【书生·浦语大模型实战营04】《(4)XTuner 大模型单卡低成本微调实战》学习笔记

发布时间:2024年01月10日

《(4)XTuner 大模型单卡低成本微调实战》

1 Finetune简介

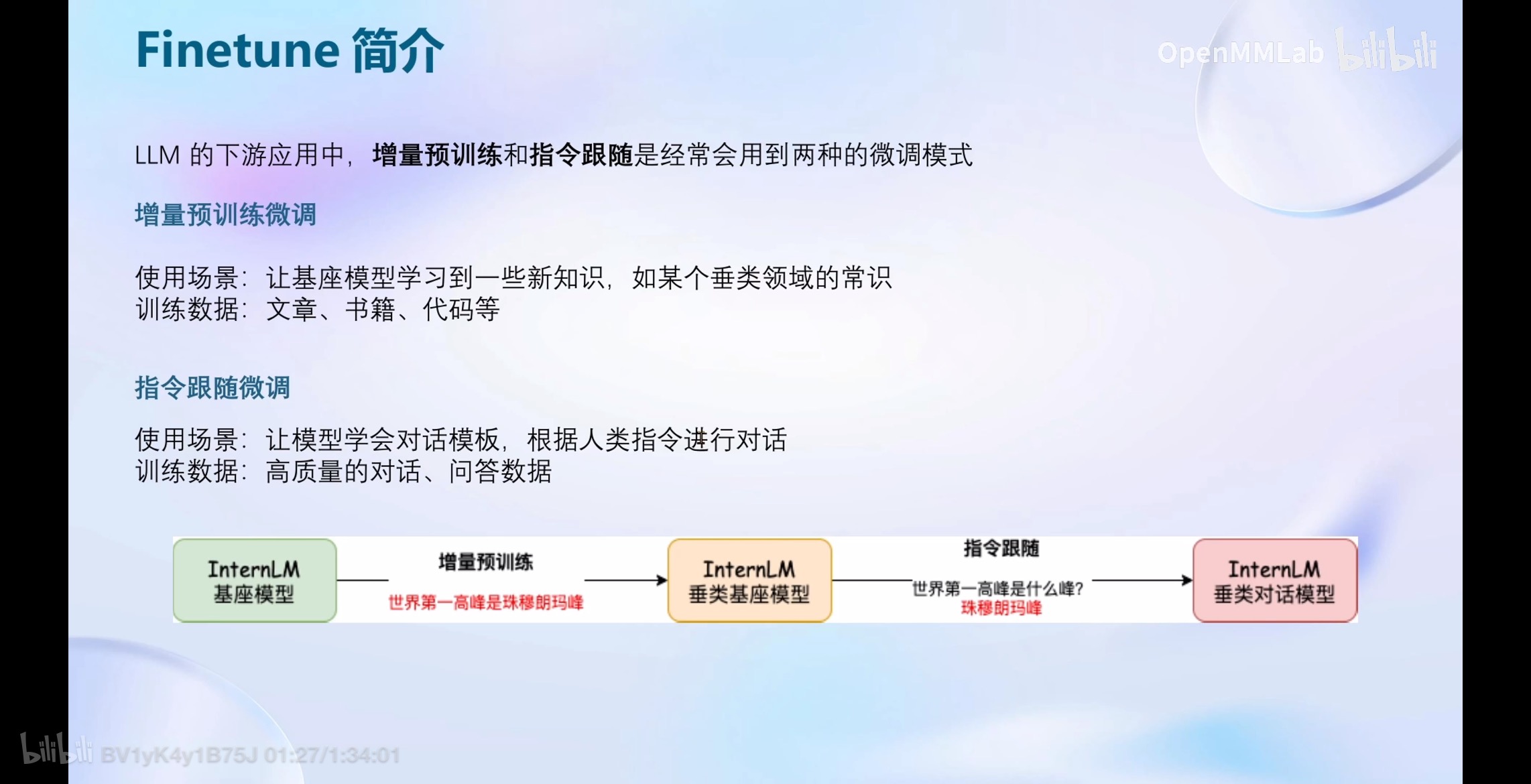

LLM的下游应用中,增量预训练和指令跟随是经常会用到两种的微调模式

LLM的下游应用中,增量预训练和指令跟随是经常会用到两种的微调模式

1.1 增量预训练微调

使用场景:让基座模型学习到一些新知识,如某个垂类领域的常识

训练数据:文章、书籍、代码等

1.2 指令跟随微调

使用场景:让模型学会对话模板,根据人类指令进行对话

训练数据:高质量的对话、问答数据

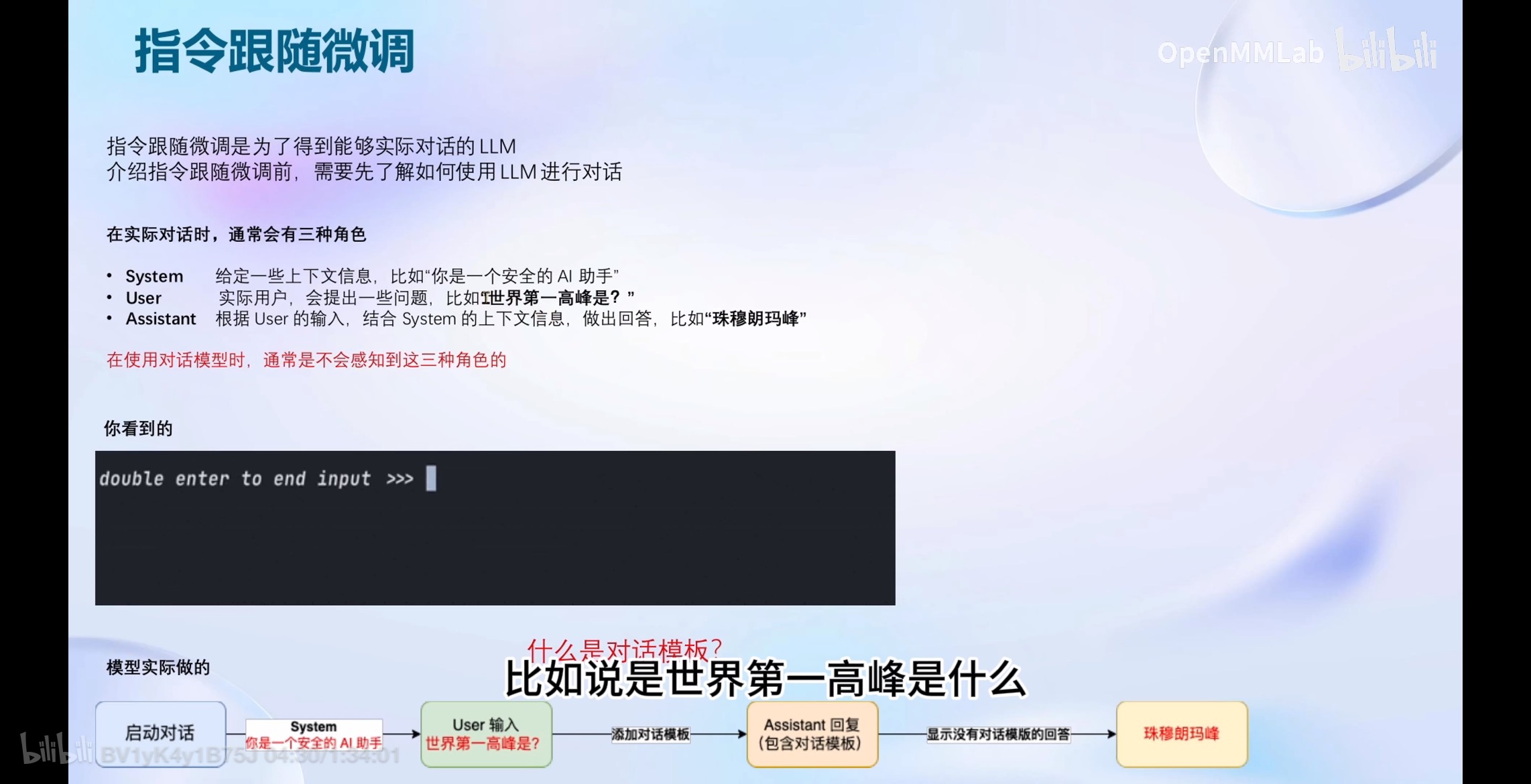

1.2.1 对话角色

指令跟随微调是为了得到能够实际对话的LLM;

介绍指令跟随微调前,需要先了解如何使用LLM进行对话;

在实际对话时,通常会有三种角色

- System:给定一些上下文信息,比如“你是一个安全的AI助手”

- User:实际用户,会提出一些问题,比如T世界第一高峰是?”

- Assistant:根据User的输入,结合System的上下文信息,做出回答,比如“珠穆朗玛峰”

在使用对话模型时,通常是不会感知到这三种角色的;

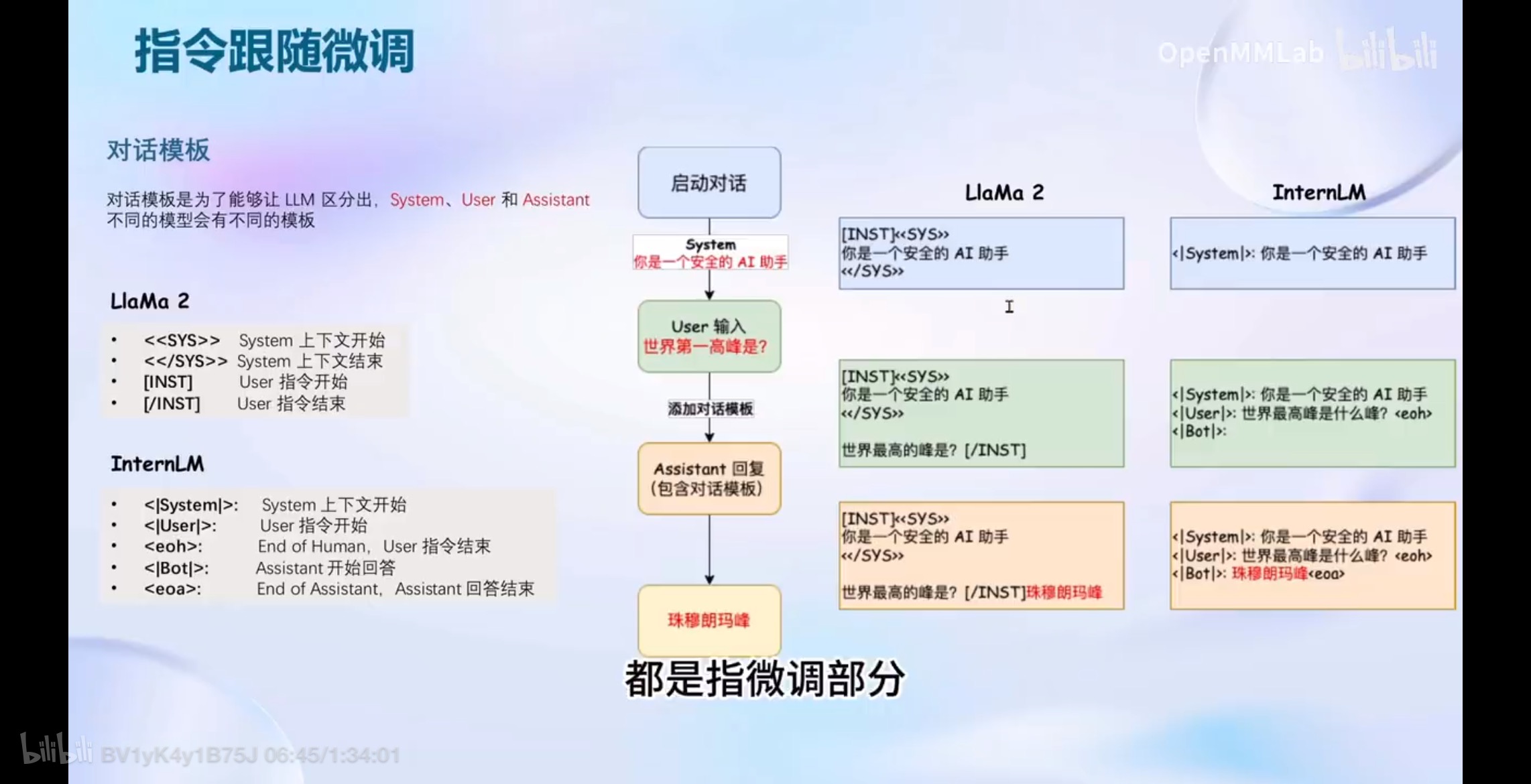

1.2.2 对话模板

对话模板是为了能够让LLM区分出,System、User和Assistant;

不同的模型会有不同的模板;

LlaMa 2 模板

- <<SYS>>: System上下文开始

- <</SYS>>: System上下文结束

- [INST]: User指令开始

- [/INST]: User 指令结束

InternLM模板

- <|System|>: System上下文开始

- <|User|>: User指令开始

- <eoh>: End of Human,User 指令结束

- <|Bot|>: Assistant开始回答

- : End of Assistant,Assistant 回答结束

文章来源:https://blog.csdn.net/songyuc/article/details/135512470

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 问题解决:django模型查询报错,找不到数据库表

- 【AI】国内好用的AI工具推荐

- 为什么要下载会声会影2024版?

- 贵港桉木建筑模板厂家批发 — 2024年市场前景与十佳品牌之一

- RT-DETR算法改进:最新Inner-IoU损失函数,辅助边界框回归的IoU损失,提升RT-DETR检测器精度

- AUTOSAR Builder—符合AUTOSAR(CPAP)的嵌入式系统设计工具

- 如何使用docker实现越权漏洞-webug靶场搭建(超详解)

- 时间序列大模型:TimeGPT

- 目标检测应用场景—数据集【NO.22】行人车辆检测数据集

- Xinlinx Vivadao入门学习