工业异常检测AnomalyGPT-训练试跑及问题解决

??????? 写在前面,AnomalyGPT训练试跑遇到的坑大部分好解决,只有在保存模型失败的地方卡了一天才解决,本来是个小问题,昨天没解决的时候尝试放弃在单卡的4090上训练,但换一台机器又遇到了新的问题,最后决定还是回来踏踏实实填坑了。

准备数据:(根据官方的提示直接准备就好)

Prerequisites:?Before training the model, making sure the environment is properly installed and the checkpoints of ImageBind, Vicuna and PandaGPT are downloaded.

AnomalyGPT训练配置:

?一张4090 24g显存,33g内存,batchsize8,cuda12.2 ,torch2.1.2(安装环境的时候也可以把requirements.txt的版本号都去掉,默认都装最新的)

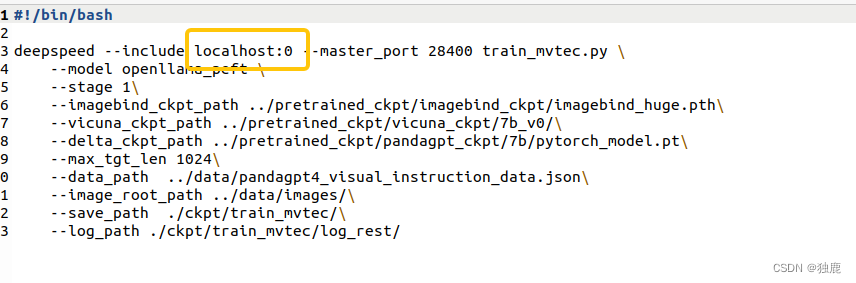

问题1:报错localhost

??? raise ValueError(f"No slot '{slot}' specified on host '{hostname}'")

ValueError: No slot '1' specified on host 'localhost'

解决办法:原因是我电脑只有一张显卡,默认配置是两张,在脚本AnomalyGPT/code/scripts/train_mvtec.sh里改一下就好了;

问题2:scikit-image报没有安装

解决办法:安装一下

pip install scikit-image问题3:deepseed版本不对

解决办法:requirements.txt里默认deepseed版本为deepspeed==0.9.2,我电脑需要至少0.9.3的版本,重新安装一下

pip install deepspeed==0.9.3问题4:loraconfig找不到

解决办法:AnomalyGPT/code/model/openllama.py中加

from peft import LoraConfig, TaskType, get_peft_model问题5:被kill

解决办法:cpu不够的时候不要开浏览器,不用开vscode等一切可能抢cpu的程序或应用,就小心翼翼开个terminal在里面进行训练。

问题6:NameError: name 'LlamaTokenizer' is not defined

解决办法:AnomalyGPT/code/model/openllama.py中加

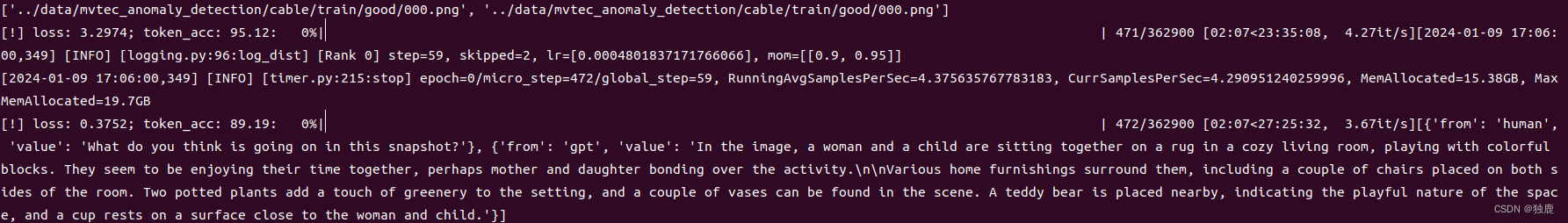

from transformers import LlamaTokenizer正常训练起来的样子:

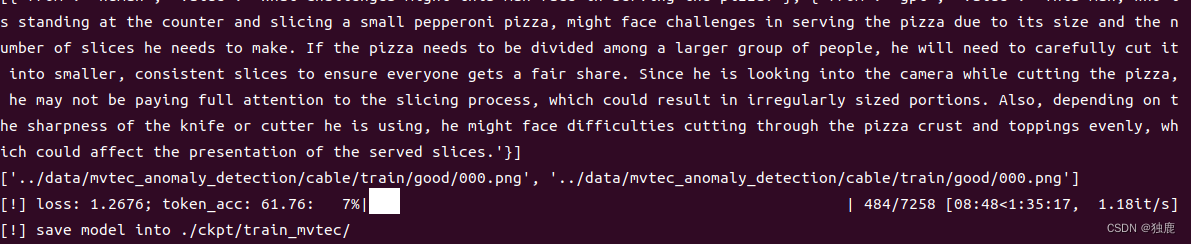

问题7:保存模型的时候报错TypeError: cannot pickle 'torch._C._distributed_c10d.ProcessGroup' object

解决办法:保存出错是因为我cpu内存小,所以加载预训练的时候将模型参数加载到了gpu上(具体操作参考上一篇web_demo.py试跑),保存的时候需要参数在cpu上才行(为什么这样?后面看一下细节再解答)。

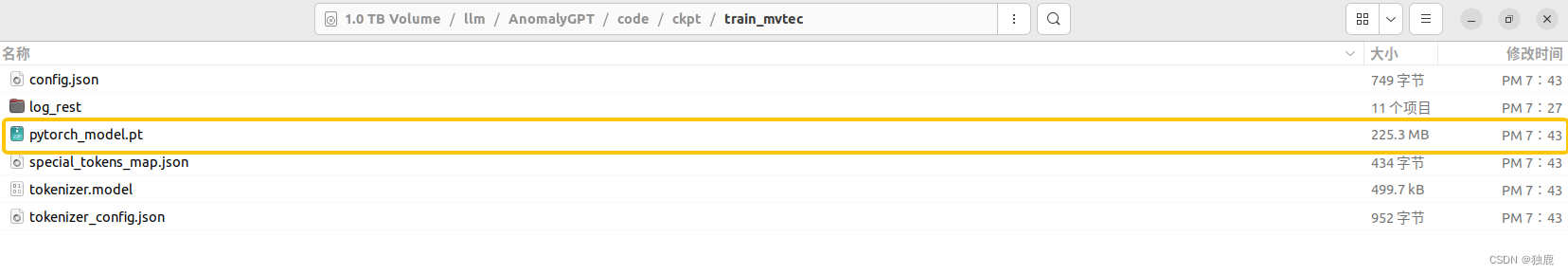

正常训练跑成功及模型保存成功的样子:

参考文献:

GitHub - CASIA-IVA-Lab/AnomalyGPT: The first LVLM based IAD method!

工业异常检测AnomalyGPT-Demo试跑-CSDN博客

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【计算机网络】UDP报文详解

- python 正则表达式学习(1)

- 算法编程比赛的一些思维技巧

- 百度搜索创新大赛,一场2800人的技术狂欢

- 计价软件审计功能-鹏业云计价i20(江苏)审核技巧操作

- 深入解析 C 语言中的 for 循环、break 和 continue

- 面试题:从 MySQL 读取 100w 数据进行处理,应该怎么做?

- 操作系统复习篇

- cpolar-内网穿透

- 【OpenAI Q* 超越人类的自主系统】DQN :Q-Learning + 深度神经网络