浦语·灵笔图文理解创作 Demo

发布时间:2024年01月19日

本小节我们将使用 InternStudio 中的 A100(1/4) * 2 机器和 internlm-xcomposer-7b 模型部署一个图文理解创作demo

1.环境准备

首先在?InternStudio?上选择 A100(1/4)*2 的配置,详情见:轻松玩转书生·浦语大模型internlm-demo 配置验证过程-CSDN博客

显卡改成:A100(1/4)*2配置

进入?conda?环境之后,使用以下命令从本地克隆一个已有的pytorch 2.0.1?的环境

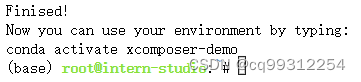

/root/share/install_conda_env_internlm_base.sh xcomposer-demo然后使用以下命令激活环境

conda activate xcomposer-demo

接下来运行以下命令,安装?transformers、gradio?等依赖包。请严格安装以下版本安装!

pip install transformers==4.33.1 timm==0.4.12 sentencepiece==0.1.99 gradio==3.44.4 markdown2==2.4.10 xlsxwriter==3.1.2 einops accelerate![]()

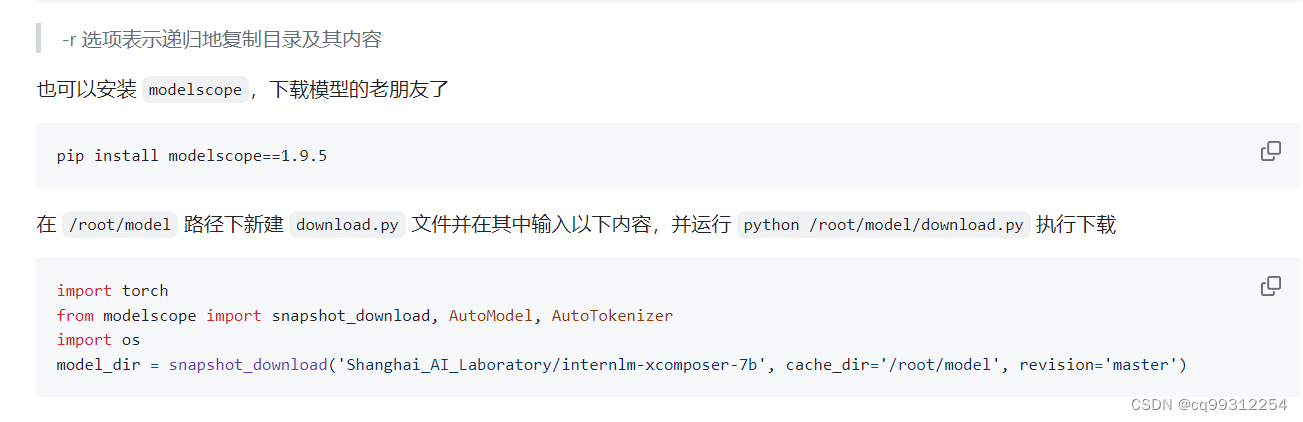

2 模型下载

InternStudio平台的?share?目录下已经为我们准备了全系列的?InternLM?模型,所以我们可以直接复制即可。使用如下命令复制:

mkdir -p /root/model/Shanghai_AI_Laboratory

cp -r /root/share/temp/model_repos/internlm-xcomposer-7b /root/model/Shanghai_AI_Laboratory

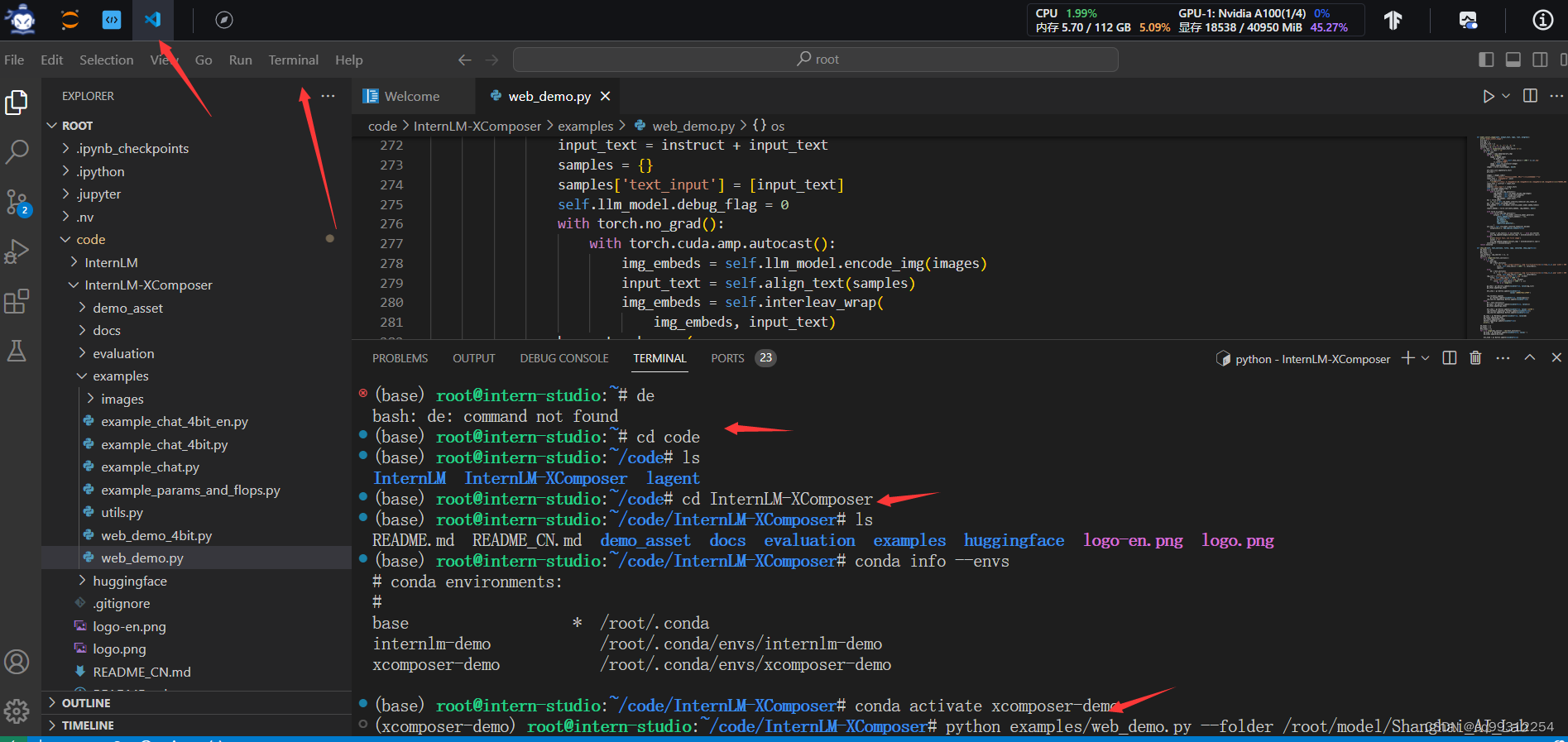

3 代码准备

在?/root/code?git clone InternLM-XComposer?仓库的代码

cd /root/code

git clone https://gitee.com/internlm/InternLM-XComposer.git

cd /root/code/InternLM-XComposer

git checkout 3e8c79051a1356b9c388a6447867355c0634932d # 最好保证和教程的 commit 版本一致4 Demo 运行

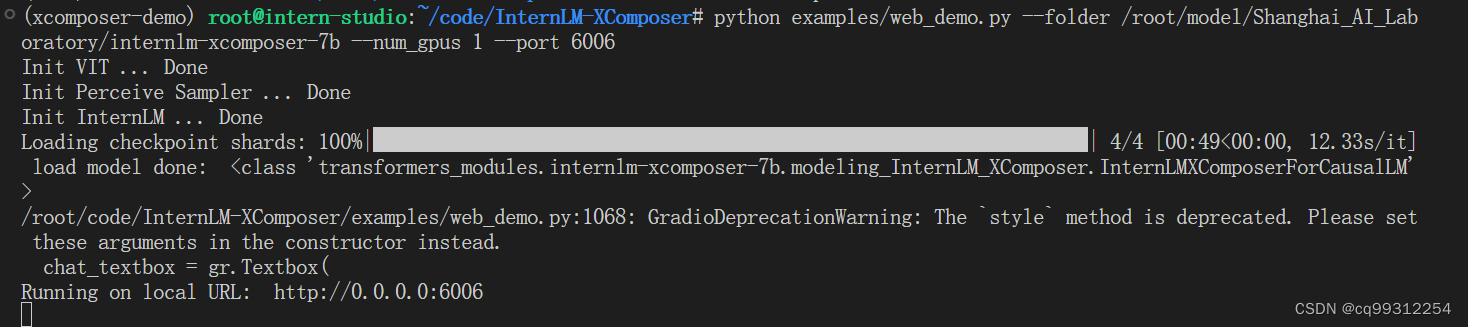

在终端运行以下代码

python examples/web_demo.py --folder /root/model/Shanghai_AI_Laboratory/internlm-xcomposer-7b --num_gpus 1 --port 6006说明:这里?num_gpus 1?是因为InternStudio平台对于?A100(1/4)*2?识别仍为一张显卡。但如果有使用两张 3090 来运行此 demo,仍需将?num_gpus?设置为?2?

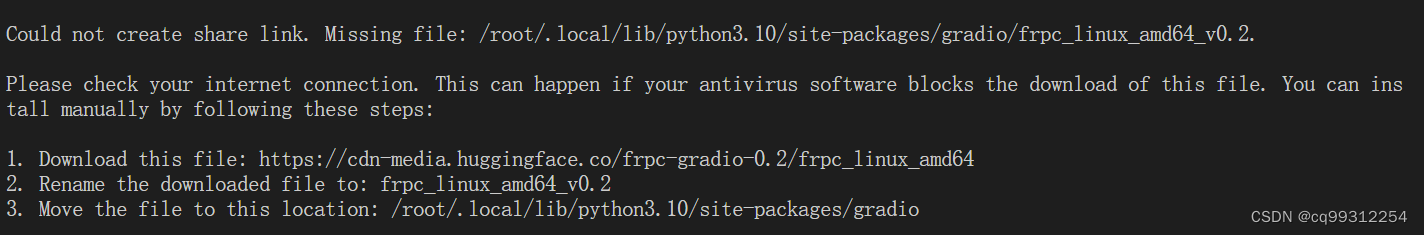

运行中报错。按要求处理即可。

修改web_demo.py中第1127行,修改后代码,可以正常运行

demo.launch(share=True, server_name="0.0.0.0", server_port=6006,root_path=f'/proxy/6006')

文章来源:https://blog.csdn.net/cq99312254/article/details/135656348

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 《SPSS统计学基础与实证研究应用精解》视频讲解:SPSS 与 Stata、Python 的对比

- 荣誉见证|亚数荣获 ISC 2023数字安全创新能力百强!

- Linux 安装图形界面 “startx”

- Arduino项目式编程教学第五章——激光报警装置

- 【2.5操作系统】数据传输控制方式

- Linux命令之sfdisk

- 计算机找不到msvcp120.dll的修复方法,总结五种可靠的方法

- 保姆级最新版Kali虚拟机安装和汉化中文教程

- 【GitHub项目推荐--开源的坦克大战】【转载】

- typora的使用保姆级教程以及安装后的配置方式