LLM Agent发展演进历史(观看metagpt视频笔记)

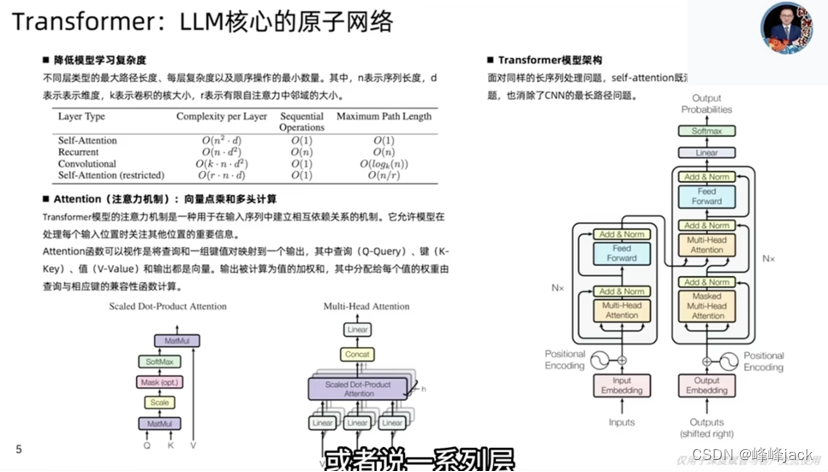

LLM相关的6篇重要的论文,其中4篇来自谷歌,2篇来自openai。技术路径演进大致是:SSL (Self-Supervised Learning) -> SFT (Supervised FineTune) == IT (Instruction Tuning) -> RLHF。

word embedding的问题:新词如何处理,新词的embedding如何表征;但LLM根据token或字做输出的方式,很大程度上可以解决这个问题。

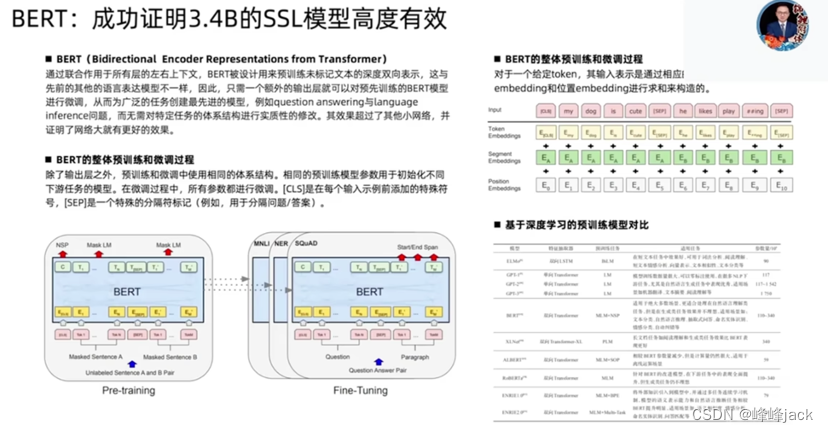

在谷歌有很大的机器资源去调用,使得BERT有机会做成大模型;BERT出来后,NLP之前所有的trick都失效了;BERT证明了大模型这条路是可行的。

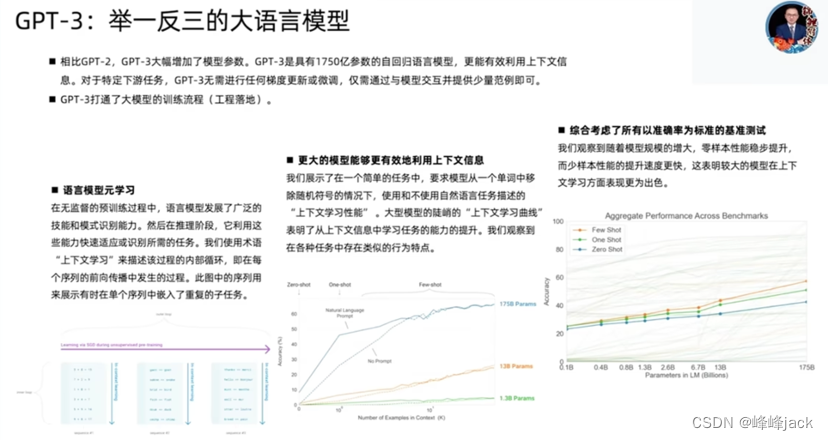

Openai是把所有资源都集中到LLM这一件事情上,集中所有资源于一点,这就是战略选择。

Instruction tuning非常重要,带来了范式的转化。

![[图片]](https://img-blog.csdnimg.cn/direct/ffe6259bc6154c54a18b28d75aa222ec.png)

RLHF将模型毒性从40%降低到0.6%。

![[图片]](https://img-blog.csdnimg.cn/direct/943821d922384d3fb497877512d8b640.png)

GPT3.5 turbo,据业界推测,是个20-30B的蒸馏版本模型

![[图片]](https://img-blog.csdnimg.cn/direct/a1b0110ebeaf4c20a219b5d5d2ce094c.png)

![[图片]](https://img-blog.csdnimg.cn/direct/c51e8bb4f20f4d1eb781dbfb14e82463.png)

GPT有可能会开源,如果是这样,LLM水平面上升,可能会淹没其它很多开源模型。

![[图片]](https://img-blog.csdnimg.cn/direct/03285ca22f8f4e158cdfbc5892f956f2.png)

什么是智能体?智能体= LLM + 记忆 + 规划 + 工具 + 神经 + 直觉

![[图片]](https://img-blog.csdnimg.cn/direct/a6c326c186fe463da08c16b4c905f610.png)

Agent需要有硬件支持,是一个全新的物种。暴露度:编程是63.4%,所以编程在很大程度上也是可被替代的。

![[图片]](https://img-blog.csdnimg.cn/direct/9d837e57b7044fec88ed83c3936e6671.png)

langchain的设计比较糟糕,复杂度太高了;违背了单接口原则。

![[图片]](https://img-blog.csdnimg.cn/direct/f90df0d897944380a11c8e214cf9df9c.png)

更关注MMLU榜单:https://paperswithcode.com/sota/multi-task-language-understanding-on-mmlu

![[图片]](https://img-blog.csdnimg.cn/direct/ab5eff7545c246168a9155208a1aae70.png)

![[图片]](https://img-blog.csdnimg.cn/direct/220b48f31e3c4494a6bf71f6eb4fed02.png)

数据结构和API设计图,有较高价值;LLM具有很强的信息收集、处理能力。一个200w人民币架构师的工作,有可能花几美元就解决。

![[图片]](https://img-blog.csdnimg.cn/direct/26a973100df445cb8ef5246a842518ab.png)

人类在这里主要扮演投资者。

![[图片]](https://img-blog.csdnimg.cn/direct/218de4b91e7343859f7f5853ea42909a.png)

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 面试官:如何实现两栏布局,右侧自适应?三栏布局中间自适应呢?

- Android 12.0 系统sim卡5G信号格数对应的信号强度值修改

- 【图的应用四:关键路径】- 用 C 语言实现关键路径

- 建站为什么需要服务器?(Web服务器与计算机对比)

- gitlab.rb主要配置

- ChatGPT论文指南|ChatGPT助力论文论点提炼详细流程!【建议收藏】

- 手把手带你死磕ORBSLAM3源代码(三十八)Tracking.cc UpdateLastFrame

- 助力工业焊缝质量检测,YOLOv7【tiny/l/x】不同系列参数模型开发构建工业焊接场景下钢材管道焊缝质量检测识别分析系统

- 影响机器人行业爆炸式发展的原因有哪些(OpenPilot)

- 用ChatGPT写公众号10W+爆文的方法(内附提示词)