Spark on Hive及 Spark SQL的运行机制

发布时间:2024年01月11日

Spark on Hive

集成原理

HiveServer2的主要作用: 接收SQL语句,进行语法检查;解析SQL语句;优化;将SQL转变成MapReduce程序,提交到Yarn集群上运行

SparkSQL与Hive集成,实际上是替换掉HiveServer2。是SparkSQL中的HiveServer2替换掉了Hive中的HiveServer2。

集成以后优点如下:

1- 对于SparkSQL来说,可以避免在代码中编写schema信息。直接向MetaStore请求元数据信息

2- 对于SparkSQL来说,多个人可以共用同一套元数据信息,避免每个人对数据理解不同造成代码功能兼容性问题

3- 对于Hive来说,底层执行引擎由之前的MapReduce变成了Spark Core,能够提升运行效率

4- 对于使用者/程序员来说,SparkSQL与Hive集成,对于上层使用者来说,是完全透明的。

在代码中集成Hive

代码中集成Hive:

from pyspark import SparkConf, SparkContext

import os

from pyspark.sql import SparkSession

# 绑定指定的Python解释器

os.environ['SPARK_HOME'] = '/export/server/spark'

os.environ['PYSPARK_PYTHON'] = '/root/anaconda3/bin/python3'

os.environ['PYSPARK_DRIVER_PYTHON'] = '/root/anaconda3/bin/python3'

if __name__ == '__main__':

# 1- 创建SparkSession对象

"""

spark.sql.warehouse.dir:告诉Spark数据存储在什么地方。默认使用本地磁盘进行存储。推荐使用HDFS

hive.metastore.uris:告诉Spark元数据信息去什么地方找MetaStore

enableHiveSupport():开启SparkSQL和Hive的集成

"""

spark = SparkSession.builder\

.config("spark.sql.warehouse.dir","hdfs://node1:8020/user/hive/warehouse")\

.config("hive.metastore.uris","thrift://node1.itcast.cn:9083")\

.appName('sparksql_hive')\

.master('local[*]')\

.enableHiveSupport()\

.getOrCreate()

# 2- 数据输入

# 3- 数据处理

# 4- 数据输出

spark.sql("show databases").show()

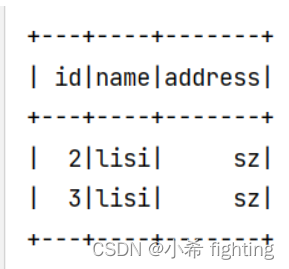

spark.sql("""

select

*

from a.student

where id>=2

""").show()

# 5- 释放资源

spark.stop()

总结:

spark.sql.warehouse.dir: 告知Spark,数据表存放的地方。推荐使用HDFS进行存储。如果不配置,默认使用本地磁盘存储。

hive.metastore.uris: 告知Spark,MetaStore元数据管理服务的连接信息

enableHiveSupport() : 开启Spark和Hive的集成

文章来源:https://blog.csdn.net/qq_50215015/article/details/135540114

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- beebox靶场A1 low 命令注入通关教程(上)

- 还在质疑js的性能,人家都干到过第一了。

- Python新手常见问题——列表中删不掉的0

- 设置gazebo内sdf,urdf文件路径的可能变量

- 实践案例分享|广发证券——夯实数据底座,赋能敏捷场景

- JSP 和 servlet 有什么区别?

- 02-knative-serving部署

- Modbus TCP转Profinet协议网关应用

- C++的魅力与奥秘:工作原理、特性及应用深度解析---探索其发展历程与运行机制

- java接口限流详解