大模型实战营Day4 XTuner 大模型单卡低成本微调实战

发布时间:2024年01月13日

本次讲师是一位从事算法工作的优秀贡献者。

一起来看看吧!

本次课程内容主要有:

我将在此整理前三节的内容,第四节放在作业章节进行讲解:

同第三节的建立数据库中所提及到的,如果通用大模型在专用领域表现能力不强,如何改进——

建立知识库或者微调,本节课进行的则是微调。

构建角色和对话模板,这项工作由Xtuner做过了,可以借此一键完成。

在预测阶段,这个不同角色模型的对话模板,两种模型的格式有所区别:

指令微调采用一问一答的方式进行:

下面还有增量微调:

其训练的数据是陈述句,然后将前两个角色内容留空,仍然是计算Assiant部分的损失。

LoRA的原理是在线性层平行增加一个两个小层的分支,因而能够减少训练的耗费。

有三种微调的方式,后二者是Xtuner提供的:

第三者在显存和GPU之间进行了一个整合,如果GPU满会到显存里面跑,速度会慢一些。

Xtuner为书生浦语提供的微调框架:

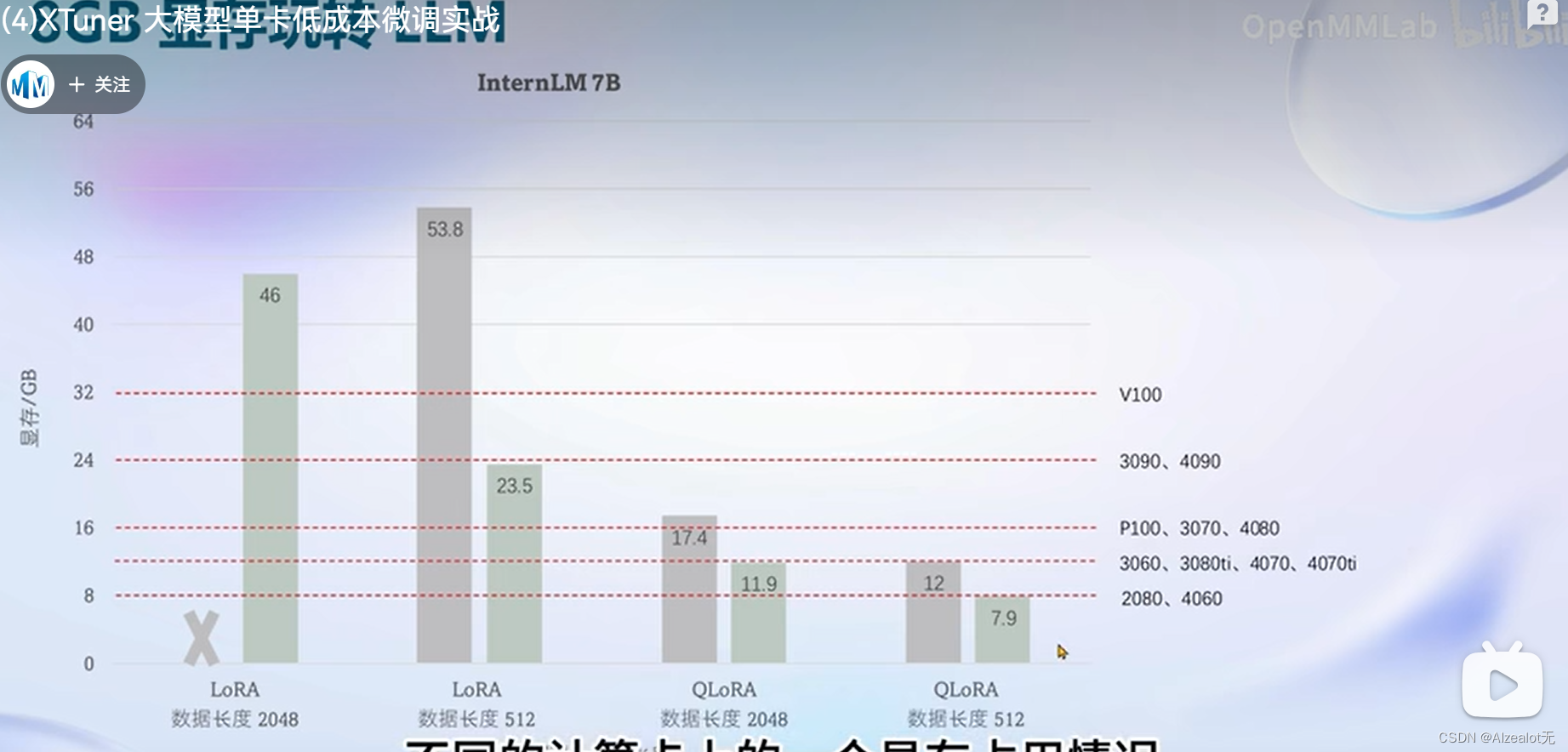

其能支持的模型的硬件资源比较广泛

并且在不同的卡上能够减少资源消耗:

今天的课程就到此为止,觉得有用的话点赞收藏加关注哦!

欢迎关注无神,一起学大模型和AI方面的前沿知识!

文章来源:https://blog.csdn.net/m0_72806612/article/details/135574724

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 轻松实现电脑对iPhone应用管理

- 龟兔再跑&

- 【router-link详细介绍】

- 国产达梦数据库二进制文件的安装教程及dm安装字节与字符默认存储问题导致数据迁移dump文件包无法导入的问题(dm8)

- 苹果电脑菜单栏应用管理软件Bartender 4 mac软件特点

- ChimeraX使用教程-安装及基本操作

- 教你IntelliJ IDEA 如何配置git?

- 计算机组成原理课程设计报告

- SofaMQ一些常用的API

- 1.4 实战:通过浏览器查看接口请求详细信息