AI数据微调找免费GPU遇阻之路

? ? ? ?赶在如火如荼的2023 AI的尾声,开始研究AI,在了解了当前技术的发展以及试用了多个AI模型和平台之后,计划本地安装Llama.cpp,利用积累的威胁建模数据和检测规则数据进行数据微调,实现自动化威胁建模和AI静态分析。但是没有GPU,在笔记本电脑上缺少GPU,所以查了很多资料,缆车那个平台可以白嫖GPU。

??????? 本机上安装了Chinese-LLaMA-Alpaca,这是中国建立的语言大模型,计划在上面做数据微调,经过了很多折腾,在虚拟机上安装成功,但是在开始训练时,报错如下:

根据local_rank以及前面多处理器提示判断可能是缺少GPU报错。大多数起码单卡才能进行微调,没有参数控制不使用GPU。于是查了一下租用支持GPU的服务器,阿里、京东以及国外一个服务器租赁平台,1/32 ?GPU的一年也要1万人民币左右,有点贵。那么想办法看看这些平台是否有可以白嫖的GPU服务器呢。

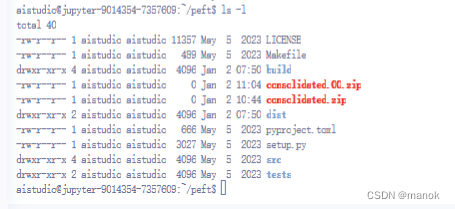

?????? 阿里平台上千问大语言模型正在搞2024 AI新年写真大挑战,使用PAI-DSW资源,活动和容易申请成功,虽然说使用平台提供的资源是免资源费用的,但是上传其它语言大模型和python程序时,会产生流量费用,且费用还比较高,所以白嫖GPU也是不能完全免费使用的,因为下载大模型会产生较高的费用。于是换到百度平台上的飞浆大语言模型,里面也有活动,可以使用AI Studio探索版,试用了一下,可以自己通过上传数据集上传python.py程序,也可以上传模型,于是办了一个季度会员,79.9元,可以使用A100甚至多卡GPU,我需要上传一个13G的ggml-model-f16.bin模型,平台最大限制500M, 于是我把模型分割为多个小于500M的文件,上传到申请的服务器上,使用cat进行合并压缩文件时,没有合并成功,而那些小的压缩文件却丢失了,如下图,看来这条路是走不通的,因为很多模型是大于500M,可能平台已经想到,所以堵住了这条路,白嫖不行,还办了一个会员。

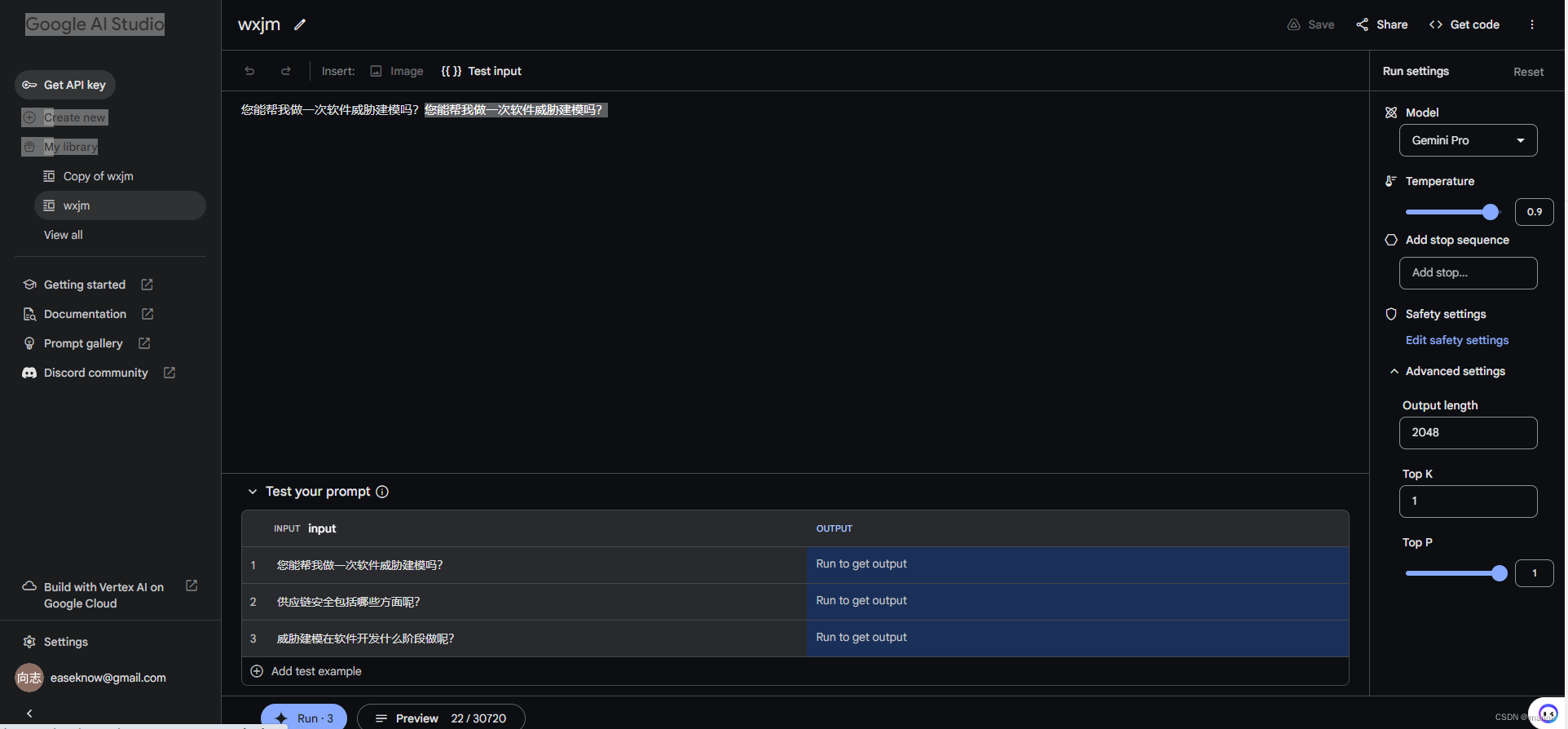

在这个期间,我处理了几十个excel威胁建模相关的数据文件,作为微调的语料。要想在这个模型上白嫖训练,国内两个平台都不行。那Google平台上是否可以呢?打开Google AI Studio平台,里面有两种方式可以模型微调,一种方式是可以通过Python API和REST API可以进行调整。但是只能支持基础模型text-bison-001调整。另一种方式是通过但是这个模型好像没有开源,训练完成的模型,更无法下载离线使用。·另一种方式是通过在线方式通过无代码接口fine-tuning的一个BERT模型,这种方式是相对比较简单,在界面上提供input和output示例后,再提供相应的示例文件。同时可以用模型参数进行实验,设置模型、温度、最大输出和安全设置。后面可以把生成的保存(百度是无保存到网盘或下载到本地的功能)到google账号里,但是无法保存模型的,只能保存自己设置的input和output问题和答案。整个界面如下:

?????

?????? 通过这几个大的AI平台上的试用情况来看,白嫖一个GPU做数据微调基本上是不太可能了。我也在想,经过2023年AI的异军突起,很多企业再找基于AI的应用,虽然说在聊天、写作、作图和视频、解读文档方面有了一些应用,但是还只能说是浅层次的应用,这些训练完成的数据模型基本上还是通用性的,主要是来自于网络的语料,而要行业里应用,是需要企业自己去基于已有模型去训练自己的纵深行业的模型的,而数据又是企业里的重要资产,把企业里的数据上传到AI平台去训练或微调,这涉及到企业数据的资产安全,基本上是一个无法行得通的路。而基于AI API调用方式建立的应用,不管是在AI平台本身,还是企业自己建立的利用,在线模式对于企业来说都是不安全的。虽然说出AI平台都在大力推自己的大语言模型,但是依据目前的方式,应该说是无法得到行业的支持或进入企业应用的。做到训练数据模型的隔离和安全可能是AI平台需要考虑的重要问题。另外,离线应用和企业训练纵深的大语言模型可能企业最关注的问题。

(完成)

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!