代理型人工智能系统 萨曼莎 贾维斯的定义,谁开发 谁部署 谁用 出了问题谁负责 是怎样炼成的?

定义:Agenticness, Agentic AI Systems, and “Agents”

agnet(名词) n.代理人

agentic(形容词) adj.代理的

agenticness(+ness变名词) n.代理

- 代理型人工智能系统的特点是能够在没有事先指定行为的情况下,在很长一段时间内持续采取有助于实现目标的行动。

- 在文化想象中,人工智能代理是为用户完成任意任务的助手,就像《她》中的萨曼莎或《2001太空漫游》中的HAL 9000。它与GPT4没有明确的界线,只是GPT4目前只能完成有限的现实任务(在某些方面出奇的博学和聪明)。

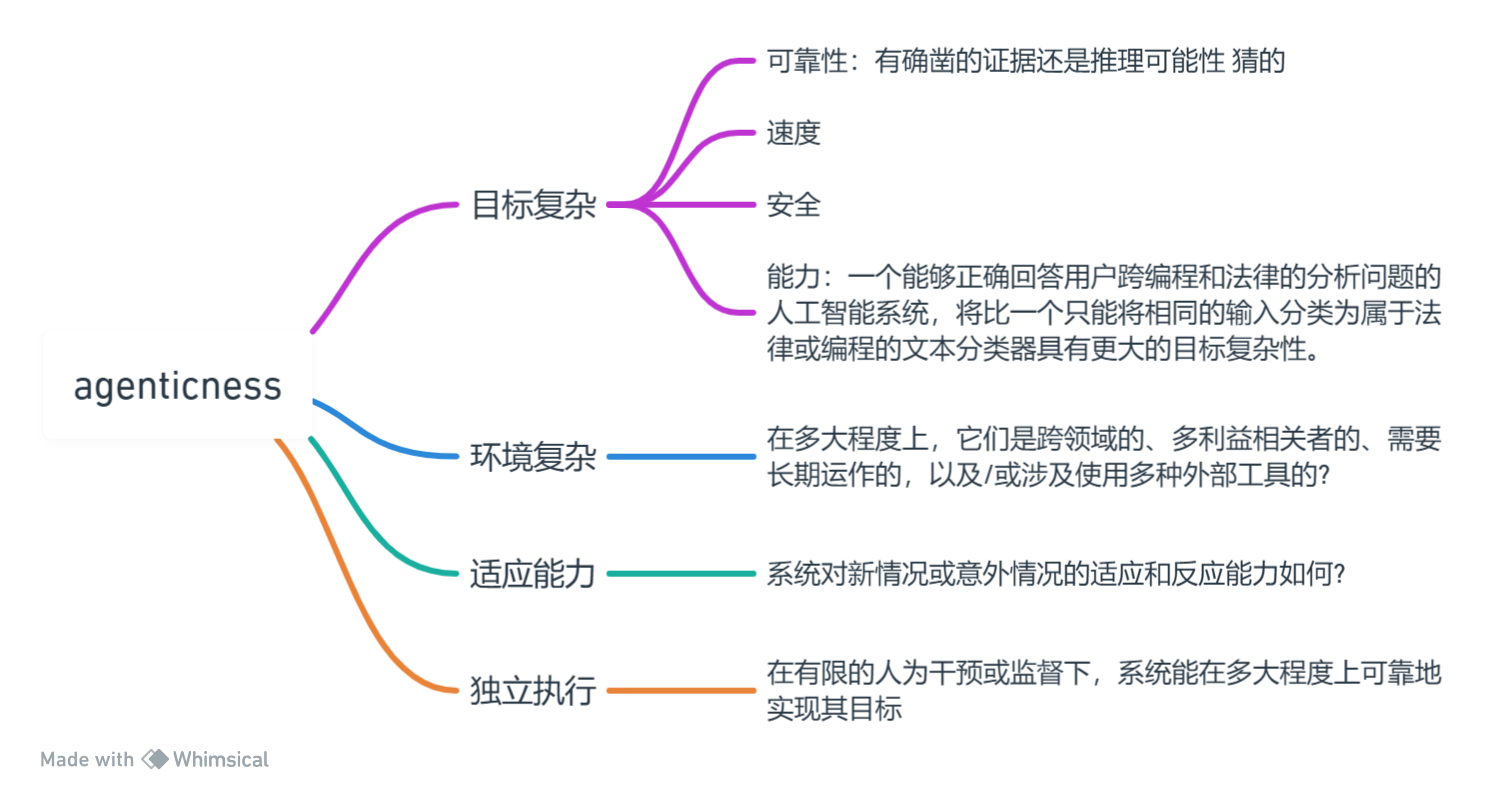

- 人工智能系统的代理性最好理解为涉及多个维度,我们预计该领域将沿着每个维度继续发展。

- 在有限的直接监督下,系统在复杂环境中实现复杂目标的适应性程度。

- 带我追上太阳,给我摘下月亮,给AI的目标到底能有多复杂?可以直接回答我做不到,我只给开车送你去发射台,告诉你方法。

我们通常将agentic AI系统概念化为在追求人类定义的目标并在人类确定的环境中运作(并且通常与人类“队友”合作),而不是完全自主设定目标的系统。我们所定义的主动性也并不与物理性质挂钩(即许多数字系统在上述意义上比大多数机器人更具主动性),但某些具有物理后果的“独立执行”(例如在无人驾驶汽车中)可能会在特定应用中增加主动性的风险和机遇。最后,主动性在概念上与AI系统在给定任务上的表现水平或其能力的通用性不同,尽管在表现和通用性上的提升可能会“解锁”系统在某些情境中作为代理人的能力。

人类参与者在AI代理生命周期中的角色

-

模型开发者(Model Developer):负责开发AI模型,这个模型是整个代理系统的核心。模型开发者决定了系统的基本能力和行为方式。

-

系统部署者(System Deployer):在模型的基础上构建并运行更大的系统。系统部署者负责实现模型的应用,如提供用户界面,连接到其他工具,或者为特定用途定制AI系统。

-

用户(User):是使用特定AI代理系统的个体或组织。用户启动系统,并提供AI代理应该追求的具体目标。

在AI代理的生命周期中,这些角色可能会有所重叠。例如,同一公司可能既是模型的开发者,也是通过API部署该模型的系统部署者。此外,有时多个实体可能共同承担某个角色,如一个公司训练了一个模型,另一个公司对其进行了针对特定应用的微调。

这些角色在AI代理系统的设计、开发、部署和使用过程中起着至关重要的作用,它们的互动和协作对于确保系统的有效性和安全性至关重要。

Agentic AI Systems的潜在益处

- 代理功能越强越好

- 影响力倍增器:在社会中促进AI的更广泛和有益的应用

代理作为一种有用的属性

- AI系统变得更有益的程度与它们的主动性的程度成正比。

- AI系统变得更有益的条件是它们被安全地设计,且适当的安全和责任最佳实践被应用。

- 高质量和更可靠的输出

- 更高效的节省用户的时间

- 改进用户交互体验:用自然语言交互比在设置中找相应的选项更容易。

- 可扩展性

代理作为影响力倍增器

核心是讨论AI系统中"主体性"(agenticness)的重要性。"主体性"在这里指的是AI的能力和自主性。文章指出,除了分析特定AI系统中的"主体性"对社会影响的意义外,我们还可以将"主体性"视为AI普及带来的更广泛系统性影响的前提条件。这些影响中有很多都有可能对社会产生重大益处。简而言之,作者强调了理解和评估AI的"主体性"在评估其广泛的社会影响时的重要性。

就代理性作为这种扩散的定义上或实际上的前提而言,代理性的影响可能与人工智能的影响密切相关。从这个意义上说,一般来讲,随着代理性的增加,人工智能的影响可能会更加频繁、更加明显,并且发生得更早,这使得代理性成为整个人工智能领域的‘影响倍增器’。

代理性越强,影响力越大。

有时候,在讨论当前或未来的人工智能能力时,人们会隐含地假设有代理性。OpenAI的宪章将人工通用智能(AGI)定义为‘在大多数经济价值工作中胜过人类的高度自主系统’,而像Russell和Norvig的《人工智能:一种现代方法》这样的经典教科书在其对人工智能的构想中强调了代理性。鉴于这些考虑,我们简要回顾了作为一个整体技术领域,人工智能普遍预期的几个影响。

即使没有在代理性方面的显著进步,人工智能很可能已经构成了一种通用技术。从历史上看,像蒸汽机和电力这样的通用技术的广泛应用随时间显著提高了全球的生活标准(尽管也给许多人带来了重大的伤害,特别是对那些在这些时期生活的较不强大或不太有特权的群体)。广泛部署的高能力和具有代理性的人工智能系统甚至可能极大地提高经济生产力,从根本上改变工作的性质,可能并且更加投机地促使一个“休闲社会”或“后工作”世界的出现,尽管这并不是必然的,并且会带来风险[16]。此外,人工智能可能加速推动各种非经济指标的社会福祉进展,如那些被囊括在可持续发展目标中的指标,并通过加速科学进步和理解。某些人期望从人工智能中获得的经济和其他生产力增长可能会更大,这在一定程度上取决于具有代理性的人工智能系统能够自主采取行动。

保持自主人工智能系统安全和可问责的实践方法

在下文中,我们建议不同方采取一系列实践,以确保自主AI系统的安全运作,并符合用户的意图,在发生伤害时创建问责制。当这些实践一起实施时,本节概述的实践旨在提供一种“深度防御”方法来减轻来自自主AI系统的风险。尽管今天许多这些实践以某种形式被采用,我们强调了围绕它们应如何操作化的许多未决问题。我们还讨论了随着AI系统变得更加自主,可能需要采取额外的预防措施。我们强调,仅这些实践本身不足以完全减轻当今AI系统的风险,更不用说减轻先进AI带来的灾难性风险。例如,下面的原则中没有一个涵盖了确保代理的网络安全性的方法,以防止它们被攻击者劫持,尽管我们预计这将是一个需要新实践的重大挑战。这里讨论的实践旨在作为方法和相关考虑的初步概述。

(AI系统自身如何防止补攻击或利用?)

我们避免讨论在构建能力强大且符合用户需求的主动式人工智能系统方面应使用的技术最佳实践。这些都是快速发展的领域,实践也在迅速变化,因此我们不期望这些领域能在短期内就如何保证特定人工智能能力或用户一致性方面达成“最佳实践”。此外,预测人工智能模型在给定训练选择下的能力/用户一致性所需的科学基础还处于初级阶段[18]。这意味着目前模型开发者无法确定性地保证模型对下游系统部署者和用户的预期行为。有一些例外,例如完全排除训练样本数据将意味着模型无法重复它。尽管如此,鉴于模型行为可以预先限定的程度有限,我们将专注于设计一套与特定模型的训练方法无关的最佳实践集。

评估适合任务的能力

限制行动空间并要求批准

设置代理的默认行为

代理行为的清晰可辨性

代理行为的可读性

自动监视

归因

如果在用户或系统部署人员的层面上防止有意或无意的伤害是不可行的(例如,犯罪分子操作AI代理来欺骗第三方),那么仍然有可能通过让用户追踪到他们身上来阻止伤害。

中断和维护控制

间接影响

除了单个人工智能系统的直接影响外,许多不同人工智能系统的使用以及社会对其使用的反应也会产生间接影响。正如我们很难预料到以前的通用技术(如电力和计算机)所带来的全面的社会调整一样,我们应该“预料到意想不到的事情”。尽管如此,我们确实认为,人工智能系统有几类间接影响可能需要社会积极缓解,我们在下面列出了这些影响。

采用竞赛

考虑到代理在竞争环境中可能赋予的优势,例如私营公司或政府之间的竞争,竞争对手可能会面临巨大的压力,在没有适当审查这些系统的可靠性和可信度的情况下采用代理AI系统。

推动这种过早依赖的一个关键观察是,人工智能系统平均而言可能会在一项任务上取得成功,而在罕见但重要的情况下却不可靠,这些情况可能会被竞争对手在压力下错过或忽视。

劳动力置换和差异化采用率

与静态人工智能系统相比,动态人工智能系统似乎可能对工人、工作和生产力产生更实质性的影响。传统的人工智能系统在一些常规工作上表现出色,但增加代理可以扩展人工智能辅助或自动化的“常规”任务(例如适应意外情况、收集相关背景和根据用户偏好进行校准)。

改变攻防平衡

有些任务可能比其他任务更容易被人工智能系统自动化。这种不对称可能会破坏当前许多隐含的假设,这些假设是我们社会中减轻伤害平衡的基础(称为“进攻-防御平衡”),后果不明确。

相关的错误

人工智能系统可能会带来意想不到的故障模式,当大量人工智能系统同时故障或以相同的方式故障时,会产生特殊的风险。这些相关的错误可能是由于“算法单一文化”造成的:使用相同或类似算法和数据训练的人工智能系统可能会以类似的方式出现故障。

结论 Conclusion

采取措施确保它们安全可靠地工作,并减轻与代理采用相关的更大间接风险。我们希望学者和从业者共同努力,确定谁应该负责使用哪些实践,以及如何使这些实践对广泛的行动者可靠且负担得起。对这些最佳实践达成一致意见也不太可能是一次性努力。如果人工智能能力持续快速进步,社会可能需要反复就每一个更有能力的人工智能系统类别达成新的最佳实践协议,以便激励快速采用解决这些系统更大风险的新实践。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Poi实现根据word模板导出-图表篇

- C++中new/delete和malloc/free行为推导

- MySQL联合索引最左匹配原则使用详解

- 浅谈云性能测试的关键要点

- vue的插值语法,vue指令系统,style和class

- 在React中实现好看的动画Framer Motion(案例:滚动进度条)

- 【视频图像篇】模糊图像处理之运动模糊造成的车牌号码图像模糊还原

- 外延炉及其相关的小知识

- 智能AI一键养号,助力账号增加浏览轨迹的全新体验

- 记csv、parquet数据预览一个bug的解决