基于Python编程实现简单网络爬虫实现

引言

网络爬虫(英语:web crawler),也叫网络蜘蛛(spider),是一种用来自动浏览万维网的网络机器人。其目的一般为编纂网络索引。 --维基百科

网络爬虫可以将自己所访问的页面保存下来,以便搜索引擎事后生成索引供用户搜索。

一般有两个步骤:1.获取网页内容 ?2.对获得的网页内容进行处理

准备

Linux开发环境

python3.61安装方法:https://www.cnblogs.com/kimyeee/p/7250560.html

安装一些必要的第三方库

其中requiests可以用来爬取网页内容,beautifulsoup4用来将爬取的网页内容分析处理

pip3 install requiests

pip3 install beautifulsoup4

第一步:爬取

使用request库中的get方法,请求url的网页内容

更多了解:Requests: HTTP for Humans? — Requests 2.31.0 documentation

编写代码

[root@localhost demo]# touch demo.py

[root@localhost demo]# vim demo.py

#web爬虫学习 -- 分析

#获取页面信息

?

#输入:url

#处理:request库函数获取页面信息,并将网页内容转换成为人能看懂的编码格式

#输出:爬取到的内容

?

import requests

?

def getHTMLText(url):

? ? try:

? ? ? ? r = requests.get( url, timeout=30 )

? ? ? ? r.raise_for_status() ? ?#如果状态码不是200,产生异常

? ? ? ? r.encoding = 'utf-8' ? ?#字符编码格式改成 utf-8

? ? ? ? return r.text

? ? except:

? ? ? ? #异常处理

? ? ? ? return " error "

?

url = "http://www.baidu.com"

print( getHTMLText(url) )

[root@localhost demo]# python3 demo.py

第二步:分析

使用bs4库中BeautifulSoup类,生成一个对象。find()和find_all()方法可以遍历这个html文件,提取指定信息。

更多了解:Beautiful Soup: We called him Tortoise because he taught us.

编写代码

[root@localhost demo]# touch demo1.py

[root@localhost demo]# vim demo1.py

#web爬虫学习 -- 分析

#获取页面信息

?

#输入:url

#处理:request库获取页面信息,并从爬取到的内容中提取关键信息

#输出:打印输出提取到的关键信息

?

import requests

from bs4 import BeautifulSoup

import re

?

def getHTMLText(url):

? ? try:

? ? ? ? r = requests.get( url, timeout=30 )

? ? ? ? r.raise_for_status() ? ?#如果状态码不是200,产生异常

? ? ? ? r.encoding = 'utf-8' ? ?#字符编码格式改成 utf-8

? ? ? ? return r.text

? ? except:

? ? ? ? #异常处理

? ? ? ? return " error "

?

def findHTMLText(text):

? ? soup = BeautifulSoup( text, "html.parser" ) ? ?#返回BeautifulSoup对象

? ? return soup.find_all(string=re.compile( '百度' )) #结合正则表达式,实现字符串片段匹配

?

url = "http://www.baidu.com"

text = getHTMLText(url) ? ? ? ?#获取html文本内容

res = findHTMLText(text) ? ?#匹配结果

?

print(res) ? ? ? ?#打印输出

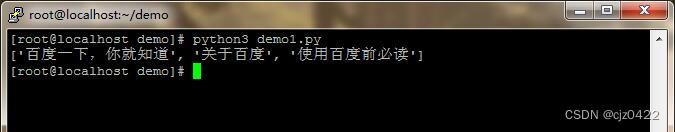

[root@localhost demo]# python3 demo1.py

一个例子:中国大学排名爬虫

参考链接:Python123 - 编程更简单

#e23.1CrawUnivRanking.py

import requests

from bs4 import BeautifulSoup

allUniv = []

def getHTMLText(url):

? ? try:

? ? ? ? r = requests.get(url, timeout=30)

? ? ? ? r.raise_for_status()

? ? ? ? r.encoding = 'utf-8'

? ? ? ? return r.text

? ? except:

? ? ? ? return ""

def fillUnivList(soup):

? ? data = soup.find_all('tr')

? ? for tr in data:

? ? ? ? ltd = tr.find_all('td')

? ? ? ? if len(ltd)==0:

? ? ? ? ? ? continue

? ? ? ? singleUniv = []

? ? ? ? for td in ltd:

? ? ? ? ? ? singleUniv.append(td.string)

? ? ? ? allUniv.append(singleUniv)

def printUnivList(num):

? ? print("{:^4}{:^10}{:^5}{:^8}{:^10}".format("排名","学校名称","省市","总分","培养规模"))

? ? for i in range(num):

? ? ? ? u=allUniv[i]

? ? ? ? print("{:^4}{:^10}{:^5}{:^8}{:^10}".format(u[0],u[1],u[2],u[3],u[6]))

def main():

? ? url = 'http://www.zuihaodaxue.cn/zuihaodaxuepaiming2016.html'

? ? html = getHTMLText(url)

? ? soup = BeautifulSoup(html, "html.parser")

? ? fillUnivList(soup)

? ? printUnivList(10)

main()

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- shopee选品工具:如何利用Shopee选品工具进行市场分析和产品选择

- 关于文件上传功能的安全方面的考量

- 仿真验证方法(3)——物理验证

- Linux 快速上手

- Sectigo通配符证书购买流程买一年送一月

- 牛客网编程题——“求IBSN码”

- Linux 驱动开发基础知识——Hello驱动程序(一)

- 认识缓存,一文读懂Cookie,Session缓存机制。

- 哈尔滨学院新生入学系统(源码+开题)

- 实战案例!风控实战催收评分卡(附 Python 源码)