一网打尽目前常用的聚类方法,详细介绍了每一种聚类方法的基本概念、优点、缺点!!

目前常用的聚类方法

1. K-均值聚类(K-Means Clustering)

基本概念:将样本随机分配到k个中心点,计算每个样本到各个中心点的距离,将样本分配到距离最近的中心点形成一个新的簇,重新计算每个簇的中心点,重复此过程直至中心点位置不再改变。

优点:计算简单高效;易于实现。

缺点:需要预设簇数k,对异常值和属性范围敏感;无法处理非球形簇。

2. 层次聚类(Hierarchical Clustering)

基本概念:通过计算样本间的距离或相似度,采用自底向上或自顶向下的方式,逐步合并相似的样本点形成新的簇。

方法:单链聚类、完全链聚类、平均链聚类。

优点:无需预设簇数,结果以树状图清晰表达。

缺点:计算量大,对样本顺序敏感;无法修改早期错误决定。

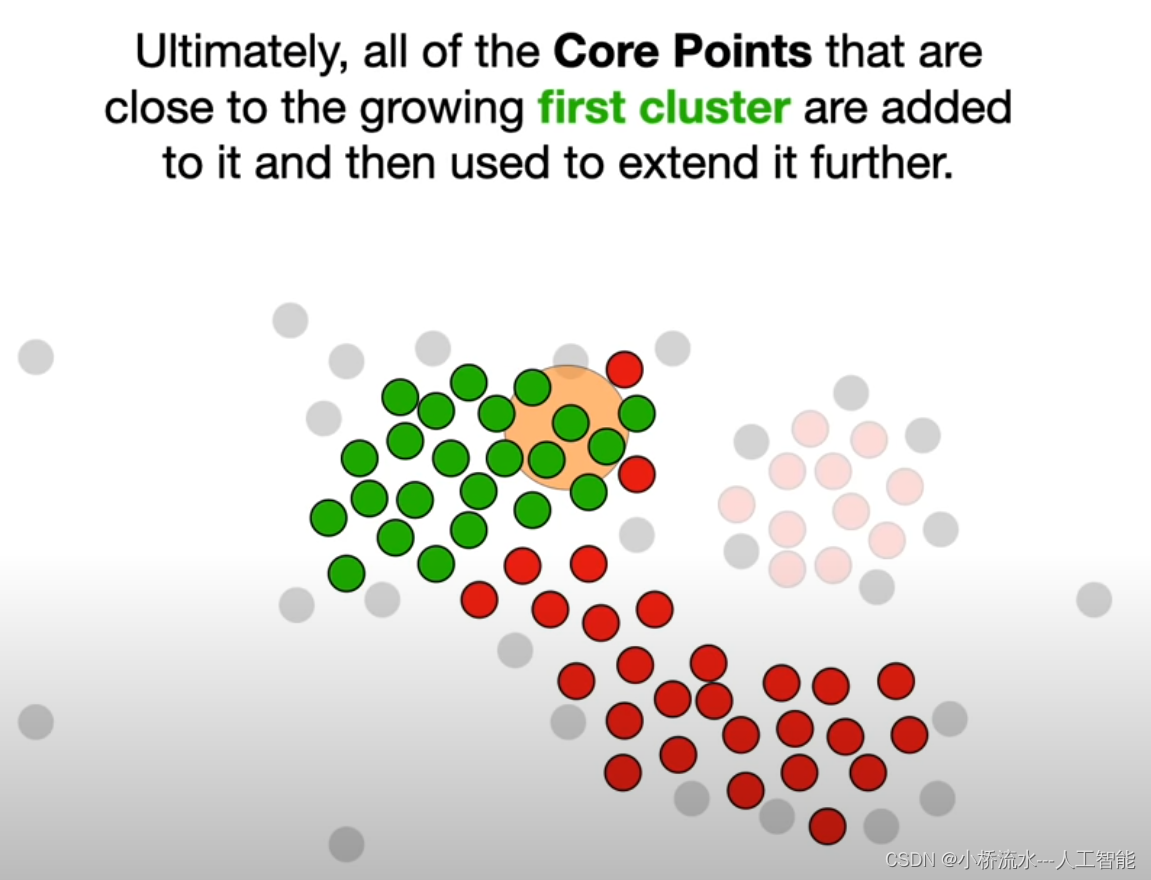

3. DBSCAN聚类(DBSCAN Clustering)

基本概念:根据样本的局部密度来寻找高密度区域,将密度可达区域聚集为一个簇,低密度视为噪声。

优点:可以找到任意形状的簇,不需要预设簇数。

缺点:选择核函数和参数对结果影响大,计算量大。

4. 谱聚类(Spectral Clustering)

基本概念:构建相似矩阵,提取其特征向量,将样本投影到低维空间进行聚类。

优点:可以处理非球形簇,不需要预设簇数。

缺点:对异常点敏感,计算量大。

5. 高斯混合模型(Gaussian Mixture Model, GMM)

基本概念:假设所有样本来自多个高斯分布,通过EM算法估计每个分布的模型参数,将样本分到概率最大的高斯分布中。

优点:可以找到任意形状和大小的簇。

缺点:需要预设组件数,对参数敏感。

6. DBA聚类(DBA Clustering)

基本概念:通过构建样本间的相似矩阵,采用分块聚类算法,迭代更新每个样本的簇分配直至收敛。

优点:效率高,可以处理大数据。

缺点:需要预设簇数,结果依赖于初始化。

总结

除了以下聚类,K-均值聚类(K-Means Clustering),层次聚类(Hierarchical Clustering),DBSCAN聚类(DBSCAN Clustering),谱聚类(Spectral Clustering),高斯混合模型(Gaussian Mixture Model, GMM),DBA聚类(DBA Clustering),后期我还会补充目前最新的不变信息聚类 Invariant Information Clustering(IIC)被提出 。IIC没有用传统聚类,而是对CNN稍作改动,用互信息最大化目标函数和双输入(two head)CNN的架构)。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- LLM 和搜索引擎是一样的吗?

- 基于springboot的医疗管理系统--98626 (免费领源码+开发文档)可做计算机毕业设计JAVA、PHP、爬虫、APP、小程序、C#、C++、python、数据可视化、大数据、全套文案

- (上) C语言中的语句分类及分支语句:if语句、switch语句介绍

- 鱼骨探矿的题解

- 大模型学习笔记03——模型架构

- R语言【cli】——ansi-styles:控制命令行中文字的颜色和格式

- 基于Pytorch实现声音的分类

- forum

- 使用 LLVM clang C/C++ 编译器编译 boost 基础框架类库

- 青少年CTF-qsnctf-A1-Misc-签到