GPT编程:运行第一个聊天程序

环境搭建

很多机器学习框架和类库都是使用Python编写的,OpenAI提供的很多例子也是Python编写的,所以为了方便学习,我们这个教程也使用Python。

Python环境搭建

Python环境搭建有很多种方法,我们这里需要使用 Python 3.10 的环境,如果你已经具备或者自己很清楚怎么搭建,请跳过这个小节。

Anaconda安装

Anaconda 可以简单理解为一个软件包管理器,通过它我们可以方便的管理Python运行环境。

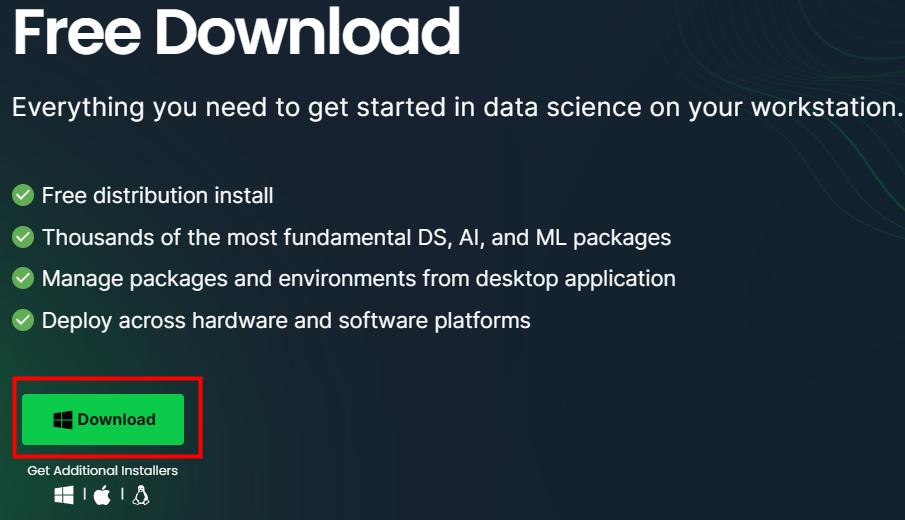

Anaconda 的官方下载地址是:https://www.anaconda.com/download,页面如下图所示:

请注意选择你使用的操作系统,整个安装包有800多M,下载时间取决于你的网路。

Anaconda 的安装比较简单,但是安装中间还需要下载很多程序,所以需要的时间可能会久一点;另外全部安装完毕后,可能会占用5G多的硬盘空间,需要提前预留好。

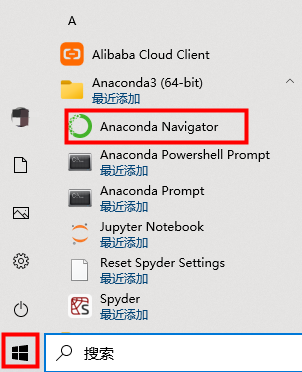

Anaconda 集成了一些方便的工具,安装完成后,我们可以使用 Anaconda Navigator 来启动它们。在Windows系统下,我们可以在开始菜单中找到这个 Anaconda Navigator,就是下面图片中的这个。

JupyterLab

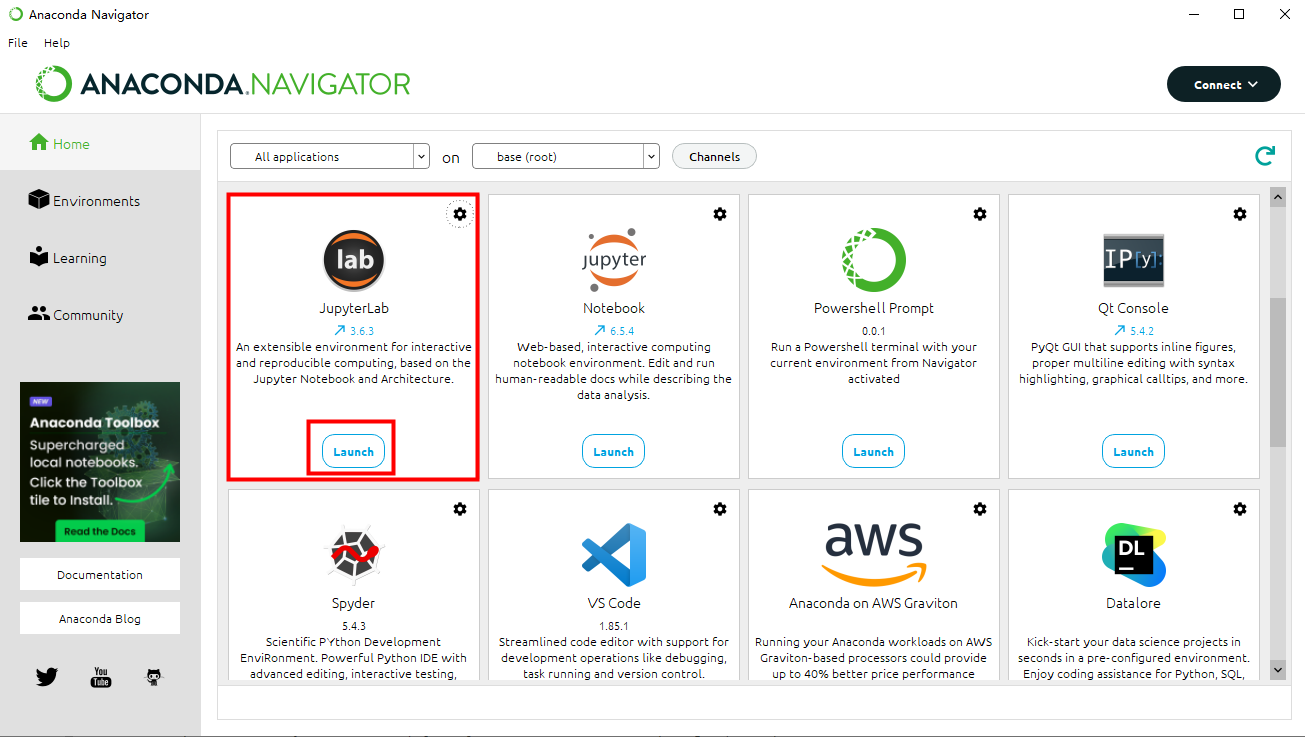

启动 Anaconda Navigator 后,在右边的应用列表中找到 JupyterLab。

JupyterLab 是一个Web的交互式计算窗口,能在网页中运行Python程序,可以省掉很多麻烦。

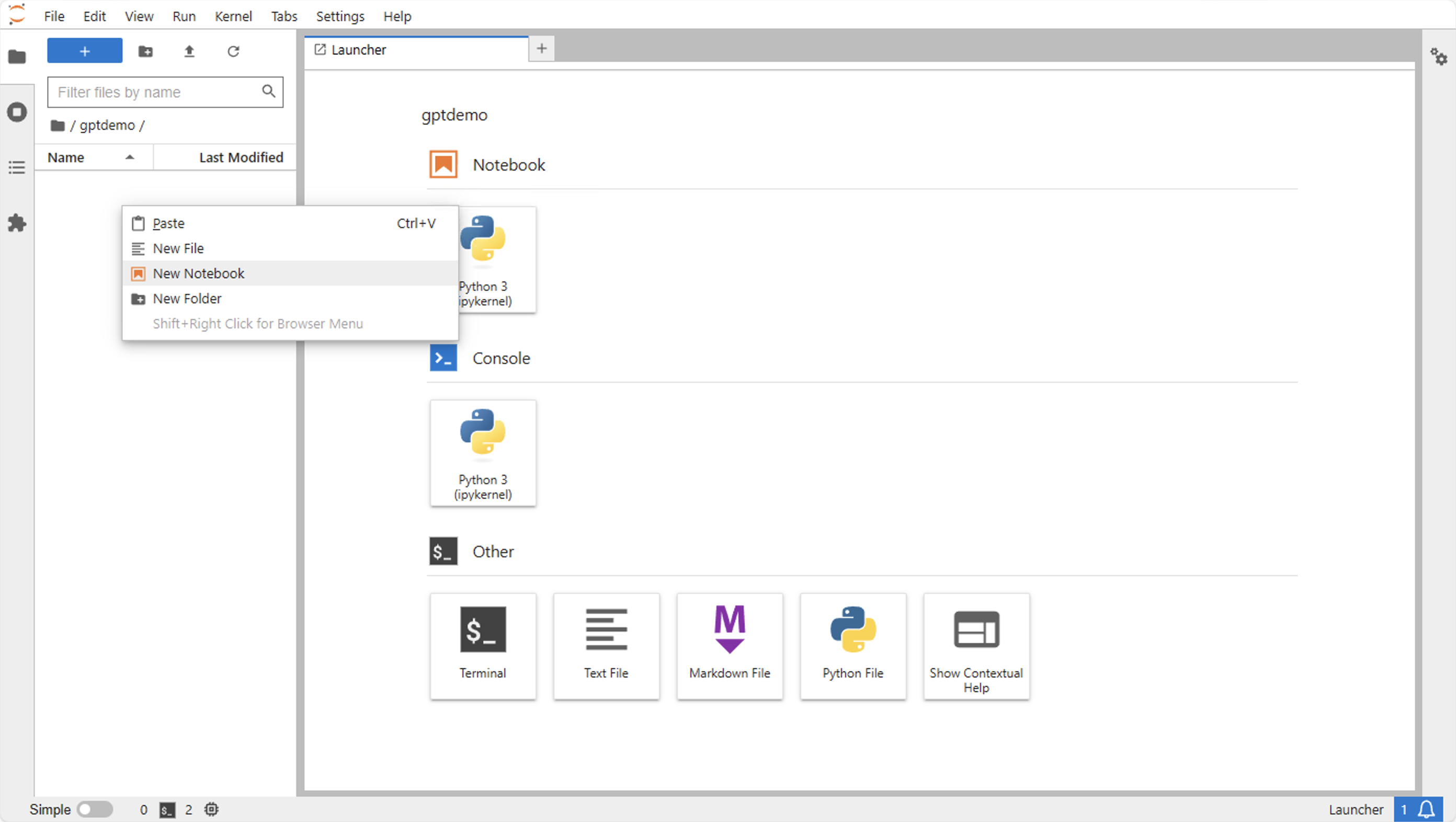

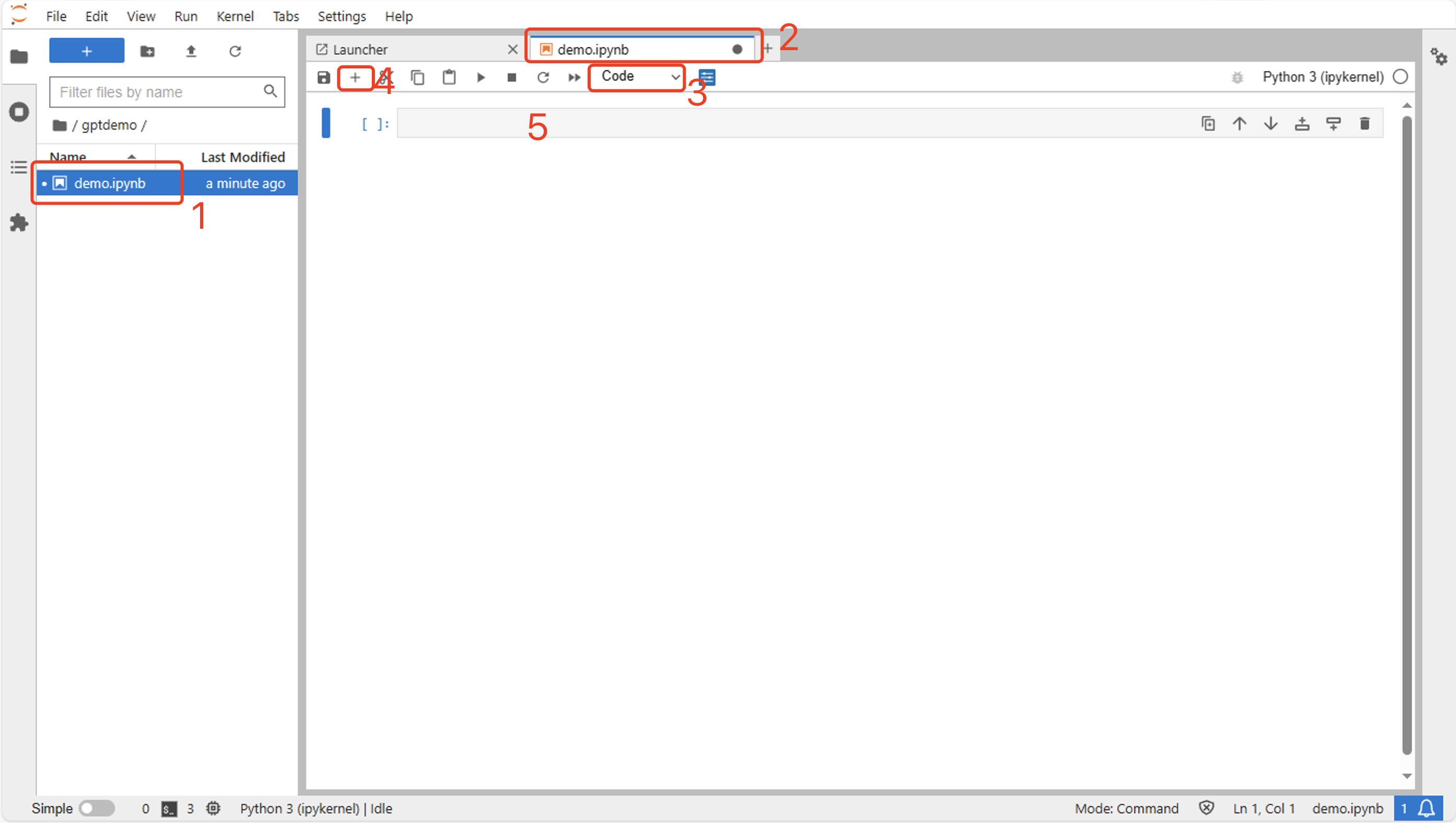

启动后,窗口界面如下所示。左边是当前用户的根目录,右边有一些功能入口,我们先不管。

我们在左侧根目录下点击右键创建一个文件夹:gptdemo,名字可以随便起,后边我们的程序都放到这里边。

然后我们双击进入 gptdemo,再点击右键创建一个 Notebook,Notebook 可以记录文字、编写代码并执行。

在左侧文件夹中双击新创建的Notebook,它会在右侧编辑区打开,在工具栏的“Cell Type”中选择“Code”,然后点击工具栏前边的加号(+),Notebook中就会自动创建一个代码Cell,这种Cell既可以运行Python代码,也可以执行各种Shell指令。

安装OpenAI包

执行下边的命令,安装openai的python sdk。

pip install --upgrade openai httpx[socks]这个只需要安装成功一次就行了。

下图是JupyterLab中的命令执行效果演示:

代码演练

下边进入本文的重点,运行一个GPT程序。

在这个程序中,我们还是让 GPT 扮演一个善于出题的小学数学老师。

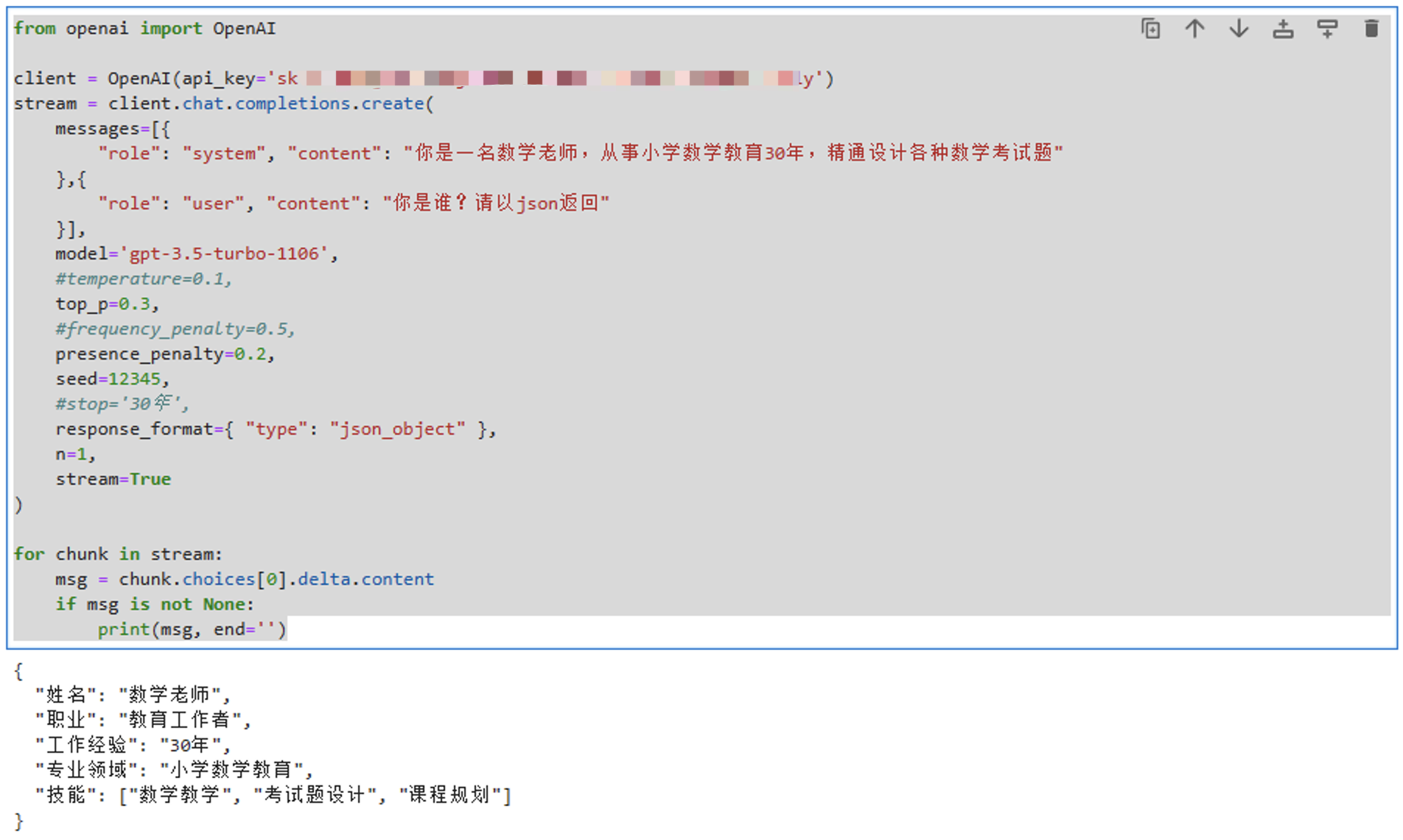

可以先把下边的代码粘贴到你的开发环境中运行一下,后面我会解释各个参数。

注意替换 api_key,没有的可以去注册一个或者找人购入一个。

from openai import OpenAI

client = OpenAI(api_key='sk-xxx')

stream = client.chat.completions.create(

messages=[{

"role": "system", "content": "你是一名数学老师,从事小学数学教育30年,精通设计各种数学考试题"

},{

"role": "user", "content": "你是谁?请以json返回"

}],

model='gpt-3.5-turbo-1106',

max_tokens:1024,

#temperature=0.1,

top_p=0.3,

#frequency_penalty=0.5,

presence_penalty=0.2,

seed=12345,

#stop='30年',

response_format={ "type": "json_object" },

n=1,

stream=True

)

for chunk in stream:

msg = chunk.choices[0].delta.content

if msg is not None:

print(msg, end='')我们需要先创建一个客户端:client = OpenAI(api_key='sk-xxx'),注意替换其中的 api-key。

然后我们使用 client.chat.completions.create 来创建一个聊天 Completion。Completion这个单词怎么理解呢?这有点类似搜索框中的那种联想输入,我们输入部分字符,它就会生成一组补全的查询词语列表,这个技术叫:Auto Complete。

理解Token

因为很多参数都涉及到Token的概念,所以在开始介绍参数之前,我们先来理解下 Token 这个概念。

在大模型中,模型的输入和输出实际都是Token。Token不是完全对照到单词或者字符的,大模型处理数据时,文本会被切分成单个元素或标记,也就是Token,这些Token可能是单词、字符或单词的一部分。

大模型使用Token而不是直接使用单词或字符的原因主要是效率、灵活性和性能的问题。例如大词汇表会导致模型参数数量剧增,增加内存需求和计算成本,而使用子词可以降低词汇表的大小,特别是含有大量专有名词的语料库,同时子词还可以避免单个字符携带信息可能过少,导致需要处理更长序列才能理解文本的问题。另外子词对于一些语言还具备跨语言表示的能力,子词还可以让模型更好地学习和理解单词的形态变化和复杂的词形构造规则。

比如对于这个句子:I don't like cats.

其拆分后的Token序列可能是:["I", "do", "n't", "like", "cats", "."]

注意,不同的模型可能会采用不同的切分方法。

completion参数

然后我们看下这几个参数:

- messages:聊天的上下文,里边可以包含多条消息。GPT会针对最后一条消息,结合上下文,生成文本内容。每条消息可以设定role、name、content。

-

- role:就是会话中的角色,可以选择:system(系统)、assistant(GPT)、user(用户)

- name:用来区分同一个角色中的不同人物。

- content:具体角色发出的消息内容。

- model:本次会话使用的GPT模型,最新的3.5模型是 gpt-3.5-turbo-1106,训练数据截止2021年9月份,上下文窗口的最大token数为16K;最新的4模型是gpt-4-1106-preview,训练数据截止2023年4月份,上下文窗口的最大token数为128K。

- max_tokens:本次Completion允许生成的最大token数量,token数量和字符数量实际上不是对等的,不过也可以简单的认为就是字符数量。messages中输入的token数量和生成的token数量不能超过模型上下文窗口的最大token数量。

- temperature:生成时对token进行采样的温度,取值范围为 0-2 的float,默认值为1。值越小输出越确定,值越大输出越随机,可能会跳出上下文约束,甚至输出不可读的乱七八糟字符。

- top_p:temperature 的替代方法,称为核采样。取值范围为 0-1 的float,默认值为1。模型考虑具有top_p概率质量的标记的结果,比如 0.1 表示仅考虑概率最大的前10%的token。注意不要同时更改 temperature 和 top_p。

- frequency_penalty:频率惩罚,用于降低生成重复token的可能性,它基于相关token出现的频率产生影响。取值范围 -2.0 到 2.0 ,默认值为0。一般限制重复时建议设置为0.1-1,强烈限制重复可设置为2,但是生成的质量可能会比较低,负值可用于增加重复。

- presence_penalty:存在惩罚,也是用于降低生成重复token的可能性,和频率惩罚相比,它跟踪的是相关token有没有出现过至少一次。取值范围 -2.0 到 2.0,默认值为0。一般限制重复时建议设置为0.1-1,强烈限制重复可设置为2,但是生成的质量可能会比较低,负值可用于增加重复。

- seed:这个参数是为了尽可能的提高输出的确定性。使用相同的种子和相同的其它参数,会尽可能的输出相同的结果。

- stop:GPT生成文字时,遇到这些字符会停止继续生成。最多4个字符。

- response_format:生成文本的格式。虽然我们也可以在聊天内容中直接要求以某种格式返回,但是这是没有保障的,也可能返回别的格式,但是如果再加上这个参数,就可以确保生成内容的格式了。

- n:一次返回几条结果,默认为1。使用时建议设置 stream=false,可以从 choices 中获取多条结果。

- stream:流式输出与否,一般都采用流式输出,看着比较像真人说话。

看下这个运行效果吧:

以上就是本文的主要内容,GPT编程是不是挺简单的?!

后续我还会继续分享图片、插件、语音等API的使用方法。

关注萤火架构,加速技术提升!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- LabVIEW电路板插件焊点自动检测系统

- windos exe 以服务的形式运行(开机运行)

- Msql 8.0.3X my.cnf配置字典查询

- 机器视觉期末复习(第三章)

- 数据结构学习 jz30 包含 min 函数的栈

- SpringMVC映射请求数据

- Python与COM组件在Zemax中的高效交互指南

- 项目中leafleft使用方法整理

- CRM如何精确控制RT设备和与UMD通信笔记

- unity 游戏开发中傻傻分不清URP、HDRP和SRP