(2023|ICLR,文本反演,LDM,伪词)一个词描述一张图像:使用文本反演个性化文本到图像的生成

An Image is Worth One Word: Personalizing Text-to-Image Generation using Textual Inversion

公纵号:EDPJ(添加 VX:CV_EDPJ 或直接进 Q 交流群:922230617 获取资料)

目录

0. 摘要

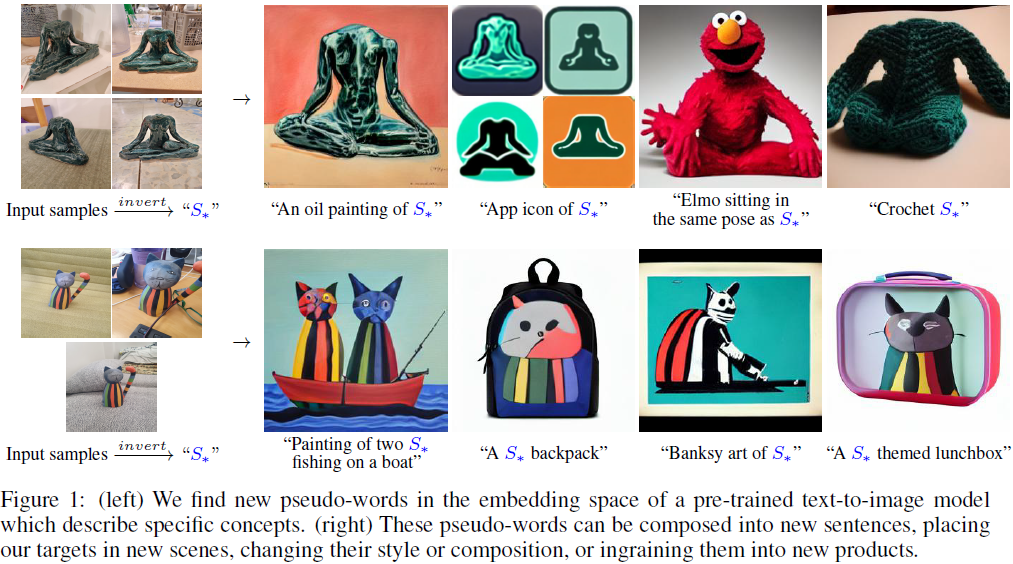

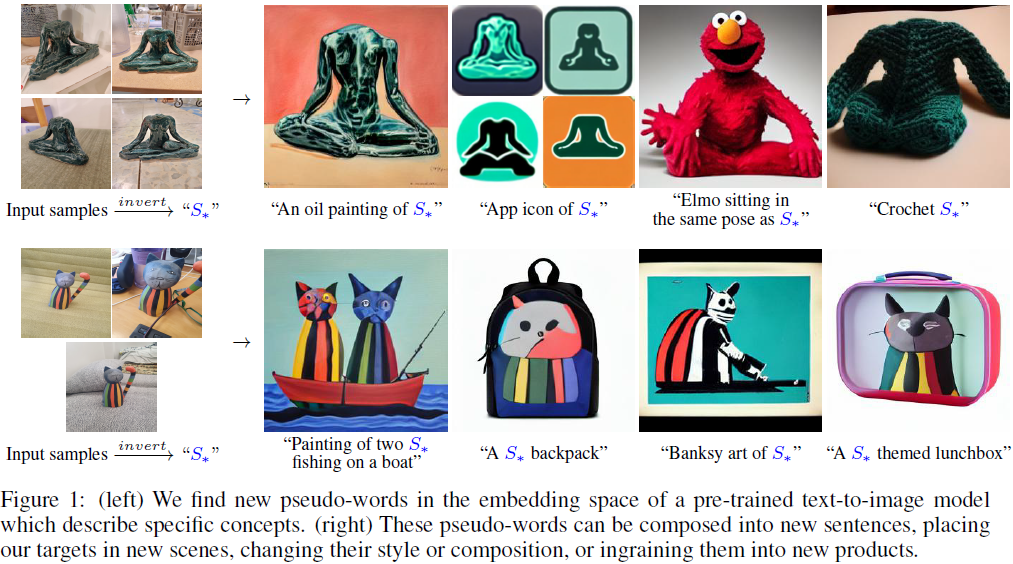

通过自然语言引导创作,文本到图像模型提供了前所未有的自由。 然而,目前尚不清楚如何行使这种自由,以生成特定独特概念的图像,修改它们的外观,或将它们组合成新的角色和新颖场景。 换句话说,我们问:我们如何使用语言引导模型将我们的猫变成一幅画,或者根据我们喜爱的玩具想象一个新产品?在这里,我们提出了一种简单的方法,允许这种创造性的自由。只使用用户提供的概念的 3-5 张图像,如对象或风格,我们学会通过冻结的文本到图像模型的嵌入空间中的新 “词”来表示它。这些 “词” 可以组成自然语言句子,以直观的方式引导个性化创作。值得注意的是,我们发现一个单一的词嵌入足以捕捉独特而多样的概念。我们将我们的方法与各种基准进行比较,并证明它在各种应用和任务中能够更忠实地描绘概念。我们的代码、数据和新词将在以下网址提供:https://textual-inversion.github.io

1. 简介

在电影《泰坦尼克号》中的一场著名场景中,Rose 向 Jack 提出了一个请求:“……像你画法国女孩那样画我。” 尽管简单,但这个请求包含了丰富的信息。它表明 Jack 应该制作一幅画;它暗示这幅画的风格和构图应该与 Jack 之前的作品的某个子集相匹配;最后,通过一个词 “我”,Rose 表明这幅画应该描绘一个特定而独特的主题:她自己。在提出请求时,Rose 依赖于 Jack 对这些概念(既广泛又具体)的推理能力,并将它们呈现在一个新的创作中。

最近,大规模的文本到图像模型(Rombach等,2021;Ramesh等,2021,2022;Nichol等,2021;Yu等,2022;Saharia等,2022)展示了对自然语言描述进行推理的前所未有的能力。它们允许用户合成具有未见过的构图的新场景,并以多种风格生成生动的图片。这些工具已被用于艺术创作、灵感的来源,甚至用于设计新的实体产品(Yacoubian,2022)。然而,它们的使用受到用户通过文本描述所需目标的能力的限制。回到 Rose,人们可能会问:如果她要接触其中一个这些模型,她可能会如何构建她的请求?作为用户,我们如何要求文本到图像模型制作一个包含珍爱的童年玩具的新场景?或者将我们孩子的画从冰箱上取下,并将它变成艺术品?

在大规模模型中引入新概念通常是困难的。对每个新概念重新训练一个模型的成本过高,而在少数示例上进行微调通常会导致灾难性的遗忘(Ding等,2022;Li等,2022)。更为谨慎的方法是冻结模型并训练转换模块,以在面对新概念时调整其输出(Zhou等,2021;Gao等,2021;Skantze&Willemsen,2022)。然而,这些方法仍然容易忘记先前的知识,或者在同时访问新学到的概念时面临困难(Kumar等,2022;Cohen等,2022)。

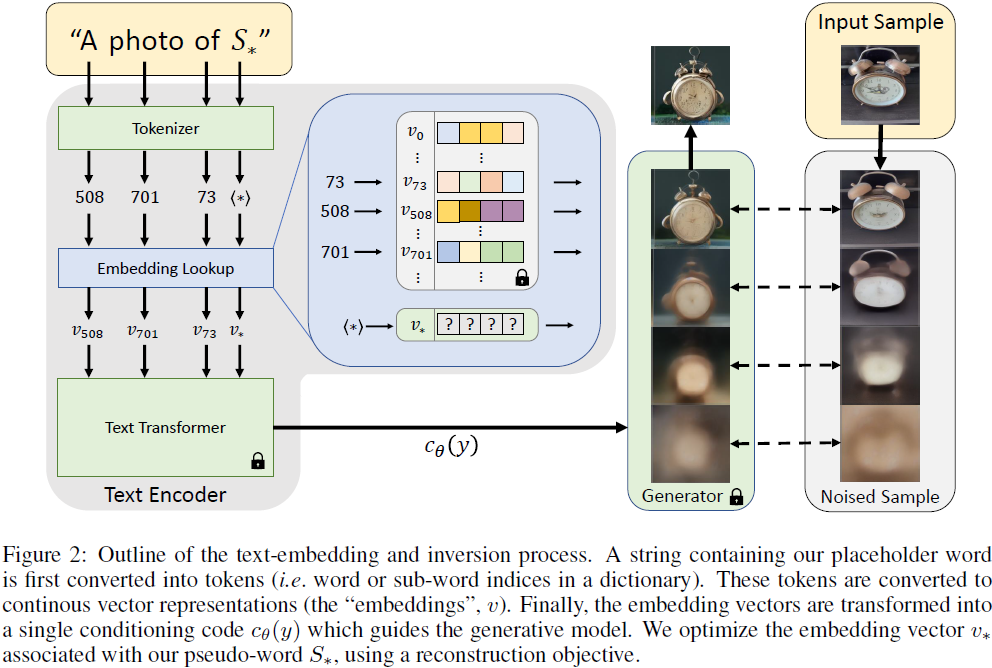

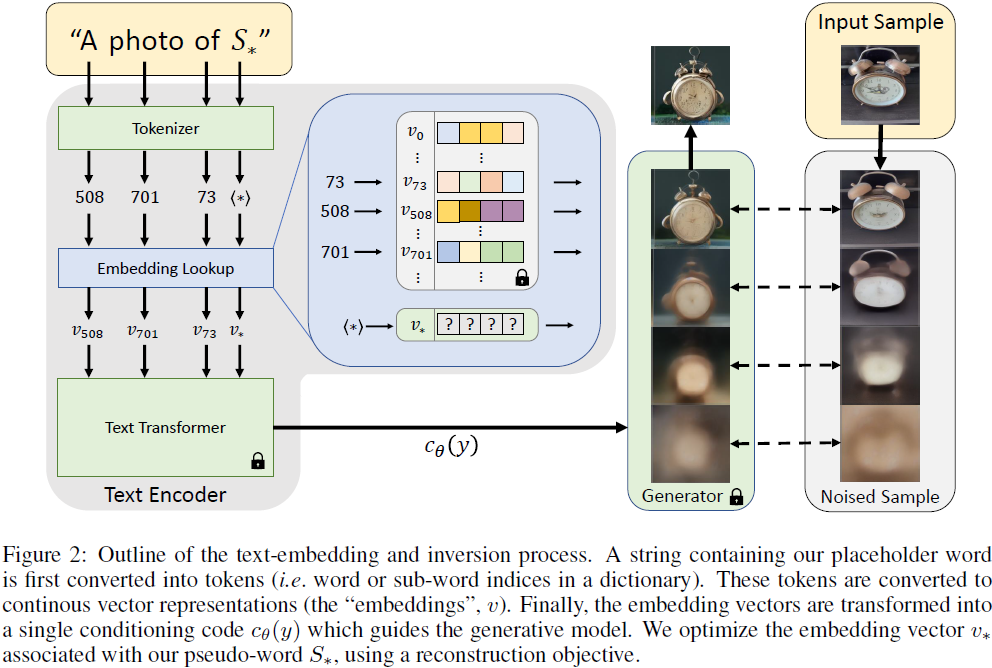

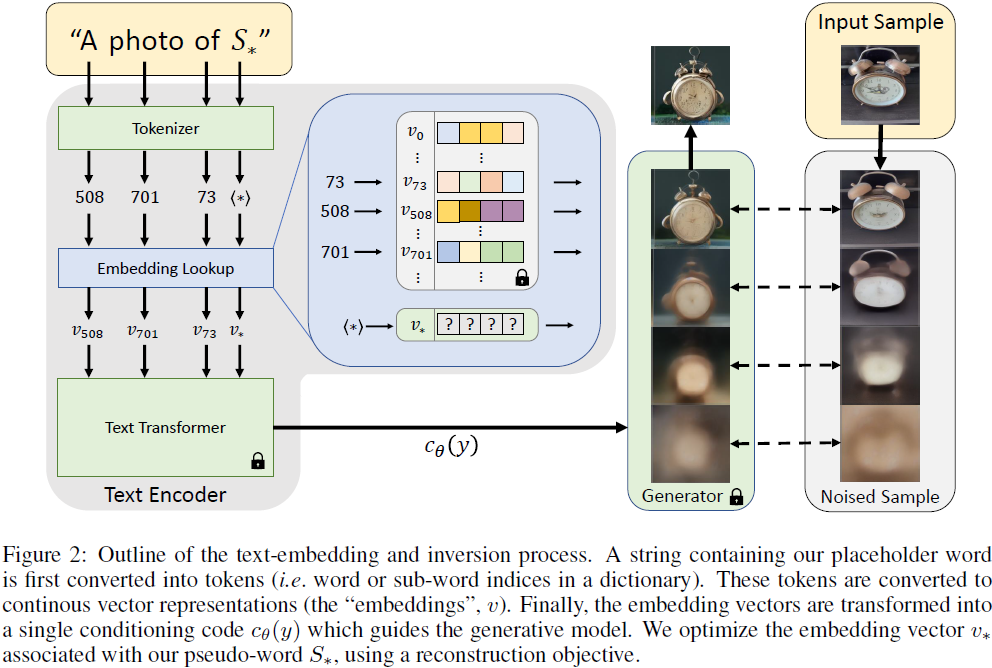

我们提出通过在预训练的文本到图像模型的文本嵌入空间中找到新词来克服这些挑战。我们考虑文本编码过程的第一阶段(图 2)。在这里,输入字符串首先被转换为一组标记。然后,每个标记都被其自身的嵌入向量替换,这些向量通过下游模型传递。我们的目标是找到代表新的、特定概念的新嵌入向量。

我们用一个新的伪词(pseudo-word)(Rathvon, 2004)表示一个新的嵌入向量,我们用 S* 表示这个伪词。然后,这个伪词被当作任何其他词对待,并可以用来构建新颖的文本查询,用于生成模型。因此,人们可以询问 “S* 在沙滩上的照片”、“墙上挂着 S* 的油画” 或者甚至组合两个概念,比如 “ 以 S2* 的风格画的 S1* 的图”。重要的是,这个过程不对生成模型进行任何更改。通过这样做,我们保留了在将视觉和语言模型微调到新任务时通常会丧失的丰富文本理解和泛化能力。

为了找到这些伪词,我们将任务框架构建为反演(inversion)的一种形式。我们得到一个固定的、预训练的文本到图像模型和一个包含描述概念的小型(3-5)图像集。我们的目标是找到一个单词嵌入,使得类似 “A photo of S*” 这样的句子将从我们的小集合中重建图像。这个嵌入是通过一个我们称之为 “文本反演” 的优化过程找到的。

我们进一步研究了一系列基于通常在生成对抗网络(GAN)反演中使用的工具的扩展。我们的分析表明,虽然一些核心原则仍然存在,但以朴素的方式应用先前的技术要么没有帮助,要么是有害的。

我们展示了我们的方法在广泛的概念和提示上的有效性,表明它可以将独特的对象注入到新场景中,跨不同风格进行转换,转移姿势,减少偏见,甚至想象新产品。

总的来说,我们的贡献如下:

- 我们引入了个性化文本到图像生成的任务,我们在自然语言指导下合成用户提供概念的新场景。?

- 我们在生成模型的背景下提出了 “文本反演” 的概念。在这里,目标是在文本编码器的嵌入空间中找到能够捕捉高层次语义和精细视觉细节的新伪词。

- 我们根据 GAN 启发的反演技术分析了嵌入空间,并展示它在失真和可编辑性之间存在权衡。我们展示了我们的方法位于权衡曲线上的一个吸引人的点。

- 我们通过使用用户提供的概念生成的图像来评估我们的方法,并展示我们的嵌入提供更高的视觉保真度,并且还能够实现更强大的编辑。?

2. 相关工作

文本引导合成。在生成对抗网络(GAN)的背景下,文本引导的图像合成得到了广泛研究(Goodfellow等,2014)。通常,利用注意力机制(Xu等,2018)或跨模态对比方法(Zhang等,2021;Ye等,2021)训练有条件的模型,以重现给定的配对图像-标题数据集的样本(Zhu等,2019;Tao等,2020)。最近,通过利用大规模自回归(Ramesh等,2021;Yu等,2022)或扩散模型(Ramesh等,2022;Saharia等,2022;Nichol等,2021;Rombach等,2021)取得了令人印象深刻的视觉结果。

与训练有条件的模型不同,一些方法采用测试时优化(test-time optimization)来探索预训练生成器的潜在空间(Crowson等,2022;Murdock,2021;Crowson,2021)。这些模型通常引导优化以最小化从辅助模型(如CLIP,Radford等,2021)导出的文本到图像相似性分数。

超越纯粹的图像生成,大量研究探讨了基于文本界面进行图像编辑(Patashnik等,2021;Abdal等,2021;Avrahami等,2022b)、生成器域自适应(Gal等,2021;Kim等,2022)、视频操作(Tzaban等,2022;Bar-Tal等,2022)、动作合成(Tevet等,2022;Petrovich等,2022)、风格迁移(Kwon&Ye,2021;Liu等,2022)甚至用于 3D 对象的纹理合成(Michel等,2021)。

我们的方法基于开放式的、有条件的合成模型。我们并非从头开始训练一个新模型,而是展示了我们可以扩展冻结模型的词汇表,并引入描述特定概念的新伪词。

GAN 反演。使用生成网络操作图像通常需要找到给定图像的相应潜在表示,这个过程称为反演(Zhu等,2016;Xia等,2021)。在 GAN 文献中,这种反演通常通过基于优化的技术(Abdal等,2019, 2020;Zhu等,2020b;Gu等,2020)或使用编码器(Richardson等,2020;Zhu等,2020a;Pidhorskyi等,2020;Tov等,2021)来实现。优化方法直接优化一个潜在向量,将其输入 GAN 将重新创建目标图像。编码器利用大量图像集来训练一个网络,将图像映射到它们的潜在表示中。

在我们的工作中,我们采用了优化方法,因为它可以更好地适应未见过的概念。编码器面临更严格的泛化要求,可能需要在 Web 规模的数据上进行训练才能提供相同的自由度。我们进一步在 GAN反演文献的基础上分析我们的嵌入空间,概述保留和不保留的核心原则。

基于 Diffusion 的反演。在扩散模型领域,反演可以通过向图像添加噪声,然后通过网络去噪朴素地实现。然而,这个过程往往会显著改变图像的内容。Choi 等(2021)通过在去噪过程中将其条件设置为目标图像的加噪低通滤波器数据来改进反演。Dhariwal 和 Nichol(2021)证明了 DDIM(Song等,2020)采样过程可以以闭式形式反演,提取出一个潜在的噪声地图,可以生成给定的真实图像。在 DALL-E 2(Ramesh等,2022)中,他们在这种方法的基础上进行了改进,并展示了它可以用于引起图像的变化,例如图像间的插值或语义编辑。后者依赖于他们使用基于 CLIP 的代码来调节模型,可能不适用于其他方法。

与上述工作将给定图像反演到模型的潜在空间不同,我们将用户提供的概念反演。而且,我们将这个概念表示为模型词汇表中的一个新伪词,从而实现更通用和直观的编辑。

个性化。调整模型以适应特定个体或对象是机器学习研究的一个长期目标。个性化模型通常出现在推荐系统领域(Benhamdi等,2017;Amat等,2018;Martinez等,2009;Cho等,2002)或联邦学习(federated learning)领域(Mansour等,2020;Jiang等,2019;Fallah等,2020;Shamsian等,2021)。

最近,个性化的努力也可以在视觉和图形领域找到。在那里,通常会对生成模型进行精细调整,以更好地重建特定的面孔或场景(Bau等,2019;Roich等,2021;Alaluf等,2021;Dinh等,2022;Cao等,2022;Nitzan等,2022)。

与我们的工作最相关的是 PALAVRA(Cohen等,2022),它利用预训练的 CLIP 模型进行个性化对象的检索和分割。PALAVRA 在 CLIP 的文本嵌入空间中识别指向特定对象的伪词。然后,这些伪词用于描述用于检索的图像,或者为了在场景中分割特定的对象。然而,他们的任务和损失都是判别性的,旨在将对象与其他候选对象分开。正如我们后来展示的(图 5 所示),他们的方法无法捕捉到在新场景中进行合理重建或合成所需的细节。

3. 方法?

我们的目标是实现语言引导的生成新的用户指定概念的能力。为此,我们的目标是将这些概念编码成预训练的文本到图像模型的中间表示。理想情况下,这应该以一种方式完成,使我们能够利用这种模型所代表的丰富语义和视觉先验,并用它来引导对概念的直观视觉转换。

在文本到图像模型通常使用的文本编码器的词嵌入阶段,自然而然地寻找这样一个表示的候选。在那里,离散输入文本首先被转换为适于直接优化的连续向量表示。

先前的研究表明,这种嵌入空间足够表达基本的图像语义(Cohen等人,2022年;Tsimpoukelli等人,2021年)。然而,这些方法利用对比或语言完成目标,这两者都不需要对图像有深入的视觉理解。正如我们在第 4 节中所示,这些方法未能准确捕捉概念的外观,尝试将它们用于合成会导致相当大的视觉破坏。我们的目标是找到能够引导生成的伪词,这是一个视觉任务。因此,我们建议通过视觉重建目标来找到它们。

在下面,我们概述了将我们的方法应用于一类特定生成模型——潜在扩散模型(Rombach等人,2021年)的核心细节。在第 5 节中,我们分析了对这种方法的一系列扩展,这些扩展是由 GAN 反演文献驱动的。然而,正如我们后来展示的,这些额外的复杂性未能改进这里提出的初始表示。

潜在扩散模型。我们在潜在扩散模型(Latent Diffusion Models,LDM)(Rombach等人,2021年)上实现我们的方法,这是最近引入的去噪扩散概率模型(Denoising Diffusion Probabilistic Models,DDPM)(Ho等人,2020年)的一种类别,其在自动编码器的潜在空间中运行。

LDM 包括两个核心组件。首先,一个自动编码器在大量图像的集合上进行预训练。编码器 E 学习将图像 x ∈ D_x 映射到一个空间潜在编码?z = E(x),通过 KL 散度损失或矢量量化进行正则化(Van Den Oord等人,2017年;Agustsson等人,2017年)。解码器 D 学习将这样的潜在映射回图像,使得 D(E(x)) 逼近 x。

第二个组件是一个扩散模型,它被训练以在学习的潜在空间内生成编码。这个扩散模型可以以类标签、分割掩模,甚至是联合训练的文本嵌入模型的输出为条件。设 c(y) 为将条件输入 y 映射到条件向量的模型。然后,LDM 损失由以下公式给出:

![]()

其中 t 是时间步长,z_t 是到时间t的潜在噪声,ε 是未缩放的噪声样本,ε_θ 是去噪网络。直观地说,这里的目标是正确地去除添加到图像的潜在表示中的噪声。在训练过程中,c_θ 和 ε_θ 被联合优化以最小化 LDM 损失。在推理时,随机噪声张量被采样并迭代去噪,以生成新的图像潜在 z0。最后,通过预先训练的解码器将这个潜在编码转换为图像,即 x' = D(z0)。

我们采用了 Rombach 等人(2021年)公开可用的拥有 14 亿参数的文本到图像模型,该模型在LAION-400M 数据集(Schuhmann等人,2021年)上进行了预训练。在这里,c_θ 是通过 BERT(Devlin等人,2018年)文本编码器实现的,其中 y 是文本提示。

接下来,我们回顾这种文本编码器的早期阶段,以及我们选择的反演空间。

文本嵌入。典型的文本编码器模型,如 BERT,始于文本处理步骤(图 2,左侧)。首先,输入字符串中的每个单词或子单词被转换为一个标记,该标记是某个预定义字典中的索引。然后,每个标记都与一个唯一的嵌入向量相关联,可以通过基于索引的查找检索出来。这些嵌入向量通常作为文本编码器 c_θ 的一部分学习。

在我们的工作中,我们选择将这个嵌入空间作为反演的目标。具体而言,我们指定一个占位符字符串 S* 来表示我们希望学习的新概念。我们介入嵌入过程,并用一个新学习的嵌入向量 v* 替换与标记化字符串相关联的向量,本质上是将概念 “注入” 到我们的词汇表中。通过这样做,我们可以构造包含该概念的新句子,就像我们使用任何其他单词一样。

文本反演。为了找到这些新的嵌入向量,我们使用一小组图像(通常是 3-5 张),这些图像跨足多个设置,如不同的背景或姿势。我们通过直接优化来找到 v*,通过最小化方程(1)的 LDM 损失,其中方程中的图像是从小组中采样的。为了调整生成,我们随机采样来自 CLIP ImageNet 模板的中性上下文文本(Radford等人,2021年)。这些包含了形式为 “A photo of S* ”、“A rendition of S* ” 等的提示。完整的模板列表在补充材料中提供。

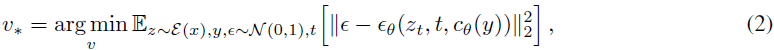

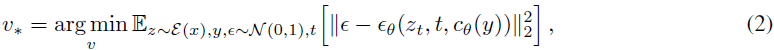

然后,我们的优化目标可以定义为:

并且通过重用(re-using)与原始 LDM 模型相同的训练方案来实现,同时保持 c_θ 和 ε_θ 固定。值得注意的是,这是一个重建任务。因此,我们期望它激发学习嵌入以捕捉与该概念独特的精细视觉细节。

实现细节。除非另有说明,我们保留 LDM(Rombach等人,2021年)的原始超参数选择。单词嵌入是用对象的单词描述符(例如,图 1 中的两个概念分别为 “sculpture” 和 “cat”)的嵌入进行初始化。我们的实验使用 2 台 V100 GPU 进行,批量大小为 4。基本学习率设置为 0.005。与 LDM 一样,我们进一步按照 GPU 数量和批量大小缩放基本学习率,得到有效的学习率为 0.04。所有结果均使用 5000 个优化步骤产生。我们发现这些参数对大多数情况都有效。然而,我们注意到对于一些概念,可以通过更少的步骤或增加学习率来获得更好的结果。

4. 定性比较和应用

在接下来的部分,我们展示通过文本反演实现的一系列应用,并提供与最先进和人工标题基线的视觉比较。

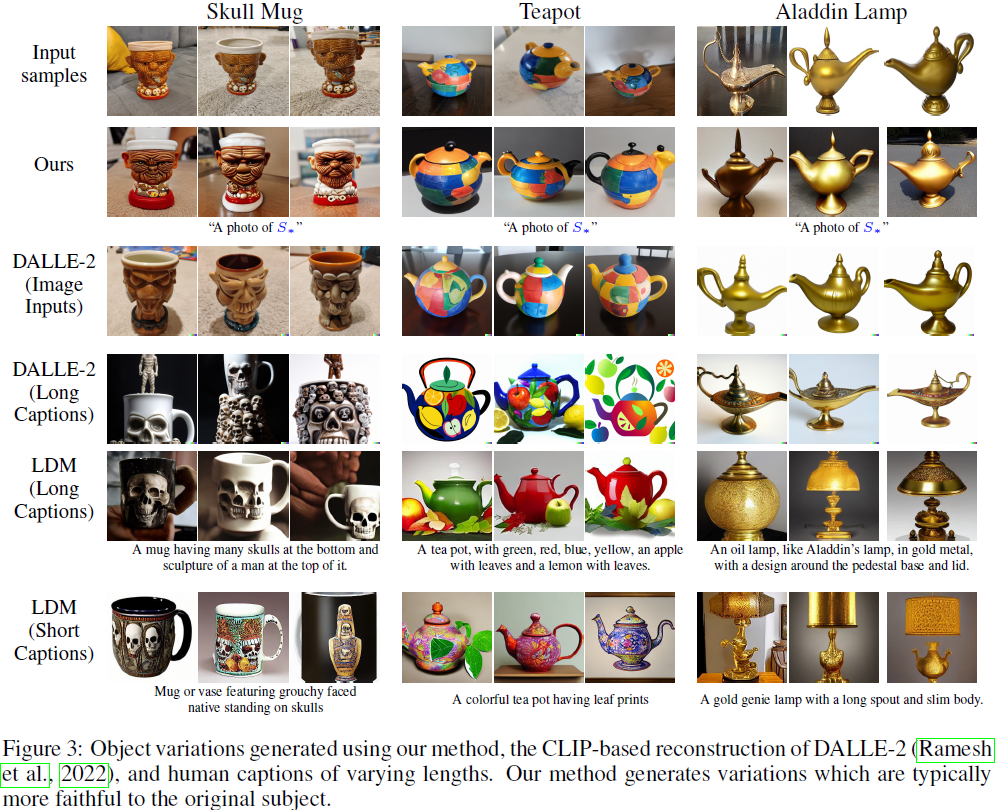

4.1 图像变化

我们首先展示了使用单个伪词捕捉和重新创建物体变化的能力。在图 3 中,我们将我们的方法与两个基线进行比较:由人类标题引导的 LDM 和由人类标题或图像提示引导的 DALLE-2。标题是通过Mechanical Turk 收集的。标注者提供了一个概念的四张图像,并被要求以一种让艺术家能够重新创建的方式描述它。我们要求提供一个短标题(≤ 12个单词)和一个长标题(≤ 30个单词)。总共,我们为每个概念收集了10个标题,其中包括五个短标题和五个长标题。图 3 显示了使用每种设置的随机选择标题生成的多个结果。在补充材料中提供了展示我们未经筛选的重建的额外大型画廊。

正如我们的结果所示,我们的方法更好地捕捉了概念的独特细节。人工标题通常捕捉物体最突出的特征,但提供的细节不足以重新构建像颜色图案(例如茶壶)这样的更细的特征。在某些情况下(例如骷髅杯),通过自然语言描述对象本身可能非常困难。当提供一张图片时,DALLE-2 能够重新创建更吸引人的样本,特别是对于细节有限的众所周知的物体(阿拉丁神灯)。然而,它仍然在个性化对象的独特细节方面遇到困难,而图像编码器(CLIP)可能没有见过(马克杯,茶壶)。相比之下,我们的方法可以成功捕捉这些更细的细节,并且仅使用一个单词嵌入就能实现。然而,请注意,虽然我们的创作更类似于源对象,但它们仍然是可能与源对象不同的变体。

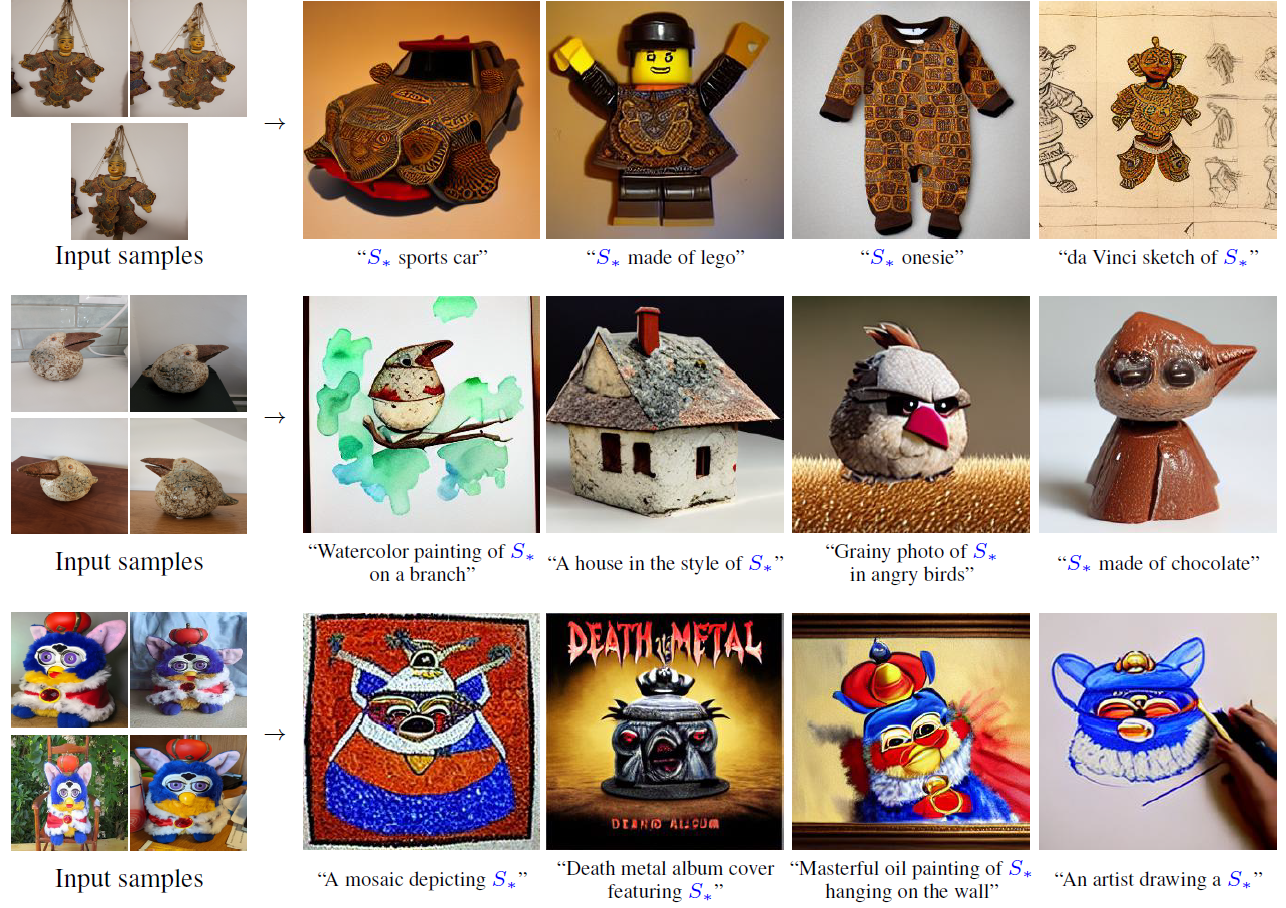

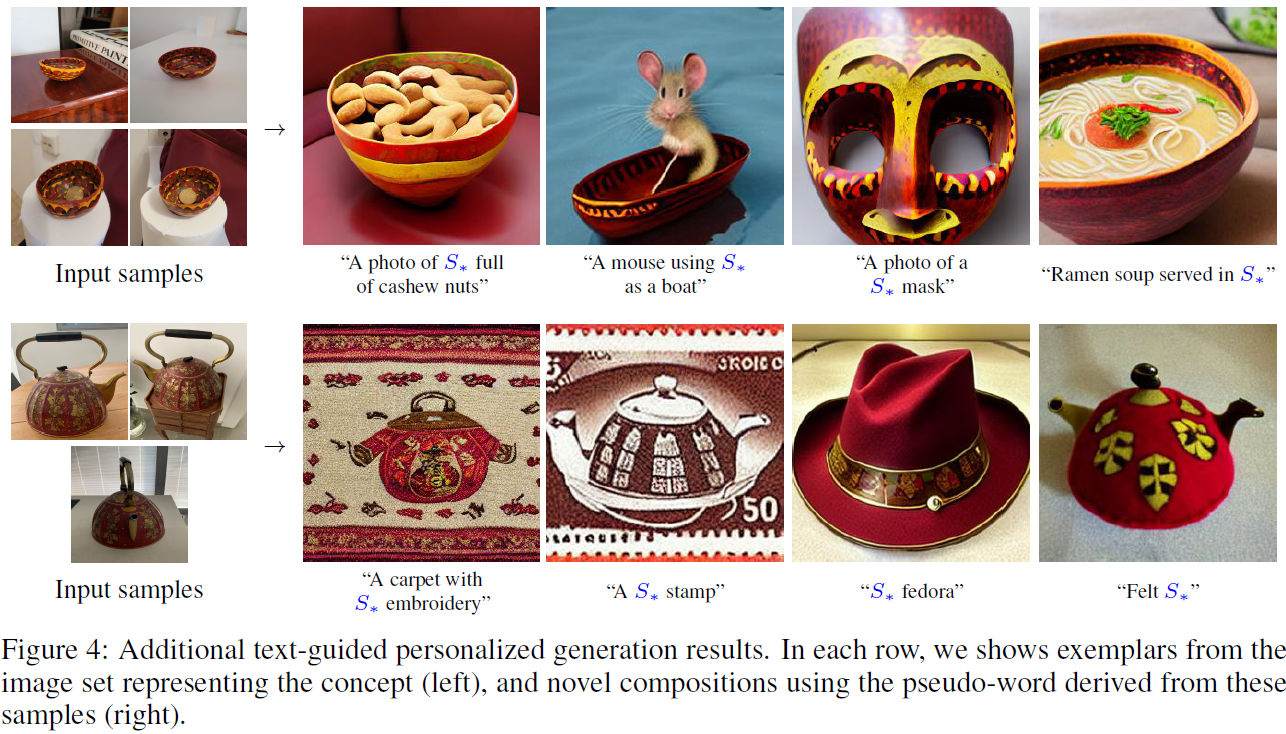

4.2 文本引导的合成

在图 1 和图 4 中,我们展示了通过将学习到的伪词融入新的条件文本中,从而构建新场景的能力。对于每个概念,我们展示了来自我们训练集的示例,以及生成的图像和它们的条件文本。正如我们的结果所示,冻结的文本到图像模型能够共同推理新概念和其大量先前知识,将它们结合在一个新的创作中。重要的是,尽管我们的训练目标是生成性质的,我们的伪词仍然包含模型可以利用的语义概念。例如,观察到碗的能力(第四行)可以包含其他物体,如食物,或者保留 Furby 的鸟头和王冠的能力,同时调整其调色板以更好地匹配提示(相册封面,第三行)。在补充材料中提供了更多概念和文本。

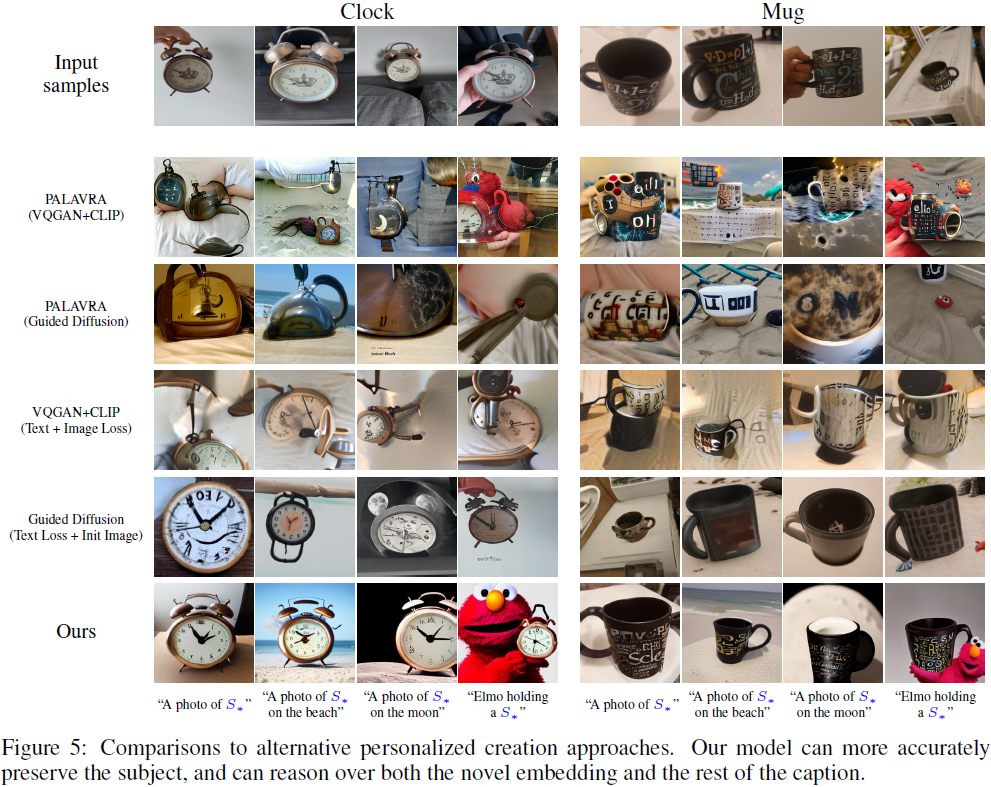

为了更好地评估我们将对象组合到新场景中的能力,我们将我们的方法与几个个性化基线进行比较(图 5)。特别是,我们考虑了最近的 PALAVRA(Cohen等人,2022年),它与我们自己的工作最相似。PALAVRA 将对象集编码到 CLIP 的文本嵌入空间中,使用对比学习和循环一致性目标的混合。我们使用他们的方法找到一个新的伪词,并使用它通过利用 VQGAN-CLIP(Crowson等人,2022年)和 CLIP-Guided Diffusion(Crowson,2021年)来合成新图像。作为第二个基线,我们应用了 Crowson 等人的 CLIP 引导模型,同时试图共同最小化与训练集图像和目标文本之间的基于 CLIP 的距离(VQGAN-CLIP),或通过使用我们集合中的输入图像初始化优化(Guided Diffusion)。对于后者,我们选择了基于图像的初始化,因为我们观察到它们在优化损失中的使用方面表现优于图像的使用。在 Disco Diffusion(Letts等人,2021年)中也报告了类似的观察结果。

PALAVRA 生成的图像(第 2、3 行)通常包含目标提示的元素(例如沙滩、月亮),但未能准确捕捉概念,并显示出相当大的视觉破坏。这并不奇怪,因为 PALAVRA 是以辨别目标为目标进行训练的。在他们的情况下,模型只需要编码足够的信息来区分两个典型的概念(例如,记住杯子是黑白相间的,带有类似文本的符号可能足够了)。此外,他们的词发现过程不需要保持在嵌入空间的区域,该嵌入空间包含可以映射到自然图像流形上的输出的嵌入向量。在文本和图像引导的合成方法(第 4、5 行)中,结果看起来更自然且更接近源图像,但它们未能推广到新的文本。此外,由于我们的方法建立在预训练的大规模文本到图像综合模型之上,我们可以优化一个单独的伪词并将其重复使用于许多新生成的图像。与此同时,基线模型在测试时使用 CLIP 进行优化,因此需要为每个新创建的图像进行昂贵的优化。

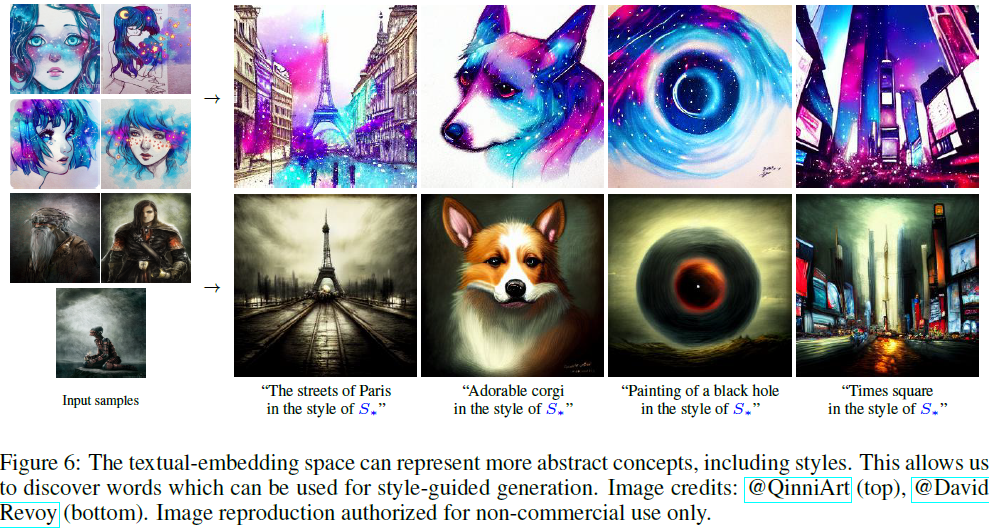

4.3 风格迁移

文本引导合成的典型用例是在艺术领域,用户希望借鉴特定艺术家的独特风格并将其应用于新的创作。在这里,我们展示了我们的模型还可以找到代表特定未知风格的伪词。为了找到这样的伪词,我们只需向模型提供一小组具有共享风格的图像,并用“ 以 S* 风格绘制的绘画” 这种形式的提示替换训练文本。结果如图 6 所示。它们进一步证明了我们捕捉概念的能力不仅限于简单的对象重建,而且还涵盖了更抽象的思想。

请注意,这与传统的风格迁移有所不同,因为我们不一定希望保留某个输入图像的内容。相反,我们给网络以自由决定如何描绘主题的自由,并仅仅要求一种适当的风格。

4.4 概念组合

在图 7 中,我们展示了组合合成,其中引导文本包含多个学习到的概念。我们观察到模型可以同时推理多个新伪词。然而,它在它们之间的关系上有困难(例如,它无法将两个概念并列放置)。我们假设这种限制是因为我们的训练仅考虑了单一概念场景,其中概念是图像核心的一部分。在多对象场景上进行训练可能会缓解这个缺点。然而,我们将这样的研究留待将来的工作。

4.5 偏见减少

文本到图像模型的一个常见局限是它们继承了用于训练它们的互联网规模数据中发现的偏见。然后,这些偏见会在生成的样本中表现出来。例如,DALLE-2 系统卡(Mishkin等人,2022年)报告说,他们的基线模型在提供 “CEO” 提示时倾向于生成白人和男性的图像。类似地,“wedding” 结果通常假定西方婚礼传统,并默认为异性恋夫妇。

在这里,我们展示我们可以利用一个小的定制的数据集,以学习一个对于有偏见的概念来说更“公平”的新单词,然后可以用它来驱动更具包容性的生成。

具体而言,在图 8 中,我们强调了单词 “Doctor” 中编码的偏见,并展示了通过从一个小而更多元化的集合中学习新的嵌入,可以减少这种偏见(即我们增加了感知到的性别和族裔多样性)。

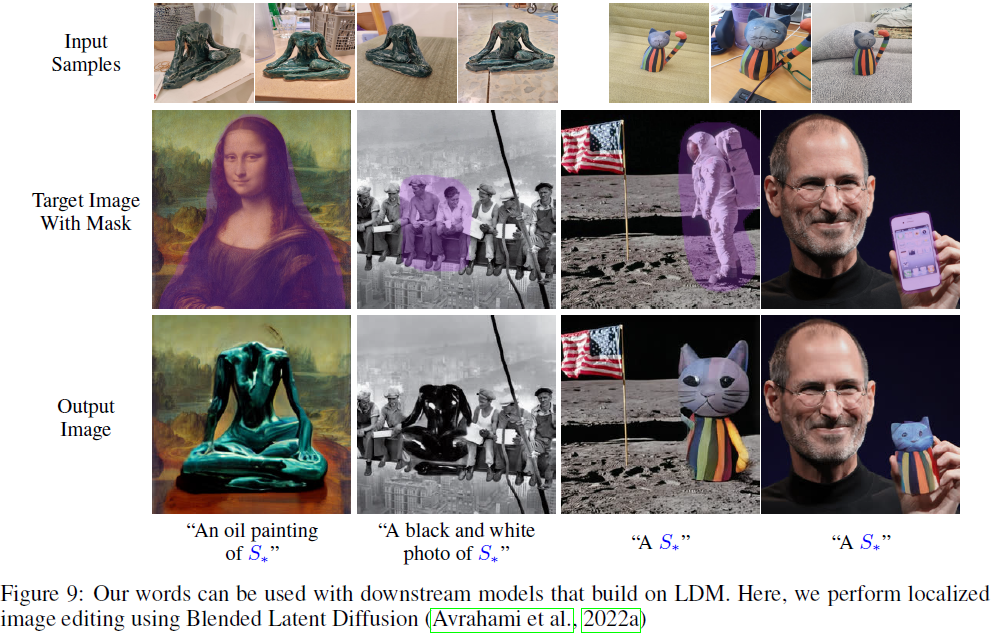

4.6 下游应用

最后,我们展示了我们的伪词可以用于构建在相同初始 LDM 模型上的下游模型。具体而言,我们考虑了最近的混合潜在扩散(Blended Latent Diffusion,Avrahami等人,2022a),它通过潜在空间中的基于掩模(mask)的混合过程,实现了对图像的基于文本的局部编辑。在图 9 中,我们展示了这个局部合成过程也可以以我们学到的伪词为条件,而无需对原始模型进行任何额外的修改。

4.7 图像定制

除非另有说明,本节中的结果是部分定制的。对于每个提示,我们生成了 16 个候选图像(或DALLE-2 的 6 个),然后手动选择了最佳结果。我们注意到类似的定制过程通常在文本条件生成的作品中使用较大批次(Avrahami等人,2022b; Ramesh等人,2021; Yu等人,2022),并且可以通过使用 CLIP 对图像进行排名来自动化这个选择过程。在补充材料中,我们提供了生成结果的大规模、未定制的画廊,包括失败案例。

5. 定量分析

进入一个未知潜在空间提供了许多可能的设计选择。在这里,我们根据 GAN 反演文献探讨这些选择,并发现许多核心假设(如失真-可编辑性权衡(Tov等人,2021; Zhu等人,2020b))也存在于文本嵌入空间中。然而,我们的分析表明,通常在 GAN 反演中使用的许多解决方案在这个空间中不能很好地推广,并且通常是无用或积极有害的。

5.1 评估指标

为了分析潜在空间嵌入的质量,我们考虑两个方面:重建和可编辑性。首先,我们希望衡量复制目标概念的能力。由于我们的方法生成概念的变化而不是特定的图像,我们通过考虑语义 CLIP 空间距离来衡量相似性。具体而言,对于每个概念,我们使用提示:“A photo of S* ” 生成 64 张图像。我们的重建分数是生成图像与概念特定训练集图像之间的平均配对 CLIP 空间余弦相似性。

其次,我们想评估使用文本提示修改概念的能力。为此,我们使用不同难度和设置的提示生成一组图像。这些提示包括背景修改(“A photo of S* on the moon”),风格更改(“An oil painting of S* ”)和组合提示(“Elmo holding a S* ”)。

对于每个提示,我们使用 50 个 DDIM 步骤合成 64 个样本,计算样本的平均 CLIP 空间嵌入,并计算它们与文本提示的 CLIP 空间嵌入的余弦相似性,其中我们省略了占位符 S*(即 “A photo of on the moon”)。在这里,较高的分数表示更好的编辑能力和对提示本身的更高忠实度。请注意,我们的方法不涉及基于 CLIP 的目标分数的直接优化,因此不对 Nichol 等人(2021 年)概述的对抗性评分缺陷敏感。

5.2 评估设置

我们使用一组受 GAN 反演启发的实验设置来评估嵌入空间:

扩展潜在空间:我们考虑一个扩展的、多向量潜在空间,这与 Abdal 等人(2019年)的方法相似。在这个空间中,S* 被嵌入到多个学到的嵌入中,这种方法等同于通过多个学到的伪词描述概念。我们考虑扩展到两个和三个伪词(分别表示为 2-words 和 3-words)。这个设置旨在缓解单一嵌入向量的潜在瓶颈,以实现更准确的重建。

渐进扩展:我们遵循 Tov 等人(2021年)的方法,考虑一个渐进的多向量设置。在这里,我们从一个单一嵌入向量开始训练,在 2000 个训练步骤后引入第二个向量,然后在 4000 个步骤后引入第三个向量。在这种情况下,我们期望网络首先关注核心细节,然后利用额外的伪词来捕捉更精细的细节。

正则化:Tov 等人(2021年)观察到,GAN 空间中的潜在编码在训练期间接近编码分布时具有更高的可编辑性。在这里,我们通过引入一个旨在使学到的嵌入保持接近现有单词的正则化项来研究类似的情况。在实践中,我们最小化学到的嵌入与对象的粗略描述符的嵌入(例如,图 1 中的图像的 “sculpture” 和 “cat”)之间的 L2 距离。

每图标记(token):超越基于 GAN 的方法,我们研究了一种新颖的方案,其中我们将唯一的、每个图像独特的标记引入到我们的反演方法中。让

![]()

表示输入图像的集合。与其优化在所有图像中共享的单个单词向量,我们引入一个通用占位符 S*,以及与唯一嵌入 vi 相关联的每个图像独特的额外占位符

![]()

然后,我们组成形如 “A photo of S* with S_i ” 的句子,其中每个图像与包含其自己唯一字符串的句子相匹配。我们使用方程(2)同时优化 S* 和

![]()

这里的直觉是,模型应该更喜欢在共享编码?S* 中编码共享信息(即概念),同时将每个图像的细节(如背景)放置在 S_i 中。

人类标题:除了学到的嵌入设置外,我们还使用第 4.1 节中概述的人类级别的性能进行比较。在这里,我们简单地将占位符字符串 S* 替换为人类标题,同时使用短标题和长字幕标题。

参考设置:为了提供结果规模的直观感受,我们添加了两个参考基线。首先,我们考虑一个模型的预期行为,该模型始终生成训练集的副本,而不考虑提示。为此,我们简单地将训练集本身用作“生成样本”。其次,我们考虑一个始终与文本提示保持一致但忽略个性化概念的模型。我们通过使用评估提示合成图像,但没有使用伪词来实现。分别将这些设置称为 “仅图像” 和 “仅提示”。

文本反演:最后,我们考虑我们自己的设置,如第 3 节所述。我们进一步使用增加的学习速率(2e-2,“高学习速率”)和减小的学习速率(1e-4,“低学习速率”)评估我们的模型。

其他设置:在补充材料中,我们考虑了反演的两个额外设置:一个关键调整方法(Roich等人,2021; Bau等人,2020),其中模型本身被优化以改善重建,以及 DALLE-2(Ramesh等人,2022)的双分体反演过程。我们进一步分析了图像集大小对重建和可编辑性的影响。

5.3 结果

我们的评估结果总结在图 10(a) 中。我们强调四个特别有趣的观察结果: 首先,我们的方法和许多基线的语义重建质量与简单从训练集中随机抽样的图像相当。其次,单词法在所有多词基线上实现了可比的重建质量,并显著提高了可编辑性。这些观点勾勒出了文本嵌入空间令人印象深刻的灵活性,显示它可以在只使用一个伪词的情况下高度准确地捕捉新概念。

第三,我们观察到我们的基线描绘了一个失真-可编辑性的权衡曲线,接近真实单词分布的嵌入(例如,由于正则化、更少的伪词或更低的学习速率)可以更容易修改,但无法捕捉目标的细节。相反,偏离单词分布可以在改善重建的同时严重降低编辑能力。值得注意的是,我们的单一嵌入模型可以通过简单地改变学习速率沿着这条曲线移动,为用户提供在这种权衡中的一定控制程度。

作为第四个观察结果,我们注意到使用人类描述概念的情况不仅无法捕捉它们的相似之处,还会导致编辑能力的降低。我们假设这与 Paiss 等人(2022年)中概述的选择性相似性属性有关,其中视觉-语言模型倾向于关注一部分语义上有意义的标记。通过使用长标题,我们增加了模型忽略我们期望的设置、仅关注对象描述本身的可能性。与此相反,我们的模型只使用一个标记,从而最小化了这种风险。

最后,我们注意到虽然我们的重建分数与随机抽样的真实图像相媲美,但这些结果应该持谨慎态度。我们的指标使用 CLIP 进行语义相似性比较,对形状保留不太敏感。在这方面,仍有待进一步努力。

5.4 人类评估

我们进一步使用用户研究来评估我们的模型。在这里,我们创建了两个问卷。在第一个问卷中,用户提供了一个概念训练集中的四张图像,并要求根据这些图像的相似度对五个模型生成的结果进行排名。在第二个问卷中,用户提供了描述图像背景的文本(“海滩上的照片”),并要求根据这些文本的相似度对相同模型生成的结果进行排名。

我们使用与基于 CLIP 的评估相同的目标概念和提示,并为每个问卷收集了总共 600 个回答,总计1,200 个回答。结果显示在图 10(b) 中。

用户研究结果与基于 CLIP 的度量相一致,并展示了相似的重建-可编辑性权衡。此外,它们描绘了人类基础标题在尝试复制概念以及在编辑概念时的相同限制。

6. 限制

尽管我们的方法提供了更大的自由度,但它可能仍然在学习精确形状方面遇到困难,而更多地是将一个概念的 “语义 ”本质纳入其中。对于艺术创作来说,这通常已经足够了。在未来,我们希望能够更好地控制对重建概念准确性的精度,使用户能够利用我们的方法执行需要更大精度的任务。

我们方法的另一个限制在于较长的优化时间。使用我们的设置,学习一个概念大约需要两个小时。通过训练一个编码器直接将一组图像映射到它们的文本嵌入,这些时间可能可以缩短。我们希望未来能够探索这方面的工作。

7. 社会影响

文本到图像模型可以用于生成误导性内容并推动虚假信息。个性化创作可能使用户能够伪造更具说服力的非公开个人的图像。然而,我们的模型目前并未在程度上保护身份,以至于这成为一个问题。

这些模型进一步容易受到训练数据中存在的偏见的影响。例如,在描绘 “医生” 和 “护士” 时存在性别偏见,当要求科学家的图像时存在种族偏见,以及更微妙的偏见,例如在提示 “婚礼” 时存在异性恋夫妇和西方传统的过度呈现(Mishkin等人,2022年)。由于我们建立在这样的模型基础上,我们自己的工作可能同样会展现出偏见。然而,正如在图 8 中所演示的,我们更精确地描述特定概念的能力也可以作为减少这些偏见的手段。

最后,学习艺术风格的能力可能会被滥用以侵犯版权。用户可以在未经允许的情况下对艺术家的图像进行训练,并以类似的风格生成图像,而不必支付艺术家的作品费用。虽然生成的艺术品仍然容易识别,但在未来,此类侵权可能难以检测或在法律上追究责任。然而,我们希望这些缺点能够通过这些工具可能提供的新机会来抵消,例如艺术家可以授权其独特的风格,或者能够快速创建新作品的早期原型。

8. 结论

我们介绍了个性化的、以语言为导向的生成任务,其中利用文本到图像模型在新的环境和场景中创建特定概念的图像。我们的方法,“文本反演”,通过在预训练文本到图像模型的文本嵌入空间中将概念反转为新的伪词来运作。这些伪词可以通过简单的自然语言描述注入到新的场景中,从而实现简单而直观的修改。在某种程度上,我们的方法允许用户利用多模态信息,使用以文本为驱动的界面以便于编辑,但在接近自然语言的限制时提供视觉线索。

我们的方法是在 LDM(Rombach等人,2021年)上实施的,这是最大的公开可用的文本到图像模型。然而,它并不依赖于他们方法中独特的任何架构细节。因此,我们相信文本反转很容易适用于其他更大规模的文本到图像模型。在那里,文本到图像对齐、形状保持和图像生成的保真度可能会进一步提高。

我们希望我们的方法为未来的个性化生成工作铺平道路。这些工作可能是各种下游应用的核心,从提供艺术灵感到产品设计。

S. 总结

S.1 主要贡献

在大规模模型中引入新概念通常是困难的。对每个新概念重新训练一个模型的成本过高,而在少数示例上进行微调通常会导致灾难性的遗忘。更为谨慎的方法是冻结模型并训练转换模块,以在面对新概念时调整其输出。然而,这些方法仍然容易忘记先前的知识,或者在同时访问新学到的概念时面临困难。

为解决这个问题,本文介绍了个性化的、以语言为导向的生成任务,“文本反演”:在预训练文本到图像模型的文本嵌入空间中将概念反演为新的伪词,然后通过简单的自然语言描述将这些伪词注入到新的场景中,从而实现个性化创作。值得注意的是,我们发现一个单一的词嵌入足以捕捉独特而多样的概念。

S.2 架构和方法

本文使用的框架如图 2 所示:

- 首先,输入字符串中的每个单词或子单词被转换为一个标记,该标记是某个预定义字典中的索引。

- 然后,每个标记都与嵌入空间(与?GAN 的潜在空间相似)一个唯一的向量(连续的表示)相关联,可以通过基于索引的查找检索出来。

- 指定一个占位符字符串 S* 来表示希望学习的新概念。在嵌入过程中,使用新学习的嵌入向量 v* 替换与标记化字符串相关联的向量,本质上是将概念 “注入” 到的词汇表中。通过这样做,可以构造包含该概念的新句子,就像使用任何其他单词一样。?

- 为了找到这些新的嵌入向量,使用一小组图像(通常是 3-5 张),这些图像跨足多个设置,如不同的背景或姿势。通过直接优化 LDM 损失来找到 v*,其中使用的图像是从小组中采样的。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- VSCode之PowerShell中创建项目踩坑

- 因为没有深入,所以都是一知半解,努力也始终只在表面打转,无法提高,学习如何循序渐进的深入?天花板

- MS-DETR论文解读

- Docker 如何删除所有没有名字的镜像

- 【暗蚊】黑客通过国内下载站传播Mac远控木马攻击活动分析

- git常用命令集合及其演示

- C++ 侯捷 内存管理

- mysql无法连接问题及其环境变量配置

- 动态IP代理与静态IP代理:详细区别与比较全析

- ROS+moveit+jakaminicob仿真运动