轻量化CNN网络 - ShuffleNet

1. ShuffleNet V1

论文:ShuffleNet: An Extremely Efficient Convolutional Neural Network for Mobile Devices

网址:https://arxiv.org/abs/1707.01083

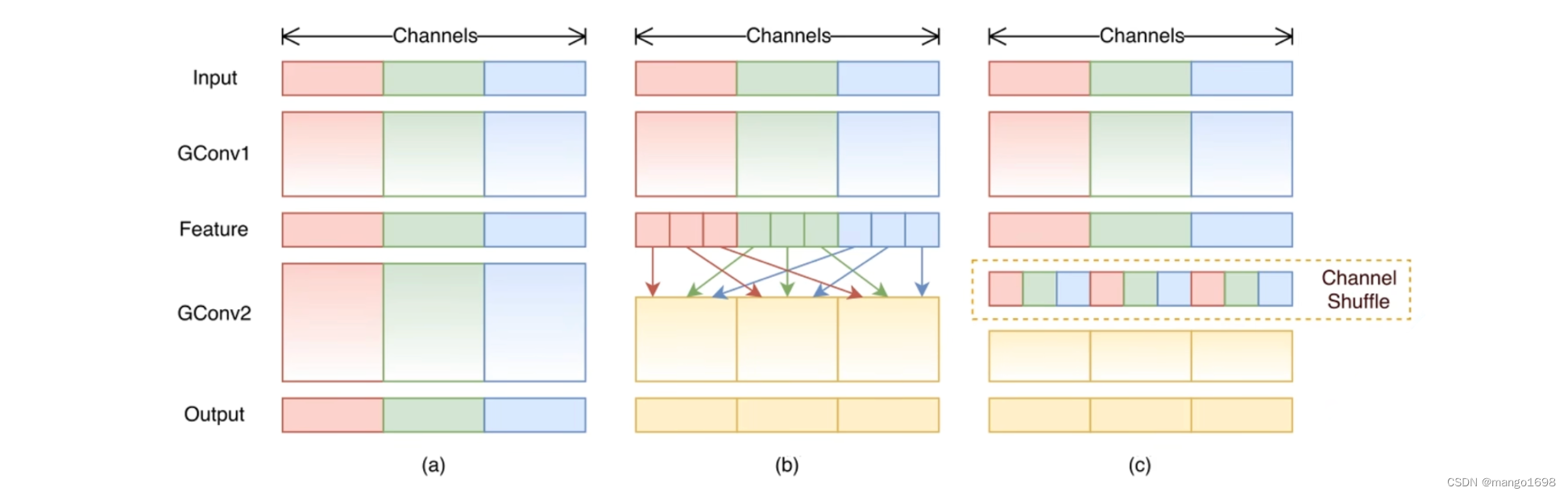

提出了Channel Shuffle的思想,在Shuffle Unit中全是GConv和DWConv。

GConv虽然能够减少参数与计算量,但GConv中不同组之间信息没有交流。

在ResNeXt网络中,PWConv的计算量占据了全部计算量的 93.4 % 93.4\% 93.4%。使用的GConv的计算量是比较少的。

所以,在ShuffleNet V1中,作者将所有的升维和降维的 1 × 1 1\times1 1×1的卷积全部换为了GConv。

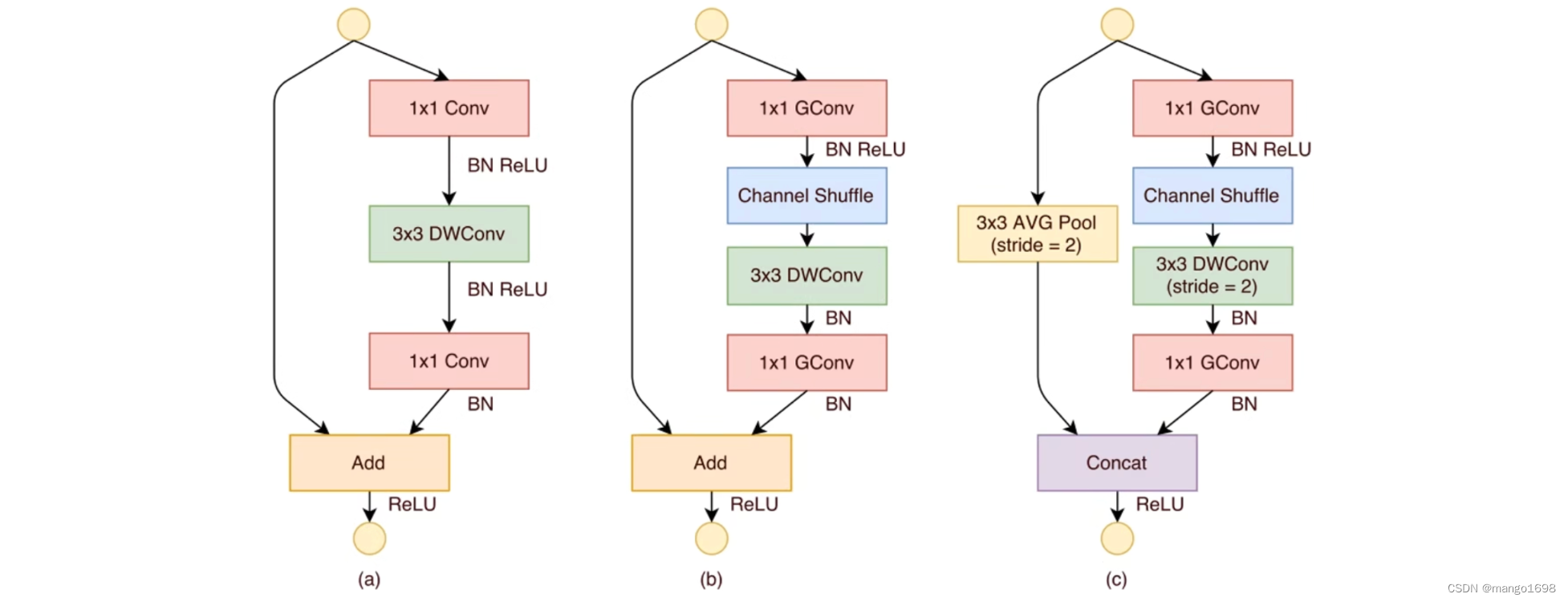

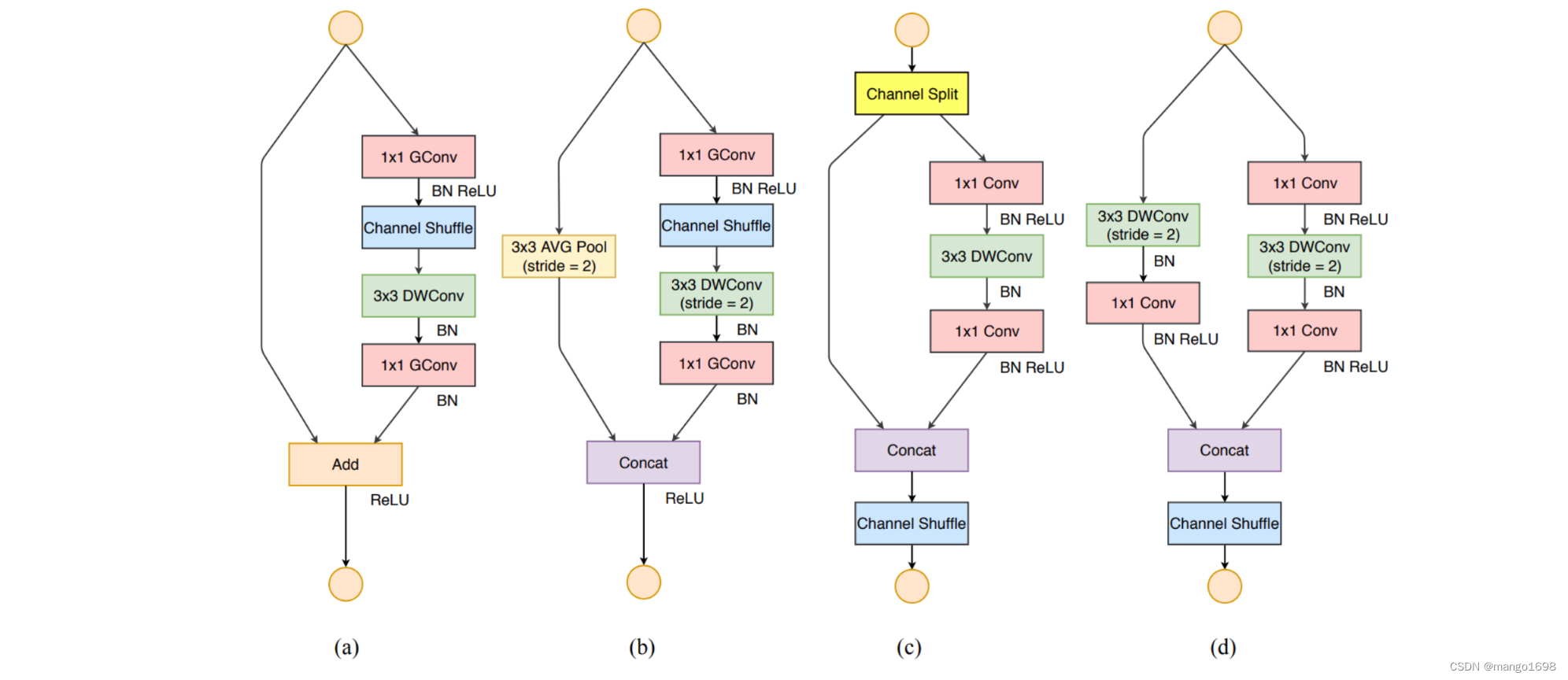

图(b)为stride=1的情况,图?为stride=2的情况。

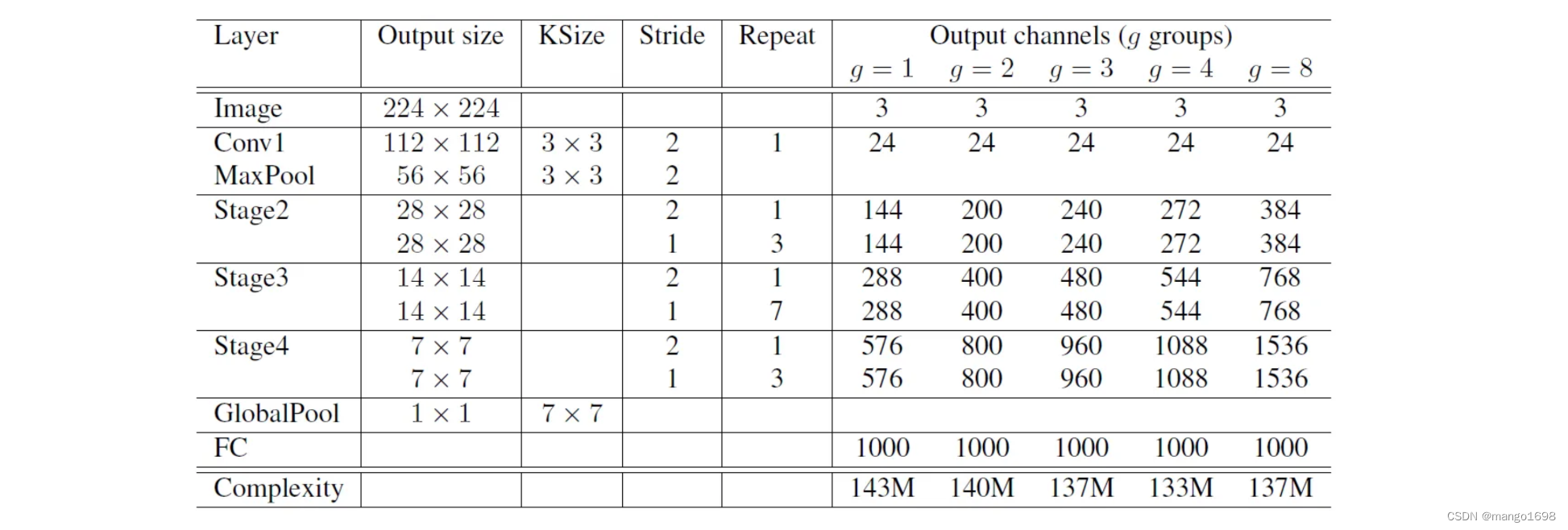

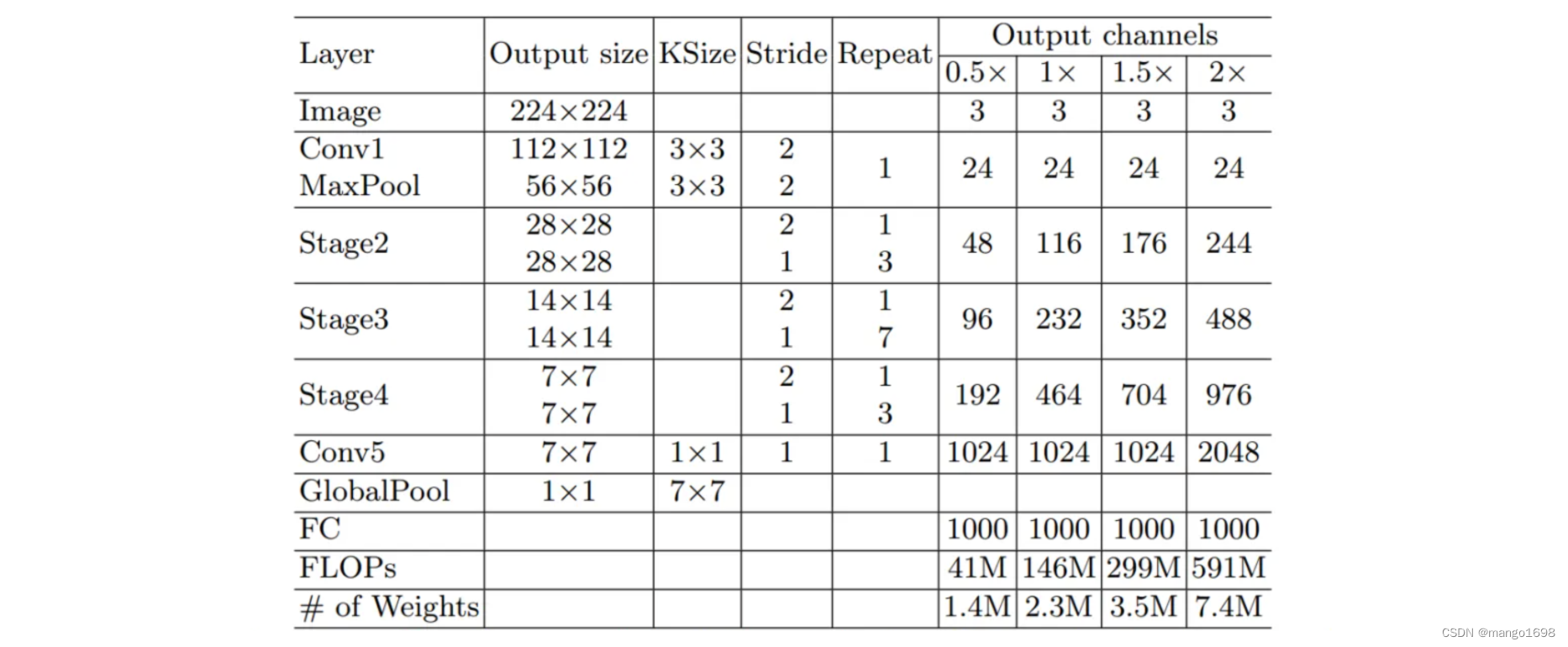

ShuffleNet V1网络结构

2. ShuffleNet V2

论文:ShuffleNet V2: Practical Guidelines for Efficient CNN Architecture Design

网址:https://arxiv.org/abs/1807.11164

补充:

FLOPS:每秒浮点运算次数,可以理解为计算的速度,是衡量硬件性能的一个指标。

FLOPs:浮点运算数,理解为计算量。可以用来衡量算法/模型的复杂度。(1GFLOPs = 1 0 9 10^9 109FLOPs)

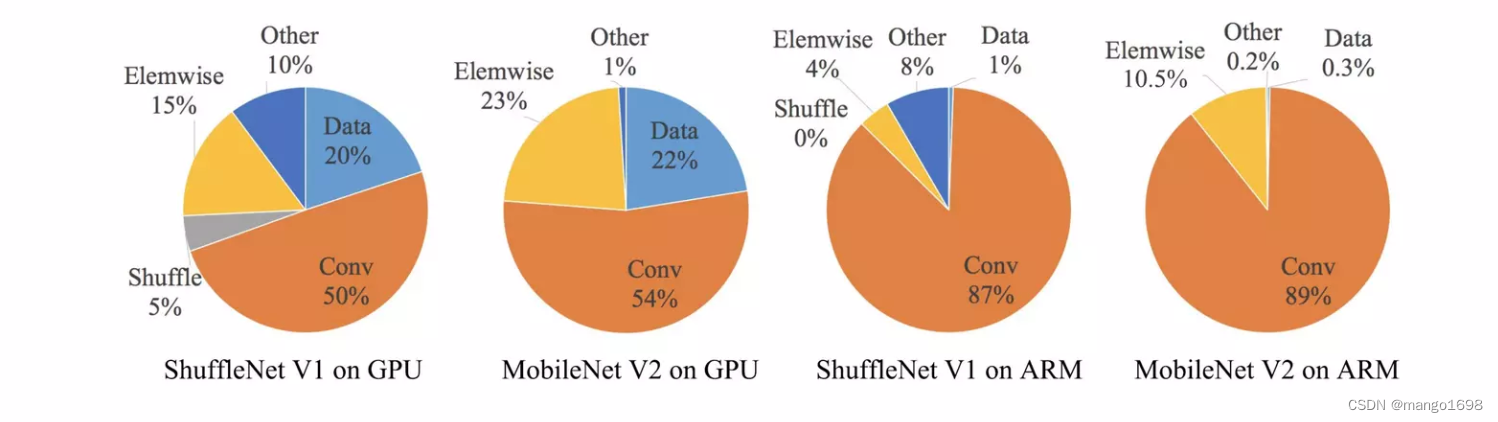

- 在ShuffleNet V2论文中,作者提出,计算复杂度,不能只看FLOPs,还要参考其他的一些指标。(最近读的一篇论文:

Run, Don’t Walk: Chasing Higher FLOPS for Faster Neural Networks指出提高网络速度,不仅要降低网络的FLOPs,同时要提升FLOPS,因此提出了一种新型的PConv,提出了一种新的网络FasterNet,论文网址:https://arxiv.org/abs/2303.03667)

-

作者提出了4条设计高效网络的准则。

-

提出了新的block设计。

4条设计高效网络的准则

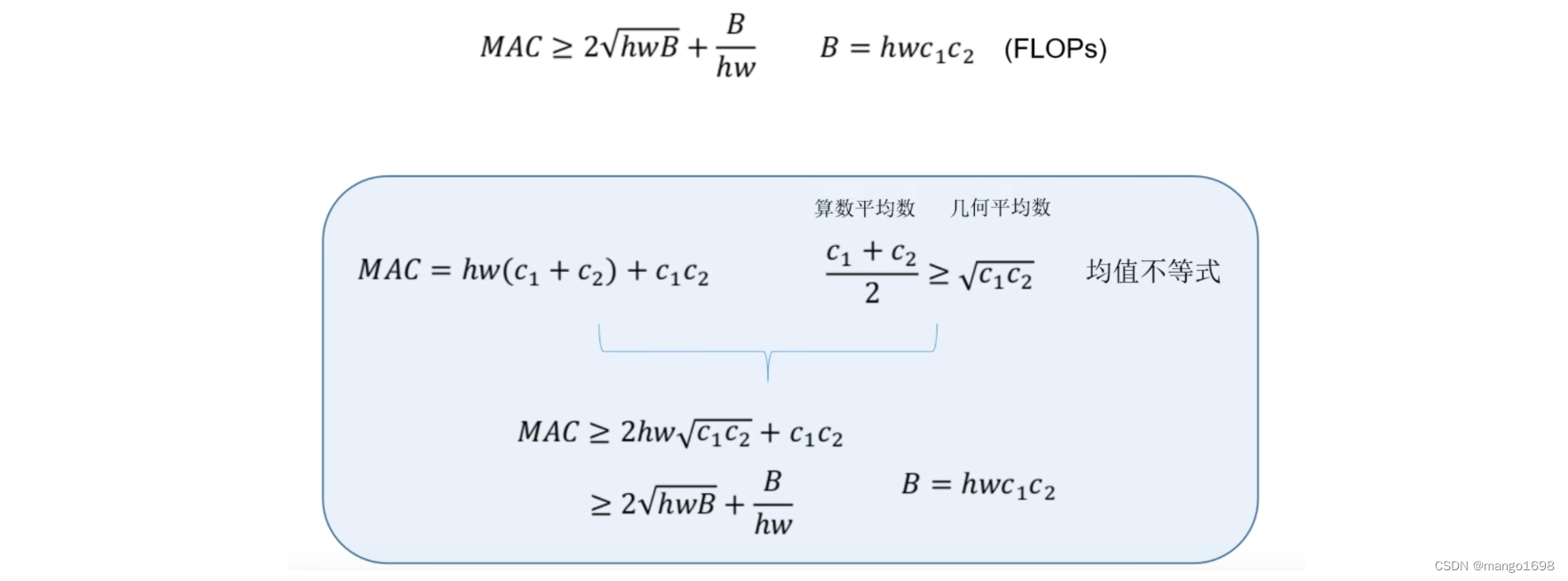

1.Equal channel width minimizes memory access cost(MAC)

当卷积层的输入特征矩阵与输出特征矩阵channel相等时,MAC最小(保持FLOPs不变时)

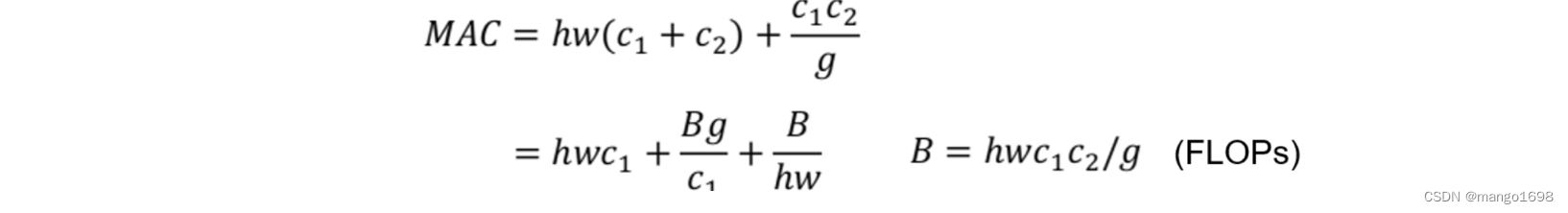

2.Excessive group convolution increase MAC

当GConv的groups增大时(保持FLOPs不变时),MAC也会增大。

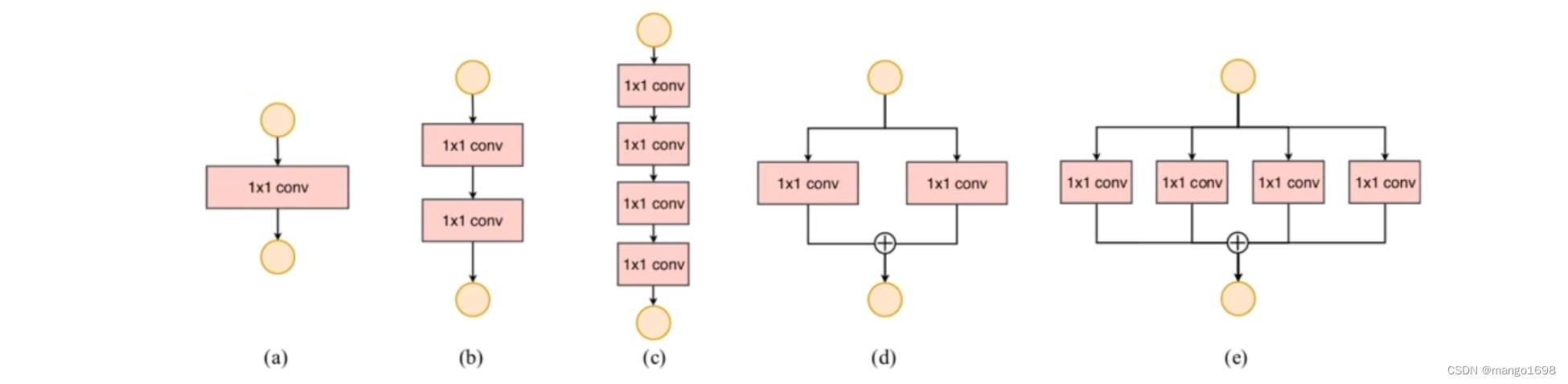

3.Network fragmentation reduces degree of parallelism

网络设计的碎片化(分支)程度越高,速度越慢

虽然碎片化可以提高我们网络的准确率,但是同时也会降低网络的效率。

4.Element-wise operations are non-negligible

Element-wise操作带来的影响是不可忽略的。

Element-wise操作包括:ReLU、AddTensor(相加操作)、AddBias(使用偏执)等。这种操作的特点是,FLOPs很小,但是MAC很大。

根据4条准则,ShuffleNet对网络进行了更新。

(a)(b)为shufflenet V1,?(d)为ShuffleNet V2中stride分别为1和2的两种情况。

ShuffleNet V2网络结构

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- MySQL索引,事务与存储引擎

- 排障启示录-无线漫游效果差

- 邦芒攻略:让HR看得上的简历五大要素

- Visual Studio Code (VS Code)安装教程(非常详细)从零基础入门到精通,看完这一篇就够了

- typescript,eslint,prettier的引入

- [管理者与领导者-129]:很多人对高情商的误解,工程师要扩展自己的情商吗?工程师如何扩展自己的情商?

- Liunx中用户缓冲区

- 2024年【中级消防设施操作员(考前冲刺)】考试题库及中级消防设施操作员(考前冲刺)免费试题

- YHZ013 Python 注释

- 玩具乐器企业网站建设的作用是什么