DiSparse: Disentangled Sparsification for Multitask Model Compression论文简读

发布时间:2024年01月08日

这篇论文提出了一个名为DiSparse的方法,它专门针对多任务模型压缩问题设计了一种独特的剪枝和稀疏训练方案。在深度学习中,尤其是计算机视觉领域,卷积神经网络(CNN)由于其卓越的性能而被广泛应用,但随着模型规模的增大和参数数量的剧增,对于边缘设备等资源有限的应用场景,有效压缩模型以节省存储空间和提高计算效率变得至关重要。

在多任务学习(MTL)中,单个模型同时解决多个相关任务,可以显著减少训练和推理时间,并通过学习跨任务共享的表示来提升泛化能力。然而,当涉及到多任务网络的压缩时,由于不同任务之间特征的高度纠缠,传统的剪枝和稀疏训练方法往往效果不佳。这是因为共享参数空间中的某些参数对一个任务可能不重要,但对另一个任务却至关重要。

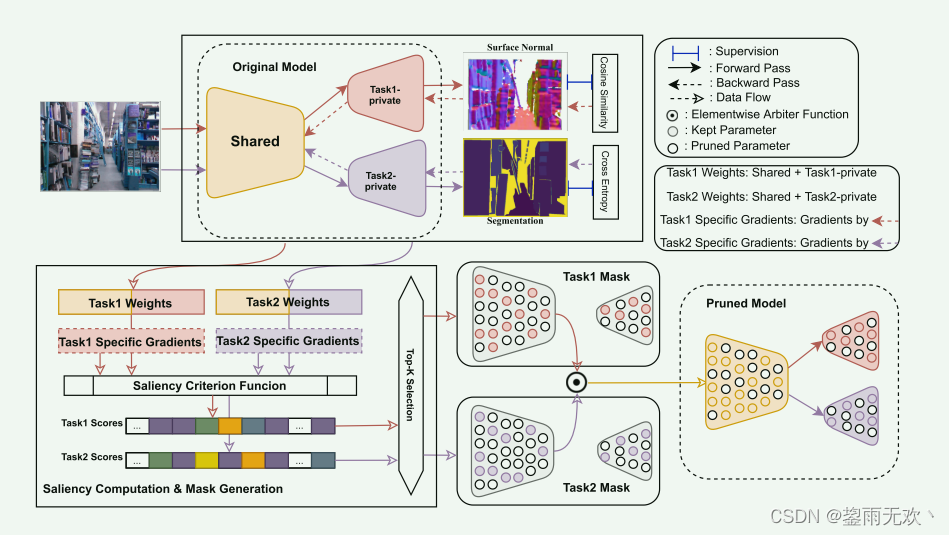

为了解决这个问题,DiSparse提出了一种新颖的剪枝策略,该策略充分考虑了多任务网络中特征的纠缠特性。具体来说,DiSparse首先独立评估每个任务在共享参数空间中各个参数的重要性得分,然后仅剔除那些对所有任务都不重要的参数,这样就避免了因剪枝而导致某些任务性能急剧下降的问题,从而实现了一个更加平衡的网络结构。

在实际操作中,DiSparse会为每个任务生成二进制的剪枝掩码,并基于所有任务的一致意见作出选择决策。在处理共享参数部分时,DiSparse采用了“仲裁者”函数A,将各任务独立计算出的与共享参数相关的掩码集合起来,综合决定最终的共享参数剪枝掩码Bc。

实验结果显示,无论是静态稀疏训练还是动态稀疏训练,以及在预训练网络上进行剪枝的情况下

文章来源:https://blog.csdn.net/RuanJianNB/article/details/135451677

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 智能优化算法应用:基于天鹰算法3D无线传感器网络(WSN)覆盖优化 - 附代码

- springcloud Config配置中心

- PHP 之道(PHP The Right Way 中文版)

- 清风数学建模笔记-因子分析

- P1309 [NOIP2011 普及组] 瑞士轮————C++

- Spring Boot接口请求响应慢,超过10秒以上,如无法优化SQL或代码的情况下,建议写入数据库或缓存中,请求接口时从数据库或缓存中读取返回

- 第23节: Vue3 绑定 HTML 类

- 2023海内外零知识证明学习资料汇总(二)(深入理解零知识证明篇)

- 数据结构与算法教程,数据结构C语言版教程!(第二部分、线性表详解:数据结构线性表10分钟入门)四

- B/S架构云端SaaS服务的医院云HIS系统源码,自主研发,电子病历病历4级