港大&谷歌提出GO-NeRF:在NeRF中生成协调且高质量的3D对象

尽管在3D生成方面取得了进展,但在作为NeRF表示的现有3D场景中直接创建3D对象仍然是未经探索的。这个过程不仅需要高质量的3D对象生成,还需要将生成的3D内容无缝地合成到现有的NeRF中。为此,作者提出了一种新方法,GO-NeRF,能够利用场景上下文进行高质量和谐调的3D对象生成,将其嵌入到现有的NeRF中。方法采用了一个组合渲染公式,允许通过学到的3D感知不透明度图将生成的3D对象无缝地合成到场景中,而不会引入意外的场景修改。此外,还开发了定制的优化目标和训练策略,以增强模型利用场景上下文和减轻源于场景中3D对象生成的浮动物等的能力。在前馈和360°场景上进行的大量实验证明了GO-NeRF在生成与周围场景谐调的合成对象以及合成高质量新视图图像方面的卓越性能。

开源地址:https://daipengwa.github.io/GO-NeRF/

近年来,在使用神经辐射场(NeRF)进行可重渲染的现实环境重建方面取得了巨大的进展。与此同时,文本引导的对象生成在创造新颖的3D内容方面表现出显著的潜力。在这项工作中,研究了一个新颖的问题:生成与给定的3D现实场景谐调的3D对象。这种能力对于新场景的创建和编辑至关重要,要求将生成的内容无缝地组合到环境中,并确保在下游应用中获得高度沉浸式的体验。

主要贡献

主要贡献如下:

? 引入了GO-NeRF,这是一种新颖的流程,可以通过文本提示生成与上下文兼容的3D虚拟对象,并将其无缝地嵌入到预训练的神经辐射场中,同时保留不变的场景上下文,并与任意NeRF表示法兼容,适用于现有场景。

? 开发了考虑场景上下文的学习目标和正则化器,实现了高质量、无浮动物体的3D合成和与场景谐调组合,以创建新的3D场景。

? 实验结果展示了方法利用场景上下文进行虚拟对象生成的能力,在前馈和360°数据集上均优于先前的方法。

算法框架

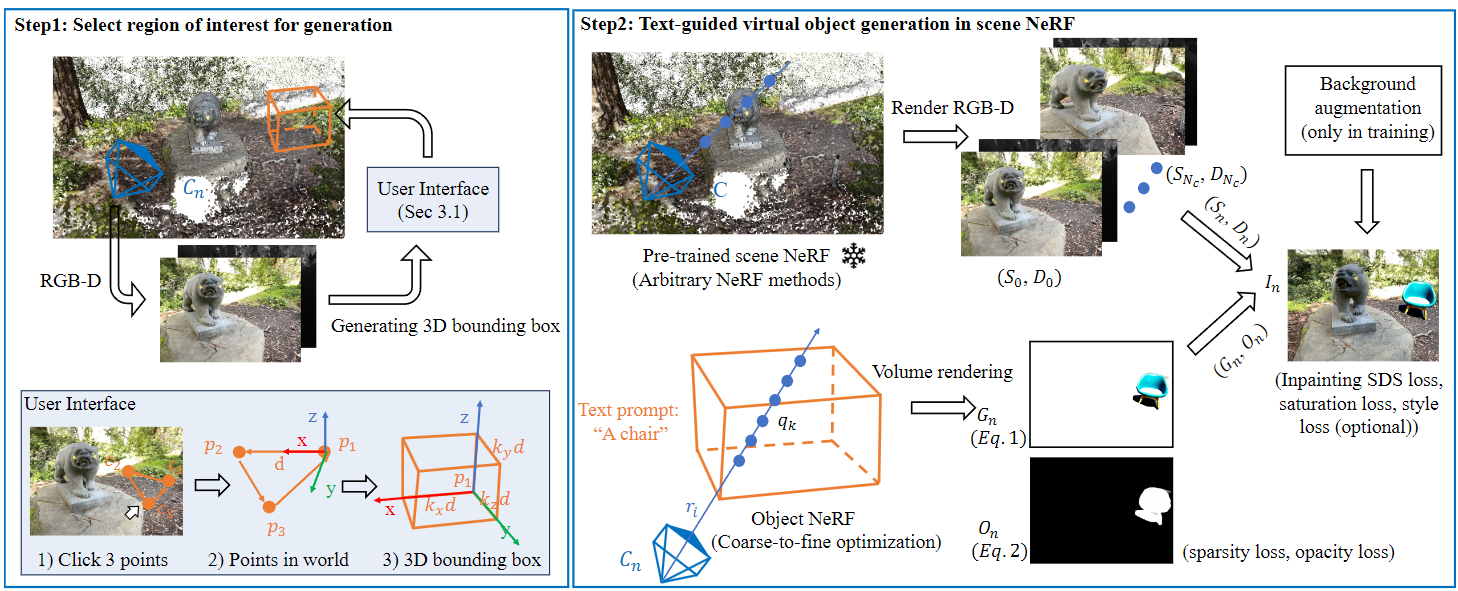

从输入文本提示中生成给定3D NeRF场景内虚拟对象的流程。该流程始于创建一个3D边界框来定义修改区域。这个过程可以通过使用界面在渲染图像上点击三个点来自动化完成。接下来,引入了一个用于场景中生成对象的组合渲染流程。具体而言,从预定义的透视图中将场景辐射场渲染成RGB-D图像;通过在3D框中优化对象NeRF来生成新的对象。为了获得最终的渲染结果,基于预渲染的RGB-D图像和优化后的不透明度映射,将对象和场景进行合成。最后,描述了精心设计的损失函数和训练策略(具体损失公式见原文),这些策略指导了优化过程,并确保了在场景中生成协调一致的对象。方法的概览如下图2所示。

左图:提供了一个用户友好的界面,用于在预训练场景NeRF中选择生成区域。具体而言,用户只需在图像平面上点击三个点,界面将通过透视投影和叉积运算返回场景中的3D边界框。右图:分离了场景渲染(上)和对象生成(下),然后在NeRF的输出空间中将它们合成。场景渲染使用预定义的相机C将场景NeRF渲染成RGB-D图像(S,D)。对象生成在3D框内优化神经辐射场,并通过体积渲染生成RGB图像和不透明度映射。随后,通过优化后的不透明度映射将场景和生成的内容混合,生成最终输出。在优化过程中,设计了损失函数和训练策略,以确保高质量和与场景谐调的结果。

效果展示

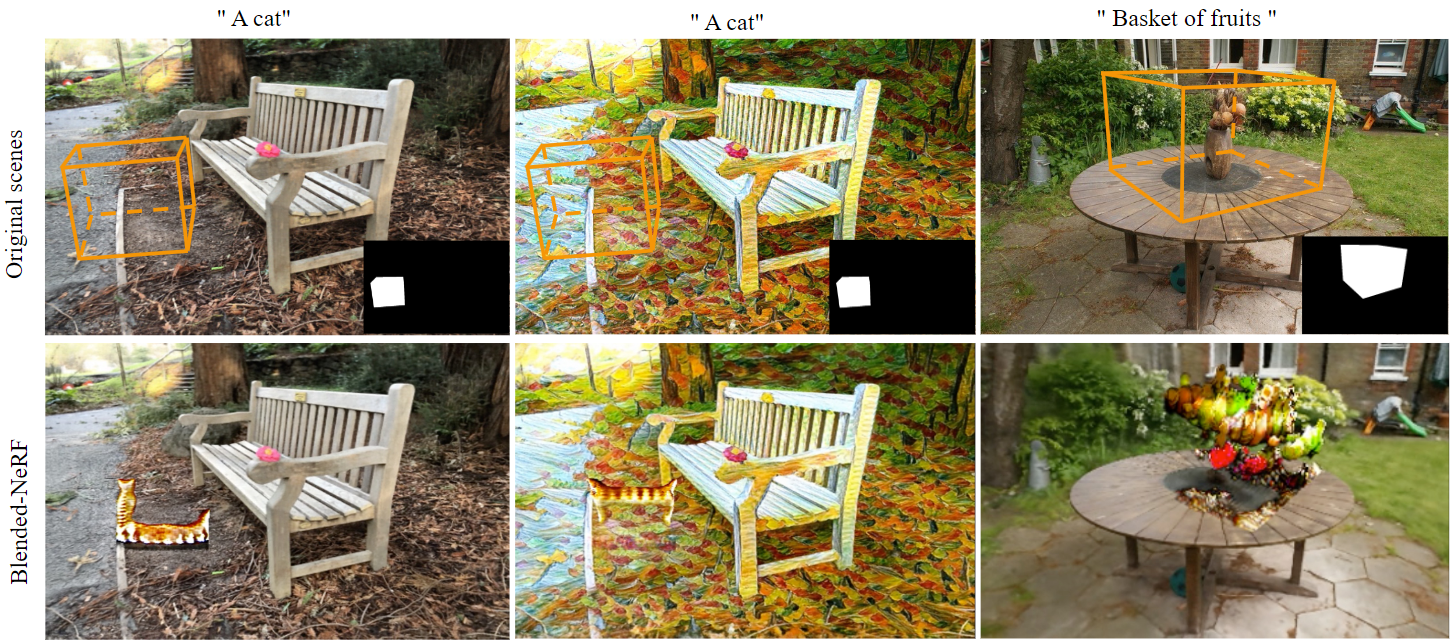

定性比较

在前馈和360度场景上将我们的方法与其他基线进行比较。第一行显示了3D框和相应的2D mask,其他行显示了不同方法的结果。Blended-NeRF往往会产生不真实和不谐调的结果,例如水果飞在天空中。Spin-NeRF?在风格化场景和视角变化较大的360度场景中失败。类似地,手动放置既繁琐又存在利用场景上下文的问题。我们的方法在所有场景中表现良好,能够生成具有不同风格的猫和桌子上带有阴影的水果,以促进谐调。在最后一行的右下方,可视化了经过优化的不透明度图,准确描述了生成内容的轮廓。

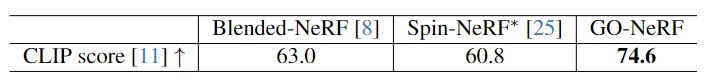

定量比较

此表显示了CLIP分数,表明生成的内容与文本之间的匹配程度。GO-NeRF遥遥领先。

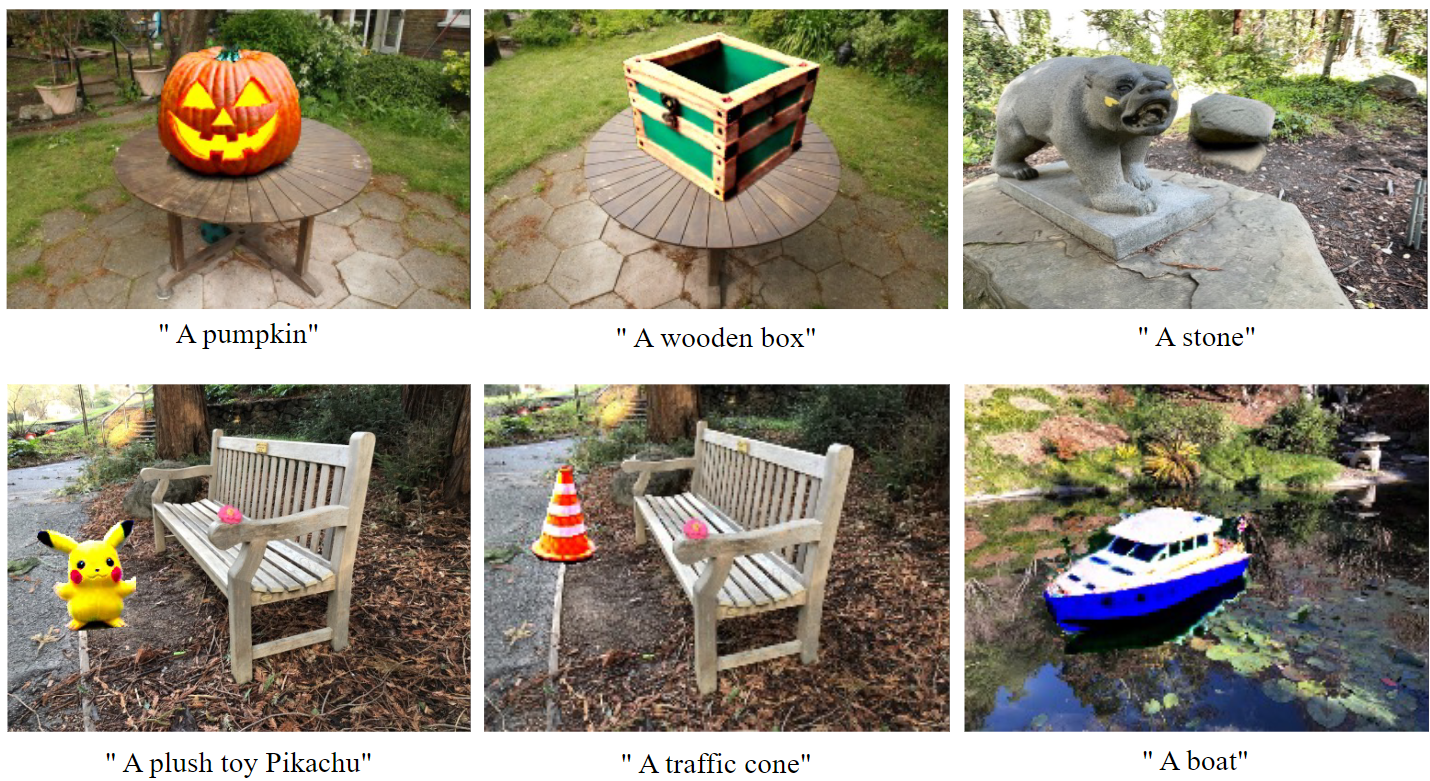

使用不同的文本提示提供更多结果:

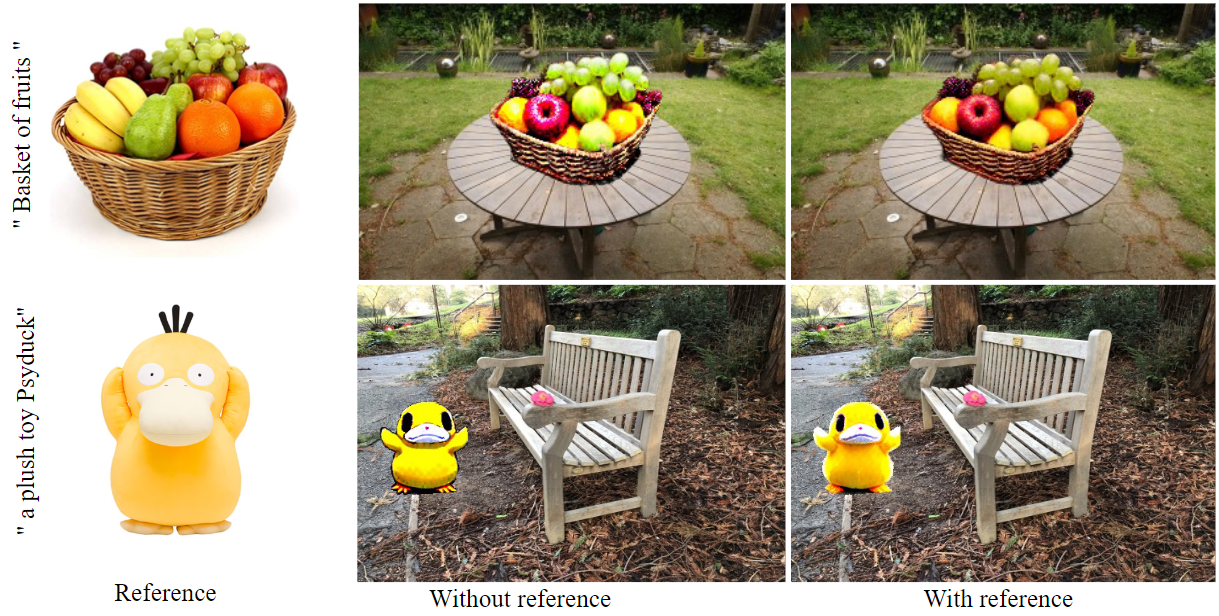

当使用参考图像作为引导时,生成的对象的样式会跟随参考图像:

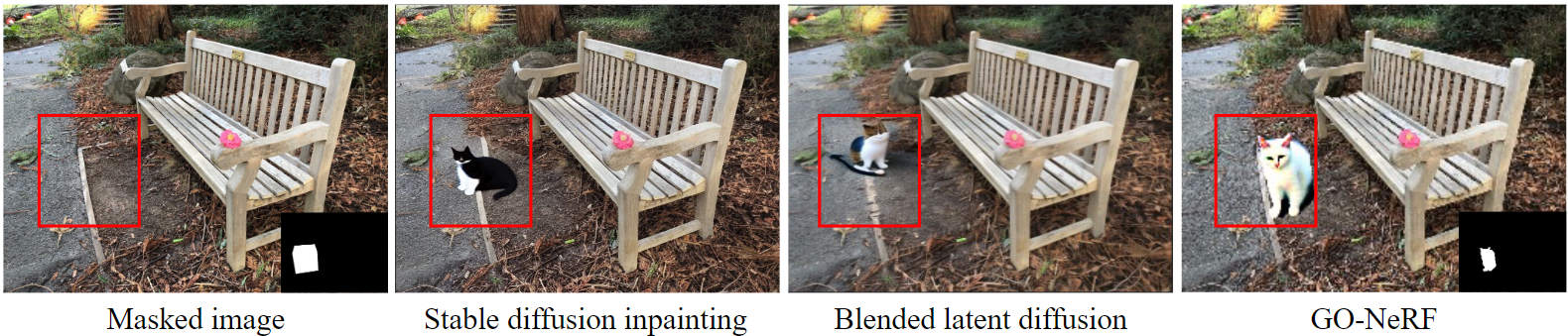

我们的方法在mask区域内生成所需的对象,而不引入意外的场景修改。其他图像修复方法改变了场景内容,比如白线和道路表面。

总结

GO-NeRF,这是一种新颖的方法,通过在现有的场景级NeRF中直接生成受文本控制的3D对象,迈出了重要一步。为了实现这一目标,采用了与量身定制的优化目标和训练策略相关的组合渲染公式,用于合成无缝嵌入现有场景的3D对象。方法利用了预训练的文本引导图像修补网络的图像先验,以促进对象及其周围环境的谐调生成。实验结果显示了我们的方法在前馈和360度数据集中的优越性能。希望我们的研究能在这个领域激发更多的工作。

参考文献

[1] GO-NeRF: Generating Virtual Objects in Neural Radiance Fields

链接:https://arxiv.org/pdf/2401.05750

?多精彩内容,请关注公众号:AI生成未来

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!