GBDT+LR探秘:构建高效二分类模型的初体验

在当今的机器学习领域,模型的选择和优化是提高预测准确性的关键。GBDT(Gradient Boosting Decision Tree,梯度提升决策树)和LR(Logistic Regression,逻辑回归)是两种广泛应用于二分类问题的算法。GBDT通过多棵决策树的集成,能够自动进行特征组合,有效地处理非线性问题,而LR则适用于处理线性问题,并且可以给出概率输出,方便后续的风险评估和推荐概率等。

然而,在实际应用中,单独使用GBDT或LR可能会遇到一些问题。GBDT可能因为树的数量过多或者树的深度过深而导致过拟合,而LR则无法很好地处理非线性问题。因此,将GBDT和LR结合成为一种有效的方法,既可以利用GBDT的特征组合能力,又可以借助LR的概率输出和解释性,提高模型的稳定性和准确性。

在本文中,将详细介绍如何采用GBDT和LR结合的方式来构建二分类模型,包括实施步骤、注意事项以及代码实现。并结合实际数据集进行实验,评估模型的性能。通过这种方式,可以更好地理解GBDT和LR结合的优势(不一定有提升,需结合具体业务及数据),并在实际应用中发挥其强大的预测能力。

实施步骤

具体实施步骤如下:

- 数据预处理:

- 数据清洗:处理缺失值、异常值等。这是非常重要的一步,因为脏数据会严重影响模型的性能,甚至导致模型无法训练。

- 特征工程:包括特征提取、特征转换、特征选择等。通过特征工程,我们可以挖掘出更多有用的信息,提高模型的表达能力。

- 数据切分:将数据集切分为训练集、验证集和测试集。合理的切分可以更好地评估模型的泛化能力,避免过拟合。

- 使用GBDT进行特征转换:

- 利用训练集训练GBDT模型。GBDT作为一种强大的非线性模型,可以自动进行特征组合,捕捉数据中的复杂关系。

- **将训练集中的数据输入到训练好的GBDT模型中,得到每一条数据在每棵树中的叶子节点的索引,这些索引可以作为一种新的特征,通常称为“叶子索引特征”。**这种特征可以看作是GBDT对原始特征的一种高层次抽象,有助于提高模型的非线性建模能力。

- 对验证集和测试集进行同样的处理,以获得它们的叶子索引特征。

- 训练LR模型:

- 使用训练集(包括原始特征和GBDT产生的叶子索引特征)来训练LR模型。LR模型作为一种线性模型,具有较好的解释性,同时可以利用GBDT学习到的特征组合信息。

- 在验证集上调整LR模型的参数,如正则化强度,优化方法等。合理的参数调整可以找到更优的模型,提高预测准确性,调参有专家经验或者自动化调参等方法。

- 模型评估:

- 使用测试集评估模型的性能,常用的评估指标包括准确率、召回率、F1分数、ROC曲线、AUC值等。

- 模型部署:

- 将模型部署到生产环境中,对实时数据进行模型预测。

在实施过程中,需要注意以下几点:

- 过拟合问题:GBDT模型可能因为树的数量过多或者树的深度过深而导致过拟合。可以通过限制树的深度、叶子节点的最大数量、学习率等来避免过拟合。

- 特征重要性:GBDT可以输出特征的重要性,这有助于理解哪些特征对于预测最为关键,也可以用来指导后续的特征选择工作。

- 模型融合:GBDT+LR的结合可以看作是一种模型融合(Model Stacking)的方法,可以提高模型的稳定性和准确性。

最后,在模型训练和评估过程中,不仅仅关注模型的预测准确性,还应该关注模型的解释性和稳定性,确保模型能够在实际应用中有效地识别用户行为,同时控制误报率。

代码实现

先确保自己Python环境安装了相应的依赖包,如果没有安装的话,比如:

pip install lightgbm

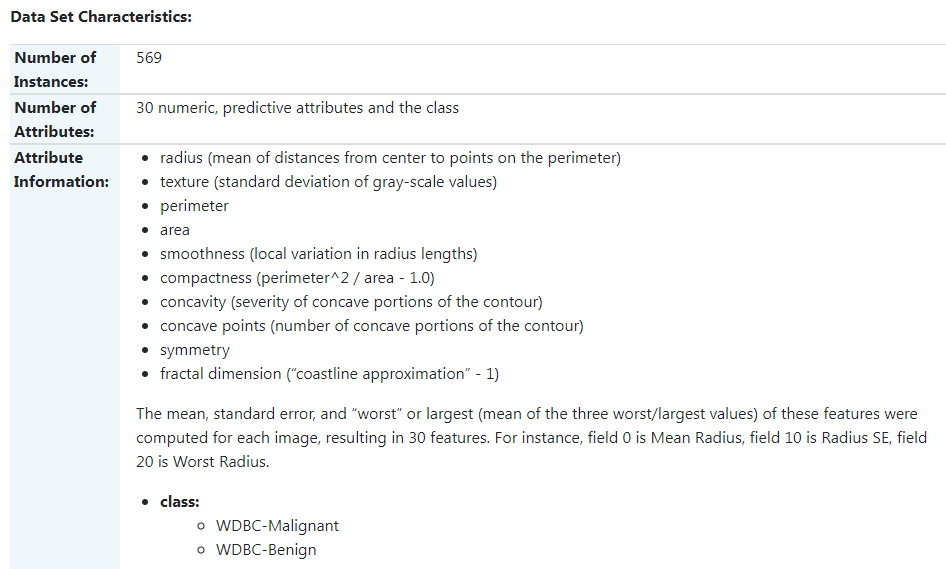

以breast_cancer乳腺癌数据集为例,这是一个经典且非常简单的二元分类数据集。

特征有三十维度,分两类

import numpy as np

import lightgbm as lgb

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import OneHotEncoder

# 加载乳腺癌数据集

from sklearn.datasets import load_breast_cancer

data = load_breast_cancer()

X = data.data

y = data.target

# 划分训练集和测试集, 80%的数据用于训练,20%的数据用于测试

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练GBDT模型, 使用lightgbm库的LGBMClassifier

gbm = lgb.LGBMClassifier(

objective='binary', # 二分类问题

num_leaves=31, # 每棵树的最大叶子节点数

learning_rate=0.05, # 学习率

n_estimators=20) # 树的数量

gbm.fit(X_train, y_train)

y_pred = gbm.predict(X_test)

print("GBDT Accuracy: {:.4f}".format(accuracy_score(y_test, y_pred)))

# # 使用GBDT模型获取训练集和测试集中每条数据在每棵树中的叶子节点索引

train_leaf_indices = gbm.predict(X_train, pred_leaf=True)

test_leaf_indices = gbm.predict(X_test, pred_leaf=True)

# 对叶子节点索引进行One-hot编码,转换为可以用于LR模型输入的特征

ohe = OneHotEncoder(categories='auto')

train_enc = ohe.fit_transform(train_leaf_indices)

test_enc = ohe.transform(test_leaf_indices)

# 训练LR模型, 使用sklearn的LogisticRegression

lr = LogisticRegression(max_iter=10000, penalty='l2', solver='liblinear')

lr.fit(train_enc, y_train)

# 在测试集上进行预测

y_pred = lr.predict(test_enc)

print("GBDT+LR Accuracy: {:.4f}".format(accuracy_score(y_test, y_pred)))

结果:

GBDT Accuracy: 0.9649

GBDT+LR Accuracy: 0.9386

从结果来看,单独使用GBDT模型的准确率为96.49%,而GBDT+LR结合模型的准确率为93.86%。这表明在这个特定的数据集上,GBDT单独的性能略优于GBDT+LR。这可能有几个原因:

-

数据集特性:乳腺癌数据集是一个相对简单且线性可分的数据集。GBDT本身已经足够强大,能够捕捉数据中的复杂关系,因此可能不需要额外的LR层来提高性能。

-

过拟合风险:在添加LR层时,可能会引入额外的过拟合风险。特别是在训练数据集较小或者特征维度不高的情况下,GBDT+LR可能会过拟合,导致性能下降。

-

特征组合:GBDT已经通过树结构自动进行了特征组合,而LR作为一个线性模型,可能无法进一步提升由GBDT生成的特征的性能。

尽管在本文例子中GBDT单独表现更好,但在其他情况下,GBDT+LR可能会更有优势:

- 非线性关系:当数据中存在复杂的非线性关系时,GBDT可以通过特征组合来捕捉这些关系,而LR可以进一步细化预测,提高模型的鲁棒性。

- 特征理解:LR可以提供特征的重要性排序,帮助理解模型决策的过程,这在某些需要模型解释性的场景中非常重要。

- 概率输出:LR能够提供概率输出,这对于需要风险评分或概率推荐的场景(如信贷审批、疾病诊断)非常有用。

总的来说,GBDT+LR的结合是否能够提升性能,很大程度上取决于具体问题的性质和数据的特性。在实际应用中,应该根据具体情况选择合适的模型,并进行充分的实验来验证不同模型组合的效果。

参考

- https://lightgbm.readthedocs.io/en/latest/pythonapi/lightgbm.LGBMClassifier.html

- https://scikit-learn.org/stable/modules/generated/sklearn.linear_model.LogisticRegression.html

感谢阅读!如果对GBDT+LR模型有任何疑问,或者在实际应用中有类似的体验和见解,欢迎在下方评论区留言分享。更多内容欢迎关注公众号:AI科技时讯

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Windows本地部署WampServer环境并实现远程访问服务界面

- CPO-SVM回归 基于冠豪猪优化算法[24年新算法]-支持向量机的多变量回归预测 (多输入单输出)

- 掌握iText:轻松实现固定pdf模板的动态数据填充

- 编译和链接

- 【Git】本地仓库文件的创建、修改和删除

- 如何高效搭建 JMeter 集群压测环境

- 【代码随想录】刷题笔记Day38

- 【OpenGL】VAO,VBO,EBO,顶点属性

- 软件测试面试会问哪些问题?真实的企业软件测试面试真题

- flink的三个state backend的选择