大模型实战营第二期——1. 书生·浦语大模型全链路开源开放体系

发布时间:2024年01月03日

1. 实战营介绍

- github链接:https://github.com/internLM/tutorial

- InternLM:https://github.com/InternLM

- 书生浦语官网:https://intern-ai.org.cn/home

2. 书生·浦语大模型介绍

- 视频链接:B站-书生·浦语大模型全链路开源体系

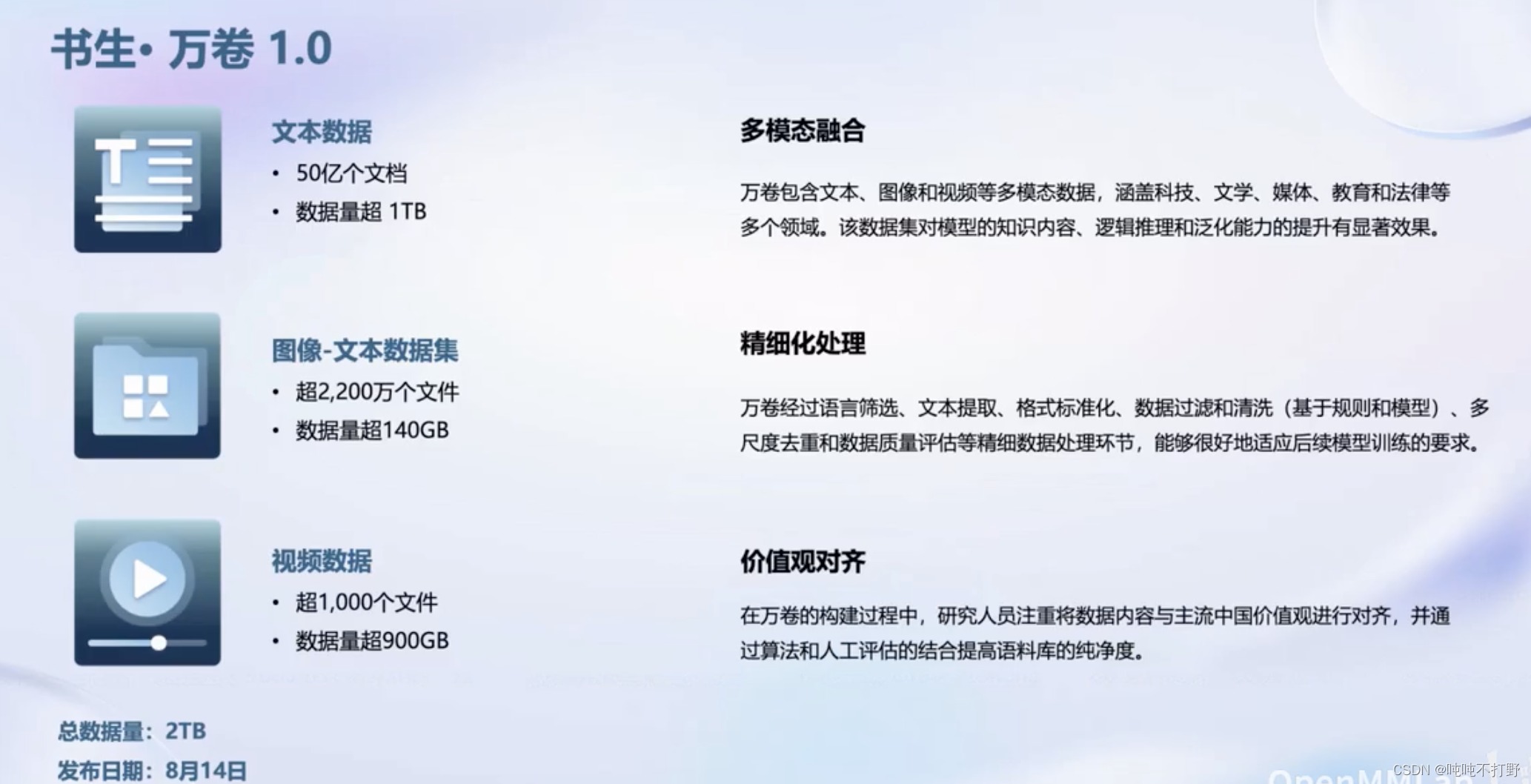

- 数据:汇聚 5400+ 数据集,涵盖多种模态与任务,更多数据集

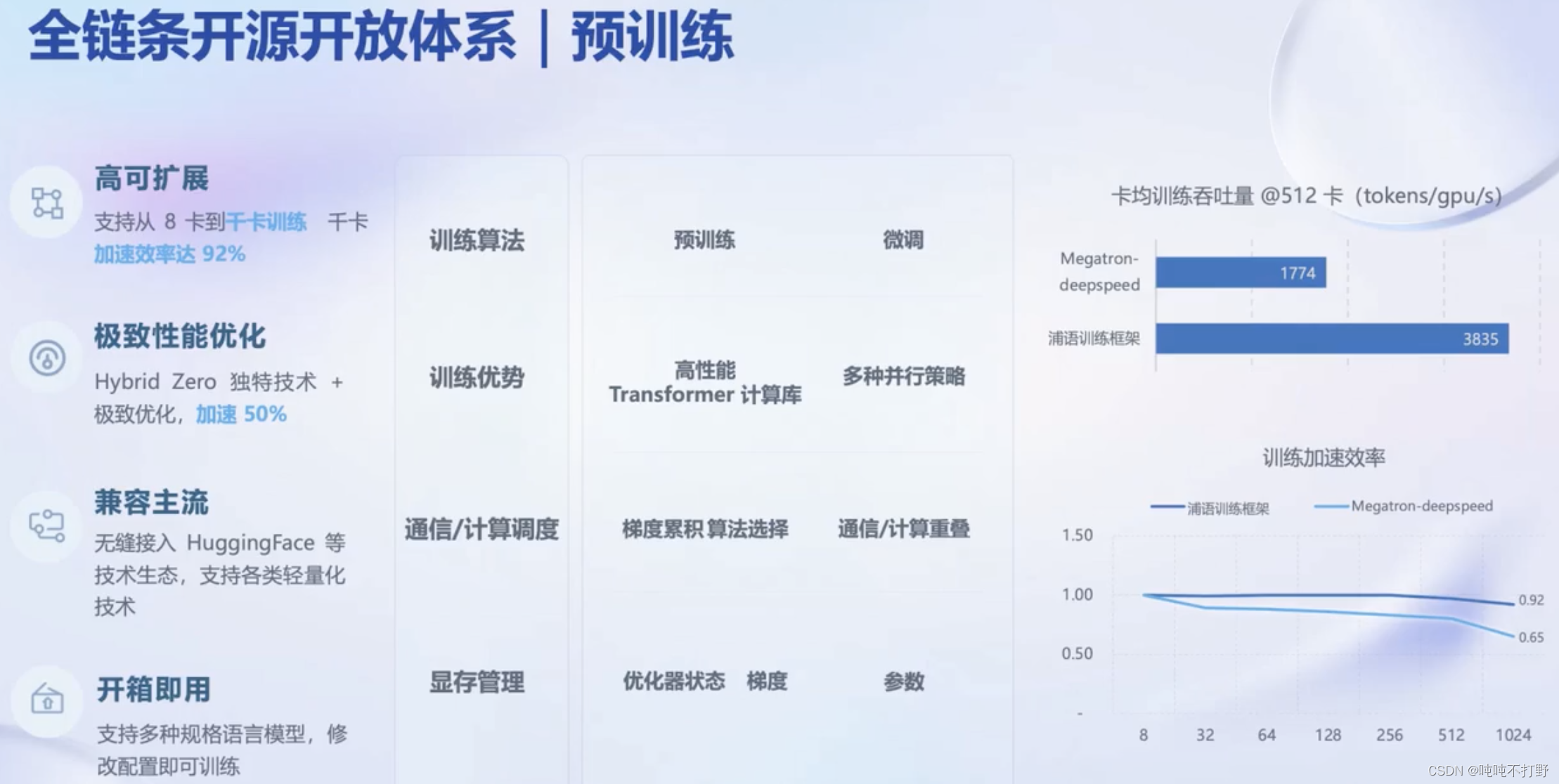

- 预训练:并行训练,极致优化,速度达到 3600 tokens/sec/gpu

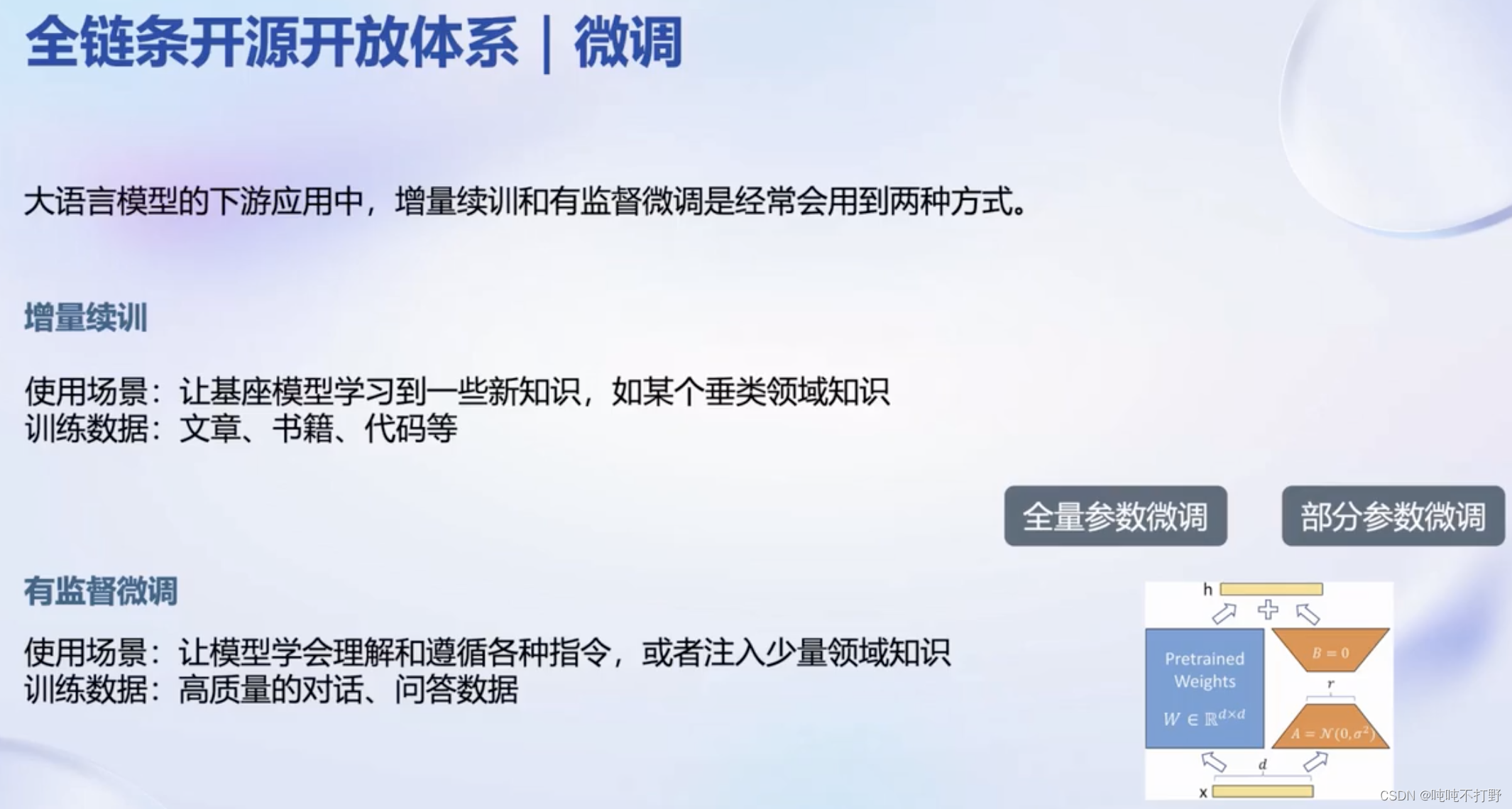

- 微调:全面的微调能力,支持SFT,RLHF和通用工具调用

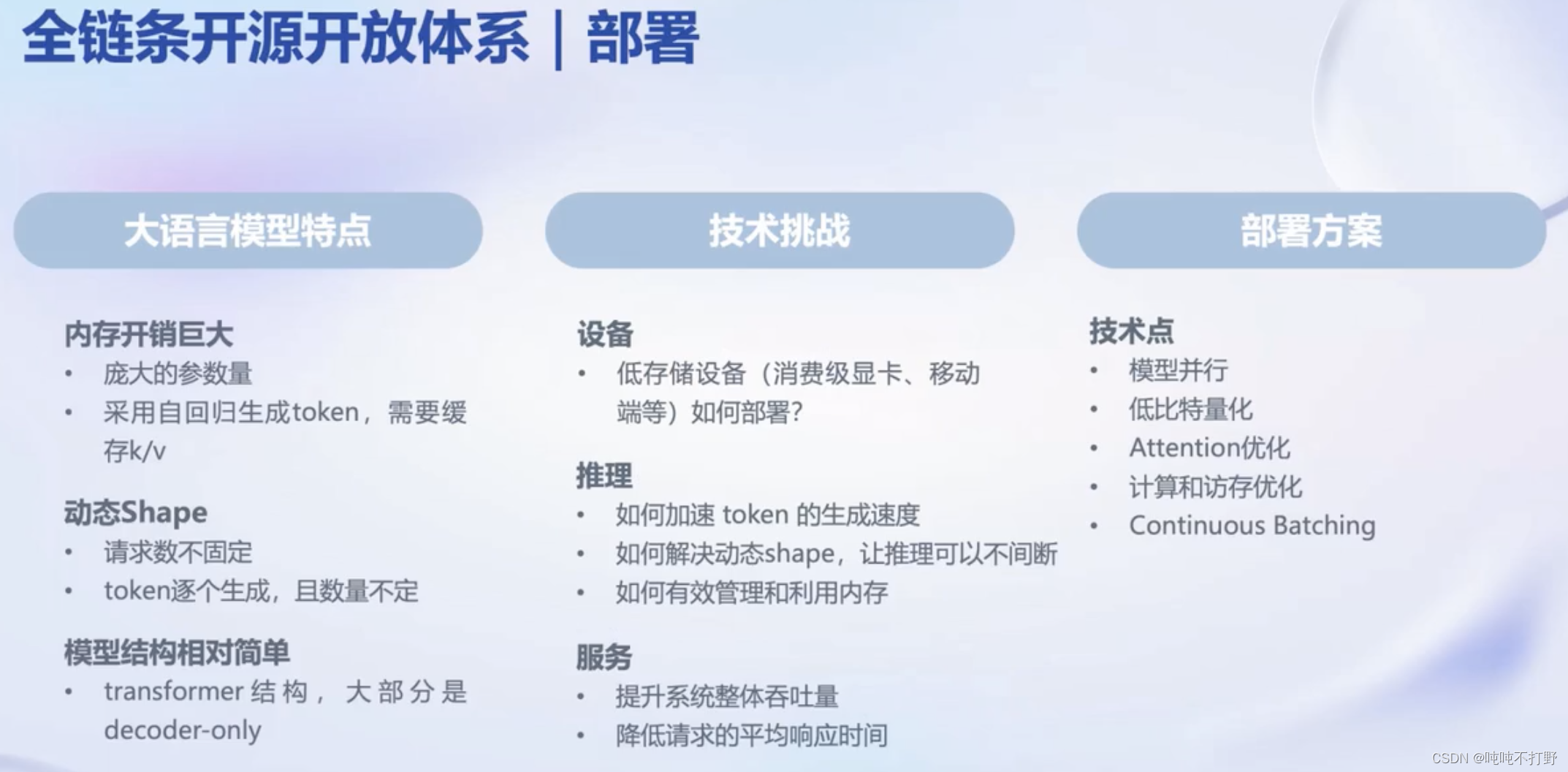

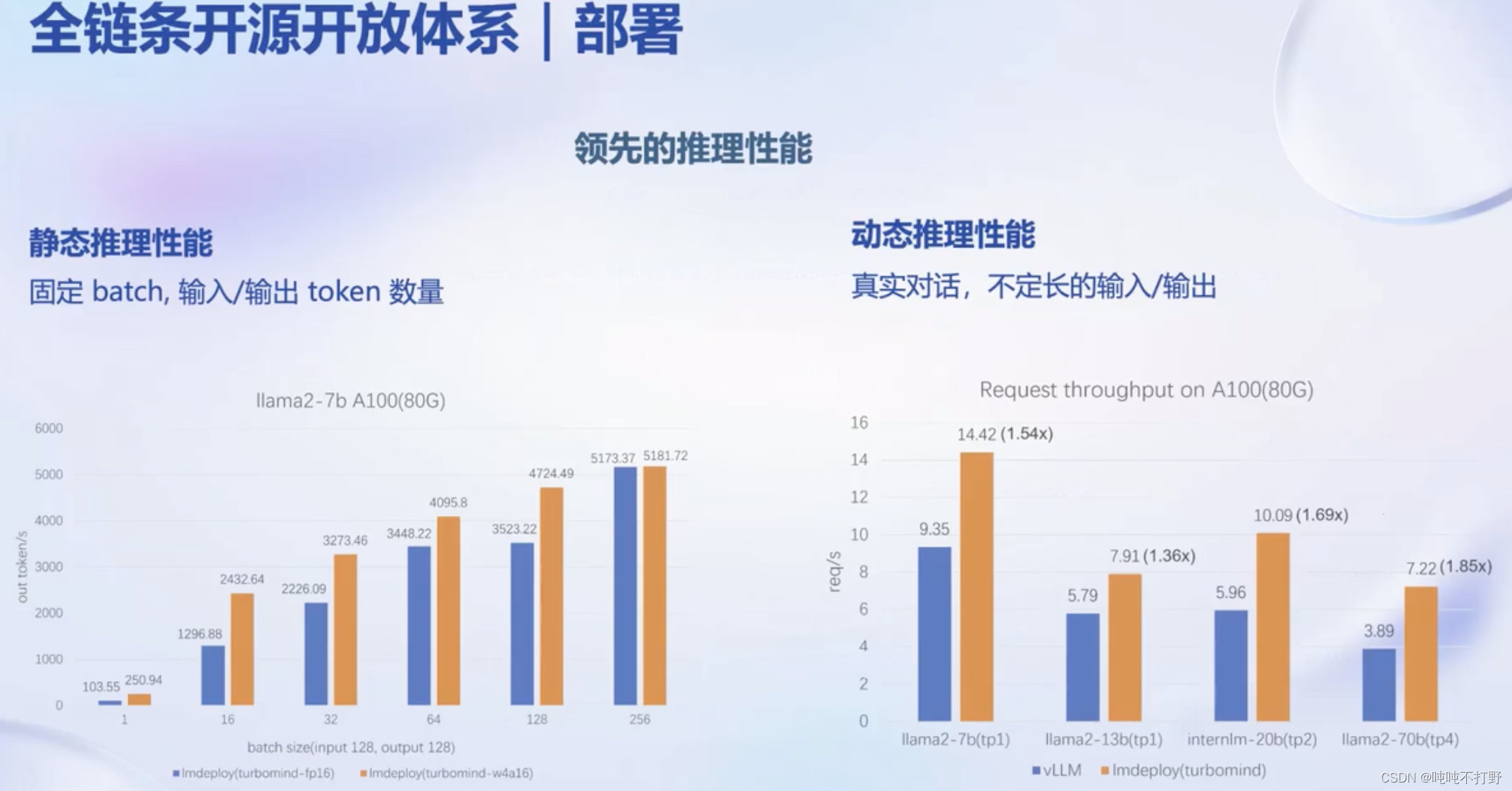

- 部署:全链路部署,性能领先,每秒生成 2000+ tokens

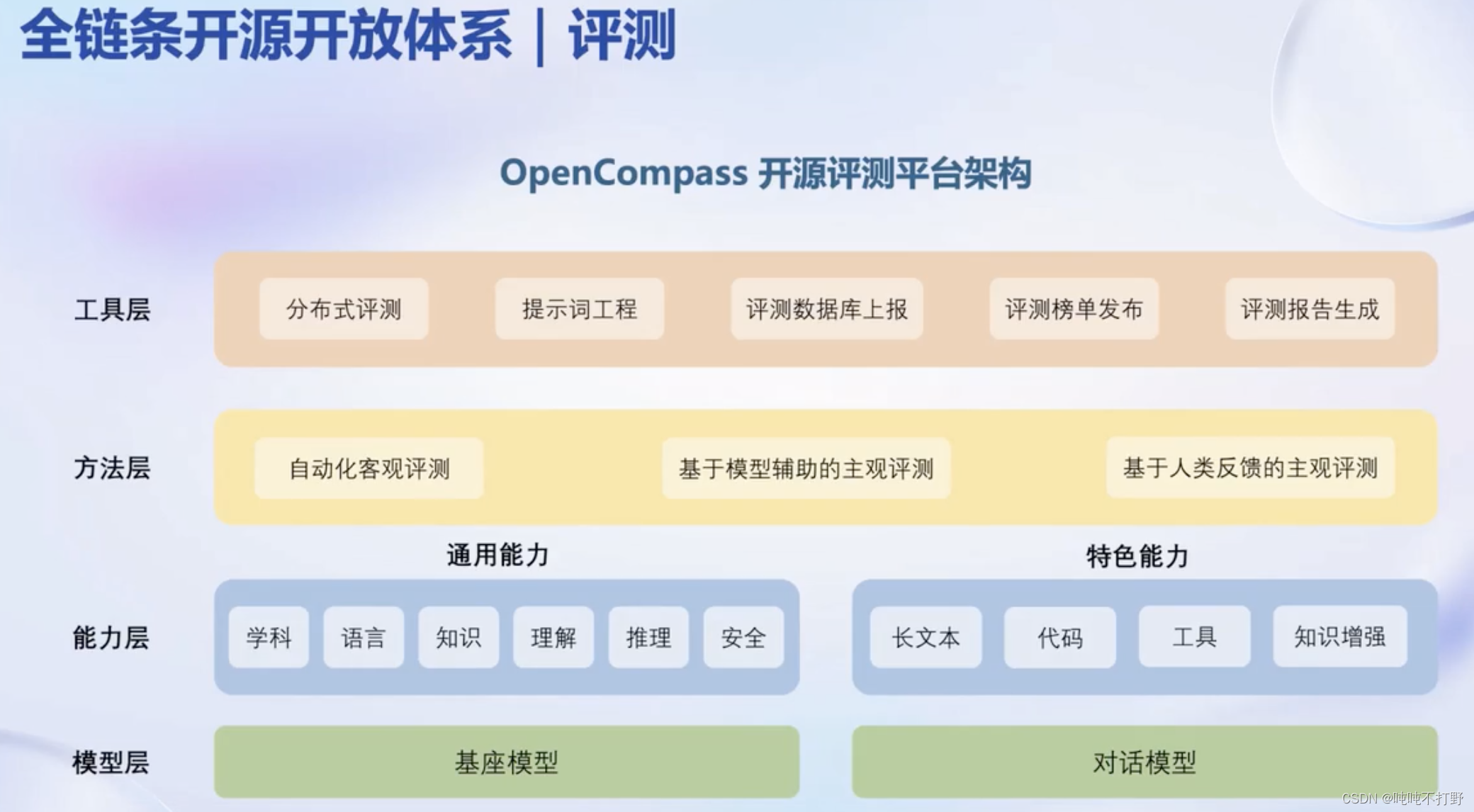

- 评测:全方位评测,性能可复现,50 套评测集,30 万道题目

2.1 数据

OpenDataLab的知乎文章:多模态语料库 “书生·万卷” 1.0 详细解读 | 附下载地址

也是来自论文的

2.2 预训练

2.3 微调

SFT(ScalableFine-Tuning) 是一种用于自然语言处理的技术,它通过对预训练的语言模型进行微调,使其适应特定任务

https://github.com/InternLM/xtuner

2.4 评测

- https://crfm.stanford.edu/helm/lite/latest/#/leaderboard

- https://github.com/stanford-crfm/helm

- https://huggingface.co/spaces/HuggingFaceH4/open_llm_leaderboard

- https://llm-leaderboard.streamlit.app/

- https://github.com/terryyz/llm-benchmark

2.5 部署

https://github.com/InternLM/lmdeploy

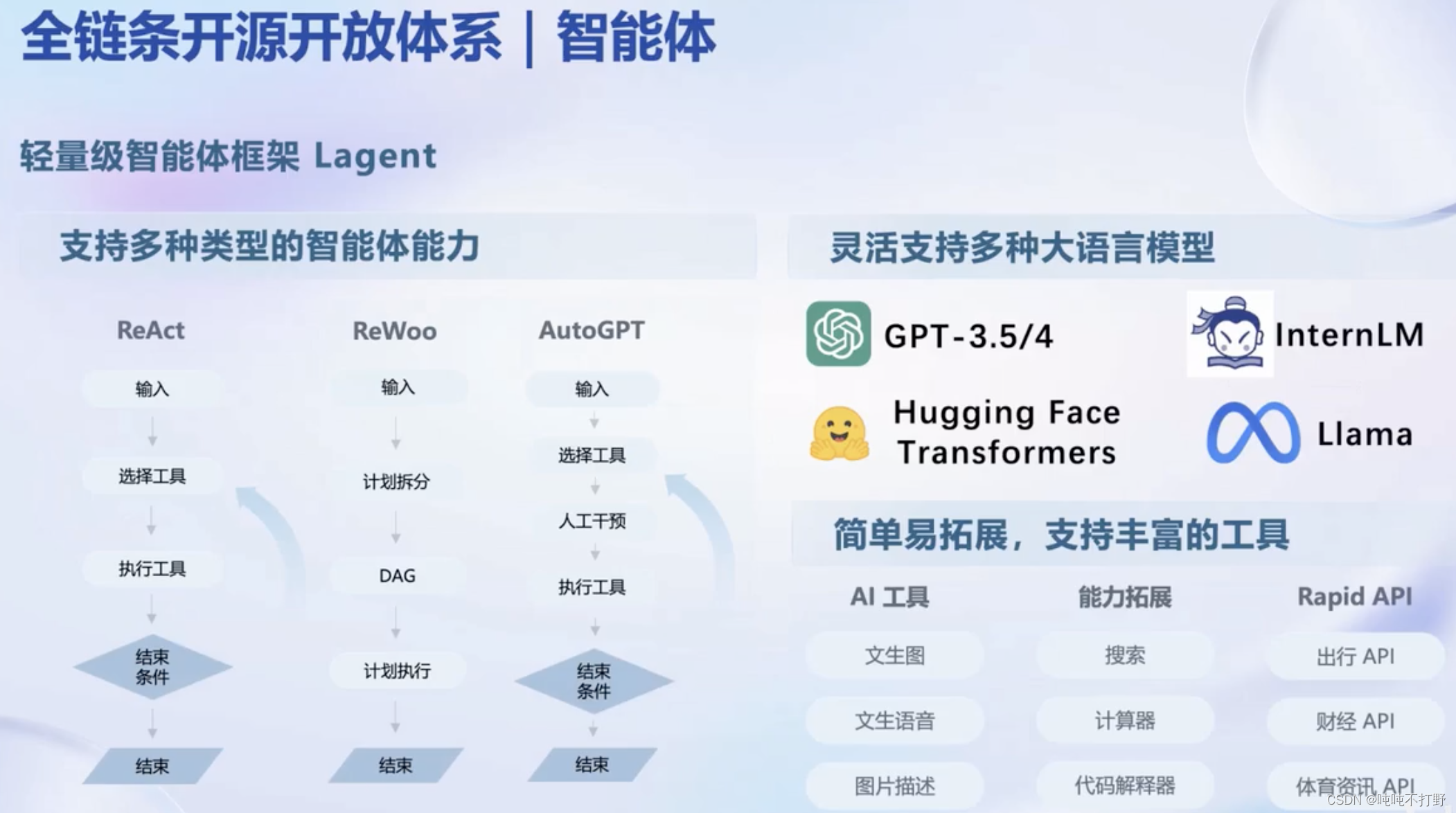

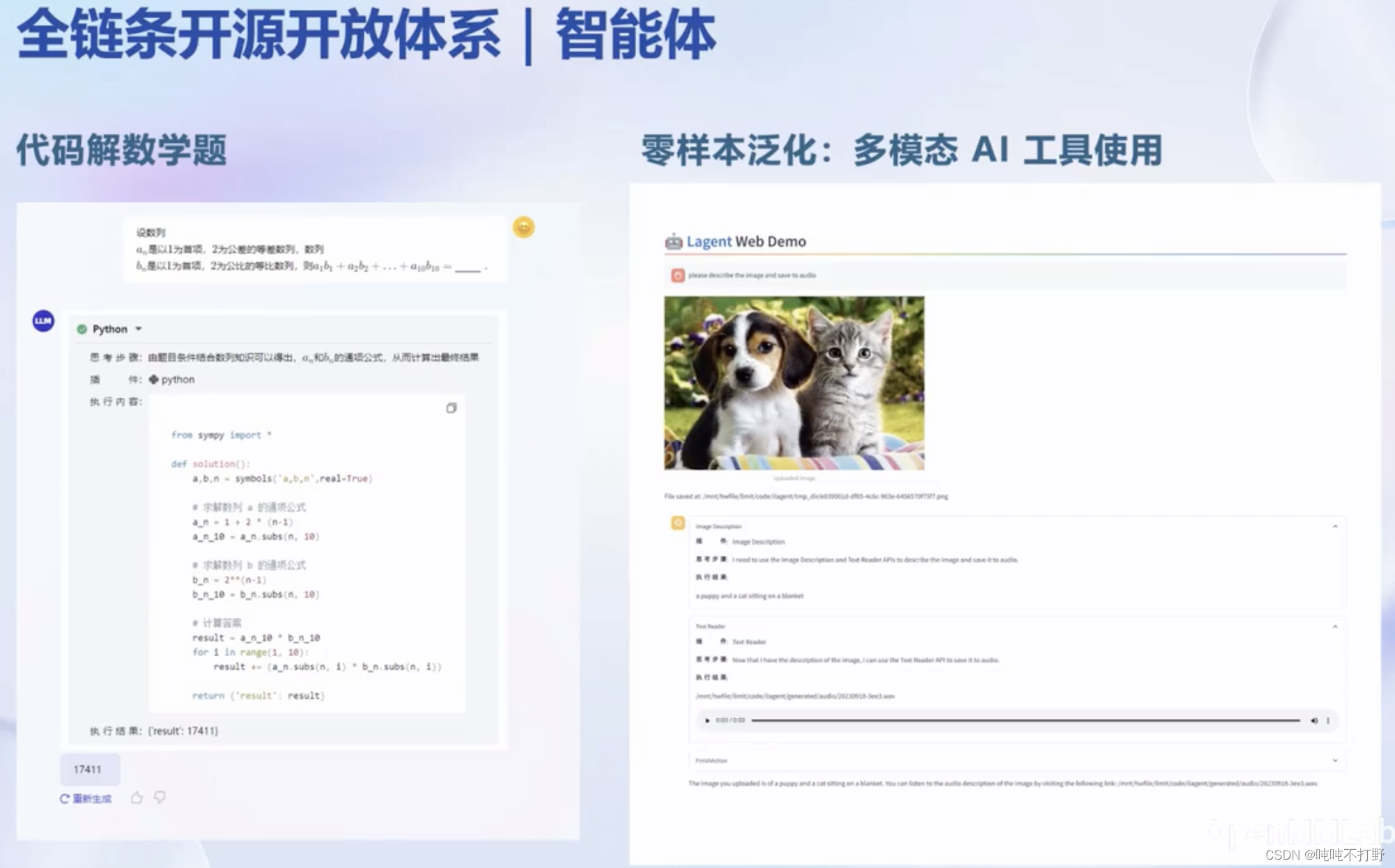

2.6 智能体(应用)

https://github.com/InternLM/lagent

文章来源:https://blog.csdn.net/Castlehe/article/details/135372922

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 系列二十九、Spring Boot打成jar包后,resources目录下的资源文件获取不到

- 关联规则分析(Apriori算法2

- 大模型的理论分析

- SSL证书:免费还是付费?

- AI:112-基于卷积神经网络的美食图片识别与菜谱推荐

- 群联高防IP:打造无懈可击的网络安全防线

- YOLOv8改进全新Inner-IoU损失函数:全网首发|2023年11月最新论文|扩展到其他SIoU、CIoU等主流损失函数,带辅助边界框的损失

- web架构师编辑器内容-数据结构设计上面的难点

- 使用克魔助手进行iOS数据抓包和HTTP抓包的方法详解

- 1241. 外卖店优先级(蓝桥杯/暴力/优化--暴力遍历 VS 根据输入遍历)