ML:2-2-2 sigmoid 函数的替代方案

发布时间:2024年01月23日

【吴恩达p62-64】

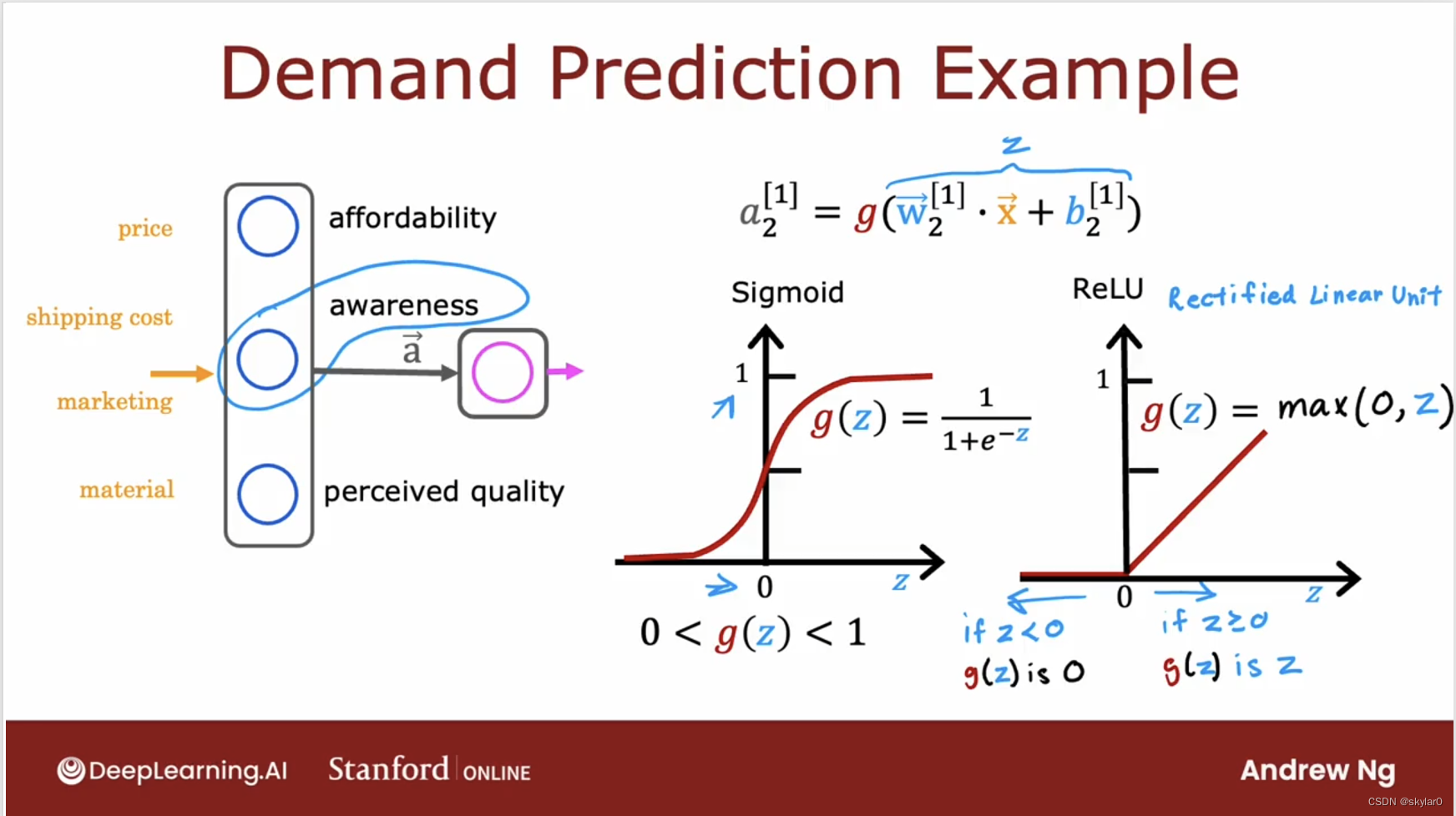

1. sigmoid function的替代方案

- 来看上周的例子,预测一个商品是否能成为消冠。

- 这里的awareness可能是binary的。人们要么知道/不知道。但事实上,可能是知道一点,完全知道…

- 因此,与其用0/1来预测(太简单了)或者0-1之间的数字,不如直接尝试预测awareness的概率。让awareness可以取到负值。

- 使用该方程,来预测awareness,会得到左侧的图像。如果想让a1_2取到大雨1的数字,在neural network里更常见的是使用右侧图像的这种activation【ReLU】,这样g(z)就可以取到所有非负数。

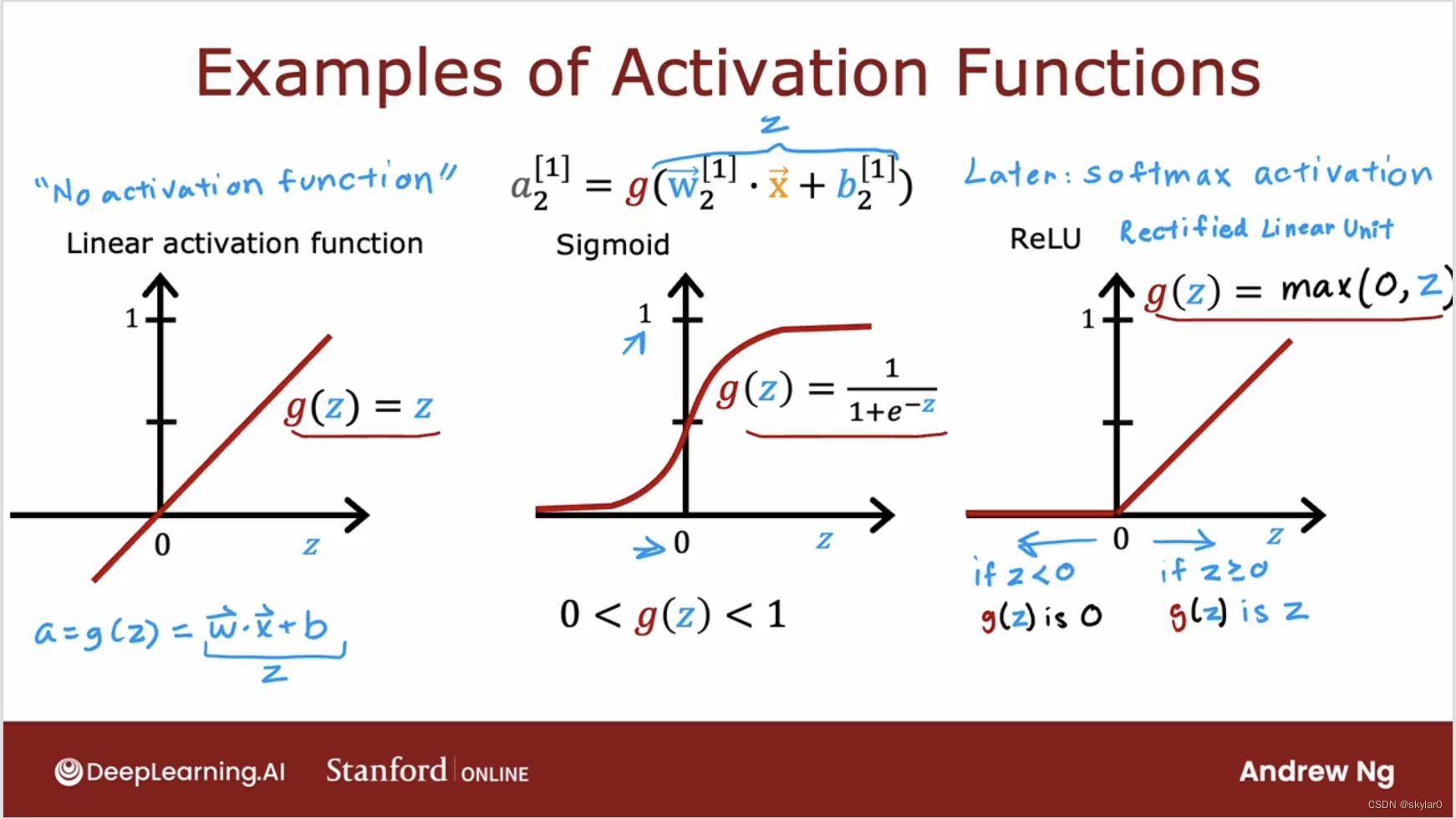

5. 一些常见的activation function:

(1) Linear activation function【也可以说没有使用任何activation function, 因为会直接让a = wx+b】

(2)sigmoid

(3)RuLU

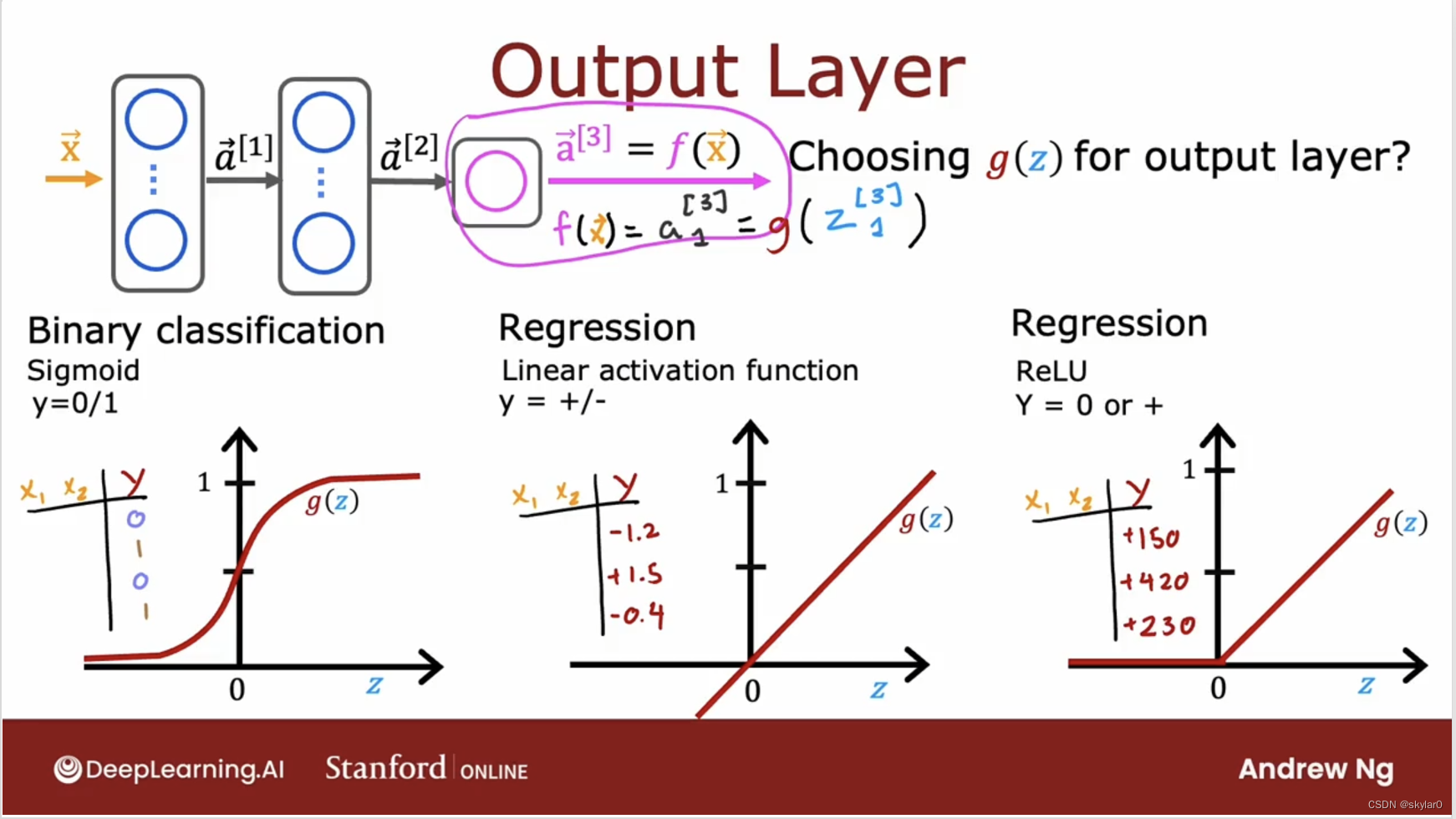

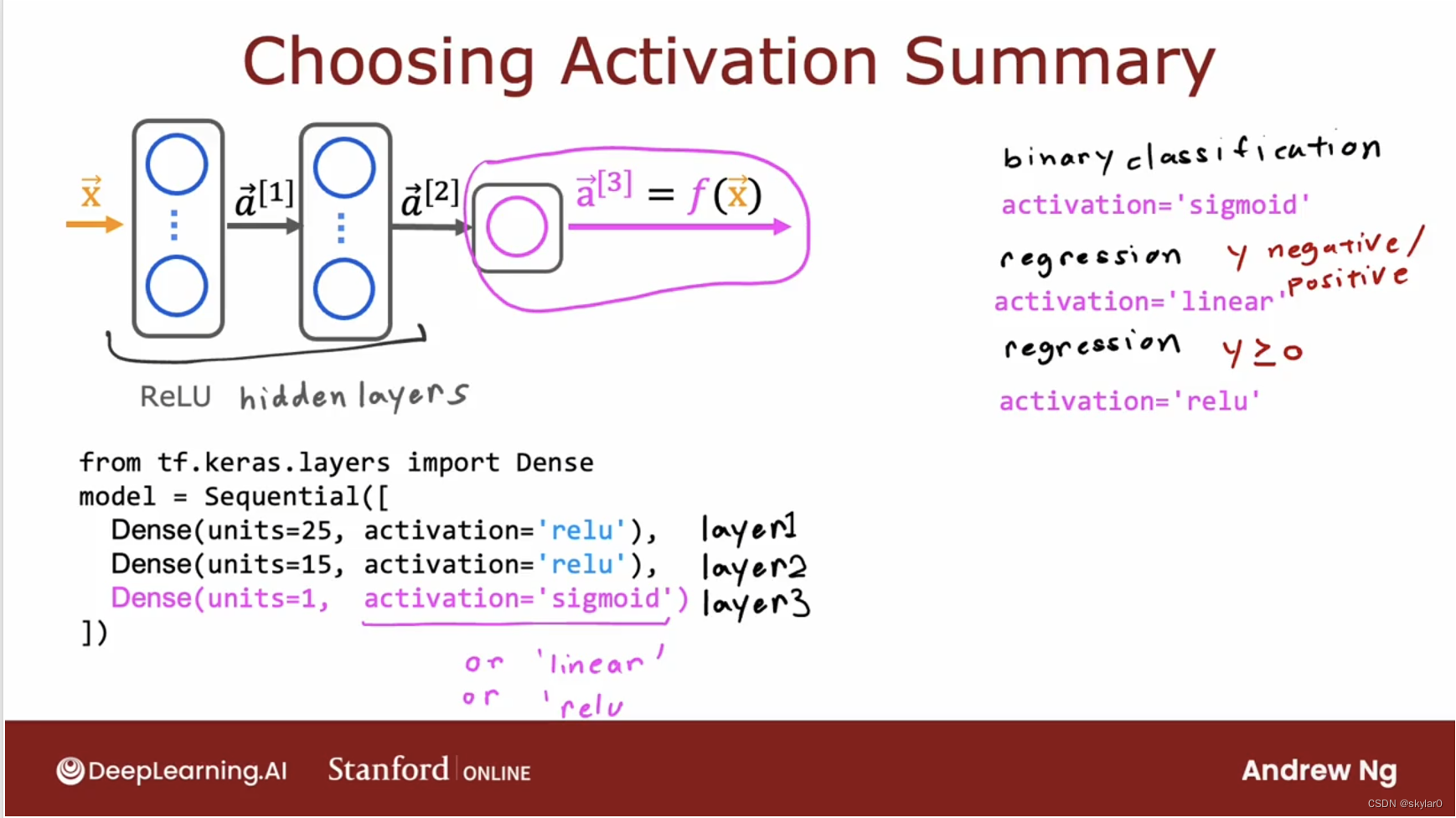

2. 如何选择activation function

- 如何选择output layer的activation function,这取决于target label / 真实值y是什么。

(1)处理classification的问题,sigmoid function通常是最自然的选择。因为让neural network去预测y=1的概率,跟我们做logistic regression一样。

(2)处理regression问题时,如果y值可正可负(预测股价变化)建议用linear activation function。因为y值可+可-。

(3)处理regression问题时,如果y值只能是非负数,那么就用ReLU。

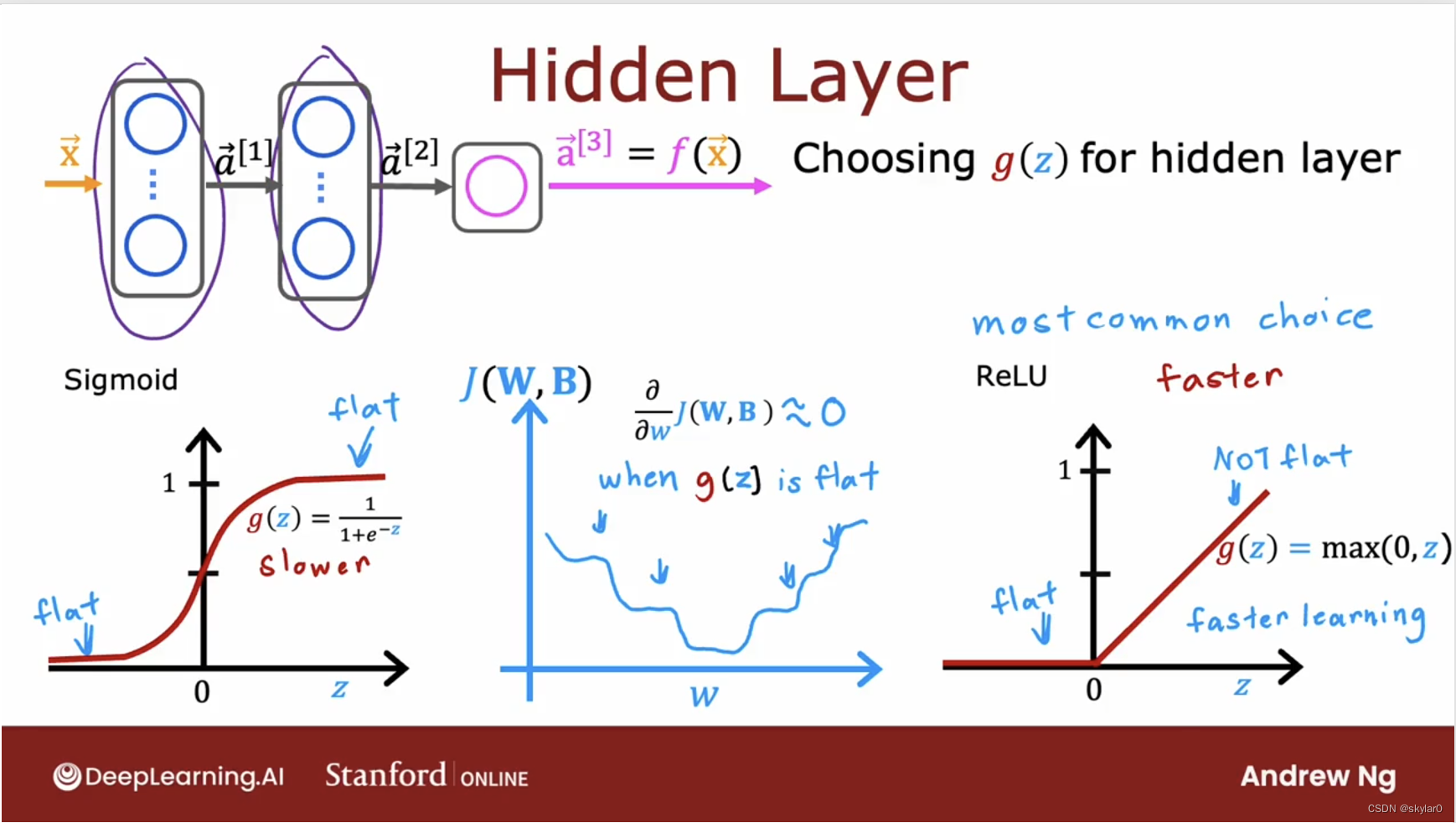

- 如何选择hidden layer的activation function:

- ReLU是neural network里最常见的一种选择。

原因一:ReLU只有一个部分是平坦的,sigmoid有2部分,flat会导致gradient descent很慢。因为flat会导致cost function的偏导约等于0.

原因二:它计算更快。

- ReLU是neural network里最常见的一种选择。

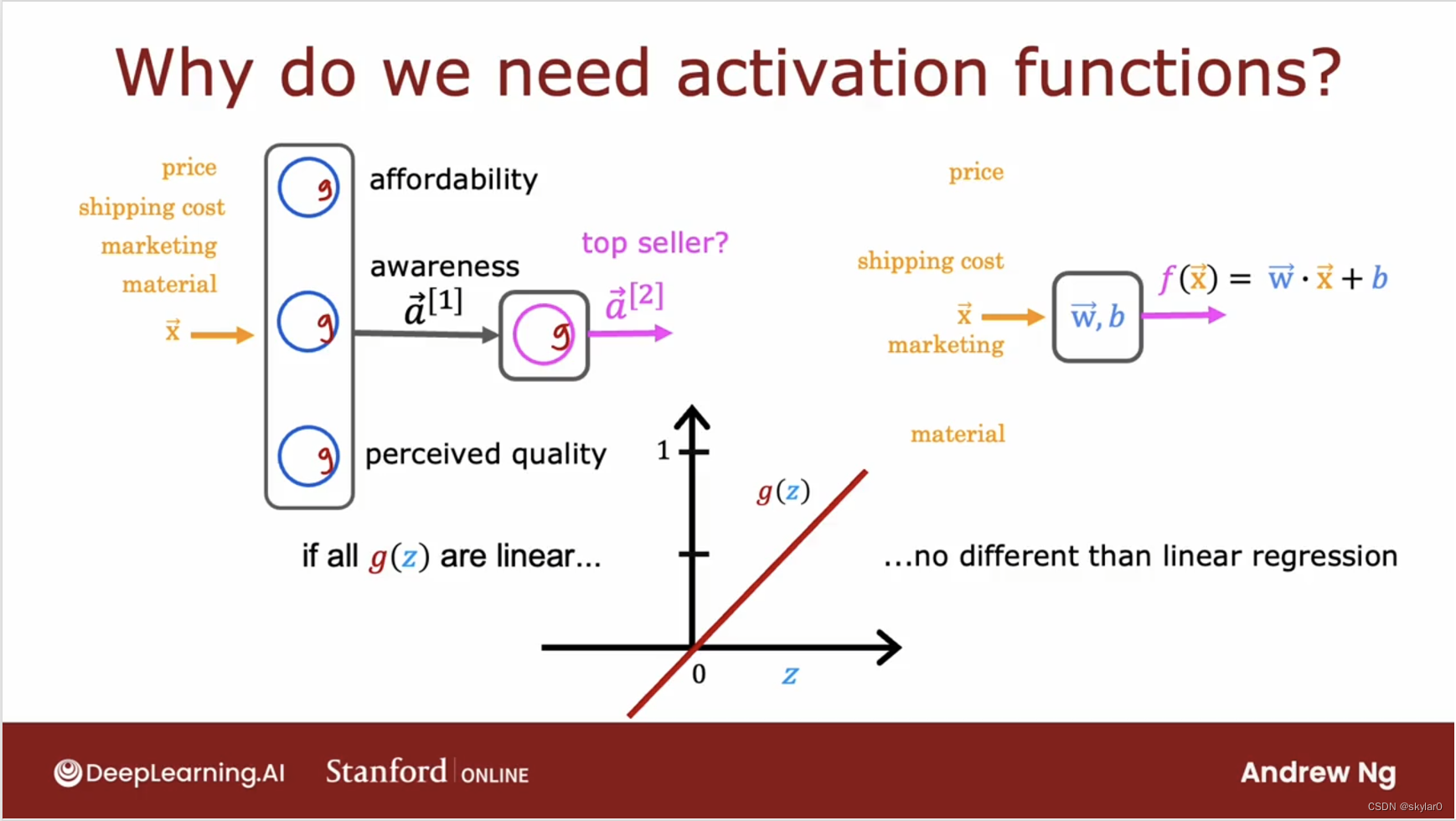

3. 为什么模型需要activation function

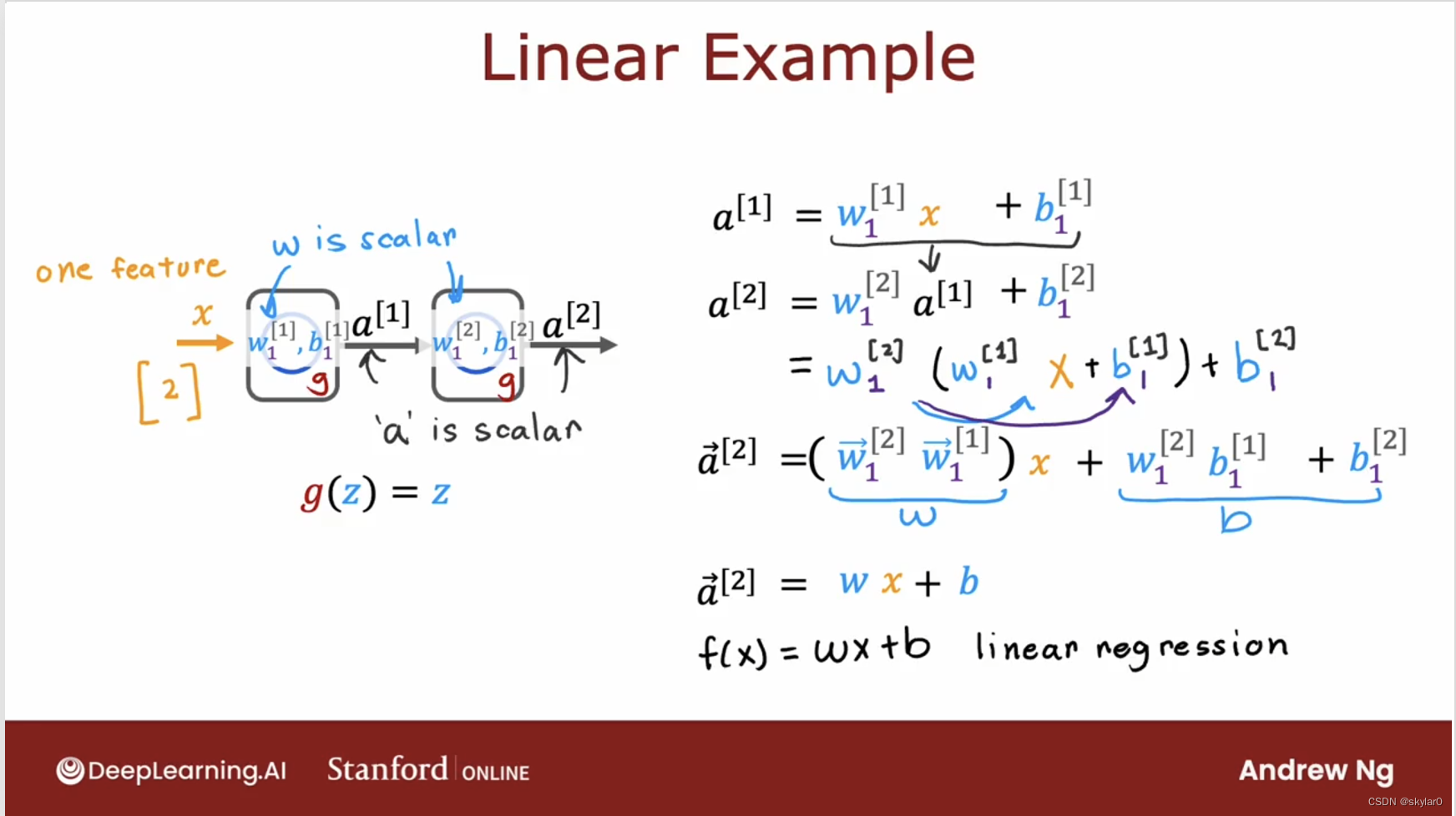

- 如果model全用linear activation function在所有的neuron会怎么样?

这个模型会完全等于linear regression。

- 这个模型会完全等于linear regression。(过程)

- 如果所有的hidden layer都用linear activation function,只有output layer用logistic activation function的话,这个模型会完全等于logistic regression。

文章来源:https://blog.csdn.net/skylar0/article/details/135661497

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【异常】SecurityException: JCE cannot authenticate the provider BC

- 文献速递:生成对抗网络医学影像中的应用——3DGAUnet:一种带有基于3D U-Net的生成器的3D生成对抗网络

- 奇偶校验的C语言实现

- 第二章 面向对象的基本概念之——类的定义

- 大模型微调学习记录-基于GLM-130B

- 创建局域网git裸仓库

- LoRa解决方案助推农业创新钡铼技术LoRa网关S281

- Mybatis 常用条件语句,大于小于、if、for、模糊搜索、case when、choose

- Python基础语法——字符串的格式化

- 如何搭建WampServer并结合cpolar内网穿透实现公网访问本地服务