假期归来必看!2023年9月份,爆款论文总结,了解最新学术进展!

以下文章来源于AINLPer?,作者ShuYini

十一假期结束了,十月基本上算是过了一半了,小伙伴们收收心准备开始学习工作吧。按照惯例,月初继续带到家盘一下上个月(九月份)的热点论文。本月论文主要分为大模型微调、大模型发布、大模型应用三个方面。

其中在大模型微调方面有:麻省理工(MIT)提出了LongLoRA微调算法、北大&微软提出的RAIN对齐方法等;在大模型发布方面有:MAmmoTH、InternLM-20B、Xwin-LM、Falcon等模型发布;在大模型应用方面有:交通管理、文档问答、情感分析、编程等。

大模型微调(LongLoRA)

牛叉!MIT 提出LongLoRA,微调LLaMA2,Token从4K扩展至100K

今年5月份,华盛顿大学提出了QLoRA,该算法在保持完整的16位微调任务性能的情况下,可以实现单卡48G GPU微调650亿参数的大模型,可谓是红极一时引爆了学术圈。

为了提高大模型对于长文本的处理,麻省理工(MIT)提出了LongLoRA微调算法,它能够在资源受限的情况下,极大的扩展预训练大模型(LLMs)的上下文长度,LongLoRA可以让LLaMA2-7B的上下文从4K扩展至100K,除此之外,它们公布了一个长文本 LongQA数据集,包含超过 3k 个长上下文问答对,可用于用于监督微调。

模型对齐(RAIN)

北大 && 微软 | 提出新方法RAIN:大模型无需微调,即可实现对齐!!?

大型语言模型(LLMs)在本文生成、代码编程等方面表现出了卓越的能力。尽管如此,此类模型输出有可能会偏离人类偏好,甚至带来潜在的风险。为了使预训练的LLMs更加安全友好,人们提出了多种对齐方法,例如 RLHF 、RLAIF、RRHF、RAFT和 DPO。然而,这些方法需要对预训练LLMs进行微调,并需要大量精心标注的数据和计算资源。

基于以上背景,作者提出了一种可回滚自动回归推理(RAIN)方法,它允许预训练LLMs评估自己的生成结果,并以此来指导模型输出,实验结果显示:RAIN显着增强了各种对齐任务的性能,大幅提高了模型输出的无害率,增强模型对抗攻击的鲁棒性。

模型高效部署(vLLM引擎)

7.3k Star!UC伯克利 | 发布vLLM引擎,高效内存管理,轻松实现大模型低成本部署!

今年六月,来自加州大学伯克利分校等机构的一个研究团队开源了 vLLM(目前已有 6700 多个 star),其使用了一种新设计的注意力算法 PagedAttention,可让服务提供商轻松、快速且低成本地发布 LLM 服务。

该团队宣称 vLLM 能实现比 HuggingFace Transformers 高 24 倍的吞吐量!现在离 vLLM 最初宣布时差不多已过去三个月,他们终于发布了这篇关于 vLLM 和 PagedAttention 的研究论文,其中详细解释了他们如何通过类似操作系统虚拟内存管理的机制来实现高效的 LLM 服务。该论文已被将于十月底在德国举办的 ACM 操作系统原理研讨会(SOSP 2023)接收。

大模型编程CodeApex

上海交大APEX发布:CodeApex,专注评估LLMs编程能力,支持中英双语,含源码!?

大语言模型 (Large Language Models) 的出现,让模型的编程能力越来越受到研究者的关注。在此态势下,上海交通大学 APEX 实验室推出了 CodeApex-- 一个专注于评估 LLMs 的编程理解和代码生成能力的双语基准数据集。

在评估大语言模型的编程理解能力上,CodeApex 设计了三种类型的选择题:概念理解、常识推理和多跳推理。此外,CodeApex 也利用算法问题和相应的测试用例来评估 LLMs 的代码生成能力。CodeApex 总共评估了 14 个大语言模型在代码任务上的能力。其中 GPT3.5-turbo 表现出最好的编程能力,在这两个任务上分别实现了大约 50% 和 56% 的精度。可以看到,大语言模型在编程任务上仍有很大的改进空间,打造能自己写代码的机器,这样的未来十分可期。

InternLM-20B

硬挑70B模型!上海AI Lab发布:InternLM-20B,将对 大模型生态 带来哪些影响?

上海人工智能实验室(上海AI实验室)与商汤科技联合香港中文大学和复旦大学正式推出书生·浦语大模型(InternLM)200亿参数版本InternLM-20B,同时也在魔搭社区(ModelScope)开源首发。

InternLM-20B模型介绍如下所示:

-

在模型结构方面,相比同等参数规模的大模型,它的模型结构层数更多,已达到60层,这样可以在有限参数的条件下,提高模型的综合能力;

-

在模型训练方面,经过了更高质量的清洗,其中包括了中文、英文、代码等并补充了高知识密度和用于强化理解和推理能力的训练数据;

-

在模型对齐方面,经过SFT 和RLHF训练,更能贴合人类价值取向;

-

在上下文长度方面,目前支持16K的语境长度。关于上下文长度,这个好像比chatglm2少一半,但是在模型效果方面,InternLM-20B在某些测试结果上面已经远远超过了GLM-130B,比如Hellaswag、MMLU等。

Xwin-LM

首超 GPT-4!700亿参数Xwin-LM发布,13B模型即可吊打ChatGPT

今年6月,AlpacaEval榜单一公布,GPT-4就以绝对领先的优势夺得第一,胜率超过95%。三个月后,一匹叫Xwin-LM的黑马,居然把稳居榜首的GPT-4从TOP 1拉下来了?

Xwin-LM是以Llama2为基础进行微调的,该模型旨在开发和开源大语言模型的对齐技术,包括监督微调(SFT)、奖励模型(RM)、拒绝采样、人类反馈强化学习(RLHF)等。

-

Xwin-LM-70B:在AlpacaEval基准测试中对Davinci-003的胜率达到95.57%,在AlpacaEval中排名第一。也是第一个在AlpacaEval上超越GPT-4的模型。此外,它对上GPT-4的胜率为60.61。

-

Xwin-LM-13B:在AlpacaEval上取得了91.76%的胜率,在所有13B模型中排名第一。

-

Xwin-LM-7B:在AlpacaEval上取得了87.82%的胜率,在所有7B机型中排名第一。

文档问答(PDFTriage)

斯坦福 | 提出PDFTriage,解决结构化文档的问题,提升「文档问答」准确率?

关于大型语言模型(LLMs)的应用落地,目前最值的关注要数文档问答了。其主要的工作思路是将文档进行文本分割存入向量数据库,当遇到问题请求的时候,依据问题检索出向量数据库相关的文章片段,通过Prompt引导大模型给出答案。然而,该方法对于纯文本文档QA效果较好,当面对PDF、网页和演示文稿等不同文档结构时却存在一定的挑战。

针对不同文档结构问题,斯坦福的研究人员提出了一种名为PDFTriage的解决方案,用于解决长篇结构化文档的QA问答。该方案使模型能够基于结构或内容检索上下文,弥合了处理结构化文档的差距,实验证明了PDFTriage增强模型在解决现有检索增强LLMs无法解决的几类问题上的有效性。

交通大模型(TrafficGPT)

北航 | TrafficGPT:一个专用于城市交通管理的大模型框架,改变交通管理模式!

随着大型语言模型的发展,大型语言模型在常识、推理和规划能力方面展现出了卓越的性能,为此人们正在尝试将其应用到各个应用场景。作者提出了TrafficGPT框架,它将ChatGPT和流量基础模型(TFM)相融合,使LLMs理解自己的行为,进而让LLMs完成一些复杂的操作并为人类提供决策建议。这种集成通过利用大型语言模型的能力来解决交通数据分析和决策带来的复杂挑战,从而彻底改变交通管理。

TrafficGPT利用多模态数据作为数据源,从而为各种交通相关任务提供全面支持。TrafficGPT的框架如下图所示。图片?如上图所示,TrafficGPT利用视频数据、探测器数据、模拟系统数据等各种交通数据。其中,交通基础模型(TFM)不与这些数据源直接交互,而是通过中间数据库管理层实现数据访问。在框架的最外层,大型语言模型 (LLM) 识别用户需求并通过TFM协调任务执行。

猛犸象大模型(数学推理)

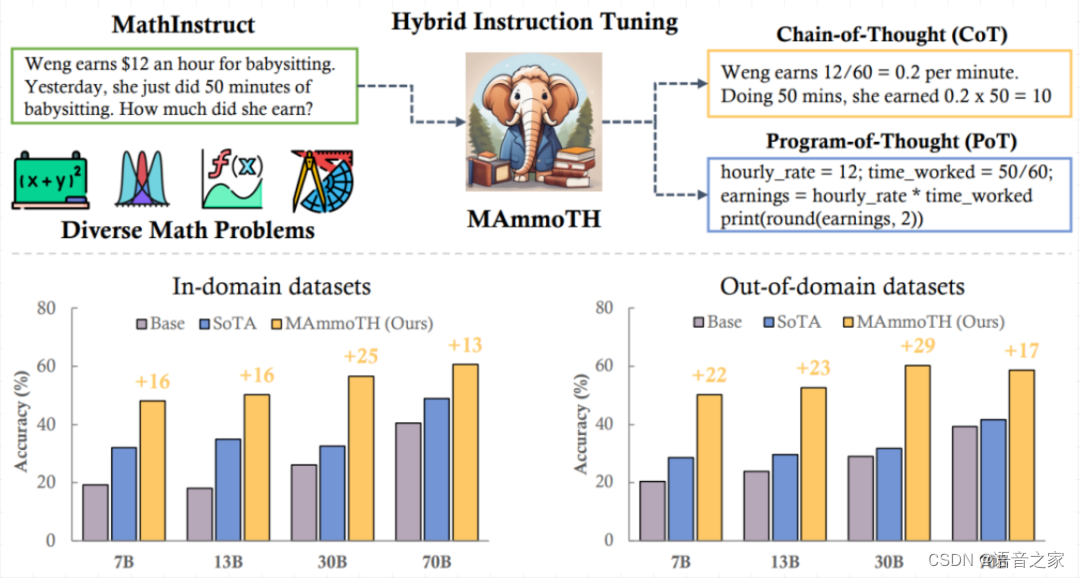

猛犸象大模型!MAmmoTH:目前最好的开源、通用数学大模型,现已超过GPT-4!

大型语言模型 (LLM)的数学推理能力是评估大模型能力的一项关键指标。尽管目前很多大型语言模型(LLMs)在该领域取得了一定的进展,但与闭源的大模型相比,开源大模型的数学推理能力仍然有很大差距。

为此,本文作者精心编制了一个指令调优数据集:MathInstruct,并将思维链(CoT)与思维编程(PoT)进行混合,训练出了MAmmoTH系列模型,实验结果显示:在9个数学推理数据集上的性能显着优于现有开源模型,平均准确率提高了13%至29%;MAmmoTH-7B模型在竞赛级数据集上比最好的开源WizardMath-7B模型高出25%;MAmmoTH-34B模型超越了GPT-4的CoT结果。

开源LLM(Falcon-180B)

世界最强!Falcon-180B,1800亿参数,比肩谷歌PaLM2,直逼GPT-4!

一夜之间,世界最强开源大模型Falcon 180B引爆全网!1800亿参数,Falcon在3.5万亿token完成训练,直接登顶Hugging Face排行榜。基准测试中,Falcon 180B在推理、编码、熟练度和知识测试各种任务中,一举击败Llama 2。甚至,Falcon 180B能够与谷歌PaLM 2不差上下,性能直逼GPT-4。

对于训练过程,Falcon 180B基于亚马逊云机器学习平台Amazon SageMaker,在多达4096个GPU上完成了对3.5万亿token的训练。总GPU计算时,大约7,000,000个。Falcon 180B的参数规模是Llama 2(70B)的2.5倍,而训练所需的计算量是Llama 2的4倍。具体训练数据中,Falcon 180B主要是RefinedWe数据集(大约占85%) 。此外,它还在对话、技术论文,以及一小部分代码等经过整理的混合数据的基础上进行了训练。

情感分析

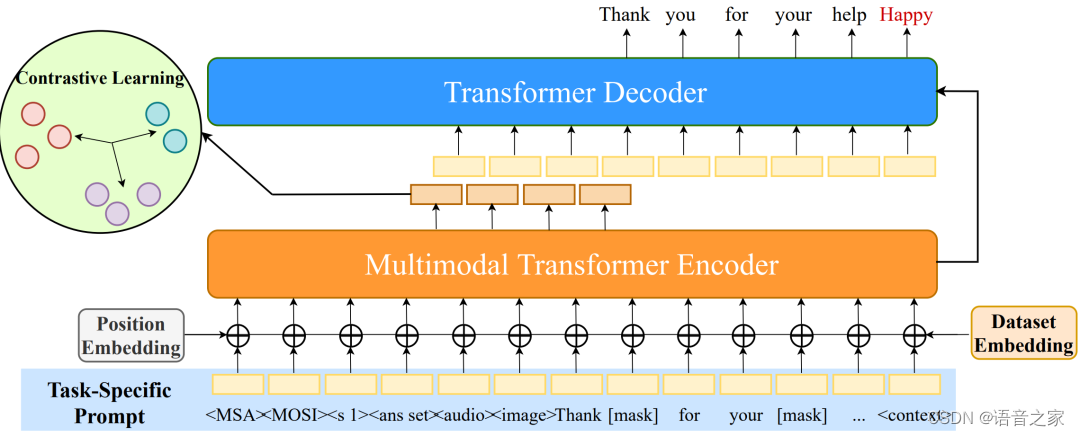

中南 | 情感分析革命:UniSA 引领多模态情感分析进入新纪元!(含源码!)

情感分析是一门利用多模态数据提取人类评论观点,理解和分类人类情感的学科。从广义上来说,情感分析包含了大量的子任务,如会话中的情感识别(ERC)、aspect-based的情感分析(ABSA)和多模态情感分析(MSA)。最初的研究主要关注单个子任务,却忽略了这些子任务之间相互关联的情感知识。

为此,本文采用生成式Transformer架构将情感分析的所有子任务统一为生成任务,提出了一种新颖的多模态情感分析框架UniSA,如上图所示。实验结果表明,UniSA在所有子任务上的表现与最先进的技术相当,并且可以很好地推广到情感分析中的各种子任务。

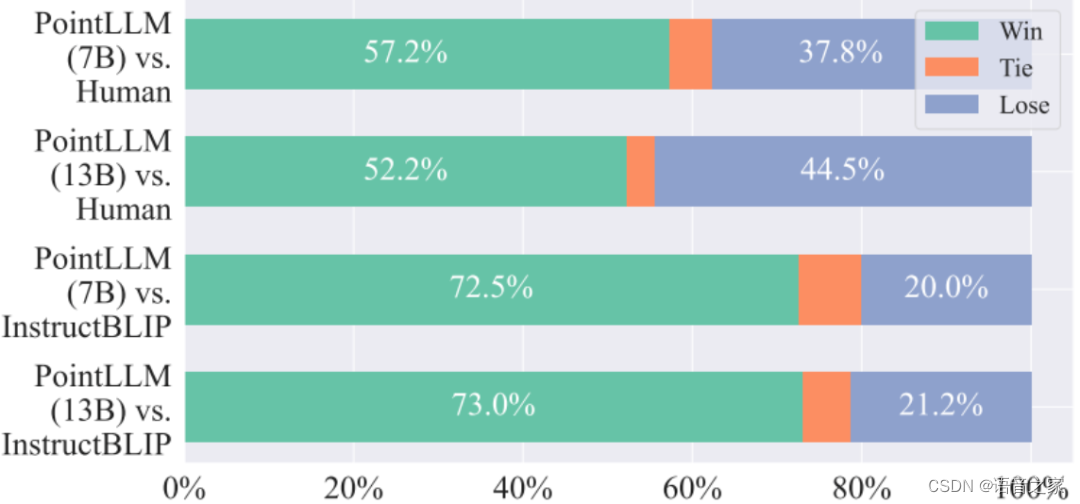

点云大模型(PointLLM)

港大 | 发布 “点云” 大模型:PointLLM,旨在实现大模型在3D对象上的应用!?

大型语言模型 (LLM) 的进步对自然语言处理产生了深远的影响,但尚未完全拥抱3D理解领域。为此本文提出了PointLLM,让LLMs学会理解点云信息并提供超越2D视觉数据的新途径。

如上图:PointLLM是一种能够理解物体的彩色点云的多模态大语言模型。它能够感知对象类型、几何结构和外观,而无需考虑模糊的深度、遮挡或视点依赖性。通过这种理解和现有的先验知识,PointLLM 可以准确地响应用户指令,正如它在这些看不见的样本上的表现所证明的那样。

实验结果表明:PointLLM 表现出优于现有2D基线的性能,在对象标注任务中,PointLLM 在超过一半的测试样本中优于人类标注,并且相比InstructBLIP模型表现出巨大的优势。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 代码随想录算法训练营第六天|哈希表理论基础,242.有效的字母异位词,349. 两个数组的交集,202. 快乐数,1. 两数之和

- Mysql5.7安装配置详细图文教程(msi版本)

- HTTP分数排行榜

- 【算法】【动规】 最长等差数列

- Dubbo3技术一套通之FST序列化

- Linux中的numactl命令使用详解

- Ubuntu20.04-剪贴板

- Differential

- Redis分布式锁存在的问题以及解决方式

- SpringSecurity Web 权限方案