VAFL---A Novel Optimized Asynchronous Federated Learning Framework

文章目录

面临的问题:网络或计算资源的差异–> 客户不会同时更新梯度,这可能需要更多的时间等待

- 如何在模型性能和通信成本之间找到平衡点是AFL中的一个挑战。

解决方案:提出了一种新颖的 AFL 框架 VAFL。VAFL可以减少约51.02%的通信次数,平均通信压缩率为48.23%,并且使模型收敛速度更快。

Introduction

联邦学习的提出:机器学习和人工智能需要输入大量数据才能获得性能良好的模型,这满足了每个设备中存储的数据的需求。例如,智慧城市[1]、医疗[2]、信用评估[3]。但是,这些数据很敏感。同时,数据之间的关系往往是孤立的、碎片化的。这限制了其处理数据的应用。联邦学习是一种保护隐私的分布式机器学习技术。数据持有者只需要提供一个使用本地数据训练的本地模型和中央节点交互

传统的联邦学习在灵活性和可扩展性有很大的挑战:

- 异构设备:由于训练数据存储在客户端,异构设备客户端过去数据大小、算力、网络等不同,且受通信条件不稳定的影响,会影响传统同步联邦学习的效率。由于用户流失的存在。例如,当少数客户端由于网络问题而断开连接时,其他客户端和服务器必须等待它们,导致联邦学习过程缓慢并花费大量时间空闲。

- 异构数据:由于联邦学习数据仅存储在本地,实际应用中数据之间这种分布的不一致会导致模型性能的显着下降,例如特征分布倾斜、标签分布倾斜、数量倾斜

- 联邦学习虽然在传输中不涉及客户端原始数据,但仍然存在相当大的安全风险。例如,攻击者可以使用 GAN 来学习梯度中的潜在信息

异步联邦学习主要解决在任意异构客户端(异构数据分布、计算资源、网络条件等)存在的情况下,中央服务器参数如何聚合的问题。

本文的方法:提出了一种新的异步联邦学习优化算法(VAFL,可以减少通信成本和空闲时间)解决前俩个挑战

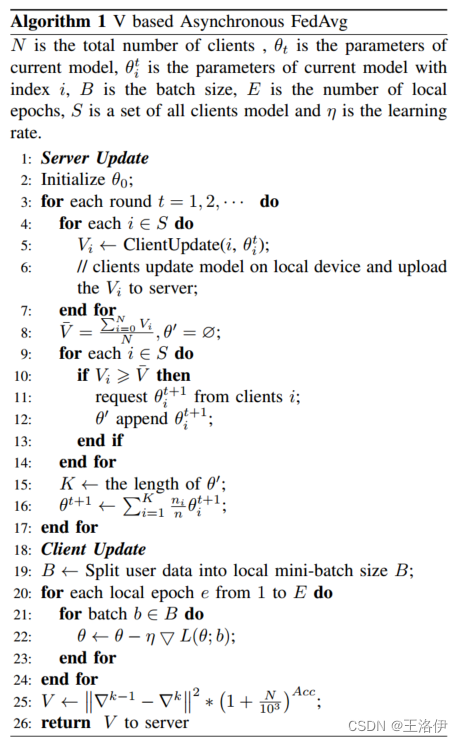

- 我们考虑了参与客户端的数量,并通过检查过时情况提供了一种改进的判断客户端的方法,引入了评估客户端通信价值的功能,从而不再进行随机选择。通过选择优质客户,提高全局模型精度。

- 我们在数据集上进行了IID和Non-IID的划分,旨在应对实际的联邦学习场景,并探索在Non-IID环境中的应用

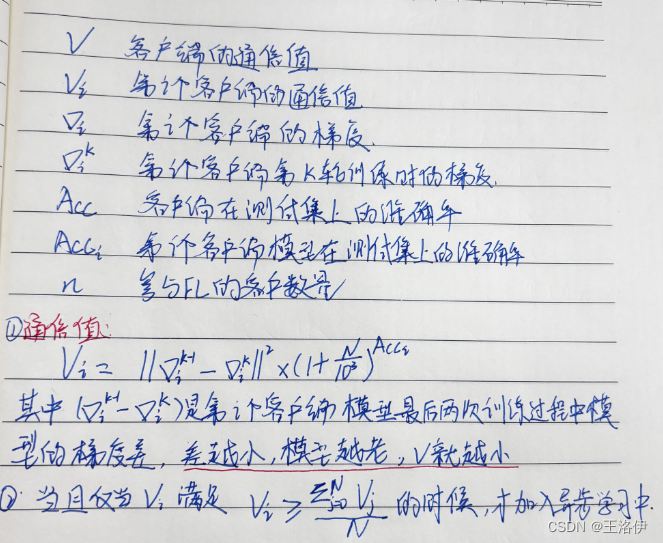

本文针对联邦学习训练中通信成本过高以及客户滞后的问题,提出一种基于梯度、客户数量和模型准确率的通信值计算的优化联邦学习异步算法(VAFL)。与Chai[18]的方法不同,我们使用客户端的梯度变化、测试集上的准确率以及客户端的数量来评估客户端的通信价值,

方法

实验

使用五台 Raspberry Pi 设备和两台笔记本电脑构建了边缘计算联邦学习的实验系统,还有一个中央设备。所有设备均连接至同一局域网。

我们使用PySyft提供的客户端类和服务器类通过WebSocket进行连接,以方便构建我们的联邦学习系统。

我们在每个客户端上运行我们的客户端程序(总共五台树莓派设备和一台笔记本电脑,彼此无法获知对方的存在,保证了客户端之间一定程度的安全和隐私)。每个客户端都连接到服务器,服务器只能获知每个客户端的型号和客户端总数。服务器使用VAFL更新模型,然后将算法得到的模型返回给客户端,客户端使用该模型进行预测。

我们使用 MNIST 构建了分发给每个客户端的 IID 和 Non-IID 数据,并分别进行了实验。对于 IID 情况,训练集平均分配给所有客户端,每个客户端包含带有 10 个标签的样本。对于非独立同分布数据集分布,训练集在标签和具有不同标签的样本数量方面有所不同。有些客户端包含所有标签,每个标签下有大量样本,有些客户端只包含少量标签,每个标签下有一些样本

实验使用准确率和通信压缩率

通信压缩率反映了客户端与服务器之间的通信被压缩的程度,压缩率越大,压缩程度越高。虽然过度的压缩率可以减少通信损耗并节省时间,但通常会伴随着模型 Acc 的下降。

思考:通信值得计算是否有问题?客户端通信值的计算频繁吗?

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 力扣周赛第二题,下午更新后两道

- TCP socket VS domain socket

- 《GreenPlum系列》GreenPlum初级教程-06GreenPlum函数

- 云轴科技ZStack 助力广西某地级市建设市级警务云视频系统

- 【分享】MathWorks中国汽车年会:“软件定义汽车”

- 【Linux】vim配置

- el-form 回车刷新的问题

- 广州找工作哪个网站好

- AI副业拆解:文字生成图文绘本,赋予你的故事生命,Story Agent智能绘本创作神器震撼登场!

- C++大学教程(第九版)5.14计算总销售量