【KD】知识蒸馏(knowledge distillation)简单介绍

发布时间:2024年01月06日

最近学到了知识蒸馏的相关知识,来简单总结一下?? ?? ? ????。

?知识蒸馏?

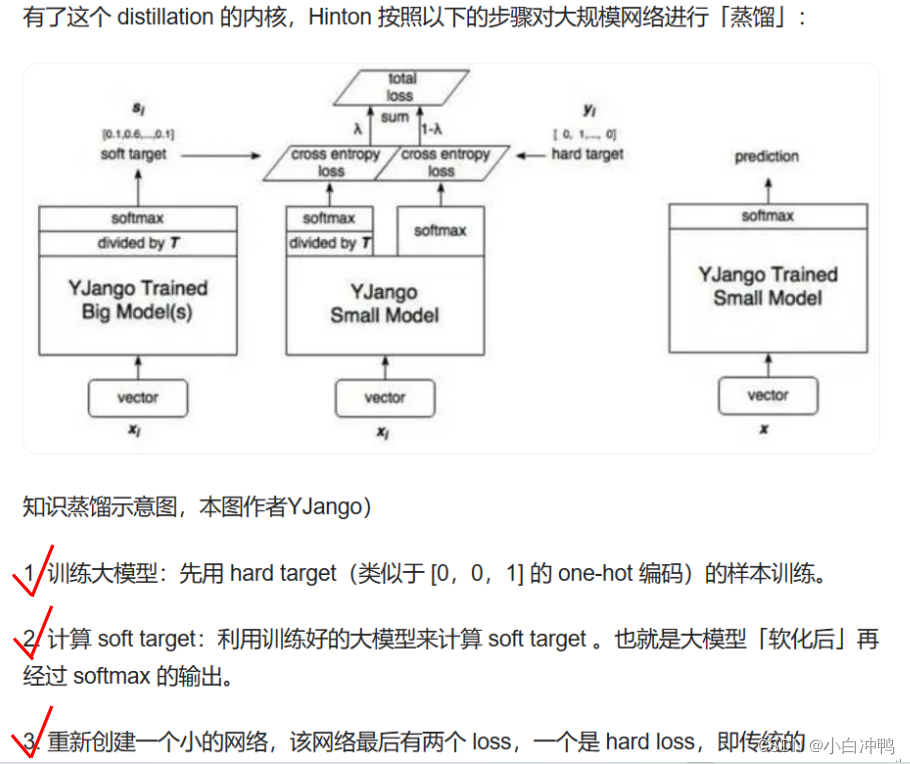

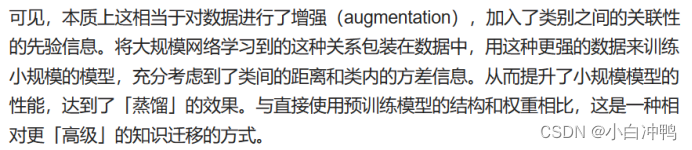

?????? 知识蒸馏,是一种模型压缩的手段。通过训练学生模仿教师的行为,将嵌入在大的教师模型中的知识迁移到小的学生模型。

例如,TinyBERT(Jiao et al.,2020)通过在通用领域的大规模语料库上执行通用的蒸馏,首次得到了一个通用的蒸馏小模型,然后在微调阶段用下游任务数据执行面向特定任务的蒸馏。DynaBERT通过从全量模型到小规模的子模型的知识蒸馏,训练了一个宽度自适应和深度自适应的BERT模型。

????????知识蒸馏也可以用于剪枝,以提高性能,例如块剪枝(Lagunas et al,2021)和CoFi(Xia et al,2022)。

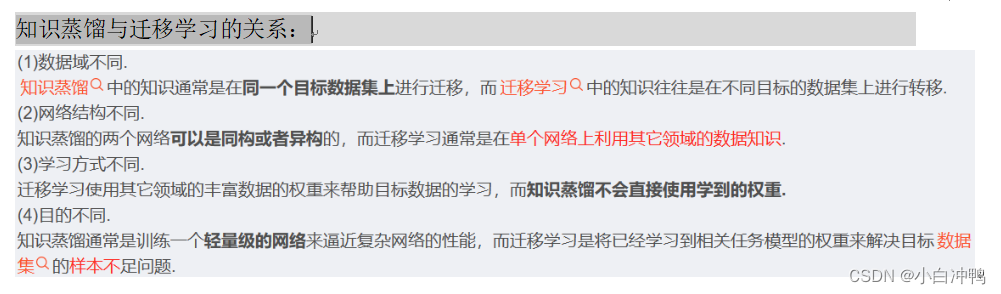

知识蒸馏与迁移学习的关系

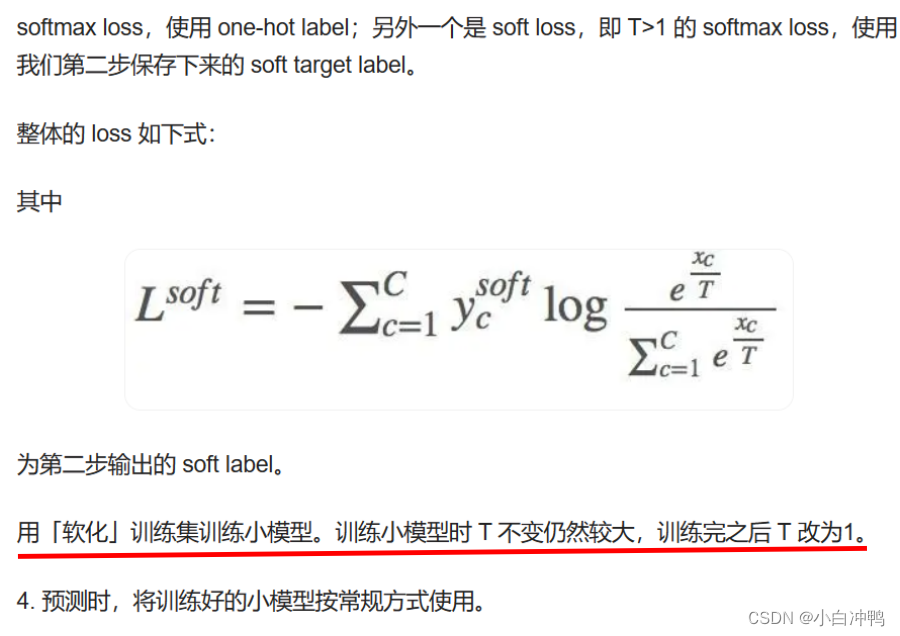

知识蒸馏中的温度设置

文章来源:https://blog.csdn.net/m0_56367027/article/details/135428246

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 《论文阅读:Backdoor Attacks Against Dataset Distillation》

- dell服务器内存架构

- Flink处理函数(2)—— 按键分区处理函数

- 【大数据面试知识点】Spark的DAGScheduler

- Springboot+mysql租房管理平台-计算机毕业设计源码54739

- 在Vue3中实现发送网络请求功能

- 什么是 Dubbo?它有哪些核心功能?

- ECMAScript简介及特性

- [GKCTF 2021]easynode

- 【2024系统架构设计】 系统架构设计师第二版-安全架构设计理论与实践