docker间通讯

发布时间:2024年01月15日

注意事项

- 不是科班出身,具体里面什么意思不知道,一步一步爬坑爬出来了

- 通过kafka实现docker之间的通讯,主要是实现numpy的传递

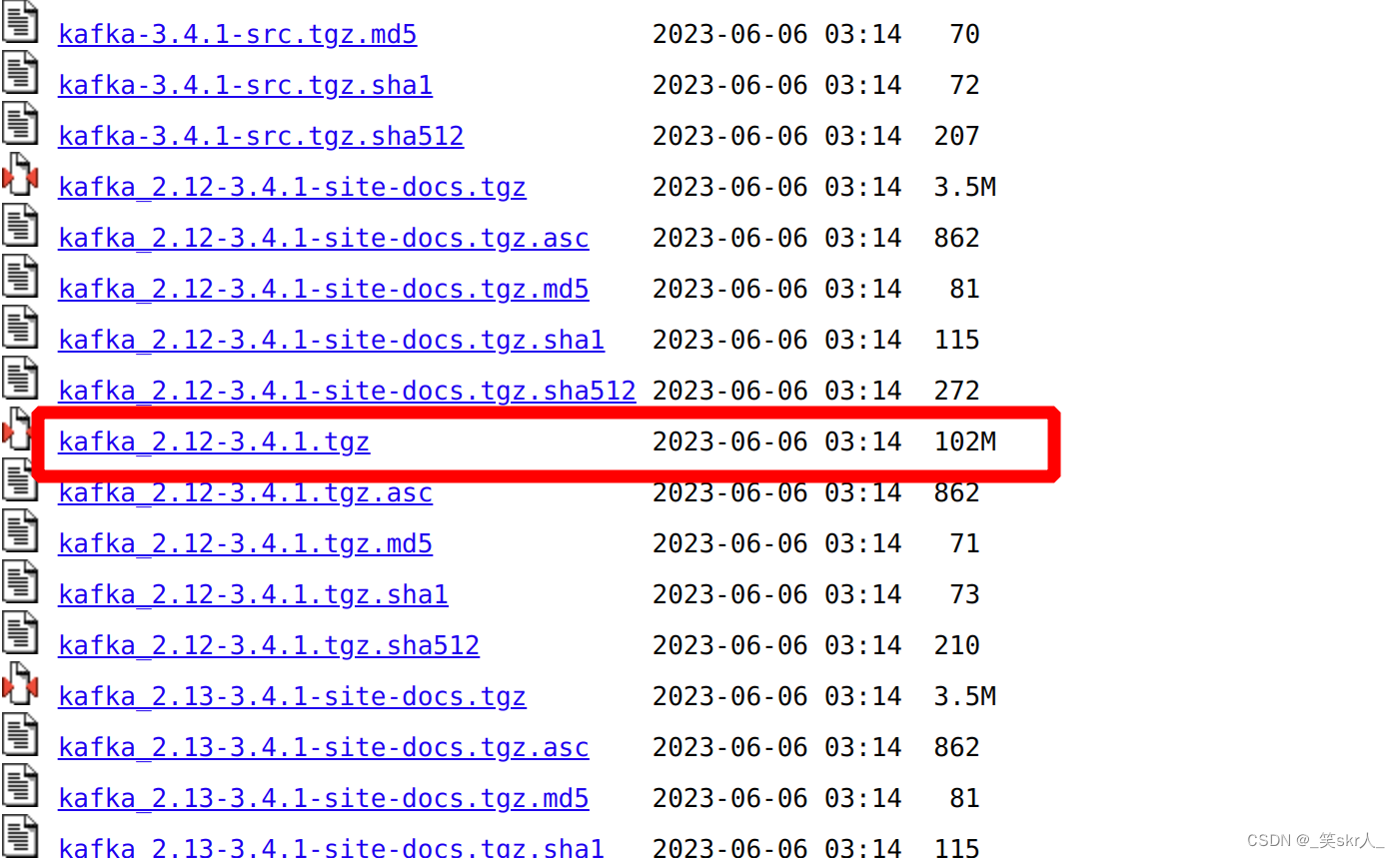

安装过程

tar -zxvf 文件名

cd kafka_2.12-3.14/

gedit config/zookeeper.properties

dataDir=~/workspace/redux/kafka/zoodata #zoodata 自己创建

admin.serverPort=8088

#启动 zookeeper

bin/zookeeper-server-start.sh -daemon config/zookeeper.properties

#查看状态,者需要java jdk,没有则安装前一张取安装

jps

#启动kafka

bin/kafka-server-start.sh config/server.properties

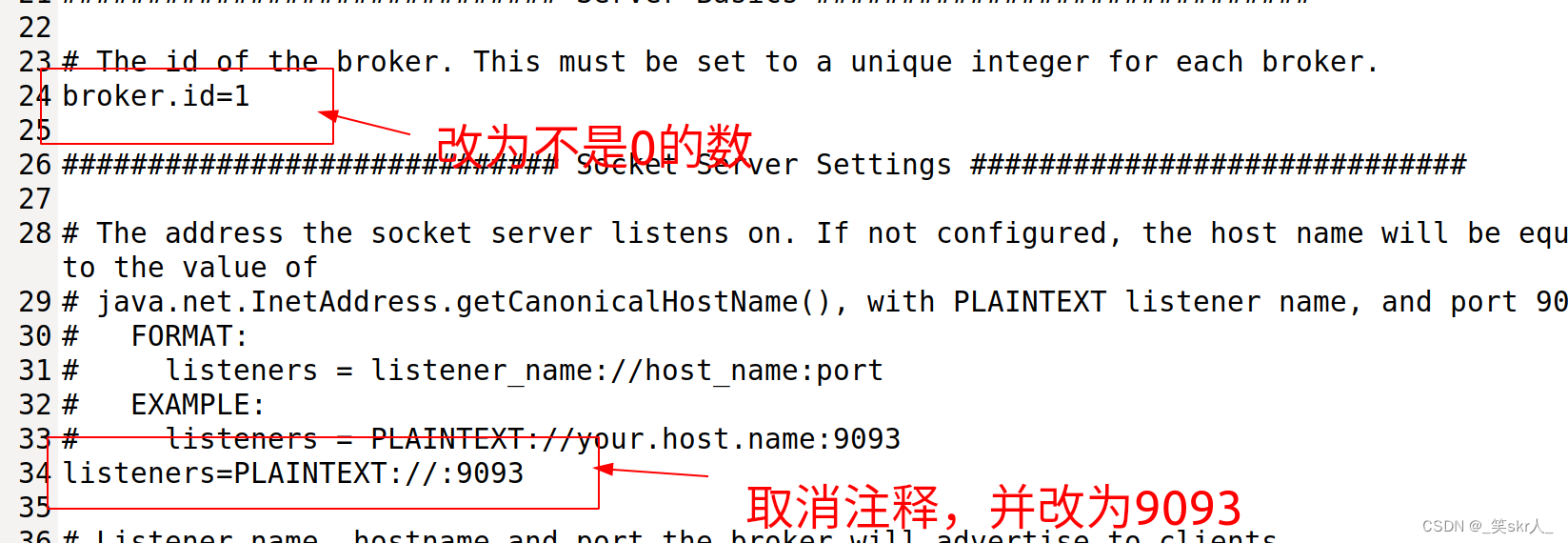

- 两个容器均这么安装,然后其中一个容器彻底不用管,只需要更改另一个容器的参数, 两个 docker 的端口是不一样的,要不然只能执行一个 docker,另一个 docker 的 kafka 启动不了

gedit config/server.properties

pip install kafka-python

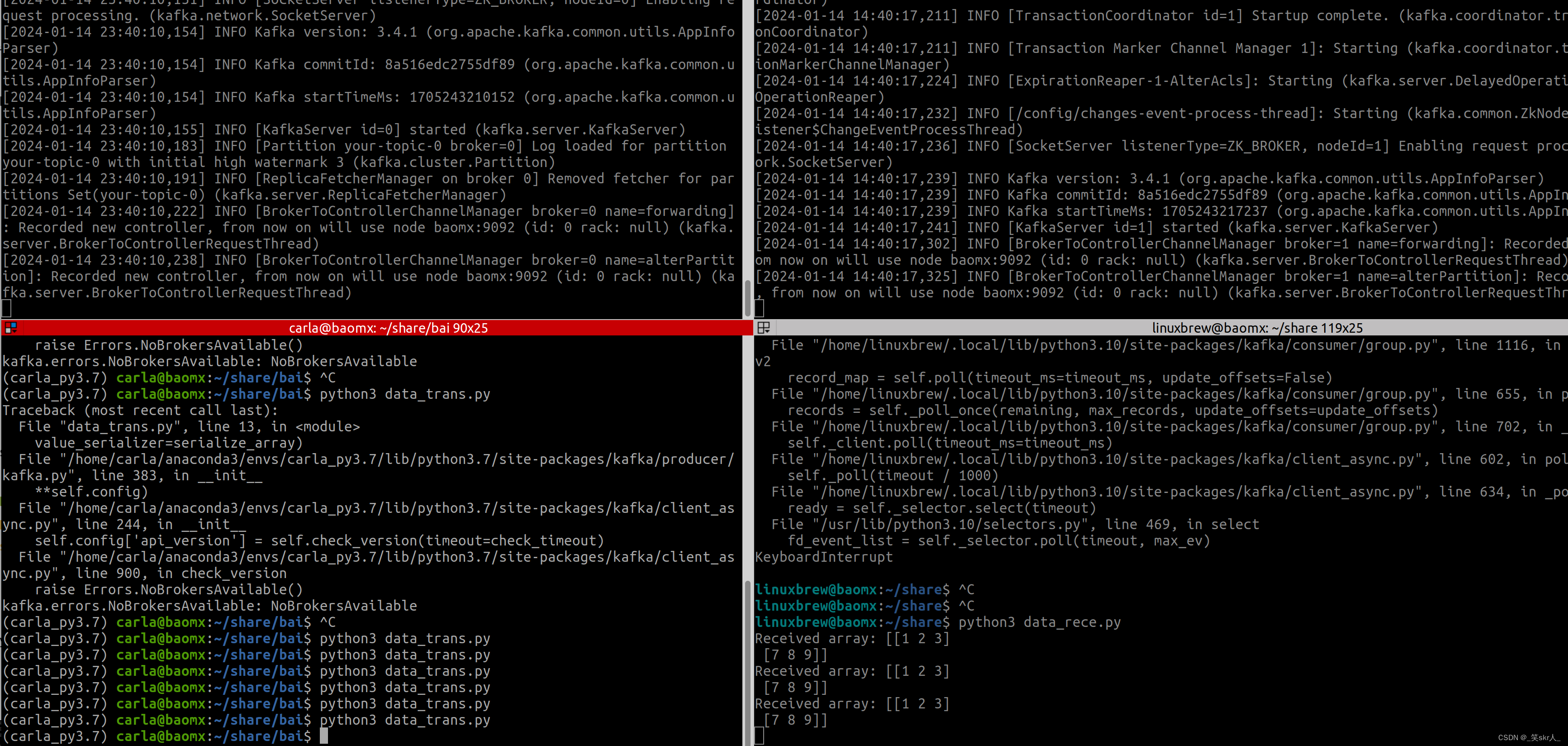

6. 先执行接受端,在执行生产者

7. 生产者

import numpy as np

from kafka import KafkaProducer

import json

# 序列化函数

def serialize_array(array):

return json.dumps(array.tolist()).encode('utf-8')

# 创建生产者实例

producer = KafkaProducer(bootstrap_servers='baomx:9092',

value_serializer=serialize_array)

# 发送 NumPy 数组

array = np.array([1, 2, 3])

producer.send('your-topic', array)

producer.flush()

- 接受者

from kafka import KafkaConsumer

import json

import numpy as np

# 反序列化函数

def deserialize_array(message):

return np.array(json.loads(message.decode('utf-8')))

# 创建消费者实例

consumer = KafkaConsumer('your-topic',

bootstrap_servers='baomx:9092',

value_deserializer=deserialize_array)

# 接收消息

for message in consumer:

array = message.value

print("Received array:", array)

- 安装完成

- 错误1

原因: 更改了broker.id 然后ERROR Exiting Kafka due to fatal exception during startup. (kafka.Kafka$) kafka.common.InconsistentBrokerIdException: Configured broker.id 1 doesn’t match stored broker.id Some(0) in meta.properties. If you moved your data, make sure your configured broker.id matches. If you intend to create a new broker, you should remove all data in your data directories (log.dirs).

解释: 如果更改了现有 Kafka Broker 的 broker.id,但其数据目录(由 log.dirs 指定)中的 meta.properties 文件仍包含旧的 Broker ID。直接删除 log 文件即可.

cd /tmp

rm -rf kafka-logs

#具体目录在server.properties中

#打开 server.properties 文件,查找 log.dirs 行

#log.dirs=/path/to/kafka-logs

文章来源:https://blog.csdn.net/qq_43385138/article/details/135590355

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 局域网IP地址冲突、环路的罪魁祸首是什么?

- Databend 的算力可扩展性

- js中国标准时间转换

- ui8.net免费资源-万库全书-sketch、figma源文件-Taxi Booking App UI Kit

- (八)Java 循环结构 —— for、while、do...while

- 最新UI酒桌喝酒游戏小程序源码,直接上传源码到开发者端即可,带流量主

- Appium:一款强大的移动应用自动化测试工具

- 14:00面试,14:07就出来了,问的问题有点变态。。。

- LVM系统逻辑卷

- docker的应用和定义