机器学习实验报告——APRIORI算法

一、算法介绍

1.1算法背景

APRIORI算法是由Rakesh Agrawal?和?Ramakrishnan Srikant于1994年提出的,它是关联规则挖掘领域中的经典算法之一。在当时,数据挖掘和关联规则挖掘成为了研究热点,而APRIORI算法的提出填补了这一领域的空白。

在APRIORI算法之前,人们对于如何高效地发现大规模数据集中的频繁项集和关联规则缺乏有效的方法。传统的暴力搜索方法在大规模数据集上的计算开销很大,因此迫切需要一种高效的算法来解决这个问题。

APRIORI算法的背景正是基于对这一问题的深刻理解和需求,它利用了一种叫做“先验知识”的技术,通过剪枝操作来减少搜索空间,从而大大提高了频繁项集和关联规则的发现效率。这种技术可以避免对所有可能的项集进行搜索,而是根据先验知识进行优化,只考虑那些可能成为频繁项集的子集。

因此,APRIORI算法的提出填补了关联规则挖掘领域的研究空白,为大规模数据集中的频繁项集和关联规则的发现提供了一种高效的解决方案。它为后续关联规则挖掘算法的发展奠定了重要的基础,成为数据挖掘领域中不可或缺的经典算法之一。

1.2算法引入

随着社会经济和购买力的不断发展,商场也面临着急剧膨胀的购买记录,如何通过研究购买记录来获取购买规律来提高收益也便成为了研究热点。沃尔玛发现,当一个人购买尿布,那么他便有很高的几率购买啤酒,这就是著名的“啤酒与尿布”的故事。研究“啤酒与尿布”关联的方法就是购物篮分析,购物篮分析曾经是沃尔玛秘而不宣的独门武器,购物篮分析可以帮助门店的销售过程中找到具有关联关系的商品,并以此获得销售收益的增长。而Apriori就是用来挖掘数据关联规则最经典的算法。

1.3算法假设

APRIORI算法基于以下两个假设来发现频繁项集和关联规则:

(1)基于支持度的假设:一个项集是频繁的,当且仅当该项集的支持度不小于某个阈值。支持度是指在所有的数据记录中,包含该项集的记录所占的比例。这个假设意味着,支持度高的项集更有可能是频繁项集,因此需要优先考虑。

(2)基于先验知识的假设:如果一个项集是频繁的,则它的所有子集也必须是频繁的。这个假设意味着,如果一个项集不是频繁的,那么它的所有超集也不可能是频繁的。因此,可以通过排除非频繁项集的超集来减少搜索空间。

基于这两个假设,APRIORI算法使用逐层搜索的方式来发现频繁项集和关联规则。具体地说,该算法从频繁1-项集开始,逐步生成候选k-项集,并根据支持度进行剪枝,得到频繁k-项集。然后,根据频繁项集生成关联规则,并计算置信度。最后,根据置信度进行排序和筛选。

需要注意的是,APRIORI算法的假设并不总是成立。例如,在某些应用场景下,支持度高的项集并不一定是频繁项集。因此,在实际应用中,需要根据具体情况进行调整和优化。

1.4算法基本概念介绍

1.4.1关联规则

关联规则是形如X=>Y的蕴含式,其中X、Y分别是一事务的真子集,且X∩Y=Φ。X称为规则的前提,Y称为规则的结果。关联规则反映出X中的项目在事务中出现时,Y中的项目也跟着出现的规律。

1.4.2支持度

关联规则的支持度是事务集中同时包含X和Y的事务数量与所有事务数量之比,它反映了X和Y中所含的事务的项在事务集中同时出现的频率,记为support(X=>Y),即support(X=>Y)=support(X∪Y)=P(XY)

1.4.3置信度

关联规则的置信度是事务集中同时包含X和Y的事务数量与包含X的事务数量之比,记为confidence(X=>Y),置信度反映了包含X的事务中出现Y的条件概率。即?confidence(X=>Y)=support(X∪Y)/support(X)=P(XY)

1.4.4频繁项集

设U∈I,项目集U在事务集T上的支持度是包含U的事务在T中所占的百分比,即support(U)=|| {t∈T | U∈t} || / ||T||。式中,||?…?||表示集合中的元素数目。对项目集I,在事务数据库T中所有满足用户指定的最小支持度的项目集,即不小于最小支持度阀值的I的非空子集,称为频繁项目集或大项目集。

1.4.5项目

项目是数据集中最小的独立单位,比如在购物记录中,“牛奶”便是一个项目。

项集:项集是项目的集合,如一条购物记录便对应着一个项集,就像{“牛奶”,“饼干”,“汽水”}。

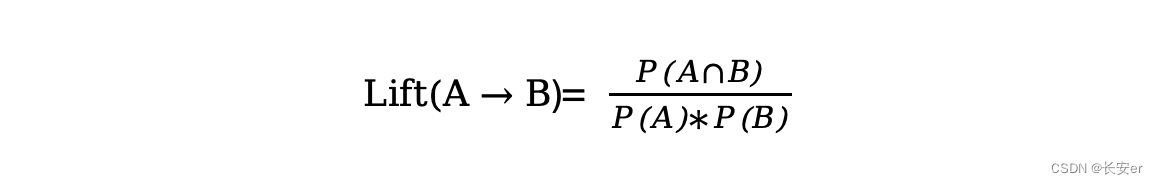

1.4.6提升度

提升度(Lift)是关联规则挖掘中用于衡量两个项集之间相关性强弱的指标。提升度表示当A出现时,B出现的概率与B本身出现的概率之比,与A无关时,B出现的概率与B本身出现的概率之比的商,即:

其中,P(A)表示项集A出现的概率,P(B)表示项集B出现的概率,P(A∩B)表示项集A和项集B同时出现的概率。

如果提升度大于1,则表示A出现与B出现是正相关的;如果提升度等于1,则表示A和B之间没有关联;如果提升度小于1,则表示A出现与B出现是负相关的。

提升度的大小与支持度和置信度有关,但不同的是,提升度更侧重于衡量两个项集之间的关联性,而支持度和置信度更侧重于衡量单个项集的出现频率和规则的可靠程度。

二、算法原理

2.1算法思想

Apriori算法的基本思想是通过对数据库的多次扫描来计算项集的支持度,发现所有的频繁项集从而生成关联规则。Apriori算法对数据集进行多次扫描,第一次扫描得到频繁1-项集L1,第k(k>1)次扫描首先利用第(k-1)次扫描的结果L(k-1)来产生候选k-项集的集合Ck,然后在扫描过程中确定Ck中元素的支持度,最后在每一次扫描结束时计算频繁k-项集的集合Lk,算法在当候选k-项集的集合Ck为空时结束。

2.2Apriori算法产生频繁项集=

产生频繁项集的过程主要分为连接和剪枝两步:

(1)连接步。为找到Lk(k≧2),通过L(k-1)与自身连接产生候选k-项集的集合Ck。自身连接时,两个项集对应的想按从小到大顺序排列好,当前除最后一项外的其他项都相等时,两个项集可连接,连接产生的结果为(l1[1], l1[2],?…, l1[k-1], l2[k-2])。

(2)剪枝步。由Apriori算法的性质可知,频繁k-项集的任何子集必须是频繁项集。由连接步产生的集合Ck需进行验证,除去不满足支持度的非频繁k-项集。

(3)删除策略

基于压缩后的Ck,扫描所有事务,对Ck中的每个项进行计数,然后删除不满足最小支持度的项,从而获得频繁k项集。

2.3Apriori算法的基本步骤

(1)扫描全部数据,产生候选1-项集的集合C1;

(2)根据最小支持度,由候选1-项集的集合C1产生频繁1-项集的集合L;

(3)对k>1,重复执行步骤(4)、(5)、(6);

(4)由Lk执行连接和剪枝操作,产生候选(k+1)-项集的集合C(k+1)。

(5)根据最小支持度,由候选(k+1)-项集的集合C(k+1),产生频繁(k+1)-项集的集合L(k+1);

(6)若L≠Ф,则k=k+1,跳往步骤(4);否则往下执行;

(7)根据最小置信度,由频繁项集产生强关联规则,程序结束。

2.4关联分析

关联分析又称关联挖掘,就是在交易数据、关系数据或其他信息载体中,查找存在于项目集合或对象集合之间的频繁模式、关联、相关性或因果结构。属于无监督学习。它是一种在大规模数据集中寻找有趣关系的任务。这些关系可以有两种形式:

频繁项集(frequent item sets):?经常出现在一块的物品的集合。

关联规则(associational rules):?暗示两种物品之间可能存在很强的关系。

联系:Apriori算法是关联规则挖掘技术的最基本算法.目前关联规则的并行数据挖掘算法大都以Apriori算法为基础,它具有无可替代的独特地位。Apriori算法本质主要包含两个方面问题,第一个是找出事务数据库中所有的频繁数据项集。第二个是如何生成强关联规则。

三、算法实现

3.1 Apriori?算法简单实现

(1)代码

from?efficient_apriori?import?apriori

#?设置数据集

transactions?=?[('牛奶','面包','尿布'),

??('可乐','面包',?'尿布',?'啤酒'),

??('牛奶','尿布',?'啤酒',?'鸡蛋'),

??('面包',?'牛奶',?'尿布',?'啤酒'),

??('面包',?'牛奶',?'尿布',?'可乐')]

#?挖掘频繁项集和频繁规则

itemsets,?rules?=?apriori(transactions,?min_support=0.5,??min_confidence=1)#设置最小支持度为0.5,最小置信度为1

print("频繁项集:",?itemsets)

print("关联规则:",?rules)- 运行结果

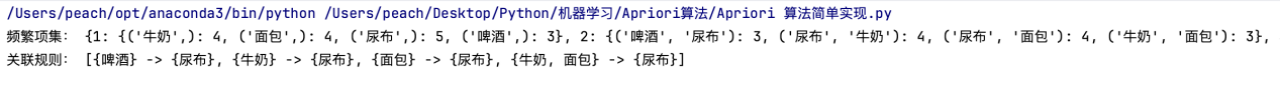

频繁项集:?{1: {('牛奶',): 4, ('面包',): 4, ('尿布',): 5, ('啤酒',): 3}, 2: {('啤酒', '尿布'): 3, ('尿布', '牛奶'): 4, ('尿布', '面包'): 4, ('牛奶', '面包'): 3}, 3: {('尿布', '牛奶', '面包'): 3}}

关联规则:?[{啤酒} -> {尿布}, {牛奶} -> {尿布}, {面包} -> {尿布}, {牛奶,?面包} -> {尿布}]

部分结果截图如下

- 分析

①代码分析

定义数据集:代码第3-7行定义了一个包含多个交易记录的数据集。每个交易记录是一个包含多个商品的列表。

挖掘频繁项集和关联规则:代码第9行调用apriori函数进行挖掘。传入参数包括数据集transactions、最小支持度min_support和最小置信度min_confidence。在这里,设置最小支持度为0.5,最小置信度为1。

打印结果:代码第11-13行打印出频繁项集和关联规则的结果。itemsets是一个字典,键表示项集的大小,值是包含频繁项集的集合。rules是一个列表,其中每个元素是一个关联规则。

②结果分析

频繁项集结果(itemsets):

大小为1的频繁项集有四个:牛奶、面包、尿布和啤酒。

大小为2的频繁项集有四个:啤酒和尿布的组合、牛奶和尿布的组合、面包和尿布的组合、牛奶和面包的组合。

大小为3的频繁项集只有一个:牛奶、面包和尿布的组合。

关联规则结果(rules):

找到了四条关联规则,分别是{啤酒} -> {尿布}、{牛奶} -> {尿布}、{面包} -> {尿布}、{牛奶,?面包} -> {尿布}。

?

可得结论:

数据集中最频繁的商品是尿布,其次是牛奶和面包,啤酒出现的频率相对较低。

通过关联规则可以看出,啤酒和尿布、牛奶和尿布、面包和尿布之间存在着强关联。

3.2超市购物小票的关联关系

3.2.1数据集描述

BreadBasket_DMS.csv

字段:Date(日期),Time(时间),Transaction(交易ID)Item(商品名称)

交易ID的范围是[1,9684],存在交易ID为空的情况,同一笔交易中存在商品重复的情况。以外,有些交易没有购买商品(对应的Item为NONE)

3.2.2 代码实现

import?pandas?as?pd

#?数据加载

data?=?pd.read_csv('BreadBasket/BreadBasket_DMS.csv')

#?统一小写

data['Item']?=?data['Item'].str.lower()

#?去掉none项

data?=?data.drop(data[data.Item?==?'none'].index)

#?采用efficient_apriori工具包

def?rule():

?from?efficient_apriori?import?apriori

?#?得到一维数组orders_series,并且将Transaction作为index,?value为Item取值

?orders_series?=?data.set_index('Transaction')['Item']

?#?将数据集进行格式转换

?transactions?=?[]

?temp_index?=?0

?for?i,?v?in?orders_series.items():#将同一个交易的商品放到一起

??if?i?!=?temp_index:#i是交易ID

???temp_set?=?set()

???temp_index?=?i

???temp_set.add(v)#v是item的值

???transactions.append(temp_set)

??else:

???temp_set.add(v)

?#?这个时候我们得到的transactions就是我们想要的数据

?#?挖掘频繁项集和频繁规则

?itemsets,?rules?=?apriori(transactions,?min_support=0.02,??min_confidence=0.5)#支持度为0.02,置信度为0.5

?print('频繁项集:',?itemsets)

?print('关联规则:',?rules)

rule()- 分析

①首先是数据预处理

数据集采用Pandas读取,并将商品名称改为小写。

将数据集中的空值('none')删除。

②然后是Apriori算法实现部分

采用efficient_apriori工具包实现Apriori算法。

将数据集格式转换为transactions,即将同一交易ID的商品集合放到一个set中,最终得到一个由多个set构成的列表。

然后对transactions进行Apriori算法挖掘,设定最小支持度min_support为0.02,最小置信度min_confidence为0.5,得到频繁项集itemsets和关联规则rules。

③最后是运行结果

频繁项集itemsets:其中数字1、2、表示不同项集的大小。每一个项集大小的字典中,元组表示该项集中的商品,元素值表示该商品出现的次数。

关联规则rules:其中每一条规则为一个元组,表示规则左侧的商品集合和右侧的商品集合。例如{cake} -> {coffee}表示购买蛋糕的人也有很大可能会购买咖啡。

3.3电影分类的关联分析

3.3.1数据集分析

数据集:MovieLens ????主要使用的文件:movies.csv

格式:movieId title genres

记录了电影ID,标题和分类

我们可以分析下电影分类之间的频繁项集和关联规则

MovieLens?主要使用?Collaborative Filtering?和?Association Rules?相结合的技术,向用户推荐他们感兴趣的电影。

3.3.2代码实现

#?分析MovieLens?电影分类中的频繁项集和关联规则

import?pandas?as?pd

from?mlxtend.frequent_patterns?import?apriori

from?mlxtend.frequent_patterns?import?association_rules

#from?efficient_apriori?import?apriori

#?数据加载

movies?=?pd.read_csv('movies.csv')

#print(movies.head())

#?将genres进行one-hot编码(离散特征有多少取值,就用多少维来表示这个特征)

#print(movies['genres'])

#?movies_hot_encoded?=?movies.drop('genres',1).join(movies.genres.str.get_dummies(sep='|'))

movies_hot_encoded?=?movies.drop('genres',?axis=1).join(movies.genres.str.get_dummies(sep='|'))

#print(movies_hot_encoded)

pd.options.display.max_columns=100

print(movies_hot_encoded.head())

#?将movieId,?title设置为index

movies_hot_encoded.set_index(['movieId','title'],inplace=True)

#print(movies_hot_encoded.head())

#?挖掘频繁项集,最小支持度为0.02

itemsets?=?apriori(movies_hot_encoded,use_colnames=True,?min_support=0.02)

#?按照支持度从大到小

itemsets?=?itemsets.sort_values(by="support"?,?ascending=False)

print('-'*20,?'频繁项集',?'-'*20)

print(itemsets)

#?根据频繁项集计算关联规则,设置最小提升度为2

rules?=??association_rules(itemsets,?metric='lift',?min_threshold=2)

#?按照提升度从大到小进行排序

rules?=?rules.sort_values(by="lift"?,?ascending=False)

#rules.to_csv('./rules.csv')

print('-'*20,?'关联规则',?'-'*20)

print(rules)- 结果

--------------------?频繁项集?--------------------

?????support ?????????????????itemsets

7 ??0.489185 ??????????????????(Drama)

4 ??0.306987 ?????????????????(Comedy)

14 ?0.153164 ???????????????(Thriller)

12 ?0.151294 ????????????????(Romance)

0 ??0.129042 ?????????????????(Action)

5 ??0.107743 ??????????????????(Crime)

9 ??0.095718 ?????????????????(Horror)

31 ?0.094325 ?????????(Drama, Romance)

26 ?0.093335 ??????????(Drama, Comedy)

6 ??0.090586 ????????????(Documentary)

1 ??0.085380 ??????????????(Adventure)

27 ?0.069470 ????????(Romance, Comedy)

32 ?0.068480 ????????(Drama, Thriller)

13 ?0.063898 ?????????????????(Sci-Fi)

28 ?0.062761 ???????????(Drama, Crime)

11 ?0.055503 ????????????????(Mystery)

8 ??0.051763 ????????????????(Fantasy)

29 ?0.045165 ????????(Crime, Thriller)

20 ?0.044101 ??????????(Action, Drama)

15 ?0.043772 ????????????????????(War)

3 ??0.041755 ???????????????(Children)

22 ?0.040655 ???????(Action, Thriller)

34 ?0.039336 ???????(Horror, Thriller)

10 ?0.037979 ????????????????(Musical)

2 ??0.037649 ??????????????(Animation)

17 ?0.035633 ??????(Action, Adventure)

33 ?0.032774 ?????????????(Drama, War)

35 ?0.029144 ??????(Mystery, Thriller)

19 ?0.028118 ??????????(Action, Crime)

36 ?0.027458 ?(Drama, Romance, Comedy)

30 ?0.026432 ?????????(Drama, Mystery)

18 ?0.026358 ?????????(Action, Comedy)

25 ?0.025368 ??????????(Crime, Comedy)

24 ?0.025295 ???????(Adventure, Drama)

37 ?0.024965 ?(Drama, Crime, Thriller)

16 ?0.024782 ????????????????(Western)

21 ?0.023499 ?????????(Action, Sci-Fi)

23 ?0.022032 ??????(Adventure, Comedy)

???consequent support ??support ?confidence ?????lift ?leverage ?conviction ?\

9 ????????????0.055503 ?0.029144 ???0.190282 ?3.428352 ?0.020643 ???1.166453 ??

8 ????????????0.153164 ?0.029144 ???0.525099 ?3.428352 ?0.020643 ???1.783185 ??

14 ???????????0.068480 ?0.024965 ???0.231711 ?3.383632 ?0.017587 ???1.212461 ??

13 ???????????0.107743 ?0.024965 ???0.364561 ?3.383632 ?0.017587 ???1.404159 ??

7 ????????????0.129042 ?0.035633 ???0.417347 ?3.234198 ?0.024616 ???1.494813 ??

6 ????????????0.085380 ?0.035633 ???0.276136 ?3.234198 ?0.024616 ???1.263525 ??

16 ???????????0.063898 ?0.023499 ???0.182102 ?2.849906 ?0.015253 ???1.144523 ??

17 ???????????0.129042 ?0.023499 ???0.367757 ?2.849906 ?0.015253 ???1.377568 ??

1 ????????????0.107743 ?0.045165 ???0.294878 ?2.736877 ?0.028662 ???1.265394 ??

0 ????????????0.153164 ?0.045165 ???0.419190 ?2.736877 ?0.028662 ???1.458027 ??

5 ????????????0.095718 ?0.039336 ???0.256821 ?2.683100 ?0.024675 ???1.216776 ??

4 ????????????0.153164 ?0.039336 ???0.410954 ?2.683100 ?0.024675 ???1.437639 ??

12 ???????????0.153164 ?0.024965 ???0.397780 ?2.597093 ?0.015352 ???1.406192 ??

15 ???????????0.062761 ?0.024965 ???0.162997 ?2.597093 ?0.015352 ???1.119755 ??

2 ????????????0.153164 ?0.040655 ???0.315057 ?2.056994 ?0.020891 ???1.236360 ??

3 ????????????0.129042 ?0.040655 ???0.265438 ?2.056994 ?0.020891 ???1.185684 ??

10 ???????????0.107743 ?0.028118 ???0.217898 ?2.022393 ?0.014215 ???1.140845 ??

11 ???????????0.129042 ?0.028118 ???0.260973 ?2.022393 ?0.014215 ???1.178520 ??

????zhangs_metric ?

9 ???????0.836425 ?

8 ???????0.749938 ?

14 ??????0.789525 ?

13 ??????0.756248 ?

7 ???????0.755291 ?

6 ???????0.793154 ?

16 ??????0.745284 ?

17 ??????0.693419 ?

1 ???????0.749401 ?

0 ???????0.711252 ?

5 ???????0.740753 ?

4 ???????0.693696 ?

12 ??????0.656134 ?

15 ??????0.726178 ?

2 ???????0.589987 ?

3 ???????0.606792 ?

10 ??????0.580437 ?

11 ??????0.566581 ?

(2)分析

①代码分析

首先,代码使用pandas库加载了名为movies.csv的电影数据集,并进行了预处理,将电影的类型进行了one-hot编码,以便进行频繁项集和关联规则的挖掘分析。

接着,使用mlxtend.frequent_patterns中的apriori函数对数据集进行频繁项集挖掘,设置了最小支持度为0.02,并按照支持度从大到小进行排序输出频繁项集。

然后,利用mlxtend.frequent_patterns中的association_rules函数基于频繁项集计算关联规则,设置了最小提升度为2,并按照提升度从大到小进行排序输出关联规则。

最后,输出了频繁项集和关联规则的分析结果。

②结果分析

首先,在频繁项集中,支持度最高的几个电影类型包括Drama(剧情)、Comedy(喜剧)、Thriller(惊悚)、Romance(爱情)、Action(动作)等。这表示这些电影类型在用户对电影的选择中出现的频率较高。

其次,在关联规则中,我们可以看到不同电影类型之间的关联性。例如,Mystery(悬疑)电影往往和Thriller(惊悚)电影有较强的关联,这表明喜欢悬疑题材的用户也可能喜欢惊悚题材的电影。类似地,还有其他类型之间的关联规则,比如Action和Adventure、Crime和Thriller等。

在我看来,这些分析结果可以很好的帮助电影平台进行推荐系统的优化,比如根据用户对某一类型电影的喜好来推荐其他相关类型的电影,从而提升用户体验和电影的观看量。

四、算法讨论

4.1Apriori算法优缺点

Apriori算法是一种经典的频繁项集挖掘算法,它的主要优点和缺点如下:

①优点:

简单易懂:Apriori算法的思想相对简单,易于理解和实现。

广泛适用:Apriori算法适用于各种类型的数据集,不仅可以用于关联规则挖掘,还可以用于其他领域的频繁项集挖掘。

可扩展性好:Apriori算法可以通过调整最小支持度参数来控制挖掘的频繁项集数量,从而适应不同的需求。

②缺点:

大规模数据集效率低:Apriori算法需要多次扫描数据集,并生成候选项集进行支持度计数,这在处理大规模数据集时会导致效率较低。

内存消耗大:Apriori算法需要维护中间结果,包括候选项集和频繁项集,这会占用较大的内存空间。

频繁项集数目庞大:在某些情况下,Apriori算法可能会生成大量的频繁项集,这给后续的关联规则生成和分析带来困难。

针对Apriori算法的缺点,研究者们提出了一些改进算法,如FP-Growth算法和Eclat算法,它们在一定程度上克服了Apriori算法的效率和内存消耗问题。因此,在实际应用中,可以根据实际情况选择合适的频繁项集挖掘算法。

4.2对FP-Growth算法及FP树的探讨

FP-Growth是一种用于挖掘频繁项集的算法,它使用了一种称为FP树(Frequent Pattern Tree)的数据结构来高效地发现频繁项集。与Apriori算法相比,FP-Growth算法在某些情况下具有更好的性能。

FP-Growth算法与Apriori算法的联系和区别如下:

①数据结构:Apriori算法基于候选项集的生成和多次数据库扫描来发现频繁项集,而FP-Growth算法使用FP树这种特殊的数据结构来紧凑地表示频繁项集信息,并通过递归处理树结构来挖掘频繁项集。

②处理大规模数据集:在处理大规模数据集时,FP-Growth算法通常比Apriori算法更快,因为它只需要对数据集进行两次扫描,减少了多次数据库扫描的开销。

③内存消耗:FP-Growth算法通常比Apriori算法需要更少的内存空间,因为它使用了压缩的数据结构FP树来表示频繁项集信息,减少了中间结果的存储开销。

④适用范围:在一些特定的数据集情况下,FP-Growth算法可能比Apriori算法更有效,但在其他情况下可能会有所不同,因为两种算法的性能取决于具体的数据特征。

总之,FP-Growth算法通过引入FP树数据结构,减少了多次数据库扫描和候选项集的生成过程,从而提高了频繁项集挖掘的效率,尤其在处理大规模数据集时具有优势。与Apriori算法相比,FP-Growth算法在一定情况下能够更有效地挖掘频繁项集。

4.3关联规则与频繁模式之间的关系

关联规则和频繁模式是数据挖掘中密切相关的概念,它们之间存在以下关系:

①频繁模式(Frequent Patterns):频繁模式指的是在数据集中经常出现的模式或者项集。频繁模式可以是单个项(例如购物篮中的商品)、项集(多个项的组合)或者序列(时间上的顺序组合)。频繁模式挖掘的目标是发现那些出现频率高于预定义最小支持度阈值的模式。

②关联规则(Association Rules):关联规则是指数据中项集之间的关联关系。关联规则通常以“如果...那么...”的形式表示,其中左侧是前提(Antecedent),右侧是结论(Consequent)。关联规则可以帮助我们理解数据之间的相关性,并且可以用于预测、推荐和决策等应用。

③关联规则与频繁模式的关系:关联规则可以从频繁模式中派生得到。具体来说,对于一个频繁模式,我们可以生成所有可能的关联规则,并通过计算规则的置信度和支持度来评估规则的质量。然后,我们可以根据置信度和支持度进行规则的筛选和排序,选择具有较高置信度的关联规则作为最终的结果。

总结起来,频繁模式是数据集中经常出现的模式或项集,而关联规则是从频繁模式中派生而来的,用于描述数据中项集之间的关联关系。频繁模式挖掘的结果可以作为关联规则挖掘的基础,而关联规则可以帮助我们理解数据之间的相关性和发现潜在的模式。

4.4Apriori算法的应用

Apriori算法是一种常用的频繁模式挖掘算法,它可以应用于多个领域和场景。以下是Apriori算法的一些应用示例:

①购物篮分析:在零售业中,Apriori算法可以用于购物篮分析,即挖掘顾客购买商品的频繁模式和关联规则。通过分析购物篮数据,可以了解哪些商品经常同时被购买,从而进行交叉销售、推荐系统优化和促销活动规划等。

②网络流量分析:在网络安全领域,Apriori算法可以应用于网络流量日志分析,帮助发现恶意攻击、异常行为或者网络故障等。通过挖掘网络流量的频繁模式和关联规则,可以提供实时的威胁检测和异常行为识别。

③医疗诊断:在医疗领域,Apriori算法可以应用于疾病诊断和治疗方案推荐。通过分析大规模的医疗数据,可以挖掘患者病历中的频繁模式和关联规则,帮助医生做出准确的诊断,并制定个性化的治疗方案。

④网络推荐系统:在互联网领域,Apriori算法可以用于用户行为数据分析和个性化推荐系统。通过挖掘用户历史行为数据中的频繁模式和关联规则,可以为用户提供个性化的推荐,帮助他们发现感兴趣的内容或商品。

⑤市场篮子分析:在市场研究领域,Apriori算法可以应用于市场篮子分析,帮助了解不同产品之间的关联性。通过挖掘购物者购买行为中的频繁模式和关联规则,可以优化产品布局、定价策略和促销活动,提高市场竞争力。

这些只是Apriori算法的一些常见应用示例,实际上,该算法可以适用于许多其他领域,如网络推荐系统、社交网络分析、文本挖掘等,帮助我们从大规模数据中发现有用的模式和规律。

五、实验总结

本次实验主要探讨了关联规则挖掘领域中的经典算法——Apriori算法。首先介绍了Apriori算法的背景,该算法填补了关联规则挖掘领域的研究空白,并为大规模数据集中频繁项集和关联规则的发现提供了高效的解决方案。接着以购物篮分析为例引入Apriori算法,该算法基于支持度和先验知识假设,通过逐层搜索的方式来发现频繁项集和关联规则。

在算法原理部分,首先阐述了Apriori算法的核心思路,即通过对数据库的多次扫描来计算项集的支持度,从而发现所有的频繁项集并生成关联规则。然后介绍了Apriori算法的实现步骤,其中连接步和剪枝步是非常重要的两个步骤,在产生频繁项集的过程中起到关键作用。

在算法实现部分,我首先简单实现了Apriori算法,然后探讨了关联分析在超市购物小票和电影分类中的应用场景。这些关联关系可以帮助商家更好地了解顾客的购买行为,从而提高销售额和利润。

在算法讨论部分,我们重点关注了Apriori算法的缺点,即在候选集产生过程中可能会生成大量的子集,导致计算空间和时间的浪费。为解决这个问题,我们引入了FP-Growth算法,该算法通过使用FP树数据结构来解决了这一问题,能够更有效地挖掘频繁项集。

最后,我们分析了Apriori算法与FP-Growth算法之间的联系和区别,发现在某些情况下,FP-Growth算法能够更高效地挖掘频繁项集。此外,我们还讨论了Apriori算法的应用领域,实际上,该算法可以适用于许多其他领域,如网络推荐系统、社交网络分析等,帮助我们从大规模数据中发现有用的模式和规律,是一个非常实用的机器学习算法。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!