OpenAI开发者大会简介

文章目录

昨天晚上

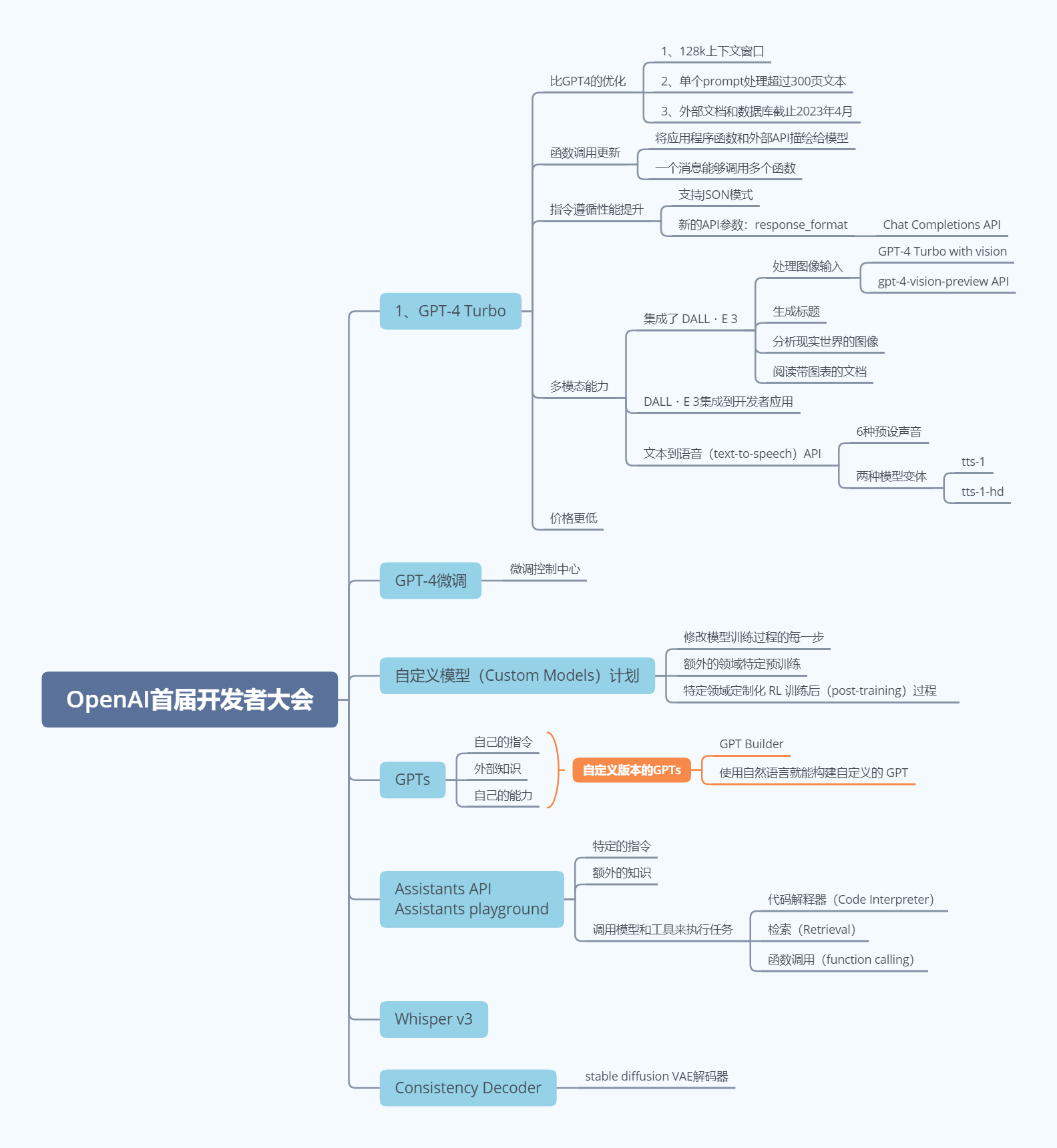

OpenAI的首届开发者大会召开

Sam Altman也做了公开演讲,应该说

这是继今年春天发布GPT-4之后

OpenAI在AI行业又创造的一个不眠夜

过去一年

ChatGPT绝对是整个科技领域最热的词汇

OpenAI 也依靠ChatGPT取得了惊人的成绩

ChatGPT目前每周有超过1亿活跃用户

超过200万开者使用API等进行开发

与超过92%的财富500强公司合作

在这次备受期待的首届开发者大会上

Altman也带来了一系列全新的AI模型和工具

包括全新的GPT-4 Turbo模型

函数调用增强和JSON模式

开放DALLE-3、GPT-4 Turbo with vision、TTS和Whisper V3等模型的API

增加GPT-4微调、自定义模型

可以允许创建自定义版本ChatGPT的GPTs

即将上线的GPT Store

以及更接近AI智能体的体验的Assistants API

从这些更新的展示中可以明显感觉到

OpenAI 正在努力把 ChatGPT 构建成一个自动化程度更高的 AI 智能体

这个智能体不再是「纸上谈兵」,

而是越来越多地通过操纵现有应用对物理世界产生影响

比如,在活动现场

一位 OpenAI 的工作人员通过语音与 ChatGPT 对话

给在场的每一位观众发放了 500 美元 OpenAI 代金券

好了,接下来我们就来详细介绍一下

这次OpenAI开发者大会的精彩内容

GPT-4 Turbo

会上首先亮相的是 GPT-4 的全新版本 GPT-4 Turbo

我们知道

OpenAI 在今年 3 月发布了 GPT-4 初始版本

并在 7 月广泛提供给了所有开发者

Sam Altman 在现场一一解析了 GPT-4 Turbo 的几大亮点

首先,GPT-4 Turbo 比 GPT-4 更强大

支持 128k 上下文窗口

可以在单个 prompt 中处理超过 300 页的文本

更长的上下文意味着模型输出结果更加准确

其次

GPT-4 Turbo 能够了解更近、更丰富的世界知识

外部文档和数据库的截止日期更新到了 2023 年 4 月

与之相比

GPT-4 的知识库截止日期为 2021 年 9 月

接下来是函数调用更新

函数调用允许将应用程序函数或外部 API 描绘给模型

并让模型智能选择「包含调用这些函数的参数」的 JSON 对象

GPT-4 Turbo 在这方面还做了几项改进

比如在一条消息中能够调用多个函数

用户可以在发送一条消息时请求多个操作

如「打开车窗并关闭空调」。

此外函数调用的准确性也得到提升

GPT-4 Turbo 更有可能返回正确的函数参数

与此同时

指令遵循性能得到提升并支持了 JSON 模式

其中在需要严格指令遵循的任务上

GPT-4 Turbo 的表现比以往的模型更好

比如生成特定的响应格式

GPT-4 Turbo 还支持了新的 JSON 模式

确保模型使用有效的 JSON 进行响应

新的 API 参数 response_format 可以限制模型输出以生成语法正确的 JSON 对象

这个模式对开发者在聊天完成(Chat Completions)API 中生成 JSON 非常有用

多模态能力也是大会的重点内容

为此 OpenAI 开放了全新的 API

这次GPT-4 Turbo 集成了 DALL?E 3

不仅能够接受并处理图像输入(即 GPT-4 Turbo with vision)

还能够生成标题、分析现实世界的图像、阅读带图表的文档等

对于 GPT-4 Turbo with vision

开发者可以通过 API 中的 gpt-4-vision-preview 来访问

OpenAI 计划为主要的 GPT-4 Turbo 模型提供视觉支持

价格取决于输入图像的大小

例如像素 1080×1080 的图像需要的成本为 0.00765 美元

同样地

开发者可以通过图像 API 将 DALL?E 3 直接集成到他们的应用程序和产品中

与之前版本的 DALL?E 类似

这个API 内置了审核的功能

可以帮助开发者保护自己的应用程序免遭滥用

OpenAI 提供了不同的格式和质量选项

生成一张图像的起价为 0.04 美元

在文本转换语音领域

开发者现在可通过文本到语音(text-to-speech)API

将文本转化为人类质量的语音

全新 TTS 模型提供了 6 种预设声音和两种模型变体即 tts-1 和 tts-1-hd

其中 tts 针对实时用例进行优化

tts-1-hd 针对质量进行优化

每输入 1000 字符的起价为 0.015 美元

有了新版本 GPT-4 Turbo

OpenAI 也没有「忘了」GPT-4

现在,GPT-4 微调正在实验访问阶段

OpenAI 正在创建一个用于 GPT-4 微调的实验性访问程序

不过与 GPT-3.5 微调获得的实质收益相比

GPT-4 微调需要更多工作才能对基础模型实现有意义的改进

未来

随着 GPT-4 微调在质量和安全性方面得到提升

GPT-3.5 微调的活跃使用者可以选择在他们的微调控制中心应用 GPT-4 程序

在微调之外

对于那些需要更多定制化功能的组织机构

OpenAI 启动了自定义模型(Custom Models)计划

允许组织机构与 OpenAI 研究人员一起针对特定领域来训练定制化 GPT-4

其中包括修改模型训练过程的每一步

从额外的领域特定预训练

到运行针对特定领域的定制化 RL 训练后(post-training)过程

组织机构对其定制化模型拥有独家访问权

OpenAI 不会提供给其他客户或与其他客户共享

也不会用于训练其他模型

此外提供给 OpenAI 来训练定制化模型的专有数据

不会在其他上下文中重复使用

不过,OpenAI 表示

目前自定义模型的功能有限且成本高昂

最后是价格

虽然 GPT-4 Turbo 性能更强了

但是价格却被打下来了

对比 GPT-4

GPT-4 Turbo 的输入 token 价格是其 1/3

为1000 token 0.01美元;

输出 token 价格是其 1/2

为1000 token 0.03美元

同样地

GPT-3.5 Turbo 16K 以及 GPT-3.5 Turbo 4K、16K 微调的价格也都有一定程度的下降

那么大家目前如何使用 GPT-4 Turbo 呢?

所有付费开发者都可以通过 API 中的 gpt-4-1106-preview 来试用 GPT-4 Turbo

未来几周

OpenAI 将发布稳定的生产就绪(production-ready)模型

虽然新模型的发布令人激动

但是接下来这一发布

可能会令你联想到十几年前苹果的发布会

这也是众多网友认为的最大亮点

那就是Sam Atlman 发布了 GTPs

让用户们无需代码

结合自己的指令、外部知识和能力创建自定义版本的 ChatGPT

自从推出 ChatGPT 以来

用户们一直期待能够定制 ChatGPT

OpenAI 在 7 月推出了自定义指令

可让用户设置一些首选项

但是这无法完全满足用户

许多高级用户会维护一份提示和指令集列表

并将它们手动复制到 ChatGPT 中

GPTs 的发布能够自动帮用户们完成这项工作了

从现场展示来看,为了创建一个 GPT

OpenAI 允许用户使用一个名为 GPT Builder 的对话式 AI 模型

让用户使用自然语言就能构建自定义的 GPT

Sam Altman 现场展示了如何通过自然语言构建自定义 GPT

在这个例子中

Altman 要求 ChatGPT 创建一个可以给创业者提供建议的 GPT

在接收到指令后

ChatGPT 不仅构建了这个 GPT

还提供了头像、命名建议

除了使用内置功能之外

用户还可以通过向 GPT 提供一个或多个 API 来定义定制化 action

与插件一样

定制 action 允许 GPTs 集成外部数据或与现实世界交互

这个功能的目的非常简单

OpenAI要充分挖掘社区开发者的力量

Altman在会上说到

「我们相信最惊人的 GPT 产品将来自社区

无论您是教育家、教练

还是只是喜欢构建有用工具的人

您都不需要了解编码来制作工具并分享您的专业知识」

同时

OpenAI 也会在本月底上线 GPT Store

让开发者们分享、发布自己创建的 GPTs

没错,你是不是想到了苹果商店呢 ?

OpenAI 明确表示 GPT Store 上会有 GPT 的排行榜

活动上

Altman 表示 OpenAI 将向最常用、最有用的 GPT 支付收入的一部分

但是否会向发布 GPT 的创建者们收费还未知

目前

GPTs 可供 ChatGPT Plus 和企业用户试用

在大会上

OpenAI 工作人员现场演示了 GPTs的使用

她构建了一个能与个人行程表联通的 GPT

然后以对话的形式命令 GPT 给 Altman 发信息

结果 Altman 真的收到了

在 keynote 环节

Sam Altman 还发布了「Assistants API」,

这是他们帮助开发人员在自己的应用中构建类似「AI 智能体(agent)」体验的第一步

通俗点来说

「assistant」可以理解为一种为某个专门用途构建的 AI

它有特定的指令,利用额外的知识

并能调用模型和工具来执行任务

新的 Assistants API 提供了代码解释器(Code Interpreter)、检索(Retrieval)以及函数调用(function calling)等新功能

可以处理大量以前你需要自己完成的繁重工作

使你能够构建高质量的 AI 应用

这个 API 设计灵活

用例包括基于自然语言的数据分析应用、编码助手、AI 驱动的度假计划器、声控 DJ、智能可视画布等等

Assistants API 基于支持新 GPTs 产品的相同功能而构建

包括自定义指令和工具

比如代码解释器、检索和函数调用

这个 API 引入的一个关键变化是持久和无限长的线程

它允许开发人员将线程状态管理移交给 OpenAI

并绕过上下文窗口限制

使用 Assistants API

你只需将每条新消息添加到现有线程中即可

Assistants 还可根据需要调用新工具

包括代码解释器(Code Interpreter)

它可以在沙盒执行环境中编写和运行 Python 代码

并生成图形和图表

处理包含各种数据和格式的文件

它允许你的 assistants 反复运行代码

从而解决具有挑战性的代码和数学问题等

其次是检索(Retrieval)

它可以利用模型之外的知识

比如专有领域数据、产品信息或用户提供的文档

来增强 assistants

这意味着

你不需要计算和存储文档的嵌入

也不需要实现分块和搜索算法

Assistants API 会根据 OpenAI 在 ChatGPT 中构建知识检索的经验

优化要使用的检索技术

OpenAI 的工作人员现场演示了 Assistants API 的用法

它不仅能列出巴黎旅游建议

还能在地图上将计划中提到的地点按类别标记出来

此外Assistants API 还可以自动阅读文档、调用代码解释器来计算旅行开销

最后就是函数调用(Function calling)

它可以让助理能够调用你定义的函数

并将函数响应纳入其信息中

OpenAI 表示,与平台的其他部分一样

传给OpenAI API的数据和文件绝不会用于训练他们的模型

开发人员可以在他们认为合适的时候删除数据

开发者可以前往 Assistants playground 试用 Assistants API 测试版

无需编写任何代码

地址我会放到评论区中

从今天起

所有开发者都可以使用 Assistants API 测试版

相应的定价可以参考OpenAI官网信息

此外,这次大会还包括其他一些更新

首先是Copyright Shield

OpenAI表示

他们致力于通过系统中的内置版权保护措施来保护客户

所以推出了新的版权保护措施

copyright Shield

如果你面临有关版权侵权的法律索赔

他们将介入并且保护客户

并且支付由此产生的费用

这适用于ChatGPT 企业版

和我们的开发者平台的一般可用功能

其次是Whisper v3 和 Consistency Decoder

whisper呢是open AI开源的一款语音转文本的模型

在这次开发者大会上

Altman官宣了新的版本Whisper large-v3

它的特点呢

是提高了各种语言的识别性能

他们还计划在不久的将来

在API中支持whisper V3

此外呢他们还在开源consistency decoder

它是stable diffusion VAE解码器的直接替代品

这个解码器可以改进所有与 Stable Diffusion 1.0+ VAE 兼容的图像

并且呢在文本、人脸和直线方面有显著的改进

好了以上就是本次开发者大会中

OpenAI发布的精华内容

大家对于这次的发布会有什么看法呢

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- WebSocket协议、与HTTP对比

- 创造营第三十二天 | 122.买卖股票的最佳时机II ● 55. 跳跃游戏 ● 45.跳跃游戏II

- 【ZooKeeper高手实战】ZooKeeper 中的核心参数讲解

- SpringMVC实现原理及详解

- 汇编语言学习中的Dosbox自动配置方法

- Centos的网络配置

- PLC协议转BACnet网关BA107

- Beta sprint summary by FZU Flying Club_Beta Sprint

- Java(TM) Platform SE binary (Process Id: 4412)

- CAICT中国信通院:量子计算发展态势研究报告(2023年)