网站防御爬虫攻击有哪些方式

很多网站都深受爬虫困扰,网站在被爬虫大量抓取的的时候经常容易被爬虫把服务器资源抓崩了,有的时候,同行也会来爬取我们网站进行数据采集,影响我们站点的原创性,那么如何进行相对应的防护还是非常重要的!

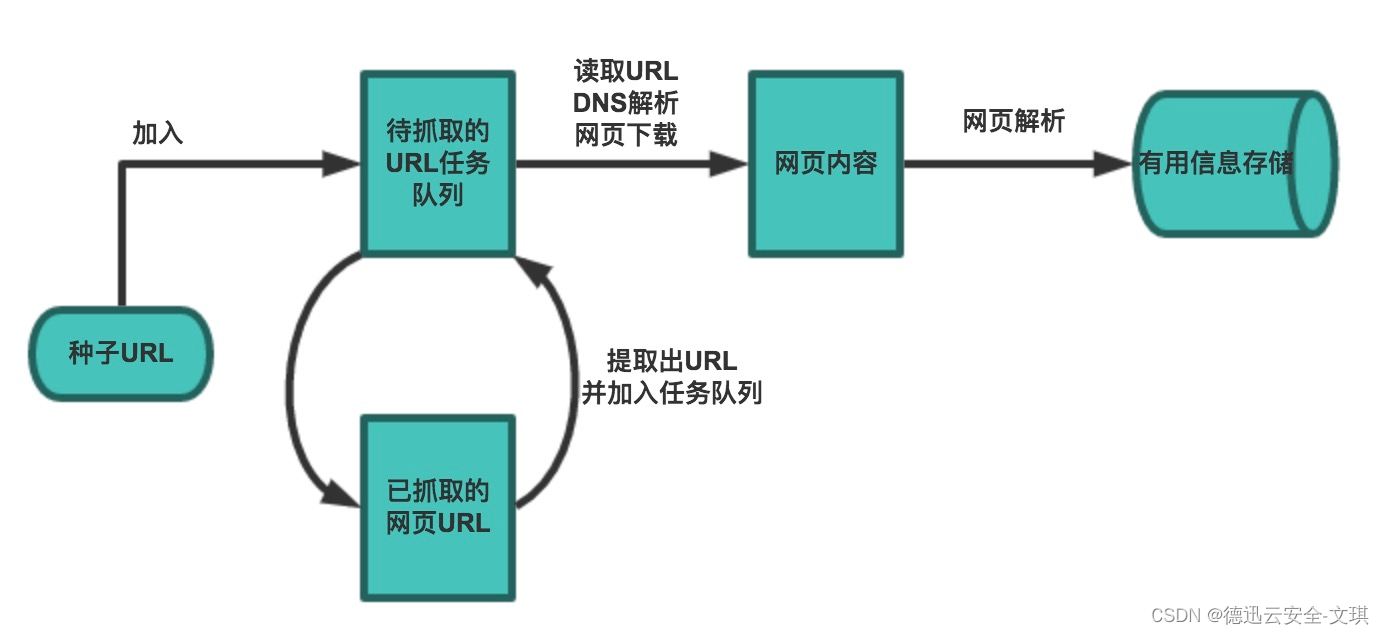

爬虫,也称为网络爬虫或网络机器人,是一种自动化的程序,用于在网络上抓取和收集数据。然而,一些恶意爬虫会利用这一机制,对目标网站进行大量的、非正常的访问,从而对网站服务器造成巨大的压力,甚至导致服务器瘫痪。此外,恶意爬虫还可能窃取敏感数据,对企业的信息安全构成威胁。

反爬机制主要有两大策略:

一、控制IP访问频率

最常见的基本都会使用代理IP来进行访问,但是对于一般人来说,几万ip差不多是极限了,所以一个ip还是可能多次请求。意味着爬虫需要付出更多的成本投入在IP资源上,IP越多,爬取的成本越高,自然容易劝退一部分人。

二、控制爬取策略

如果简单的只对目标数据进行爬取,反爬系统只要对访问情况和用户行为进行相关分析,其实很简单就能判定爬虫的那堆ip,你除了这堆数据什么都没访问,一看就不是正经用户。当然策略这个东西,就需要更多的博弈了。爬虫要增加迷惑度,需要去访问一些无关的东西,最后是研究正常用户的访问流程,然后模拟一遍。再者,控制速度。毕竟反爬系统的统计区间是肯定有限制的,不可能拿一个月的数据都分析一遍找出爬虫。反爬系统的存在,意义就在于增加这个成本。当然也需要衡量自身的成本,毕竟不能本末倒置,反爬成本太高就没价值了。

那网站一般用什么措施防范爬虫呢?主要有以下几种:

1.使用验证码机制

在登录、注册或搜索等重要操作时,引入验证码机制。验证码是一种动态生成的字符,用于验证用户是否为人类。通过在验证码中加入随机性和难以识别的字符,可以有效防止机器自动识别。

2.检测和限制访问频率

通过监控用户的访问频率和访问模式,可以识别出异常行为。一旦检测到异常,可以采取相应的措施,如暂时限制访问或发送警告信息。

3.使用IP黑白名单

对于已知的恶意IP地址,可以将其加入黑名单,禁止其对目标网站的访问。相反,对于可信任的IP地址,可以将其加入白名单,允许其对目标网站的访问。

4.检测和过滤恶意请求

通过分析用户请求的内容和特征,可以识别出恶意请求。例如,可以检测请求中是否包含大量的垃圾数据、是否包含特定的恶意关键词等。一旦检测到恶意请求,可以将其过滤掉或暂时限制其访问。

5.使用WAF(Web应用防火墙)

WAF是一种部署在网站服务器前的安全设备,可以检测和过滤恶意请求、防止常见的网络攻击等。通过配置相应的规则和策略,可以有效防御爬虫攻击。

使用WAF(Web应用防火墙)可以提供多层次的安全防护,是防御爬虫攻击的重要手段之一。WAF可以识别和过滤恶意请求、防止常见的网络攻击,并提供对HTTP协议的全面保护。通过配置相应的规则和策略,WAF可以识别并拦截恶意爬虫的访问,从而有效防止爬虫攻击对网站服务器造成的威胁。此外,WAF还可以提供实时监控和日志分析功能,帮助管理员及时发现和处理安全问题。因此,使用WAF是防御爬虫攻击的重要技术策略之一,可以有效提高网站的安全性和稳定性。

防御爬虫攻击是一项复杂而重要的任务,需要采取多种技术策略和管理措施,以确保网站的安全性和稳定性。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- go Swagger使用时生成 LeftDelim: “{{“,RightDelim: “}}“,问题

- Eclipse、IntelliJ IDEA、PyCharm三种IDE的区别

- 多级缓存架构(三)OpenResty Lua缓存

- 年底了,准备跳槽的可以看看...

- 【小沐学Python】Python实现通信协议(mqtt)

- 【LeetCode】20. 有效的括号(简单)——代码随想录算法训练营Day11

- Spring Boot测试 - JUnit整合及模拟Mvc

- 【CCF-A】中科院和国自然科学基金共同主办,IF稳定增长,国人占比高达96%

- 【jmeter】将上一个请求的结果作为下一个请求的参数

- 线性代数——(期末突击)行列式(下)-行列式按行展开、范德蒙行列式、克拉默法则