OpenShift 4 - 使用 Model Serving 运行模型

发布时间:2024年01月06日

《OpenShift / RHEL / DevSecOps 汇总目录》

说明:本文已经在 OpenShift 4.14 + RHODS 2.50 的环境中验证

说明:请先根据《OpenShift 4 - 部署 OpenShift AI 环境,运行 AI/ML 应用(视频)》一文完成 OpenShift AI 环境的安装。

注意:如无特殊说明,和 OpenShift AI 相关的 Blog 均无需 GPU。

什么是 Model Serving

Model Serving 是指将机器学习模型部署到生产环境中,以便实时处理和提供预测服务。在模型训练完成后,通常需要对其进行部署以供实际应用使用。

在 RHOAI 的 Model Serving 中包含了 Model Server 以及被运行的模型。

使用 Model Serving 运行模型

准备对象存储

请先根据《OpenShift 4 - 管理和使用 OpenShift AI 运行环境》一文安装 MinIO,并创建一个名为 rhoai-bucket 的存储桶。

生成模型文件

- 以一般用户在 RHOAI 控制台中创建名为 model-serving-demo 的 Data Science Projects 项目。

- 创建名为 model-serving-demo 的 Workbench,使用 Standard Data Science 镜像即可。

- 打开 Jupyter Notebook 界面,然后导入 https://github.com/RedHatQuickCourses/rhods-qc-apps.git。

- 在 Launch 界面中打开一个 Terminal,然后在其中执行以下命令。

(app-root) (app-root) pip install -r /opt/app-root/src/rhods-qc-apps/4.rhods-deploy/chapter2/requirements.txt

- 打开 rhods-qc-apps/4.rhods-deploy/chapter2/iris_to_onnx.ipynb 文件,然后在菜单中点击 Run > Run Selected Cells,完成执行后会生成 rf_iris.onnx 模型文件。

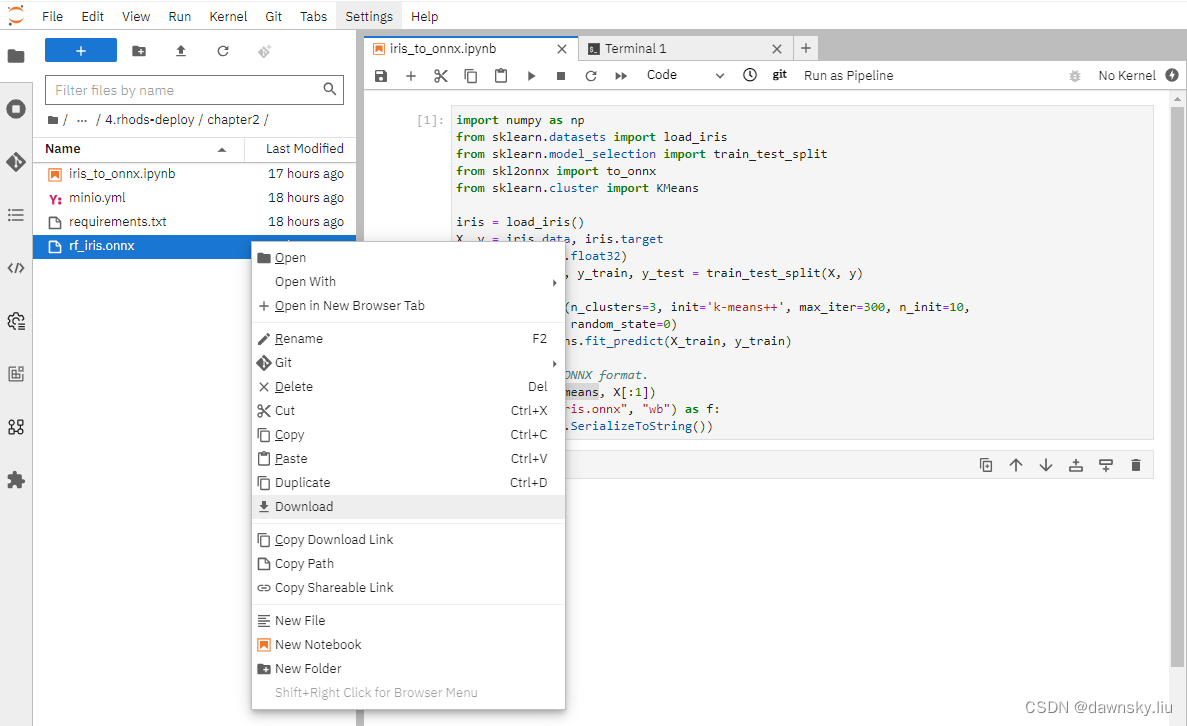

- 右键点击 rf_iris.onnx 文件,然后从菜单中使用 Download 下载文件到本地。

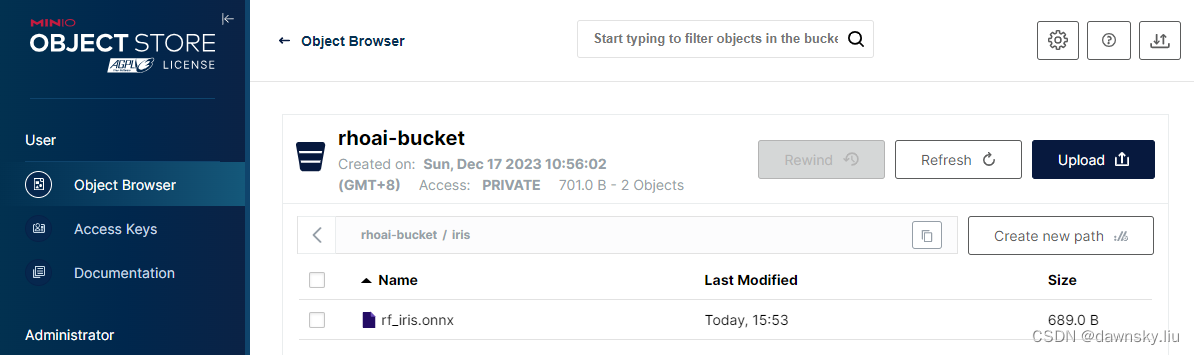

- 在 MinIO 控制台上将 rf_iris.onnx 文件上传到 rhoai-bucket/iris 路径下。

运行模型

配置 Data connection

- 在 RHOAI 控制台的 model-serving-demo 项目页面中点击 Add data connection 按钮。

- 按照下图配置将使用的数据链接,其中 Endpoint 填写的是名为 minio-api 的 route 地址。

运行模型服务器

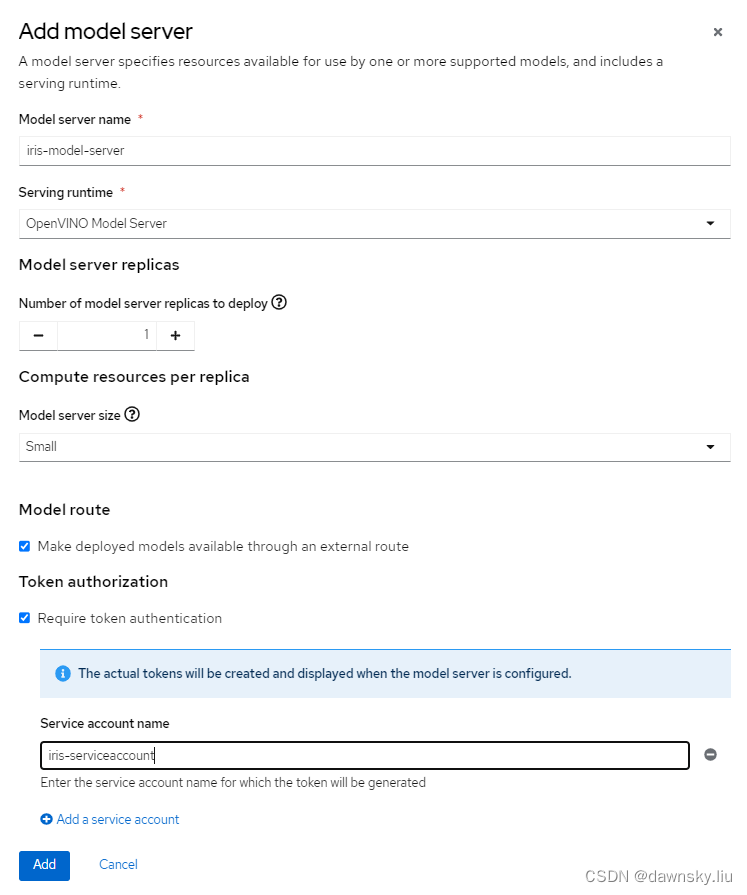

- 在 RHOAI 控制台的 model-serving-demo 项目页面中点击 Add model server 按钮。

- 按照下图配置要运行的模型服务器。

部署模型

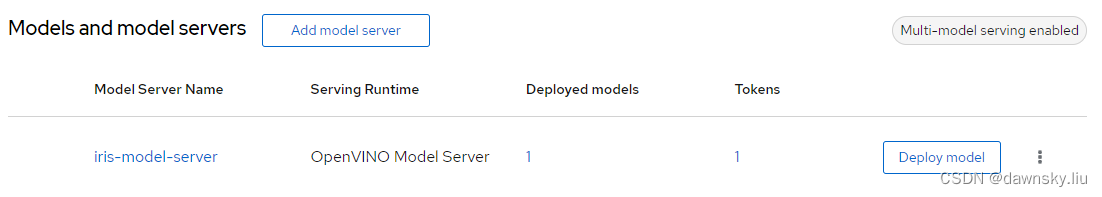

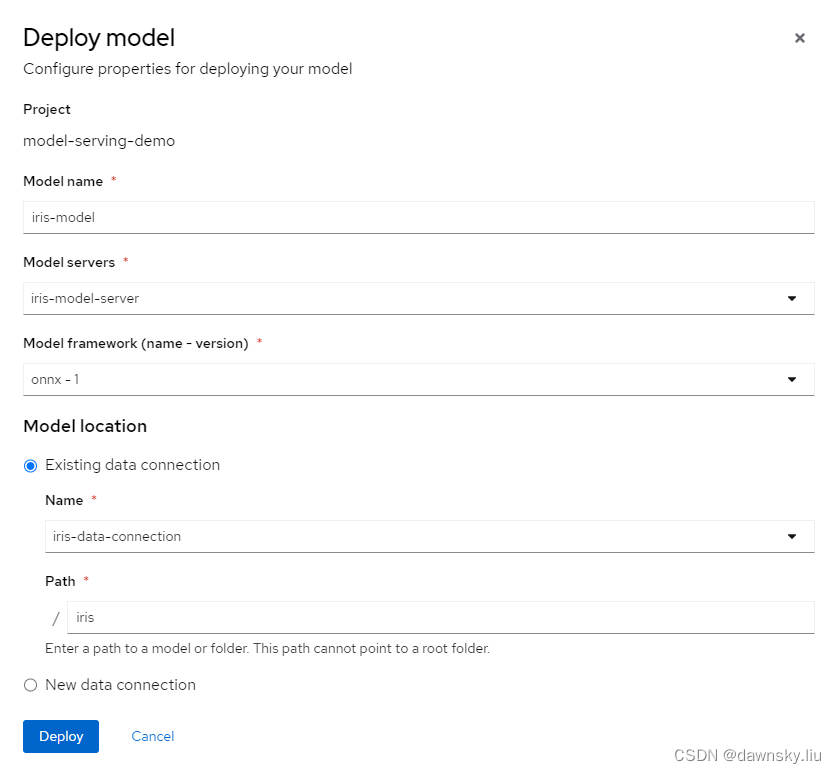

- 点击 iris-model-server 一行的右侧的 Deploy model 按钮。

- 按照下图配置要部署运行的模型。

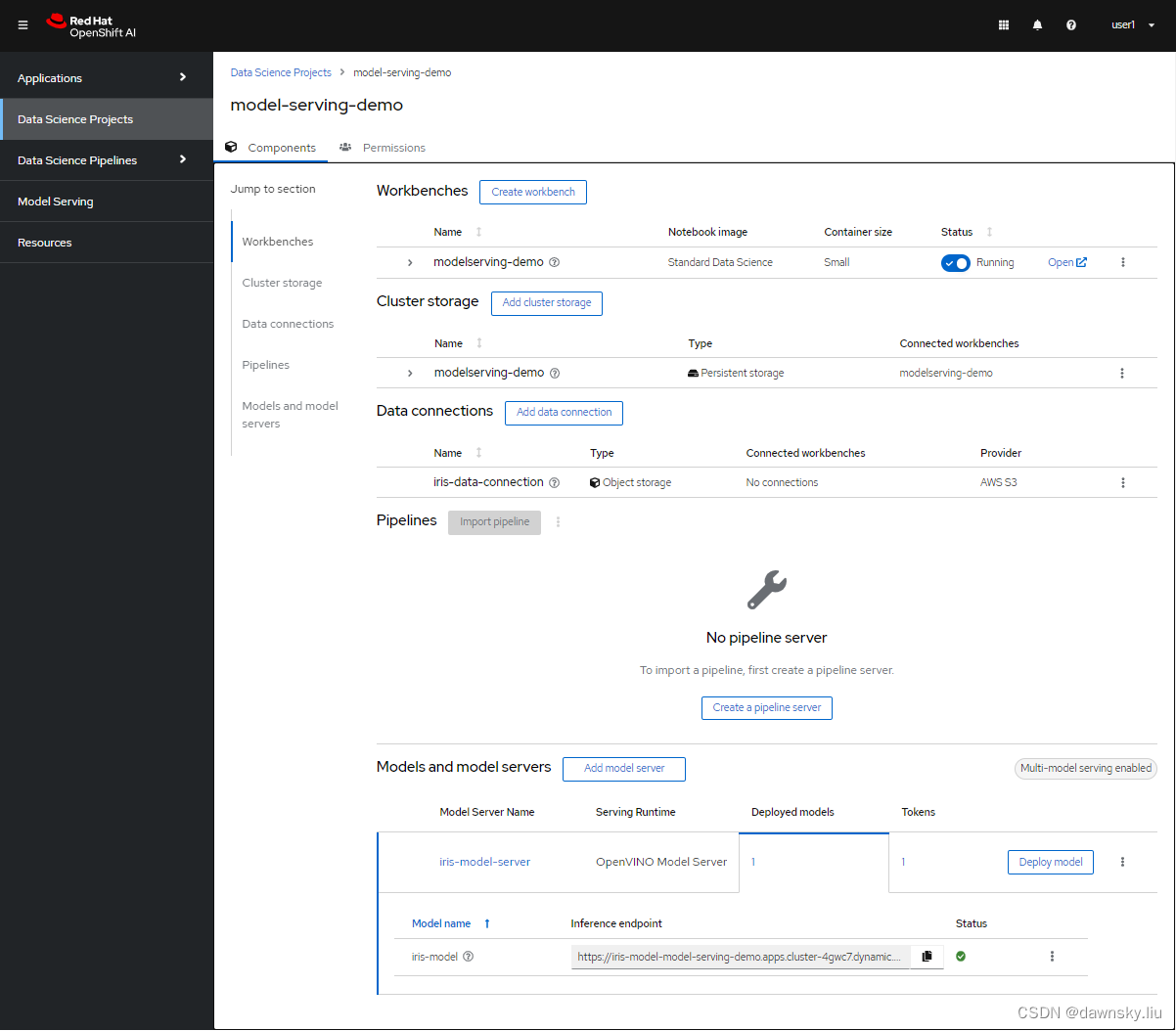

- 模型部署完成后在 RHOAI 的 model-serving-demo 项目将显示下图,其中模型 iris-mode 显示绿色 Loaded 状态。

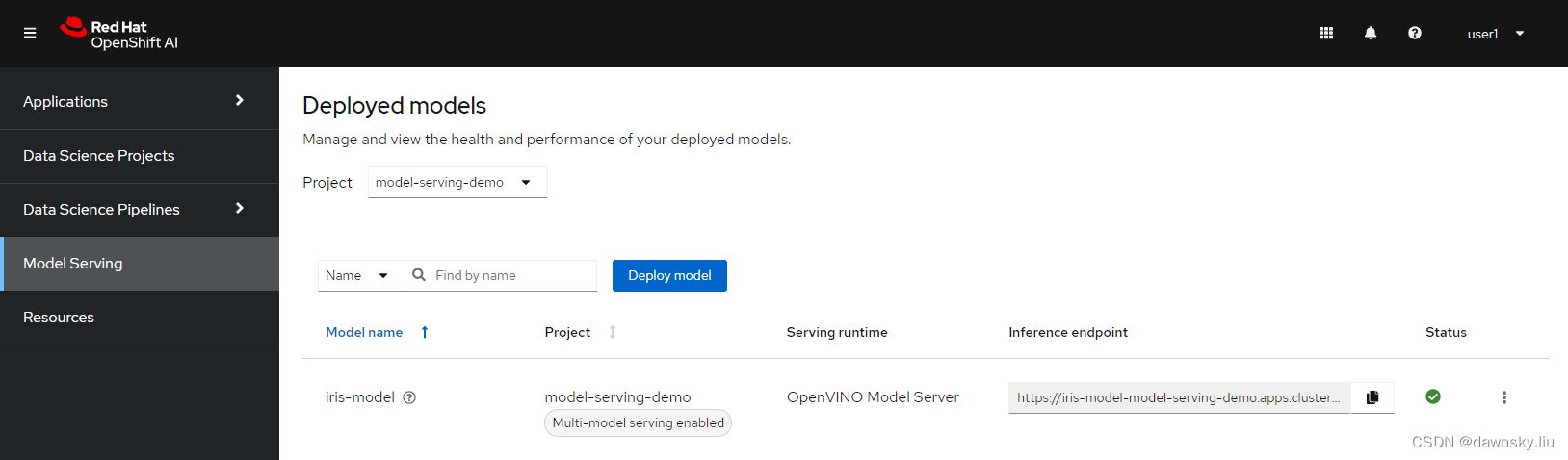

同时还可在 Model Serving 菜单中看到项目中已经部署运行的模型。

另外,还可在 OpenShift 的开发者视图里看到该项目中的和模型服务器相关的资源拓扑情况和运行状态。

测试访问模型

- 运行命令以下命令。

$ export IRIS_ROUTE=https://$(oc get routes -n model-serving-demo | grep iris-model | awk '{print $2}')/v2/models/iris-model/infer

$ export TOKEN=$(oc whoami -t)

- 向运行的模型发请求,并获得模型推理返回结果。

$ curl -s -H "Authorization: Bearer $TOKEN" $IRIS_ROUTE -X POST --data '{"inputs" : [{"name" : "X","shape" : [ 1, 4 ],"datatype" : "FP32","data" : [ 3, 4, 3, 2 ]}],"outputs" : [{"name" : "output0"}]}' | jq

{

"model_name": "iris-model__isvc-4e49574209",

"model_version": "1",

"outputs": [

{

"name": "label",

"datatype": "INT64",

"shape": [

1

],

"data": [

0

]

},

{

"name": "scores",

"datatype": "FP32",

"shape": [

1,

3

],

"data": [

3.1270404,

3.4207978,

4.8063498

]

}

]

}

参考

https://redhatquickcourses.github.io/rhods-deploy/rhods-deploy/1.33/index.html

文章来源:https://blog.csdn.net/weixin_43902588/article/details/135110024

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- openCV图像SIFT特征

- dp专题13 零钱兑换II

- CTF-PWN-栈溢出-初级ROP-【ret2libc】

- Matlab实现SMA-KELM| 黏菌优化算法优化核极限学习机分类预测

- Html转PDF,前端JS实现Html页面导出PDF(html2canvas+jspdf)

- springBoot如何动态切换数据源

- 翻译: Pyenv管理Python版本从入门到精通一

- 【PTA-C语言】编程练习5 - 函数与指针

- 讲解Ajax和axios相关知识

- kotlin by lazy 的使用