使用Triton部署ONNX模型

介绍

适用于各种 AI 工作负载的推理:借助 NVIDIA Triton?,在任何处理器(GPU、CPU 或其他)上,对使用基于任何框架的,经过训练的机器学习模型或深度学习模型,进行推理部署。Triton 是 NVIDIA AI 平台的一部分,可通过 NVIDIA AI Enterprise 获取。这款开源软件可针对各种工作负载,实现标准化的 AI 模型部署和执行。

优势

支持所有训练和推理框架:使用 Triton,部署基于任何主流框架的 AI 模型,包括 TensorFlow,PyTorch,Python,ONNX,NVIDIA? TensorRT?、RAPIDS? cuML,XGBoost,scikit-learn RandomForest,OpenVINO,C++ 自定义框架等。

可在任何平台上实现高性能推理:借助动态批处理、并发执行、最佳模型配置,音视频串流输入支持,最大限度地提升吞吐量和资源利用率。Triton 支持所有 NVIDIA GPU,x86 和 Arm? 架构 CPU 以及 AWS Inferentia。

专为 DevOps 和 MLOps 设计的开源软件:可将 Triton 集成到 DevOps 和 MLOps 解决方案中,例如集成到 Kubernetes 实现规模化,或集成到 Prometheus 进行监测。Triton 也可以通过所有主流云平台、本地 AI 平台和 MLOps 平台获取。

企业级安全性、可管理性和 API 稳定性:NVIDIA AI Enterprise(包括 NVIDIA Triton 和 Triton Management Service),是一个安全的、生产就绪型的 AI 软件平台,提供支持、安全性和 API 稳定性,帮助企业加速开发 AI,实现收益。

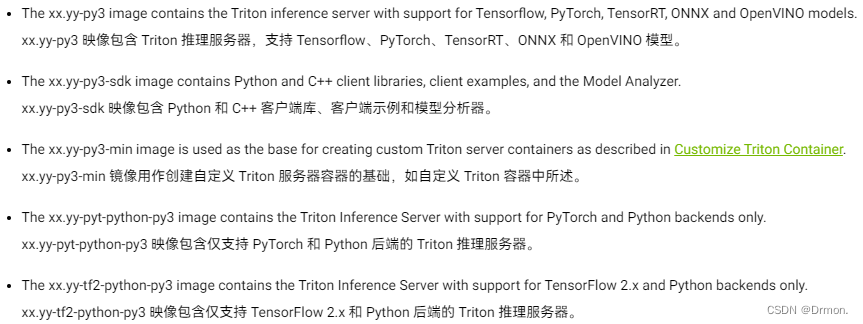

镜像介绍

部署ONNX模型

将onnx模型按照 base_path /model_name / version / model.onnx 的模式放入指定文件夹中,onnx模型可以不指定config.pbtxt。

在nvidia-Triton官方文档中根据CUDA和Ubuntu版本选择合适的镜像,CUDA版本需要不大于系统安装的CUDA版本。

运行指令创建Triton推理容器

$ docker run --gpus=1 --rm -p8000:8000 -p8001:8001 -p8002:8002 -v/full/path/to/docs/examples/model_repository:/models nvcr.io/nvidia/tritonserver:<xx.yy>-py3 tritonserver --model-repository=/models

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Rocky Linux 9.3 安装 MinIO 最新版本 (超级详细版本)

- 【Chemokine : IL-8, PF4 ; SCF ; VEGF 】

- 地图自定义省市区合并展示数据整合

- ZZ014城市轨道交通运营与维护赛题第8套

- 力扣第236题——二叉树的最近公共祖先 (C语言题解)

- abaqus复合材料建模技术与应用

- JavaScript中实现页面跳转的多种方法【通俗易懂】

- Turtle绘制菱形-第11届蓝桥杯选拔赛Python真题精选

- 线性表:顺序表的实现以及遍历扩容

- 【03】GeoScene创建海图或者电子航道图数据