伪装实例分割模型:OSFormer模型及论文解析

论文:https://arxiv.org/pdf/2207.02255.pdf

代码:https://github.com/pjlallen/osformer

1. 摘要

我们推出OSFormer,这是第一个用于伪装实例分割 (CIS) 的单级 Transformer框架。OSFormer 基于两个关键设计。首先,我们设计了一个位置感知变压器(LST),通过引入位置引导查询和混合卷积前馈网络来获取位置标签和实例感知参数。其次,我们开发了一种从粗到细的融合(CFF)来合并来自LST编码器和CNN主干的不同上下文信息。将这两个组件耦合起来使 OSFormer 能够有效地混合本地特征和远程上下文依赖关系以预测伪装实例。与两阶段框架相比,我们的OSFormer 达到了41% AP,并实现了良好的收敛效率,而无需大量训练数据,即 60个epoch下仅需要3040个样本。

2.主要贡献

1.我们提出了OSFormer,这是第一个基于变压器的单级框架,专为伪装实例分割任务而设计,它是一个灵活的框架,可以以端到端的方式进行训练。

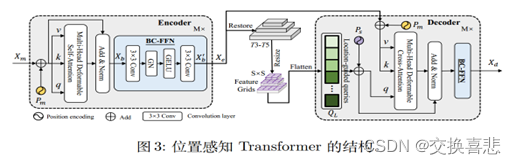

2.提出了一个位置感知变压器来动态捕获不同位置的实例线索,我们的LST包含一个带有混合卷积前馈网络的编码器,用于提取多尺度局部特征,以及一个带有建议的位置引导查询的编码器,以带来实例感知嵌入,所提出的LST结构在有限的训练数据下快速收敛。

3.提出了一种新颖的从粗到细的融合(CFF),通过融合来自骨干网和LST块的多尺度低级和高级特征来获得高分辨率掩模特征。在该模块中,嵌入了反向边缘注意(REA)来突出伪装实例的边缘信息。

4.大量实验表明,OSFormer 在具有挑战性的CIS任务中表现良好,大幅优于11种流行的实例分割方法,例如,在COD10K 测试集上AP提高了8.5%。

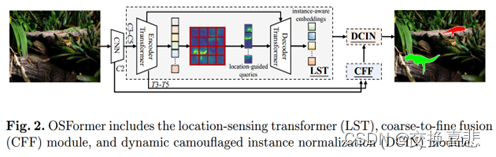

3.模型图

4.方法

代码结构

1.用于提取对象特征表示的CNN主干

2.采用全局特征和位置引导查询来生成实例感知嵌入的位置感知转换器(LST)

3.粗到精融合,用于集成多尺度低级和高级特征并产生高分辨率掩膜特征.(CFF)

4.动态伪装实例归一化,用于预测最终实例掩码。(DCIN)

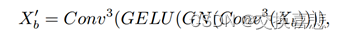

将CNN提取出来的多尺度特征,C3、C4、C5展平并串联成一个具有256通道的序列Xm,将这三个特征输入到LST编码器,C2直接输入到CFF中(将其作为高分辨率的低级特征输入到CFF模块)。然后第二部分,引入混合卷积前馈网络(BC-FFN),该网络只有两个卷积层:

LST编码器层的描述如下:

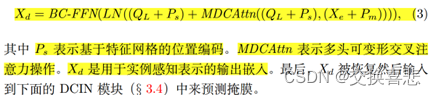

Pm位置编码,多头可变形注意力和层归一化。

然后就是我不太能看懂的位置引导Queries:

主旨就是query是transformer架构中很关键的结构,用作解码器的输入,并通过解码器进行输出嵌入。参考DETR,query的零初始化是其收敛缓慢的原因,借鉴了SOLO模型的启发,将特征图(T3-T5)调整,然后将特征划分为S2个网络,然后展平来产生位置引导。

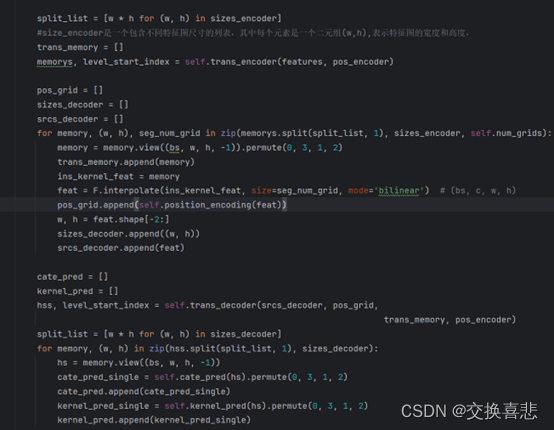

在osformer.py的CISTransformer中

然后就是LST解码器:

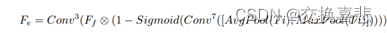

CFF是说将C2,T3,T4,T5作为级联融合的输入。从输入的1/32尺度的T5开始,通过3 × 3卷积、GN和2×的双线性上采样,并加入更高分辨率的特征(1/16 比例的 T4)。在以 1/4 的尺度融合C2后,特征通过1 × 1的卷积、GN和RELU操作,生成掩膜特征 F。另外考虑到边缘特征难以捕捉,还引入了反向边缘注意力模块,在迭代过程中监督边缘特征:

收到CBAM的启发,将最后的共享掩膜特征Fe输入到DCIN预测最终的每一个伪装实例掩膜:

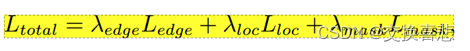

损失函数:

5.结果/发现

本文为伪装实例分割(CIS)贡献了一个全新的位置感知的单阶段的Transformer模型,称为OSFormer,OSFormer包含了一个高效的位置感知Transformer,以捕捉全局特征并动态回归伪装实例的位置和形状,作为第一个自上而下的单阶段CIS框架,模型还嵌入了一个由粗到细的融合模块,以整合多尺度特征并突出伪装的边缘,并输出全局特征,大量的实验结果表明,OSFormer的性能优于目前其他知名的模型,此外,OSFormer只需要训练3000张图像,并且收敛迅速,它还可以被灵活地扩展到其他具有较少训练样本的下游视觉任务。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!