springboot集成Elk做日志系统

?一、ELK 介绍

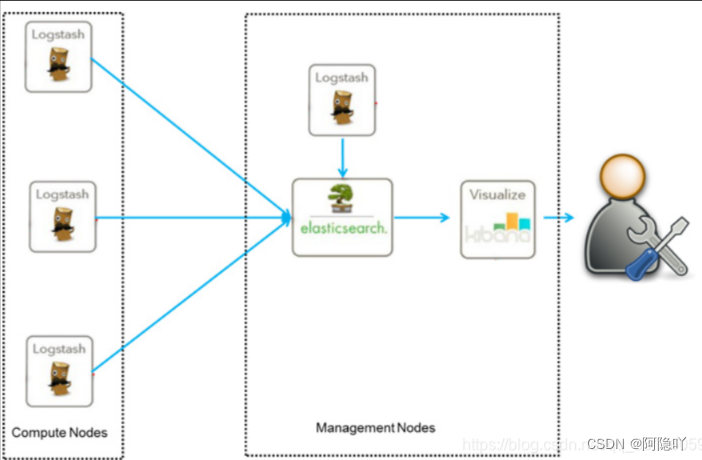

ELK是三个开源软件的缩写,分别表示:elasticsearch、logstash、kibanaElasticsearch、Logstash、Kibana作用:

Elasticsearch: 是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等 ,用于存储日志信息

Logstash: 日志收集,springboot利用Logstash把日志发送个Logstash,然后Logstash将日志传递给Elasticsearch。

Kibana:通过web端对日志进行可视化操作

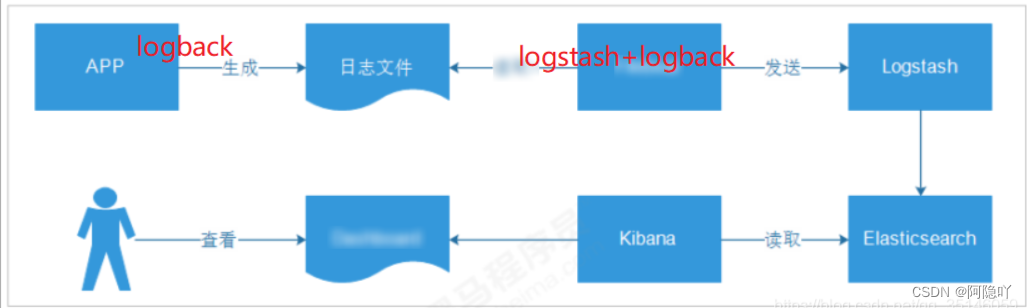

二、本次采用实现日志收集的方案

logback产生日志->logstash->elasticsearch->kibana

?

优点:

? 此架构搭建简单,容易上手

缺点:

1、每个节点部署logstash,运行时占用CPU,内存大,会对节点性能造成一定的影响

? 2、没有将日志数据进行缓存,存在丢失的风险

三、ELK的安装

windows 安装 ELK(Elasticsearch,Logstash,kibana)

下载相应软件包:

Elasticsearch 下载:https://www.elastic.co/downloads/elasticsearch

Logstash 下载:https://www.elastic.co/downloads/logstash

kibana 下载:https://www.elastic.co/downloads/kibana

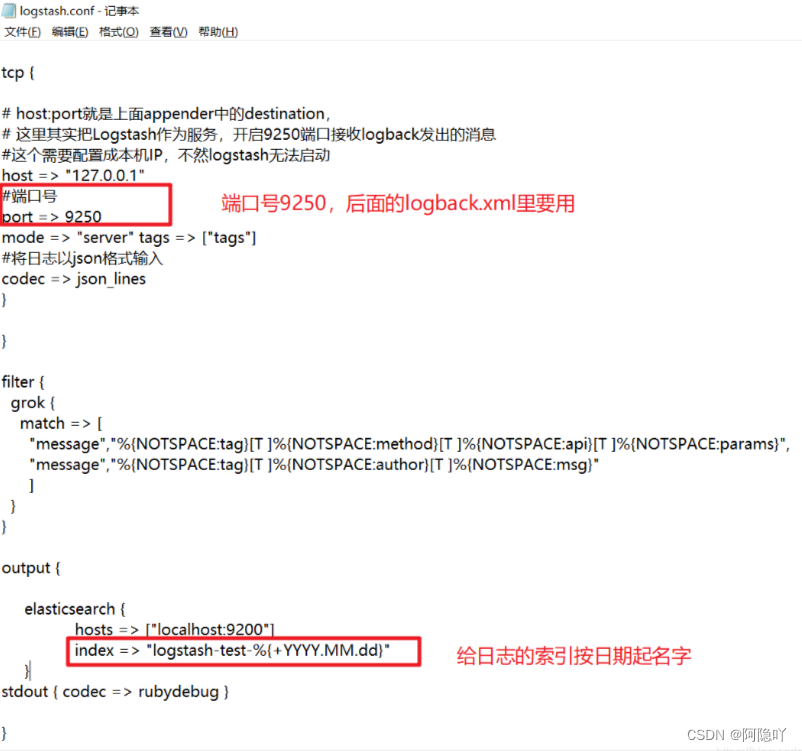

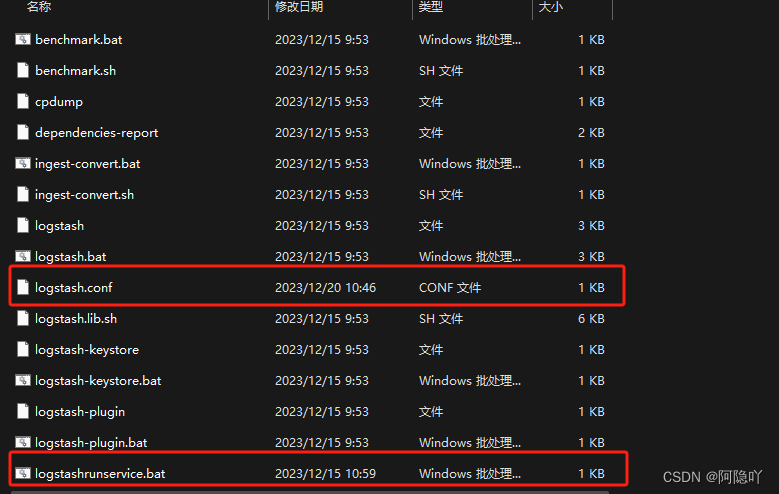

重点讲一下logstash的安装

首先在 logstash的bin目录下 新建一个 logstash.conf 文件

input {

# stdin { }

tcp {

# host:port就是上面appender中的destination,

# 这里其实把Logstash作为服务,开启9250端口接收logback发出的消息

#这个需要配置成本机IP,不然logstash无法启动

host => "127.0.0.1"

#端口号

port => 9250

mode => "server" tags => ["tags"]

#将日志以json格式输入

codec => json_lines

}

}

filter {

grok {

match => [

"message","%{NOTSPACE:tag}[T ]%{NOTSPACE:method}[T ]%{NOTSPACE:api}[T ]%{NOTSPACE:params}",

"message","%{NOTSPACE:tag}[T ]%{NOTSPACE:author}[T ]%{NOTSPACE:msg}"

]

}

}

output {

elasticsearch {

hosts => ["localhost:9200"]

index => "logstash-test-%{+YYYY.MM.dd}"

}

stdout { codec => rubydebug }

}

然后在新建一个文件 logstashrunservice.bat

输入logstash.bat -f logstash.conf 并保存

logstash.bat -f logstash.conf

至此logstash安装完成,elasticsearch和kibana的安装比较简单,此处不多加赘述。

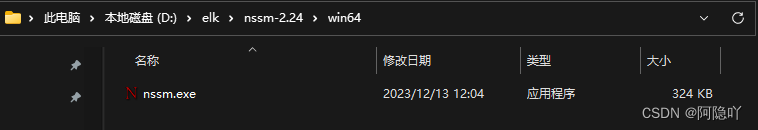

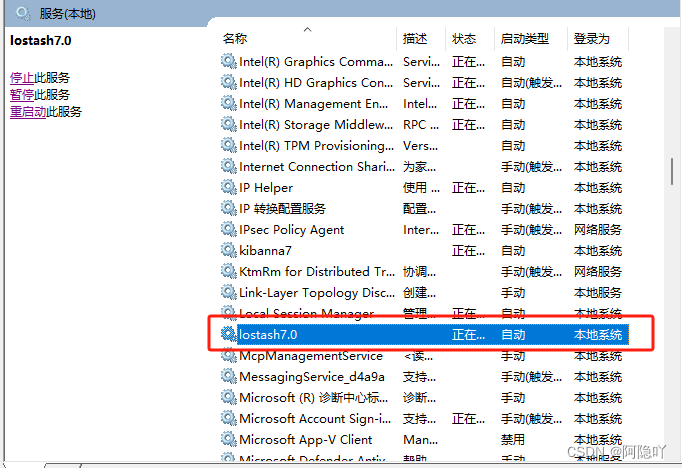

使用 NSSM 软件 将 Elasticsearch,Logstash,kibana 都安装成windows服务

下载NSSM: http://www.nssm.cc/download

下载后解压到文件夹

此处还是以logstash为例进行安装服务,elasticsearch和kibana的安装一样。

将cmd 当前所在目录设置到 nssm.exe 的目录下运行 nssm install

nssm install

单击 install service 就可以了。

服务安装成功之后,在浏览器中输入对应的地址即刻查看安装是否成功

在浏览器中输入?http://127.0.0.1:9200?访问elasticsearch

在浏览器中输入?http://127.0.0.1:9600 访问logstash

在浏览器中输入?http://127.0.0.1:5601 访问kibana

四、Spring Boot 搭建 ELK正确看日志的配置流程(logback)

1.系统中添加依赖

maven版本

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>6.6</version>

</dependency>

2.系统中logback.xml的配置

让logback的日志输出到logstash

<configuration>

<!-- %m输出的信息, %p日志级别, %t线程名, %d日期, %c类的全名, %i索引 -->

<!-- appender是configuration的子节点,是负责写日志的组件 -->

<!-- ConsoleAppender把日志输出到控制台 -->

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder>

<pattern>%date{yyyy-MM-dd HH:mm:ss} %highlight(%-5level) (%file:%line\)- %m%n</pattern>

<!-- 控制台也要使用utf-8,不要使用gbk -->

<charset>UTF-8</charset>

</encoder>

</appender>

<!-- RollingFileAppender:滚动记录文件,先将日志记录到指定文件,当符合某个条件时,将日志记录到其他文件 -->

<!-- 1.先按日期存日志,日期变了,将前一天的日志文件名重命名为xxx%日期%索引,新的日志仍然是sys.log -->

<!-- 2.如果日期没有变化,但是当前日志文件的大小超过1kb时,对当前日志进行分割 重名名 -->

<appender name="syslog" class="ch.qos.logback.core.rolling.RollingFileAppender">

<File>log/ant-back.log</File>

<!-- rollingPolicy:当发生滚动时,决定 RollingFileAppender 的行为,涉及文件移动和重命名。 -->

<!-- TimeBasedRollingPolicy: 最常用的滚动策略,它根据时间来制定滚动策略,既负责滚动也负责出发滚动 -->

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!-- 活动文件的名字会根据fileNamePattern的值,每隔一段时间改变一次 -->

<!-- 文件名:log/sys.2017-12-05.0.log -->

<fileNamePattern>log/ant-back.%d.%i.log</fileNamePattern>

<!-- 每产生一个日志文件,该日志文件的保存期限为120天 -->

<maxHistory>120</maxHistory>

<timeBasedFileNamingAndTriggeringPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedFNATP">

<!-- maxFileSize:这是活动文件的大小,默认值是10MB,本篇设置为100MB -->

<maxFileSize>100MB</maxFileSize>

</timeBasedFileNamingAndTriggeringPolicy>

</rollingPolicy>

<encoder>

<!-- pattern节点,用来设置日志的输入格式 -->

<pattern>

%d %p (%file:%line\)- %m%n

</pattern>

<!-- 记录日志的编码 -->

<charset>UTF-8</charset>

</encoder>

</appender>

<!-- 控制台日志输出级别 -->

<!-- <root level="info">

<appender-ref ref="STDOUT"/>

</root>-->

<!-- 指定项目中某个包,当有日志操作行为时的日志记录级别 -->

<!-- com.example.ant为根包,也就是只要是发生在这个根包下面的所有日志操作行为的权限都是DEBUG -->

<!-- 级别依次为【从高到低】:FATAL > ERROR > WARN > INFO > DEBUG > TRACE -->

<!--<logger name="com.example.ant" level="FATAL">

<appender-ref ref="syslog"/>

</logger>-->

<!-- 为logstash输出的JSON格式的Appender -->

<appender name="logstash"

class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<!--可以访问的logstash日志收集端口-->

<destination>127.0.0.1:9250</destination>

<!-- 日志输出编码 -->

<encoder

class="net.logstash.logback.encoder.LoggingEventCompositeJsonEncoder">

<providers>

<timestamp>

<timeZone>UTC</timeZone>

</timestamp>

<pattern>

<pattern>

{

"thread": "%thread",

"logLevel": "%level",

"message": "%message",

"class": "%logger{40}",

"serviceName": "${springAppName:-}",

"trace": "%X{X-B3-TraceId:-}",

"span": "%X{X-B3-SpanId:-}",

"exportable": "%X{X-Span-Export:-}",

"pid": "${PID:-}"

}

</pattern>

</pattern>

</providers>

</encoder>

</appender>

<!-- 日志输出级别 -->

<root level="INFO">

<appender-ref ref="STDOUT"/>

<appender-ref ref="logstash" />

</root>

</configuration>

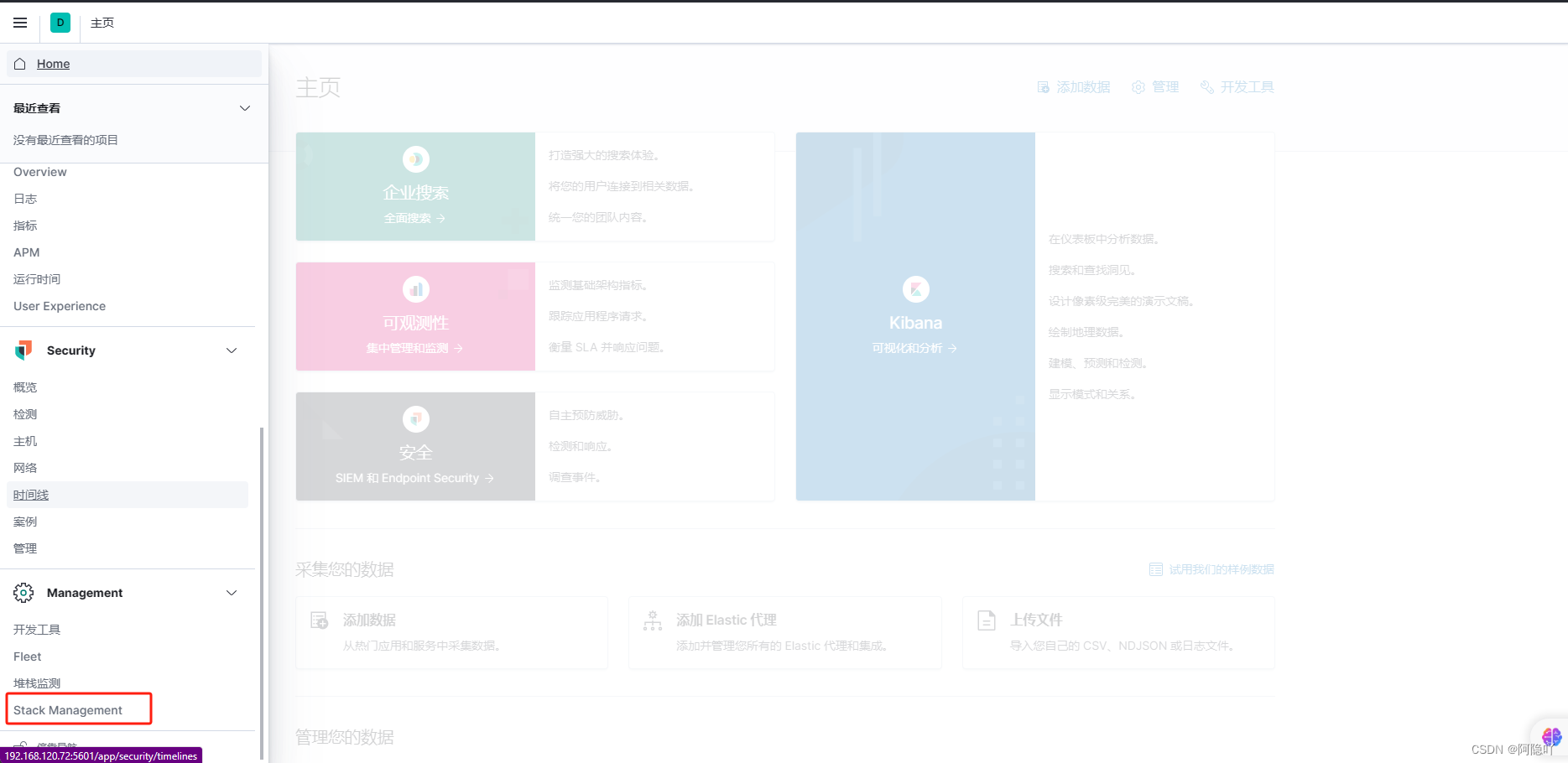

3.Kibana的使用

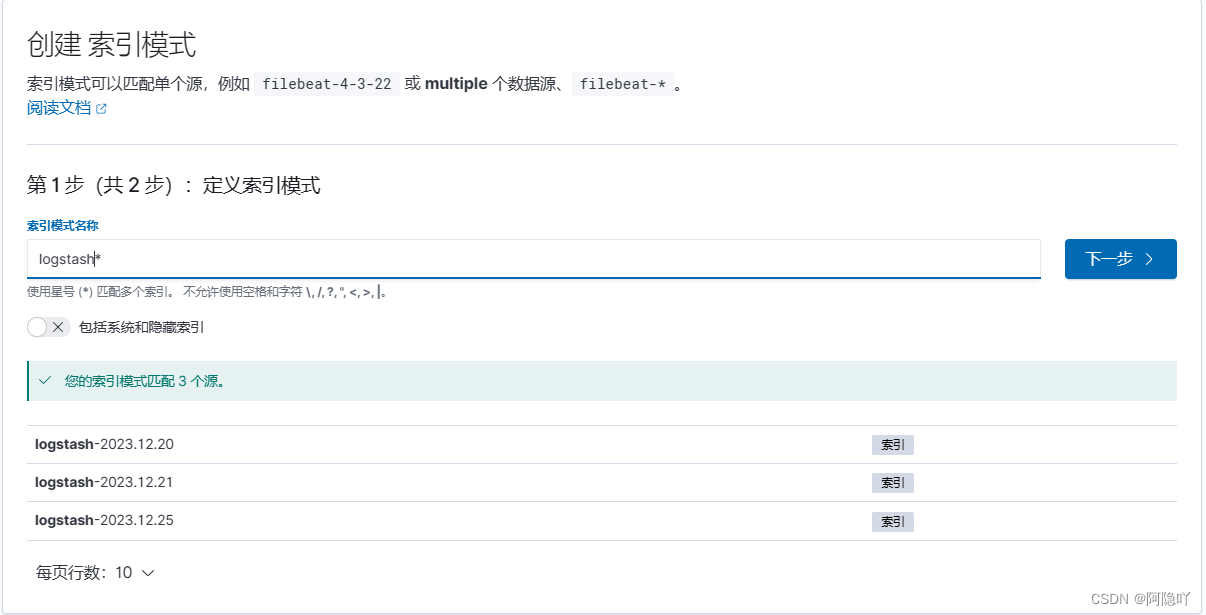

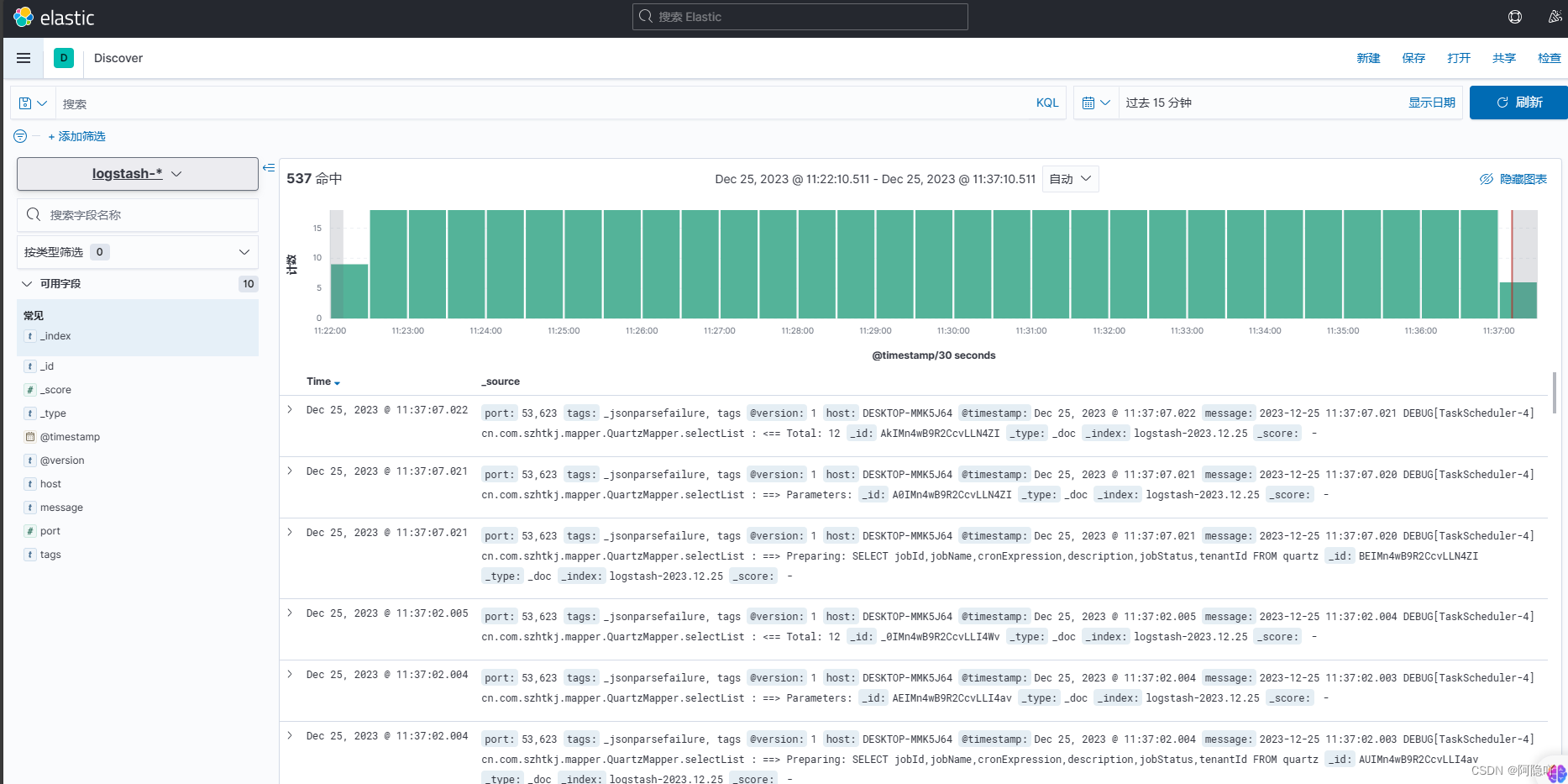

重启自己本地的项目,去浏览器的ELk中建立索引,查看刚才从系统中导入logstash的日志

3.1、建立索引模式

索引模式创建完成,如何查看日志呢?

索引模式创建完成,如何查看日志呢?

五、Spring Boot 搭建 ELK正确看日志的配置流程(log4j)

pom依赖

需要将starter和stater-web中引入的log包排除,再引入log4j2依赖包

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter</artifactId>

<version>2.1.5.RELEASE</version>

<exclusions>

<exclusion>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-logging</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

<version>2.1.5.RELEASE</version>

<exclusions>

<exclusion>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-logging</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-log4j2</artifactId>

<version>2.1.5.RELEASE</version>

</dependency>

配置文件修改

log4j2.xml配置文件中内容

<?xml version="1.0" encoding="UTF-8"?>

<!-- Configuration后面的status,这个用于设置log4j2自身内部的信息输出,可以不设置,

当设置成trace时,可以看到log4j2内部各种详细输出

-->

<!-- monitorInterval:Log4j能够自动检测修改配置 文件和重新配置本身,设置间隔秒数 -->

<configuration monitorInterval="5">

<!-- 日志级别以及优先级排序: OFF > FATAL > ERROR > WARN > INFO > DEBUG > TRACE > ALL -->

<!-- 变量配置 -->

<Properties>

<!--

格式化输出:

%d表示日期,

%thread表示线程名,

%-5level:级别从左显示5个字符宽度

%msg:日志消息,%n是换行符

%logger{36} 表示 Logger 名字最长36个字符

-->

<property name="LOG_PATTERN" value="%d{yyyy-MM-dd HH:mm:ss.SSS} %highlight{%-5level}[%thread] %style{%logger{36}}{cyan} : %msg%n" />

<!-- 定义日志存储的路径,不要配置相对路径 -->

<property name="FILE_PATH" value="./logs" />

<!-- 服务名 -->

<property name="FILE_NAME" value="order-service" />

</Properties>

<appenders>

<console name="Console" target="SYSTEM_OUT">

<!--输出日志的格式-->

<PatternLayout pattern="${LOG_PATTERN}" disableAnsi="false" noConsoleNoAnsi="false"/>

<!--控制台只输出level及其以上级别的信息(onMatch),其他的直接拒绝(onMismatch)-->

<ThresholdFilter level="info" onMatch="ACCEPT" onMismatch="DENY"/>

</console>

<!--

这个会打印出所有的info及以下级别的信息,每次大小超过size,

则这size大小的日志会自动存入按年份-月份建立的文件夹下面并进行压缩,作为存档

-->

<RollingFile name="RollingFileInfo"

fileName="${FILE_PATH}/info.log"

filePattern="${FILE_PATH}/$${date:yyyy-MM}/${FILE_NAME}-%d{yyyy-MM-dd}-INFO_%i.log.gz">

<!--控制台只输出level及以上级别的信息(onMatch),其他的直接拒绝(onMismatch)-->

<ThresholdFilter level="info" onMatch="ACCEPT" onMismatch="DENY"/>

<PatternLayout pattern="${LOG_PATTERN}"/>

<Policies>

<!--interval属性用来指定多久滚动一次,默认是1 hour-->

<TimeBasedTriggeringPolicy interval="1"/>

<SizeBasedTriggeringPolicy size="20MB"/>

</Policies>

<!-- DefaultRolloverStrategy属性如不设置,则默认为最多同一文件夹下7个文件开始覆盖 -->

<DefaultRolloverStrategy max="15"/>

</RollingFile>

<!-- 这个会打印出所有的warn及以下级别的信息,每次大小超过size,则这size大小的日志会自动存入按年份-月份建立的文件夹下面并进行压缩,作为存档-->

<RollingFile name="RollingFileWarn"

fileName="${FILE_PATH}/warn.log"

filePattern="${FILE_PATH}/$${date:yyyy-MM}/${FILE_NAME}-%d{yyyy-MM-dd}-WARN_%i.log.gz">

<!--控制台只输出level及以上级别的信息(onMatch),其他的直接拒绝(onMismatch)-->

<ThresholdFilter level="warn" onMatch="ACCEPT" onMismatch="DENY"/>

<PatternLayout pattern="${LOG_PATTERN}"/>

<Policies>

<!--interval属性用来指定多久滚动一次,默认是1 hour-->

<TimeBasedTriggeringPolicy interval="1"/>

<SizeBasedTriggeringPolicy size="20MB"/>

</Policies>

<!-- DefaultRolloverStrategy属性如不设置,则默认为最多同一文件夹下7个文件开始覆盖-->

<DefaultRolloverStrategy max="15"/>

</RollingFile>

<!-- 这个会打印出所有的error及以下级别的信息,每次大小超过size,则这size大小的日志会自动存入按年份-月份建立的文件夹下面并进行压缩,作为存档-->

<RollingFile name="RollingFileError"

fileName="${FILE_PATH}/error.log"

filePattern="${FILE_PATH}/$${date:yyyy-MM}/${FILE_NAME}-%d{yyyy-MM-dd_HH}-ERROR_%i.log.gz">

<!--控制台只输出level及以上级别的信息(onMatch),其他的直接拒绝(onMismatch)-->

<ThresholdFilter level="error" onMatch="ACCEPT" onMismatch="DENY"/>

<PatternLayout pattern="${LOG_PATTERN}"/>

<Policies>

<!--interval属性用来指定多久滚动一次,默认是1 hour-->

<TimeBasedTriggeringPolicy interval="1"/>

<SizeBasedTriggeringPolicy size="20MB"/>

</Policies>

<!-- DefaultRolloverStrategy属性如不设置,则默认为最多同一文件夹下7个文件开始覆盖-->

<DefaultRolloverStrategy max="15"/>

</RollingFile>

<Socket name="logstash" host="192.168.120.72" port="9250" protocol="TCP">

<PatternLayout pattern="${LOG_PATTERN}"/>

</Socket>

</appenders>

<!--Logger节点用来单独指定日志的形式,比如要为指定包下的class指定不同的日志级别等。-->

<!--然后定义loggers,只有定义了logger并引入的appender,appender才会生效-->

<loggers>

<!--过滤掉spring和mybatis的一些无用的DEBUG信息-->

<logger name="org.mybatis" level="info" additivity="false">

<AppenderRef ref="Console"/>

</logger>

<!--监控系统信息-->

<!--若是additivity设为false,则 子Logger 只会在自己的appender里输出,而不会在 父Logger 的appender里输出。-->

<Logger name="top.fate" level="info" additivity="false">

<AppenderRef ref="Console"/>

</Logger>

<root level="info">

<appender-ref ref="Console"/>

<appender-ref ref="RollingFileInfo"/>

<appender-ref ref="RollingFileWarn"/>

<appender-ref ref="RollingFileError"/>

<appender-ref ref="logstash"/>

</root>

</loggers>

</configuration>本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- unity学习笔记

- Prometheus实战篇:Prometheus监控redis

- RIP复习实验

- 干洗店洗鞋店小程序核心功能有哪些?

- 【软考中级-软件设计师】day4:数据结构-线性表、单链表、栈和队列、串

- 春节声量高涨213%!如何撬动过年市场?小红书数据洞察入场玩家

- Java 主线程等待所有异步线程执行结束后在继续执行

- 安全防御之安全审计技术

- 12. 序列的特殊方法

- 60、UART任意时间缓冲打印信息--解决写代码调试时中断中打印信息问题