自然语言处理阅读第二弹

发布时间:2023年12月17日

HuggingFace

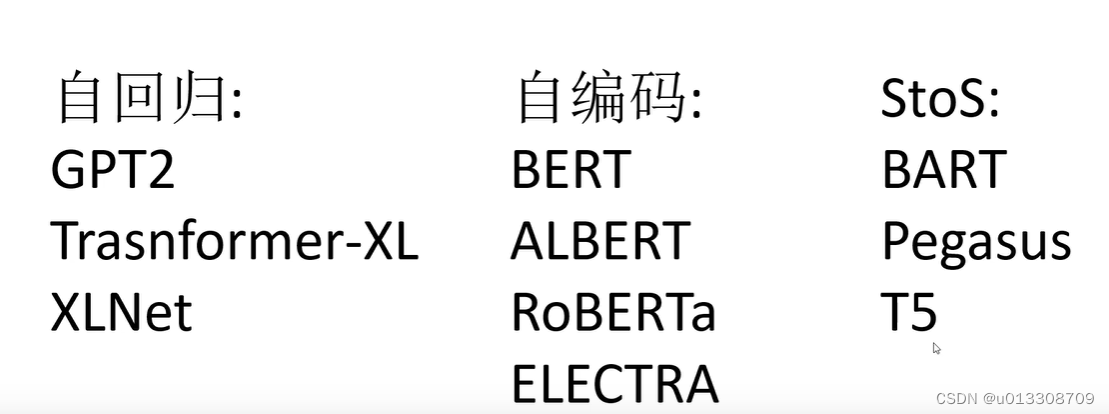

NLP中的自回归模型和自编码模型

- 自回归:根据上文内容预测下一个可能的单词,或者根据下文预测上一个可能的单词。只能利用上文或者下文的信息,不能同时利用上文和下文的信息。

- 自编码:对输入的句子随机Mask其中的单词,然后预训练过程的主要任务之一是根据上下文单词来预测这些被Mask掉的单词。同时根据上下文预测单词。

- Sequence-to-Sequence:是encoder和decoder的结合。

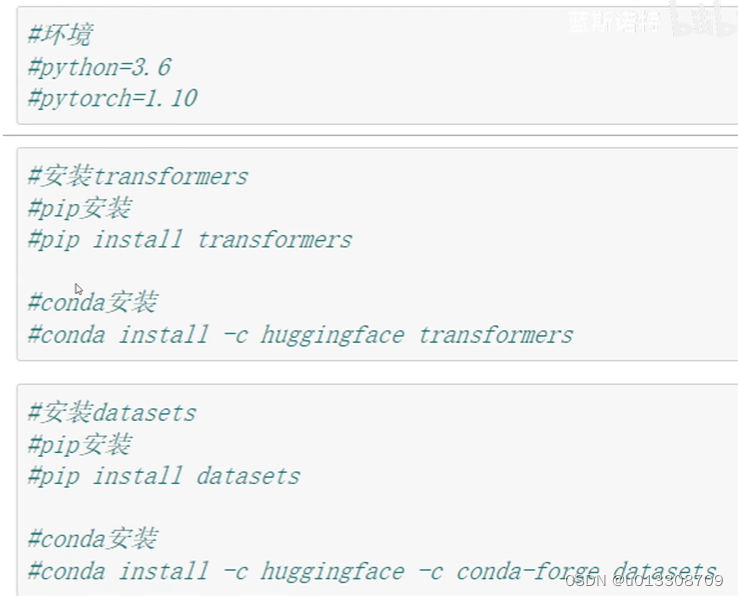

安装环境

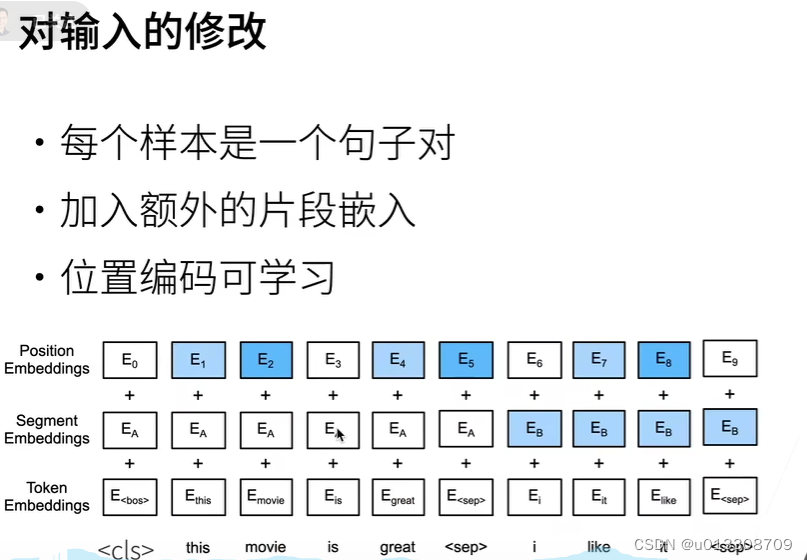

BERT架构

- 输入的修改

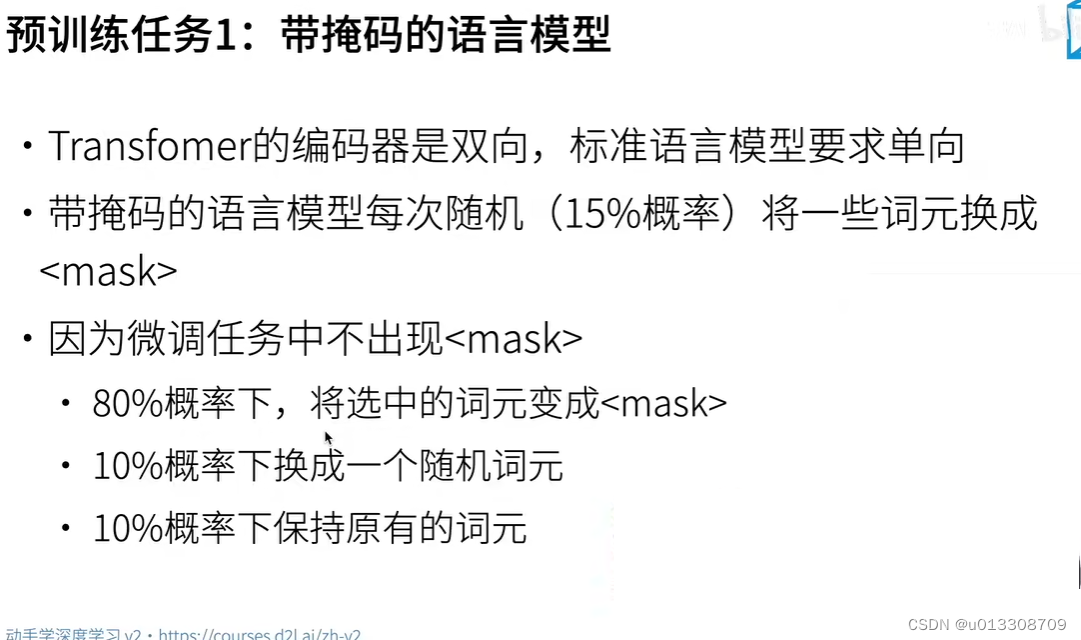

- 预训练任务1

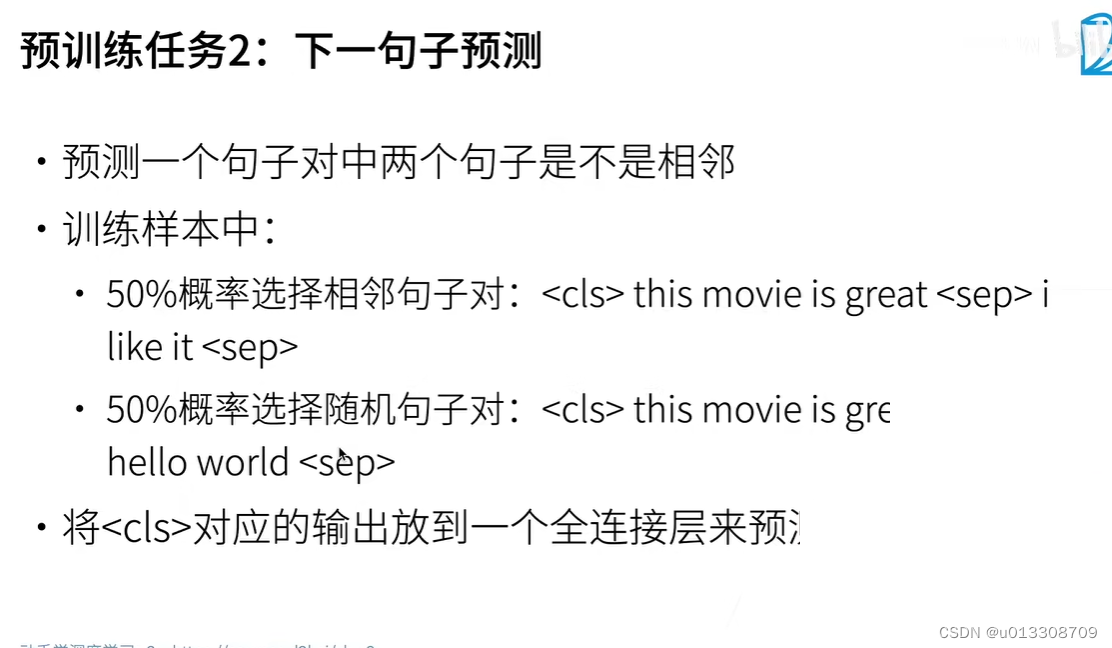

- 预测任务2

- 总结

文章来源:https://blog.csdn.net/u013308709/article/details/135037154

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!