深度学习|3.6 激活函数 3.7 为什么需要非线性激活函数

发布时间:2024年01月03日

激活函数

主要有sigmoid函数、tanh函数、relu函数和leaky relu函数

tanh函数相比sigmoid函数是具有优势的,因为tanh函数使得输出值的平均值为0,而sigmoid函数使得输出值的平均值为1/2,对下一层来说tanh输出的0更好进行处理。

激活函数tanh和sigmoid函数的不同和缺点

两者在趋近正负无穷时,函数值的变化量基本忽略不计。

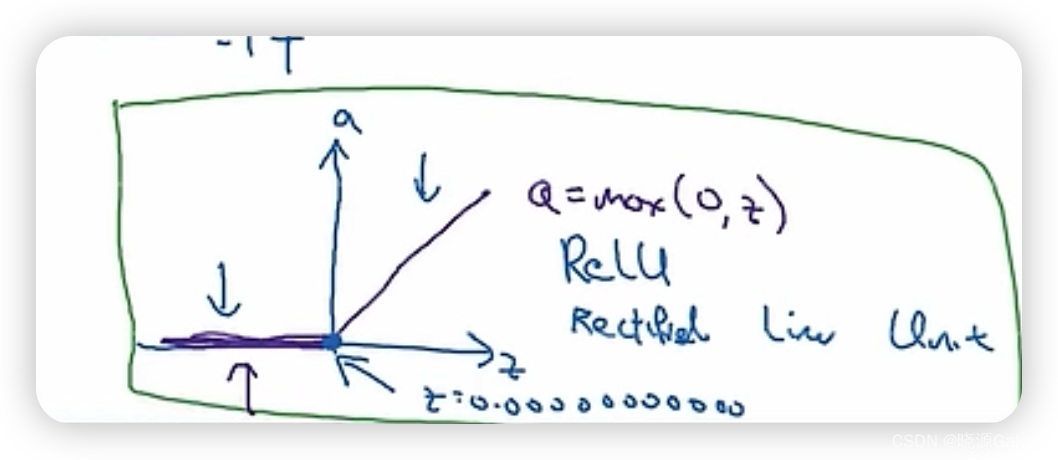

relu函数

relu函数的缺点是,当x小于0时,函数值为一个常数,对应地,其导数为0。

文章来源:https://blog.csdn.net/Fangyechy/article/details/135303138

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 使用STM32微控制器读取和显示DHT11温湿度传感器数据

- 排查格式化符与待格式化参数不一致导致的程序崩溃问题

- 街机模拟游戏逆向工程(HACKROM)教程:[8]68K汇编指令简介

- 杰理方案AC79整合LVGL触屏显示效果

- 【React】Redux的使用详解

- 数据隐私治理所面临的四大挑战

- 芯课堂 | LVG免费开源GUI图形库

- Grind75第4天 | 141.环形链表、876.链表的中间节点、125.验证回文串

- 搭建Eureka服务注册中心

- 设计模式之-备忘录模式,快速掌握备忘录模式,通俗易懂的讲解备忘录模式以及它的使用场景