Hadoop集群三节点搭建(一)

发布时间:2024年01月04日

一、第一台虚拟机准备

- 确认是可以上网,方便下载文件和工具,使用ping命令测试下

- 安装工具

net-tool:工具包集合,包含ifconfig等命令,大家可以根据自己需要按需下载

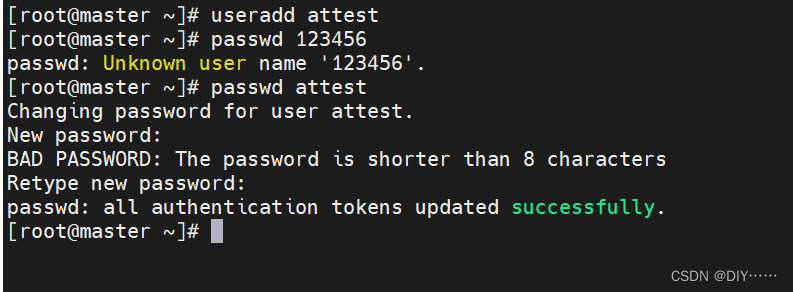

- 创建普通用户attest,并修改attest用户的密码

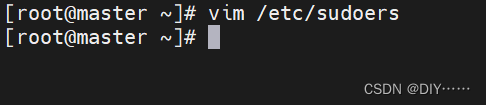

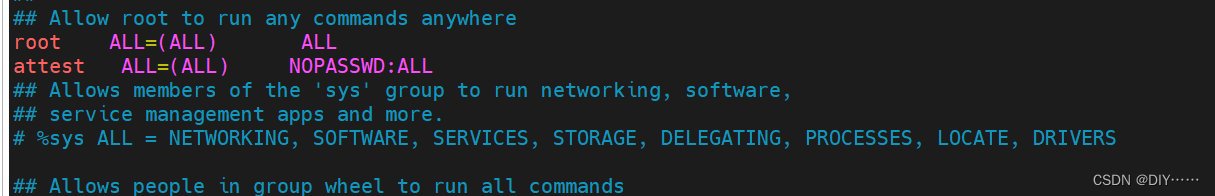

- 配置attest用户具有root权限,方便后期加sudo执行root权限的命令

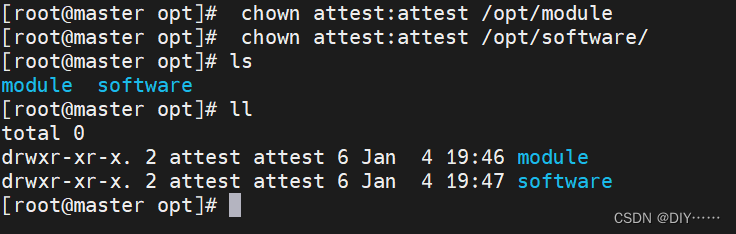

- 在/opt目录下创建文件夹,并修改所属主和所属组

二、安装JDK

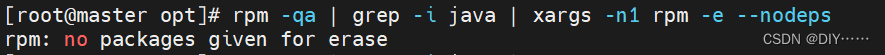

- 卸载虚拟机自带的JDK

rpm -qa:查询所安装的所有rpm软件包

grep -i:忽略大小写

xargs -n1:表示每次只传递一个参数

rpm -e –nodeps:强制卸载软件

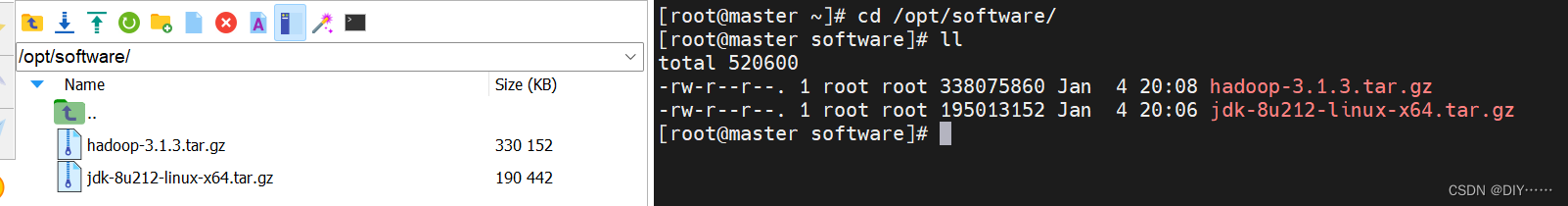

- 切换成attest用户,安装jDK,Hadoop

上传jdk hadoop 安装包到指定的目录 (/opt/software)

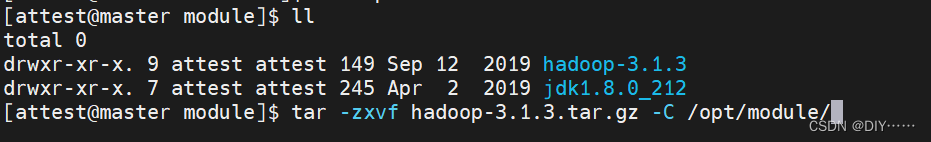

解压JDK到/opt/module目录下

[attest@master software]$ tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/

- 配置JDK环境变量

新建/etc/profile.d/my_env.sh文件

sudo vim /etc/profile.d/my_env.sh

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

- source一下/etc/profile文件,让新的环境变量PATH生效

[attest@master software]$ source /etc/profile

- 测试JDK是否安装成功

[attest@master software]$ java -version

java version "1.8.0_212"

Java(TM) SE Runtime Environment (build 1.8.0_212-b10)

Java HotSpot(TM) 64-Bit Server VM (build 25.212-b10, mixed mode)

能看到以上结果,则代表Java安装成功。

java version “1.8.0_212”

三、安装 Hadoop

Hadoop [下载地址](https://archive.apache.org/dist/hadoop/common/hadoop-3.1.3/)

- 解压安装文件到/opt/module

- 将Hadoop添加到环境变量

[attest@master module]$ sudo vim /etc/profile.d/my_env.sh

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

- 让环境变量生效、检查是否安装成功

[attest@master module]$ source /etc/profile

[attest@master module]$ cd

[attest@master ~]$ hadoop version

Hadoop 3.1.3

Source code repository https://gitbox.apache.org/repos/asf/hadoop.git -r ba631c436b806728f8ec2f54ab1e289526c90579

Compiled by ztang on 2019-09-12T02:47Z

Compiled with protoc 2.5.0

From source with checksum ec785077c385118ac91aadde5ec9799

This command was run using /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-common-3.1.3.jar

[attest@master ~]$

注意:如果Hadoop命令不能用启虚拟机

- hadoop目录解析

bin目录:存放对Hadoop相关服务(hdfs,yarn,mapred)进行操作的脚本

bin目录:存放对Hadoop相关服务(hdfs,yarn,mapred)进行操作的脚本

etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

sbin目录:存放启动或停止Hadoop相关服务的脚本

share目录:存放Hadoop的依赖jar包、文档、和官方案例

文章来源:https://blog.csdn.net/qq_37232843/article/details/135394460

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章