英特尔深度相机D455实现YOLOv5+deeepsort行人车辆测速、测距、追踪

目录

Intel RealSense D435、D455等D4系列:

Intel D4系列深度相机是由英特尔(Intel)公司推出的一款深度感知摄像头,专为实现计算机视觉和深度学习应用而设计。这款相机使用了英特尔的深度感知技术,结合了摄像头和红外(IR)传感器,可以提供高质量的深度图像和 RGB 彩色图像,为开发者提供了丰富的数据源,用于各种应用,包括虚拟现实(VR)、增强现实(AR)、手势识别、人脸识别、姿势识别、3D 扫描等。

以下是Intel D4系列深度相机的一些主要特点和优势:

1. 深度感知技术:

D4系列相机具备高质量的深度感知功能,能够获取场景中各个物体的精确距离信息,而不仅仅是RGB图像。

2. 多模式操作:

相机支持多种操作模式,包括手势识别、人脸识别、物体追踪等。这使得它非常适合于需要人机交互的应用领域。

3. 低光环境适应:

D4系列深度相机在低光环境下也能够提供准确的深度信息,这使得它在各种不同的环境中都能够稳定工作。

4. 易于集成:

相机提供了丰富的软件开发工具,开发者可以方便地将其集成到自己的应用中,快速开发深度感知应用。

5. 多平台支持:

D4系列深度相机支持多种操作系统,包括Windows、Linux等,也提供了各种开发语言的API,方便开发者在不同平台上使用。

6. 精准度和稳定性:

相机具有高精度和稳定性,能够在不同距离范围内提供准确的深度信息,这对于需要精确度的应用非常重要。

结构光:

基本原理是,通过近红外激光器,将具有一定结构特征的光线投射到被拍摄物体上,再由专门的红外摄像头进行采集。这种具备一定结构的光线,会因被摄物体的不同深度区域,而采集不同的图像相位信息,然后通过运算单元将这种结构的变化换算成深度信息,以此来获得三维结构。通常采用特定波长的不可见的红外激光作为光源,它发射出来的光经过一定的编码投影在物体上,通过一定算法来计算返回的编码图案的畸变来得到物体的位置和深度信息。

结构光的优点主要有:

1)方案成熟,相机基线可以做的比较小,方便小型化。

2)资源消耗较低,单帧 IR 图就可计算出深度图,功耗低。

3)主动光源,夜晚也可使用。

4)在一定范围内精度高,分辨率高,分辨率可达 1280x1024,帧率可达 60FPS。

结构光的缺点:

1)容易受环境光干扰,室外体验差。

2)随检测距离增加,精度会变差。

1,YOLOv5+deepsort原理简介

Yolov5是以YOLO系列为基础的最新版本。它使用卷积神经网络来实现目标检测任务。Yolov5通过将输入图像分成不同大小的网格单元,并在每个单元上预测目标的边界框和类别信息。与之前的版本相比,Yolov5在网络结构上进行了改进,引入了更多的卷积层和特征金字塔网络,以提高目标检测的准确性和效率。

DeepSORT(Deep Learning + Simple Online and Realtime Tracking)是一种多目标跟踪算法,它结合了深度学习和在线实时跟踪的思想。DeepSORT首先使用目标检测算法(如Yolov5)检测出图像中的目标,并将其表示为特征向量。然后,使用卡尔曼滤波器对目标进行动态建模,并使用匈牙利算法将检测到的目标与现有的跟踪轨迹进行关联。最后,通过计算特征向量之间的相似度来更新和预测目标的轨迹。

结合Yolov5和DeepSORT,可以实现目标检测和目标跟踪的一体化处理。首先,Yolov5用于检测出图像中的目标,并为每个目标生成边界框和类别信息。然后,将这些检测结果传递给DeepSORT,利用其多目标跟踪算法进行目标关联和轨迹更新。在每个时间步长上,DeepSORT会根据目标的预测位置和特征向量的相似度来更新目标的轨迹,并输出最终的目标追踪结果。

该方法的优点是能够同时实现目标检测和目标跟踪,具有较高的准确性和实时性。由于Yolov5采用了轻量级的网络结构,因此可以在实时视频流上进行快速目标检测。而DeepSORT利用深度学习和在线实时跟踪的思想,可以准确地关联目标并生成连续的轨迹。

2,项目介绍

项目介绍可见文章:

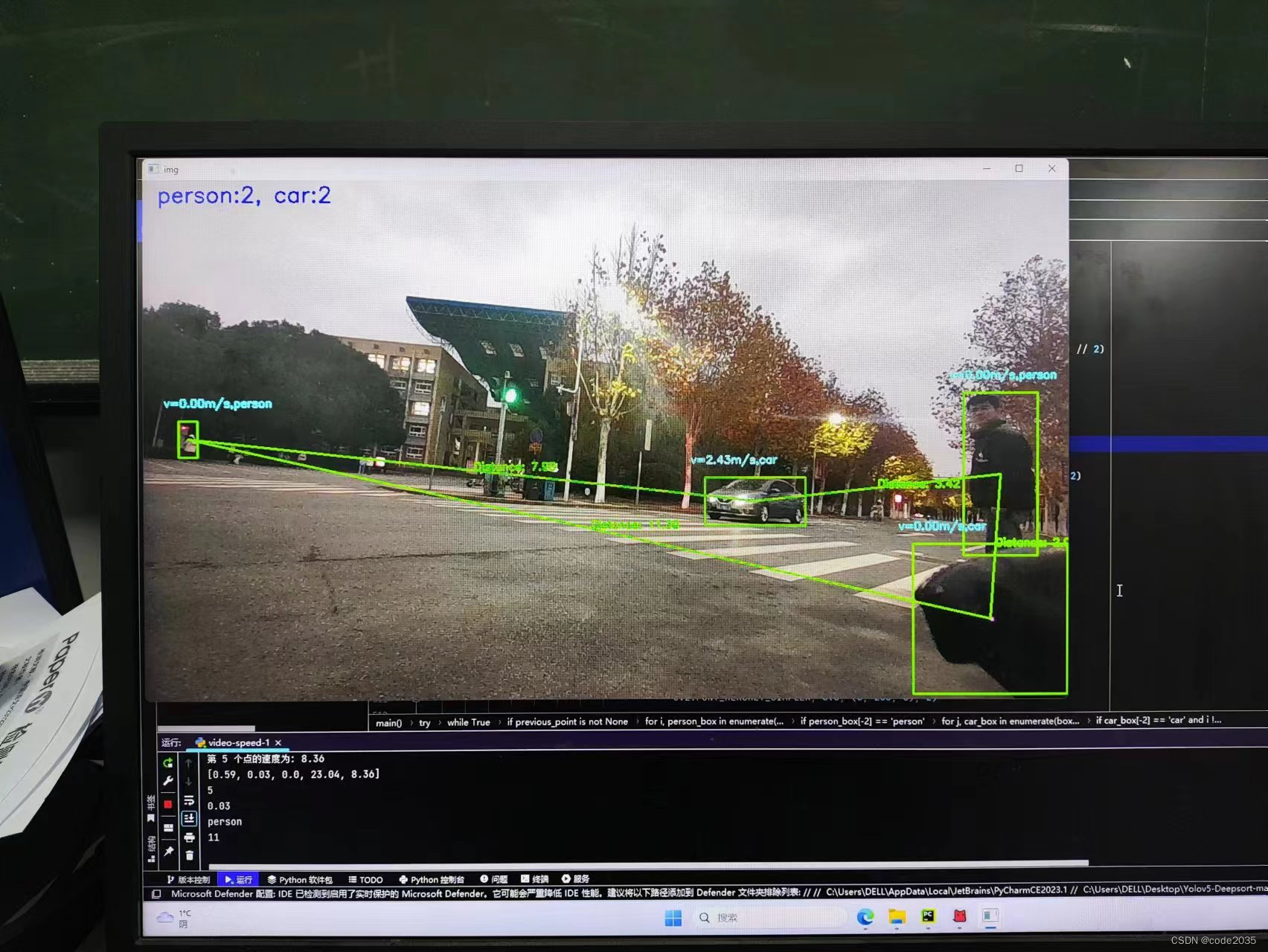

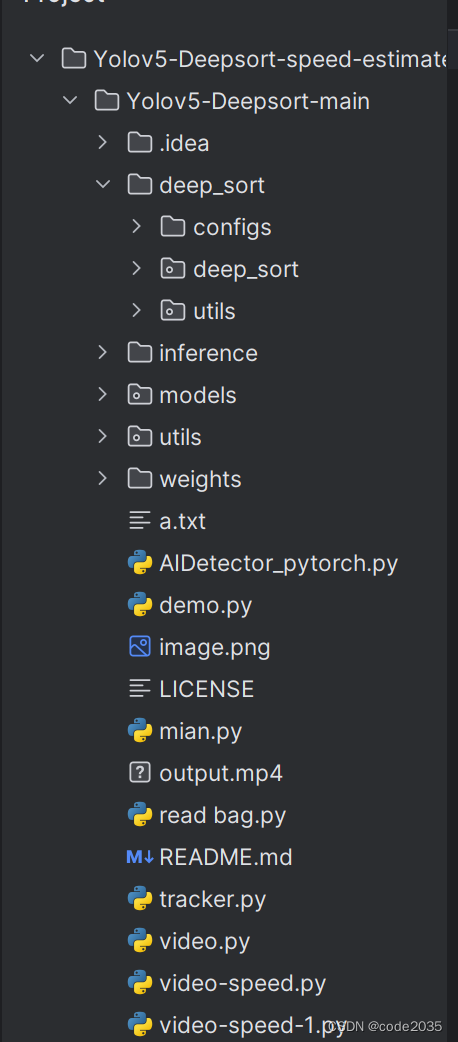

通过将YOLOv5目标检测器+deepsort追踪器相结合,重写主函数,实现了

目标检测

目标测速

车和行人安全距离

人车轨迹绘制

3,结果展示

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!