深度学习技巧应用32-在YOLOv5模型上使用TensorRT进行加速的应用技巧

发布时间:2024年01月11日

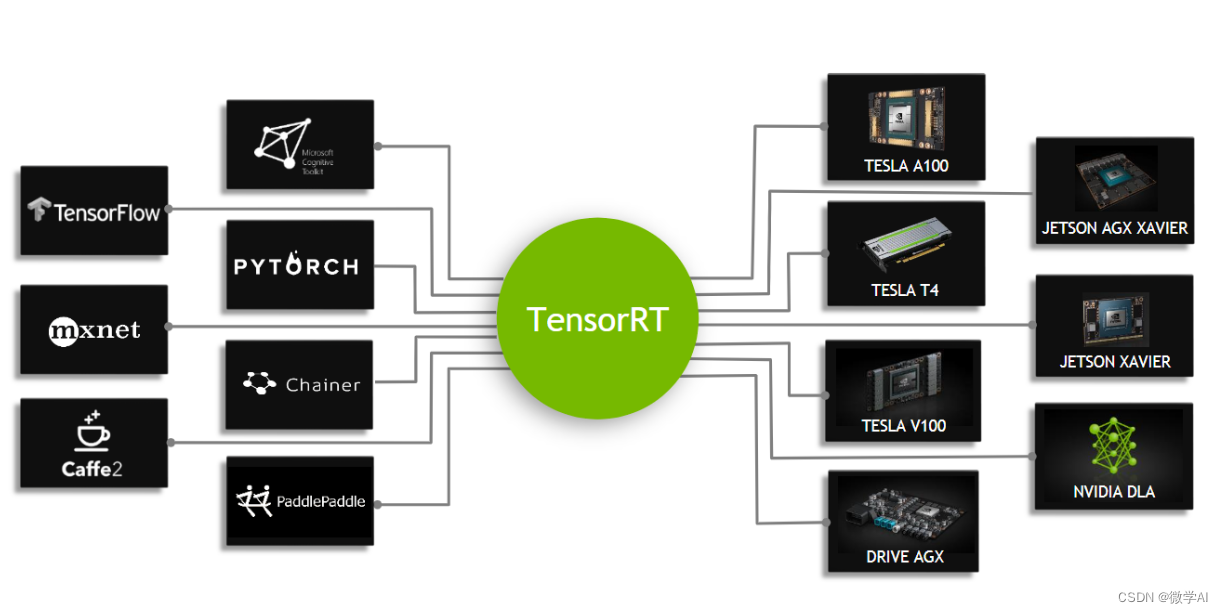

大家好,我是微学AI,今天给大家介绍一下深度学习技巧应用32-在YOLOv5模型上使用TensorRT进行加速的应用技巧,TensorRT是NVIDIA公司提供的一个深度学习推理(inference)优化器和运行时库。它专门为生产环境下的高性能深度学习推理提供优化支持。TensorRT可以加速深度学习模型在NVIDIA GPU上的推理速度,降低延迟和提升吞吐量,这对于实时应用如自动驾驶、机器人、AI助手等场合至关重要。

一、 TensorRT的原理

TensorRT的原理基于以下几点:

1 图优化(Graph Optimization):

- 层融合(Layer Fusion):将多个层(如卷积、激活、批量归一化)融合成一个更高效的内核。

- 精度校准(Precision Calibration):使用低精度(如FP16或INT8)计算代替FP32以提升性能,同时尝试最小化精度损失。

- 动态张量内存(Dynamic Tensor Memory):优化内存使用,减少内存占用和数据复制操作。

2 内核自动调优(Kernel Auto-Tuning):

- 根据目标平台的GPU架构,

文章来源:https://blog.csdn.net/weixin_42878111/article/details/135530792

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 什么是GeoTrust证书?

- 怎么将视频转换为mp4?

- 【MySQL】索引基础

- 今日腊八 | “粥”到,健康到

- 学习Java API(二):基础知识点一文通?

- 2023年,94%的企业发生过邮件安全事件!

- Android Studio由于开启代理无法下载依赖,一直在Build model

- 酷狗音乐逆向(js逆向)

- 源码学习:web server althttpd (未完待续)

- 解决ELement-UI懒加载三级联动数据不回显(天坑)