在AutoDL平台部署ChatGLM3-6B(0基础小白超详细教程)

发布时间:2024年01月22日

在AutoDL平台部署ChatGLM3-6B超详细教程

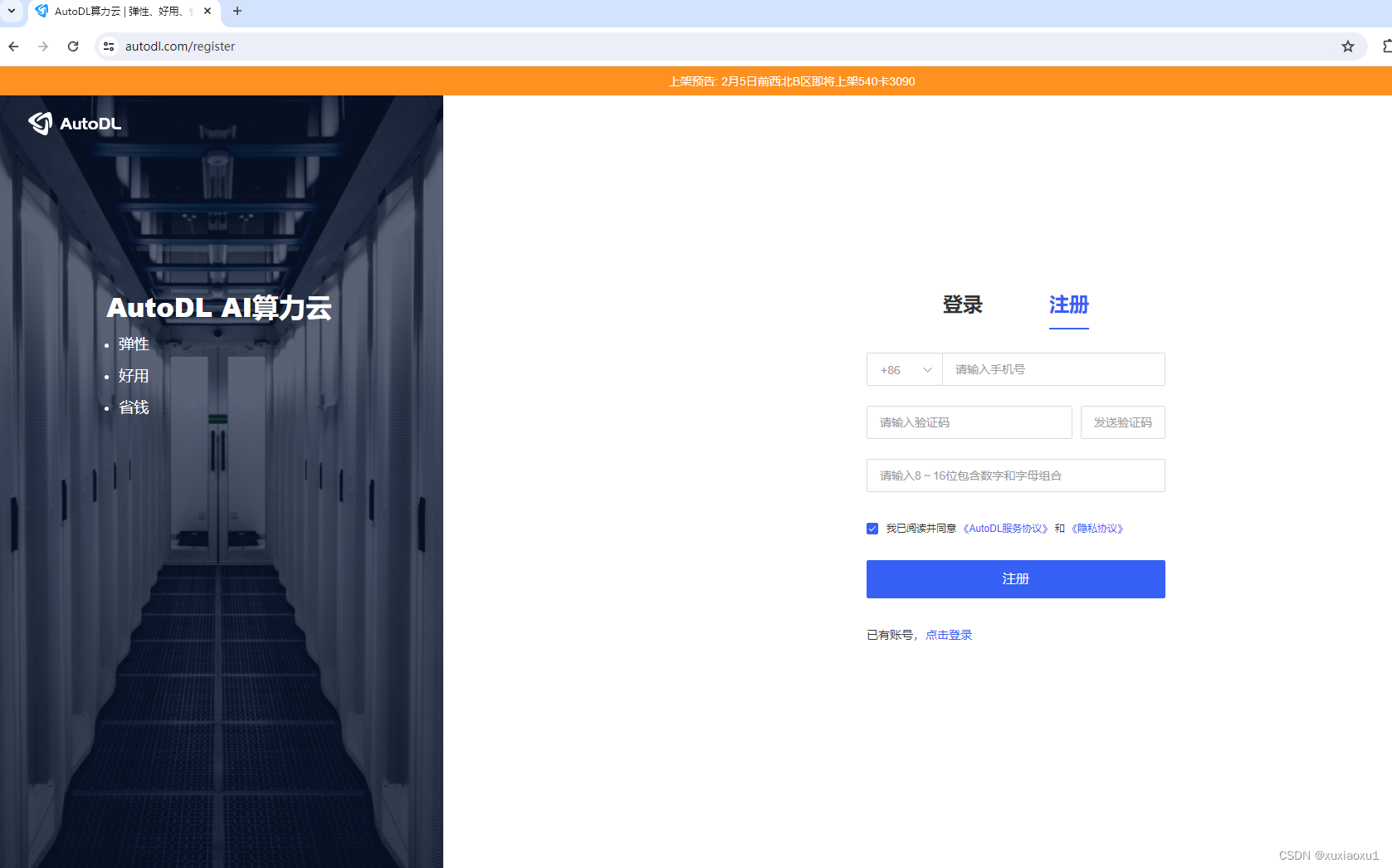

一、注册AutoDL

AutoDL官网 注册账户好并充值

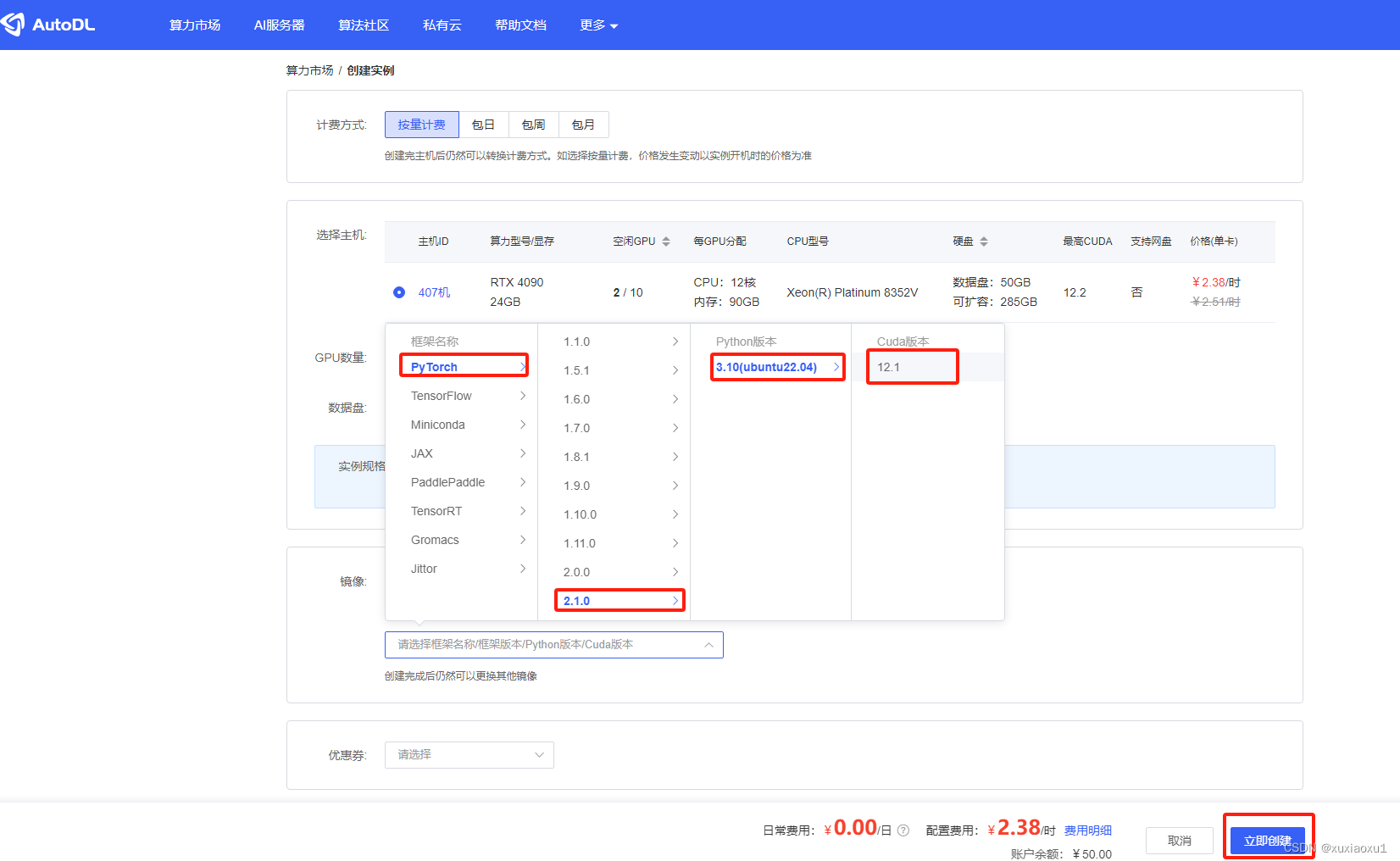

二、创建实例

2.1 登录AutoDL,进入算力市场,选择RTX 4090机器。

2.2 配置基础镜像

2.3. 无卡模式开机

创建成功后为了省钱先关机,然后使用无卡模式开机。

无卡模式一个小时只需要0.1元,比较适合部署环境。

三、部署环境

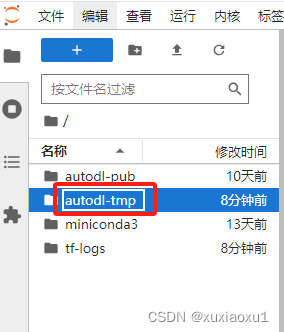

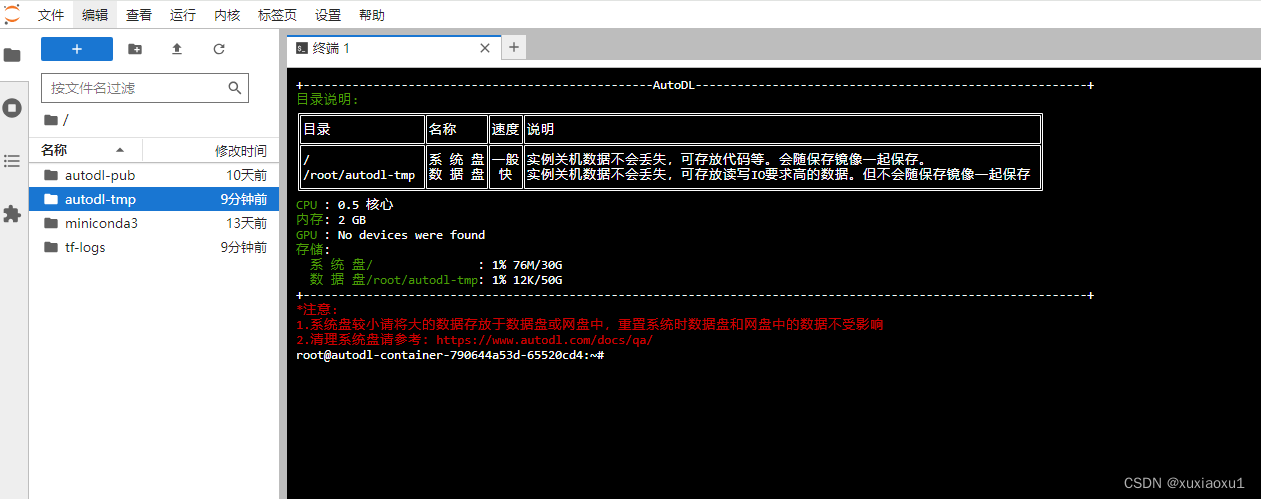

3.1 进入终端

打开jupyterLab,进入数据盘(autodl-tmp),打开终端,将ChatGLM3-6B模型下载到数据盘中。

3.2 下载模型文件

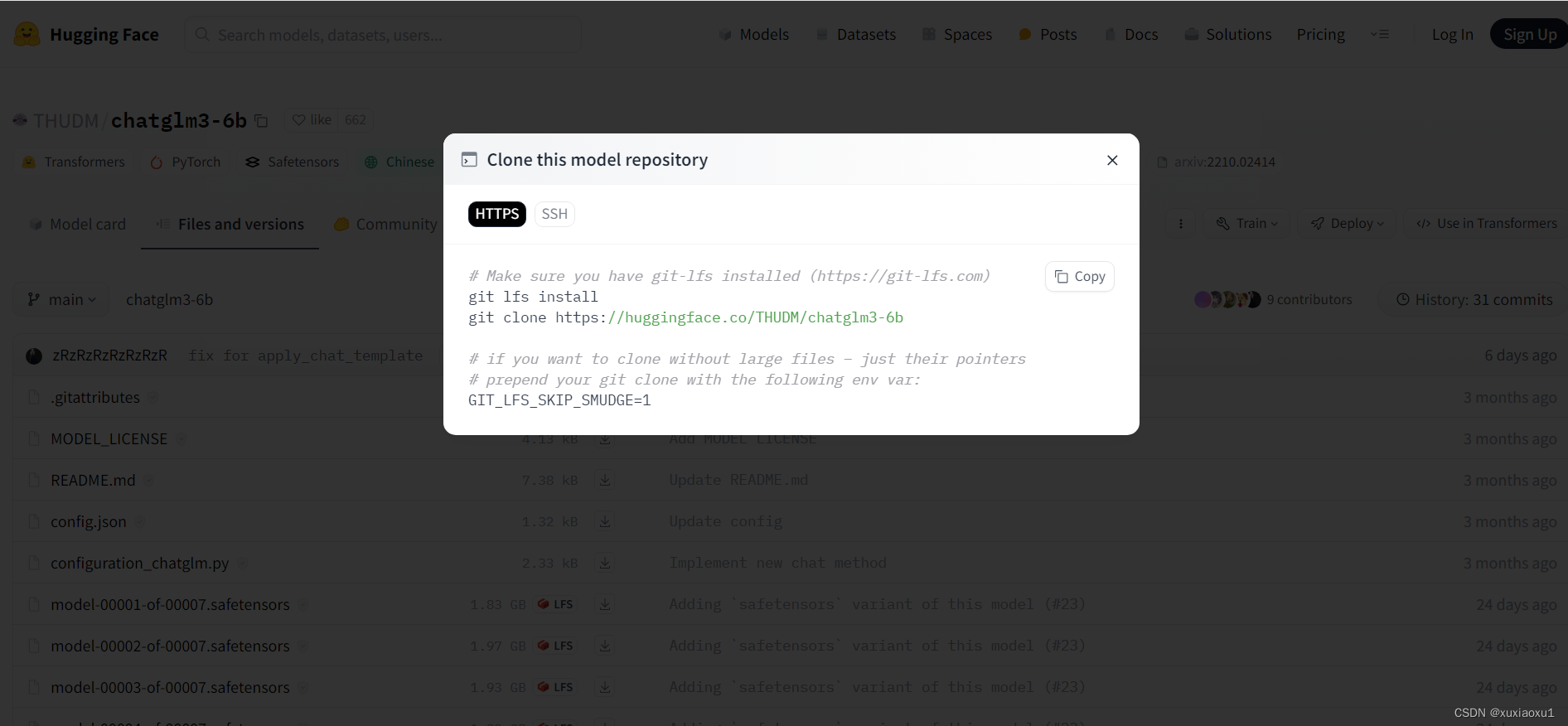

进入Hugging Face上的chatglm3-6b的模型仓库地址下载模型文件

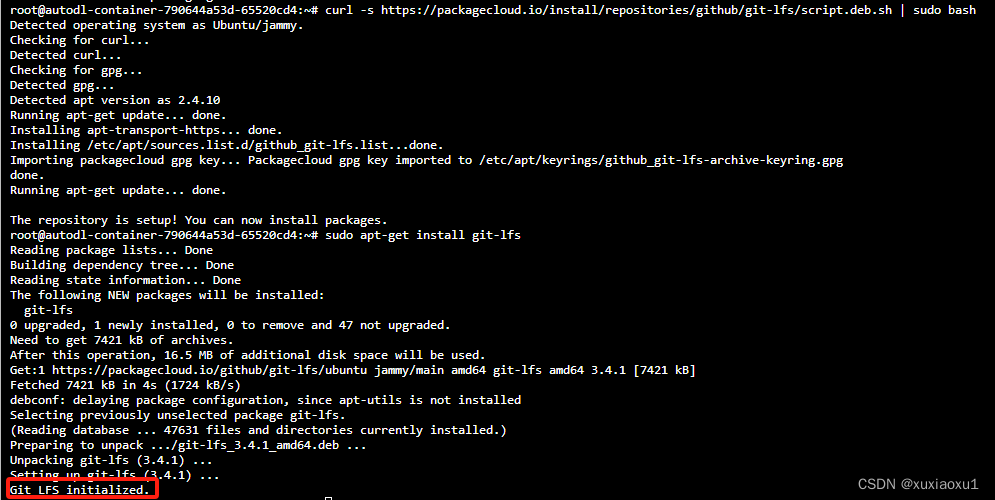

安装git lfs

curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bash

sudo apt-get install git-lfs

下载模型文件(模型二十多G,需慢慢等待)

注意:先设置学术资源加速

source /etc/network_turbo

git lfs install

git clone https://huggingface.co/THUDM/chatglm3-6b

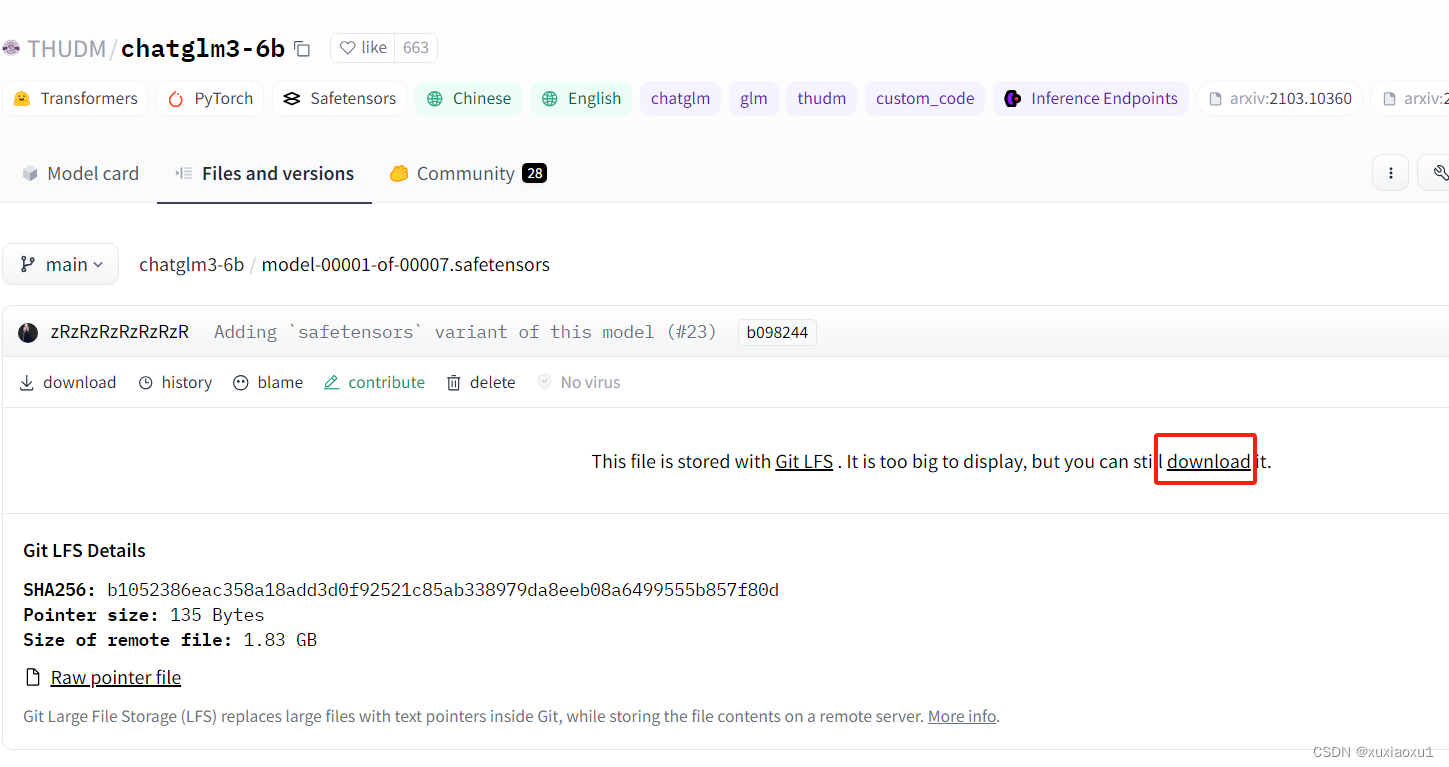

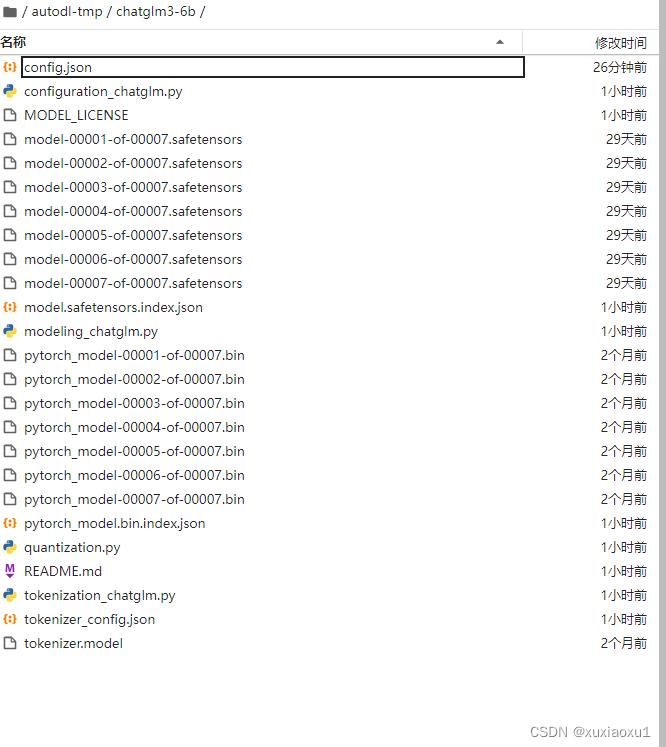

下载模型文件很慢,可以停止下载,此时在/autodl-tmp/chatglm3-6b/目录下载主要的模型文件

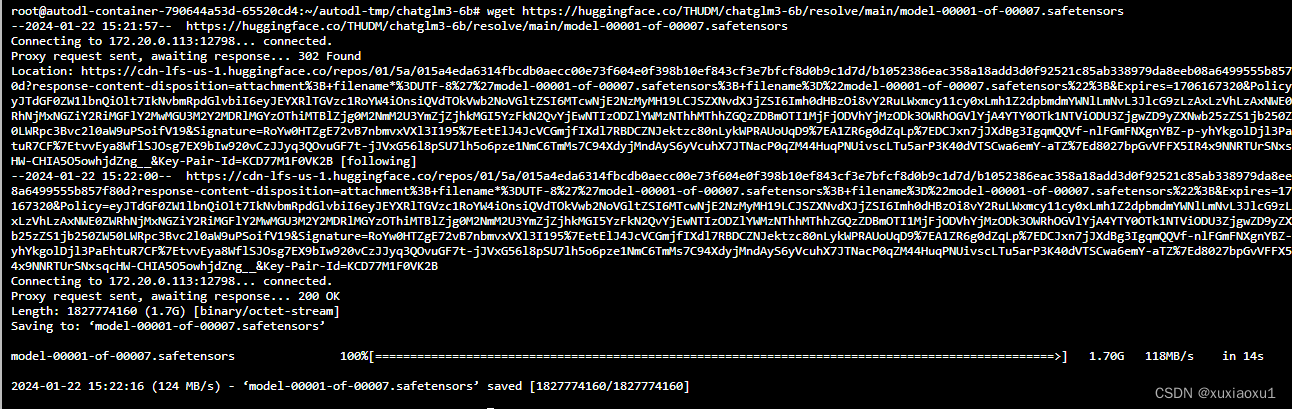

复制这些文件的地址,在/autodl-tmp/chatglm3-6b/目录下,使用wget下载(非常的快)

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/model-00001-of-00007.safetensors

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/model-00002-of-00007.safetensors

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/model-00003-of-00007.safetensors

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/model-00004-of-00007.safetensors

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/model-00005-of-00007.safetensors

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/model-00006-of-00007.safetensors

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/model-00007-of-00007.safetensors

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/pytorch_model-00001-of-00007.bin

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/pytorch_model-00002-of-00007.bin

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/pytorch_model-00003-of-00007.bin

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/pytorch_model-00004-of-00007.bin

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/pytorch_model-00005-of-00007.bin

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/pytorch_model-00006-of-00007.bin

wget https://huggingface.co/THUDM/chatglm3-6b/resolve/main/pytorch_model-00007-of-00007.bin

模型下载完成,仔细比对不能少必要文件

四、ChatGLM3项目

4.1 环境安装

在/root下打开终端,执行

git clone https://github.com/THUDM/ChatGLM3.git

cd ChatGLM3

然后使用 pip 安装依赖:

pip install -r requirements.txt

4.2 网页版对话 Demo

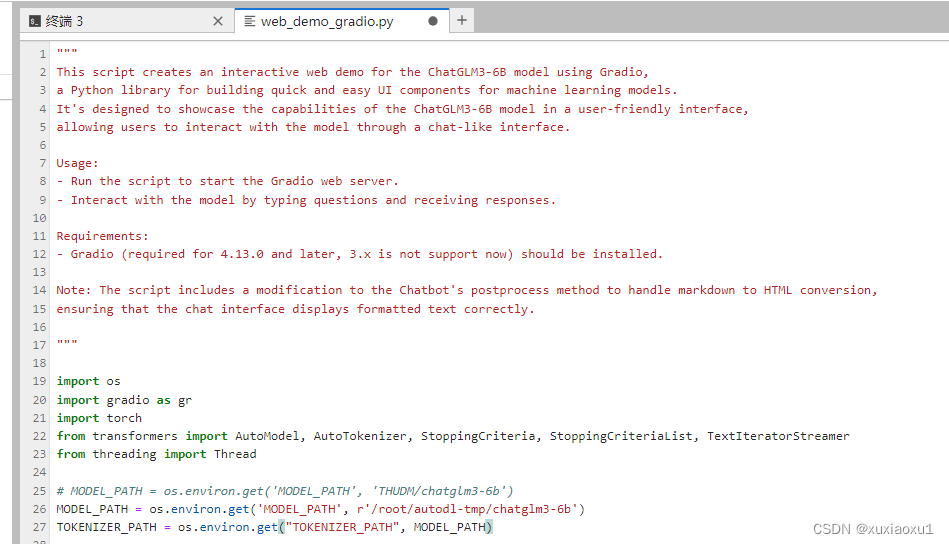

修改/ChatGLM3/basic_demo/web_demo_gradio.py的25行,将MODEL_PATH修改为上边下载好的本地路径

MODEL_PATH = os.environ.get('MODEL_PATH', r'/root/autodl-tmp/chatglm3-6b')

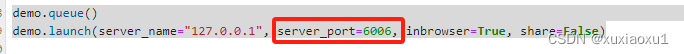

设置gradio的参数,server_port=6006,然后点击控制台面的 自定义服务,就可以了。

demo.queue()

demo.launch(server_name="127.0.0.1", server_port=6006, inbrowser=True, share=False)

环境部署已完成

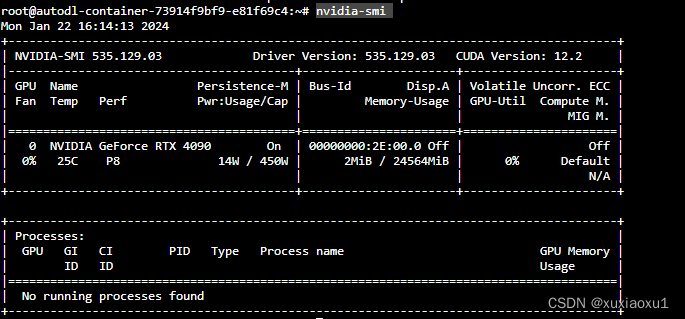

4.3 有卡开机

进入autodl容器实例界面,执行关机操作,然后进行有卡开机,开机后打开jupyterLab。

查看配置

nvidia-smi

cd /root/ChatGLM3/basic_demo/

python web_demo_gradio.py

未完待续

文章来源:https://blog.csdn.net/weixin_68531269/article/details/135747460

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 微服务实战系列之Dubbo(上)

- Android 13 - Media框架(24)- OMXNodeInstance(一)

- 【揭秘】Maven聚合与继承:如何轻松实现项目依赖管理?

- vue2面试题:对vue生命周期的理解

- 基于人工蚁群、蚁群、遗传算法的多目标任务分配

- Pandas教程(五)—— 重塑及数据透视

- 人员安全管理

- 代码随想录第三十五天(一刷&&C语言)|整数拆分&&不同的二叉搜索树

- 软件测试人员的革命:打造个性化的测试用例生成工具

- Maya参考图的导入和层的应用