图神经网络|5.消息传递的计算方法 6.多层GNN的作用

发布时间:2024年01月07日

5.消息传递的计算方法

边的存放方式

注意,在实际的边的实现方式中,并不是以邻接矩阵来进行实现的,这是因为在图的更新中,用邻接矩阵进行更新所占用的时间开销相对大,二是因为领接矩阵占用的空间大(N方)。

所以在实际实现中会采用2XN的存储结构,从而避免多余的存储开销。

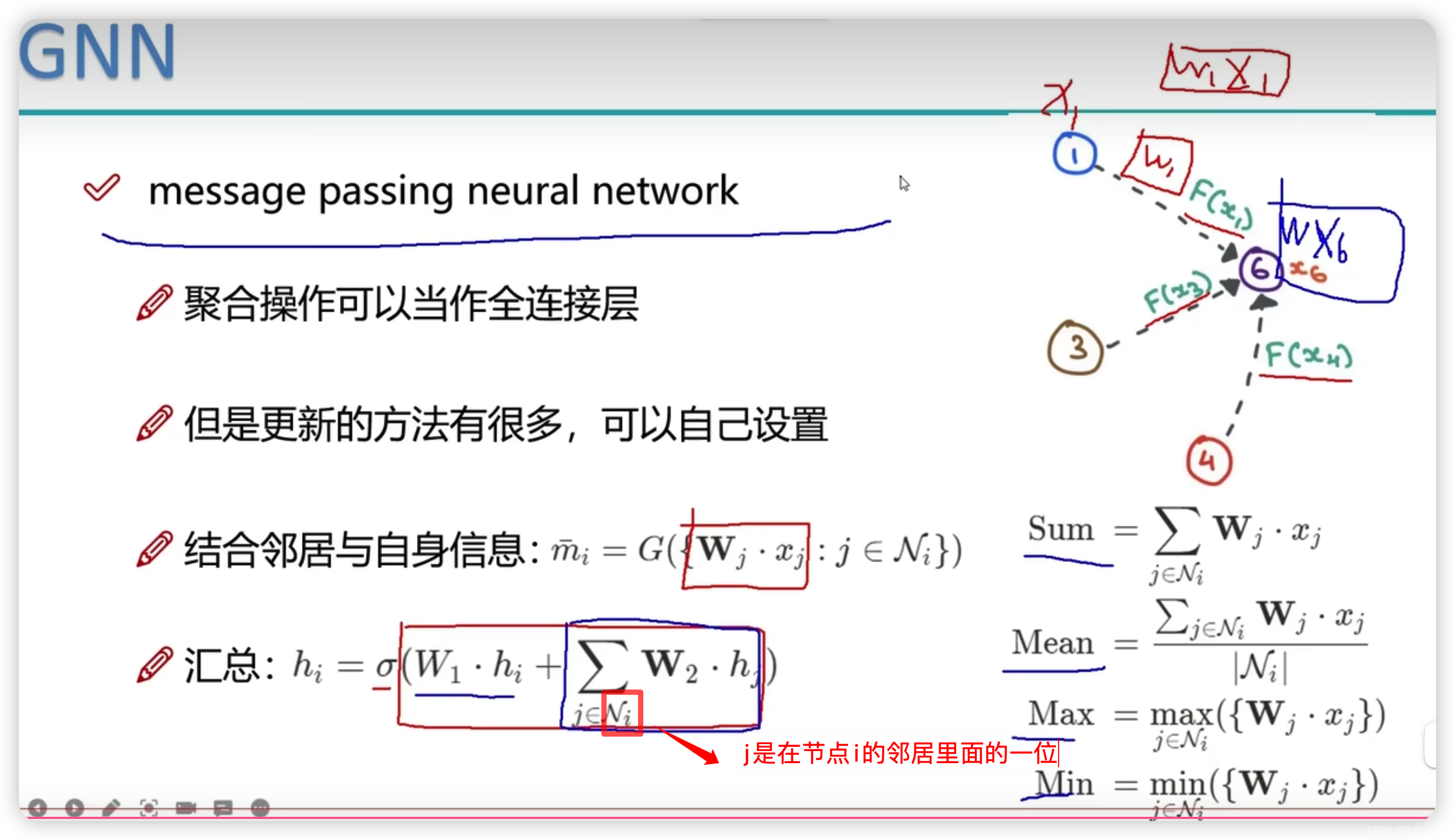

节点更新

在图神经网络中,某个节点的更新,不应该只关心自身的变化,还应该关心相邻节点与本节点的关系。

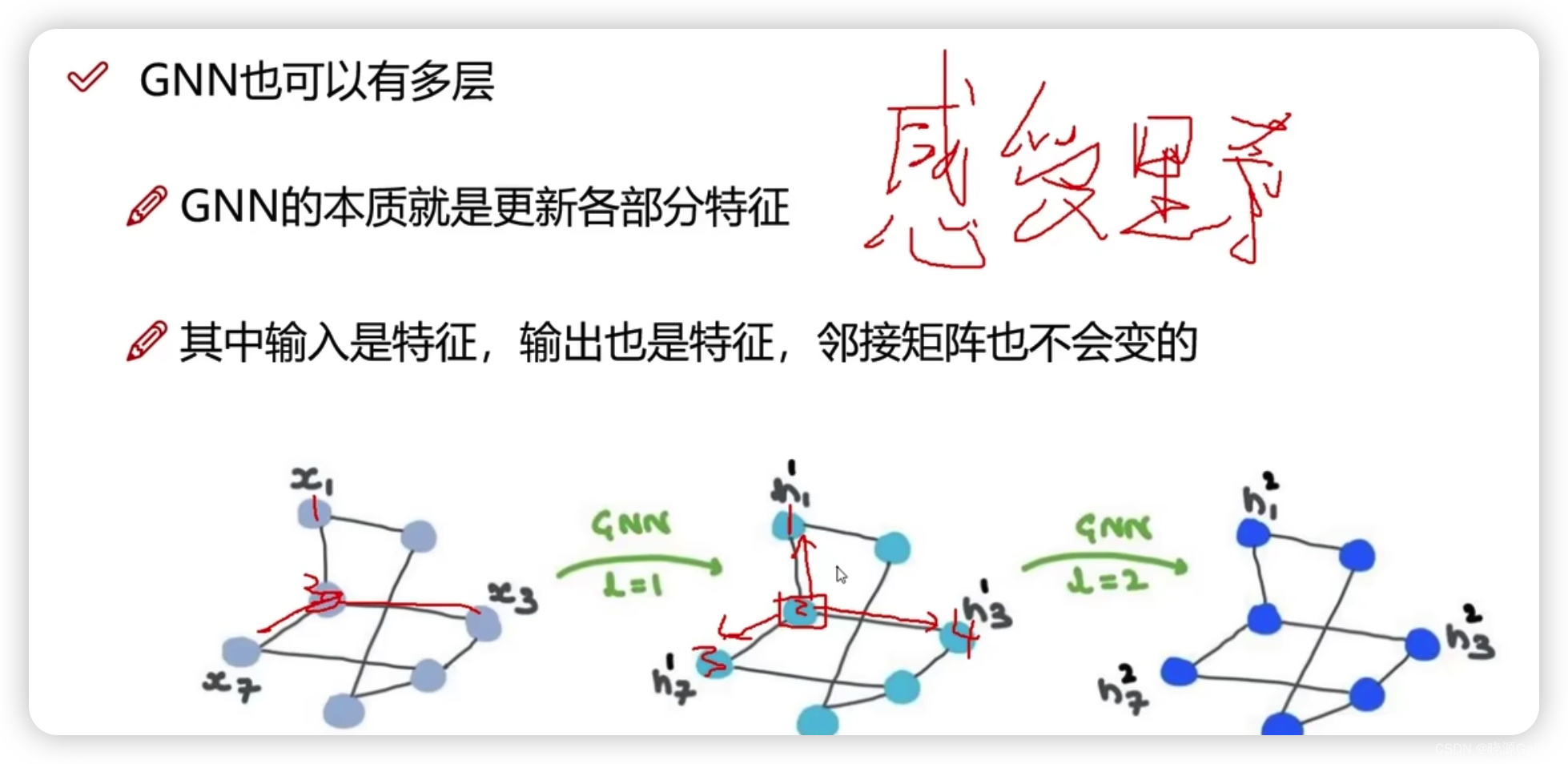

6.多层GNN的作用

首先,多层GNN并不会破坏图的结构(拓扑关系/邻接结构)。

而多层GNN能使得本点上的特征信息,不断进行迭代(就好像计算机网络中rip,不断交换路由信息,来得到更远处的路由信息,从而最后收敛)

文章来源:https://blog.csdn.net/Fangyechy/article/details/135434359

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 数据结构栈实现(赋完整代码)

- 知存科技助力AI应用落地:WTMDK2101-ZT1评估板实地评测与性能揭秘

- 一些简单OJ:进制转换,报数字,刷快手。

- 力扣210. 课程表 II

- 前端框架前置学习Webpack(1) 常用webpack配置

- 线上展览馆可以展示哪些内容,线上展览馆如何搭建

- 第11章 GUI Page420 步骤七 设置圆,矩形,文字的前景色

- NFC物联网一次性口令认证解决方案

- 洁具工程标书:打造舒适生活的细节

- c#之枚举类型和结构体