k8s中服务器容器tcp连接数量优化

发布时间:2024年01月22日

netty的http1服务器在运行一段时间后会无法提供服务,返回客户端socket hang up

使用apipost测试抓包显示三次握手后被reset

修改net/core/somaxconn

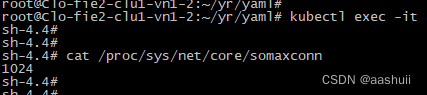

登录容器,cat /proc/sys/net/core/somaxconn显示128,对于一个服务器来说,这个限制太小了,可以放大。

但是k8s把容器的参数分类了,大部分的参数都属于unsafe,不能直接修改。

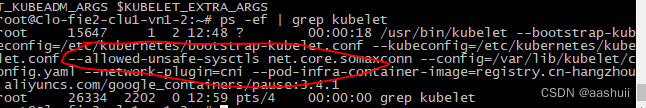

第一步:修改kubelet启动参数

kubelet启动增加参数:kubelet --allowed-unsafe-sysctls ‘net.core.somaxconn’

kubelet可能是通过配置文件启动的,比如/etc/systemd/system/kubelet.service.d/10-kubeadm.conf

修改后重启kubelet:systemctl restart kubelet

确认是否生效:

第二步:修改netty的yaml

在Deployment中spec-template-spec-containers下增加securityContext:

securityContext:

sysctls:

- name: net.core.somaxconn

value: "1024"

启动pod后查看somaxconn:

修改 TIME_WAIT 连接数量

cat /proc/net/tcp查看到tcp连接数非常多,(没看懂具体内容,待补充)

需要修改关闭连接的等待时间

步骤一 修改kubelet配置,增加:

--allowed-unsafe-sysctls net.core.somaxconn,net.ipv4.*

步骤二 修改deployment:

securityContext:

sysctls:

- name: net.core.somaxconn

value: "1024"

- name: net.ipv4.tcp_fin_timeout

value: "30"

- name: net.ipv4.tcp_tw_reuse

value: "1"

文章来源:https://blog.csdn.net/aashuii/article/details/135745511

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- C++的面向对象学习(5):对象的重要特性:对象的成员变量和成员函数深入研究

- Apache认证和授权

- 第四章 处理机调度【操作系统】

- 跨境电商平台的物流服务:解析与利用

- lenovo联想小新Pro-13 2020 Intel IML版笔记本电脑(82DN)原装出厂Win10系统镜像

- 第十二届“中关村青联杯”全国研究生数学建模竞赛-C题:移动通信中的无线信道“指纹”特征建模

- 15 使用v-model绑定单选框

- Vue3组件库 -- element plus 树形选择器组件怎样显示已有的树形菜单?

- web前端 JQuery下拉菜单的案例

- 基于Java SSM框架实现医院预约挂号系统项目【项目源码+论文说明】