机器学习系列13:通过随机森林获取特征重要性

发布时间:2023年12月30日

我们已经知道通过?L1 正则化和?SBS?算法可以用来做特征选择。

我们还可以通过随机森林从数据集中选择相关的特征。随机森林里面包含了多棵决策树,我们可以通过计算特征在每棵决策树决策过程中所产生的的信息增益平均值来衡量该特征的重要性。

你可能需要参考:《机器学习系列06:决策树》

这种方法无需对特征做归一化或者标准化预处理,也不假设数据集是否线性可分。

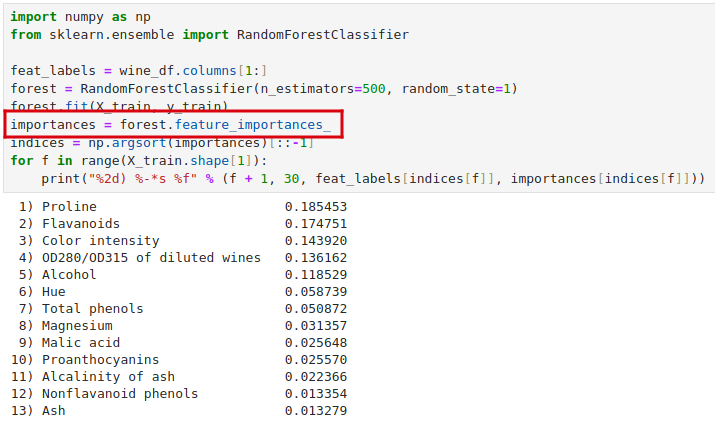

以红酒数据集为例。我们可以直接通过 feature_importances_ 属性获取每个特征的重要性,所有特征重要性之和为 1.0。

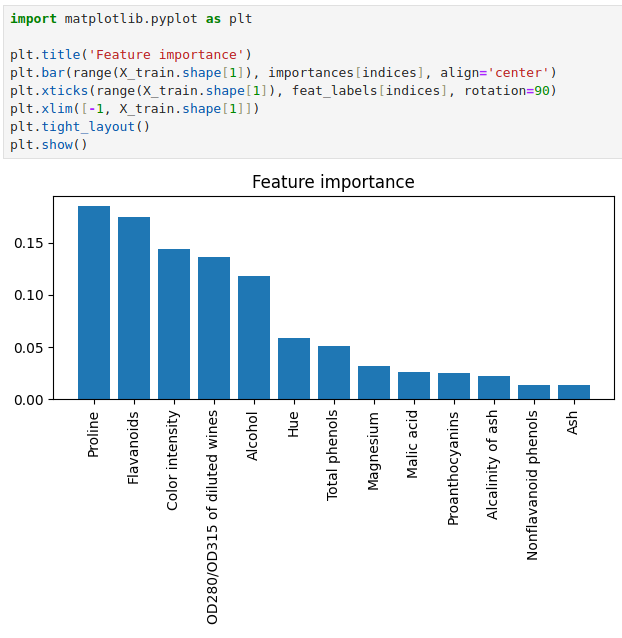

我们可以更直观地可视化观察一下。

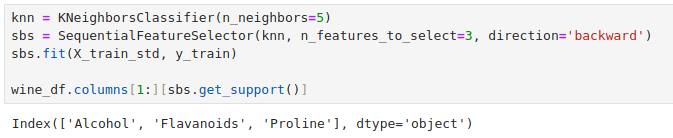

可以看到上面随机森林选出的前 3 个特征最重要的特征中有 2 也出现在了之前在

《机器学习系列12:减少过拟合——降维(特征选择)》中使用 SFS 算法选择的 3 个最重要的特征中。

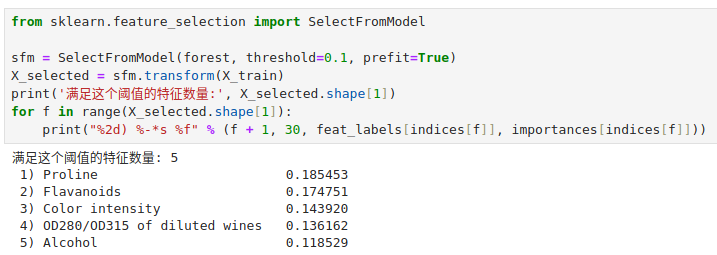

我们可以通过 scikit-learn 提供的 SelectFromModel 来通过?threshold 参数设定一个阈值 ,选择满足这个贡献度阈值的特征出来。

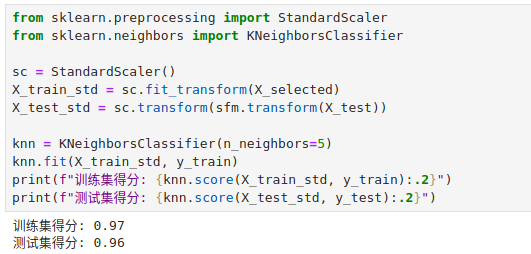

可以看到选择了 5 个特征,现在我们就用这 5 个特征拟合一下 kNN 算法。

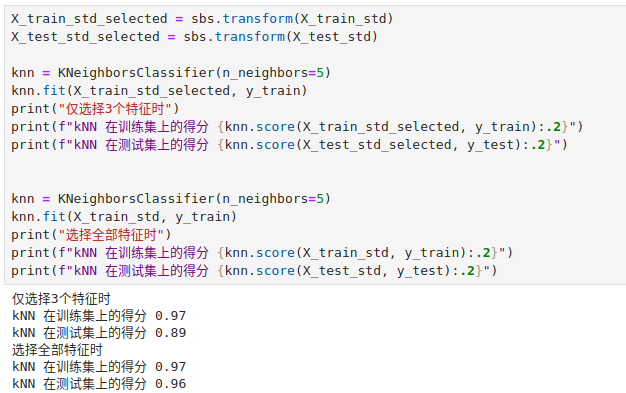

可以对比一下在用 SFS 算法选择的 3 个特征拟合的 kNN 算法。

选择 5 个特征时,模型在训练集和测试集上的表现和选择全部特征的表现相当!

文章来源:https://blog.csdn.net/Gabriel100yi/article/details/135300521

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Halcon利用颜色信息提取背景相似的字符区域

- 蓝凌EIS智慧协同平台 frm_form_upload.aspx 文件上传漏洞复现

- Observability:捕获 Elastic Agent 和 Elasticsearch 之间的延迟

- Linux 操作系统 018-远程文件传输工具

- 不会代码循环断言如何实现?只要6步!

- 如何下载知网论文、专利的PDF格式

- 内核死锁检测--lockdep(linux3.16)

- 模拟电子技术基础 | 功率放大电路 | 期末重点

- 品牌如何把“流量”转为“留量”,媒介盒子分享

- 特征工程-特征处理(三)