梯度的计算

发布时间:2024年01月23日

文章目录

import torch as tc

# 以函数f(x) = x^2 为例子,求梯度

x1 = tc.tensor(1,dtype=tc.float64,requires_grad=True)

g1 = tc.autograd.grad(x1**2,x1)[0]

print(f"The grad of x**2 at {x1} is {g1}")

(x1 ** 2).backward()

print(f"The grad of x**2 at {x1} is {x1.grad} ")

x2 = tc.arange(3,dtype=tc.float64,requires_grad= True)

g2 = tc.autograd.grad(x2**2,x2,grad_outputs=tc.ones_like(x2) )[0]

print(f"The grad of x**2 at {x2.data} is {g2}")

- 逐一分析代码

当然,让我们逐一分析每一部分代码:

-

导入 PyTorch 模块

import torch as tc这一行导入了PyTorch库,并将其别名设置为

tc以方便在代码中使用。 -

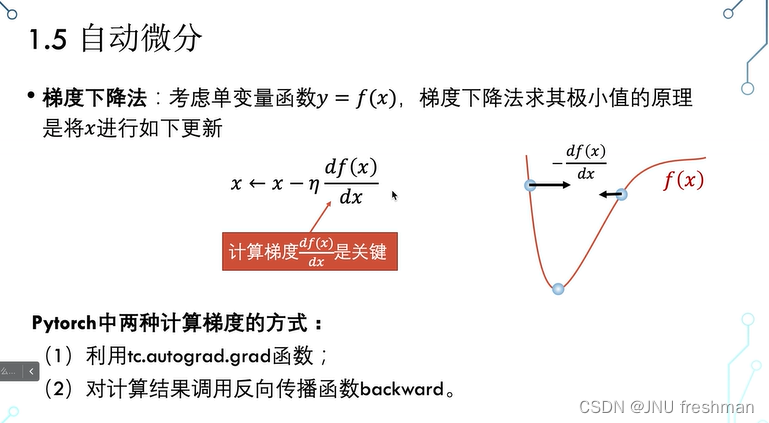

计算梯度例子1

# 创建一个张量 x1,设置为1,数据类型为float64,并启用梯度追踪 x1 = tc.tensor(1, dtype=tc.float64, requires_grad=True) # 使用autograd.grad计算 x1**2 对 x1 的梯度 g1 = tc.autograd.grad(x1**2, x1)[0] print(f"The grad of x**2 at {x1} is {g1}")这一部分代码创建了一个标量张量

x1,并启用了梯度追踪。然后使用autograd.grad计算了函数x1**2相对于x1的梯度,并将结果打印出来。 -

计算梯度例子2

# 使用张量的backward方法计算 x1**2 对 x1 的梯度,并打印结果 (x1 ** 2).backward() print(f"The grad of x**2 at {x1} is {x1.grad}")这一部分使用了PyTorch中张量的

backward方法来计算x1**2对x1的梯度,并将结果打印出来。这种方式也可以用于计算梯度。 -

计算梯度例子3

# 创建一个张量 x2,从0开始,到2结束(不包括2),数据类型为float64,并启用梯度追踪 x2 = tc.arange(3, dtype=tc.float64, requires_grad=True) # 使用autograd.grad计算 x2**2 对 x2 的梯度,同时设置grad_outputs为一个与x2相同形状的张量,值都为1 g2 = tc.autograd.grad(x2**2, x2, grad_outputs=tc.ones_like(x2))[0] print(f"The grad of x**2 at {x2.data} is {g2}")这一部分创建了一个张量

x2,该张量包含值从0到2(不包括2)的浮点数,启用了梯度追踪。然后使用autograd.grad计算了函数x2**2相对于x2的梯度,并设置了grad_outputs参数,最后将结果打印出来。

通过这些注释,你应该能更清楚地理解每一部分代码的作用。

文章来源:https://blog.csdn.net/weixin_74850661/article/details/135773050

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Pix2Pix理论与实战

- LA PEG2K AA,硫辛酸聚乙二醇乙酸,具有硫辛酸的抗氧化特性,可进行定制服务

- Windows Server 2019 OVF, updated Dec 2023 (sysin) - VMware 虚拟机模板

- Arthas

- Git保姆级安装教程

- 存储系统规划可用容量

- Chrome禁用第三方Cookie,有什么影响?

- 关系型非关系型数据库区别,以MongoDB为例在express中连接MongoDB示例

- 全球电商平台API数据稳定接入

- ubuntu 22.04 安装 lfs