深度学习卷积神经网络中常见的激活函数图像绘制python

发布时间:2023年12月27日

论文专用:各个种类的激活函数的图像绘制

import numpy as np

import matplotlib.pyplot as plt

def Sigmoid(x):

y = 1 / (1 + np.exp(-x))

y = np.sum(y)

print(y)

# 画图

xx = np.arange(-10, 10, 0.1)

yy = 1 / (1 + np.exp(-xx))

dy = 1 / (1 + np.exp(-xx)) * (1 - 1 / (1 + np.exp(-xx)))

plt.plot(xx, yy, label='Sigmoid')

plt.plot(xx, dy, label="Sigmoid'")

plt.xlabel("x")

plt.ylabel("f(x)")

plt.legend()

plt.show()

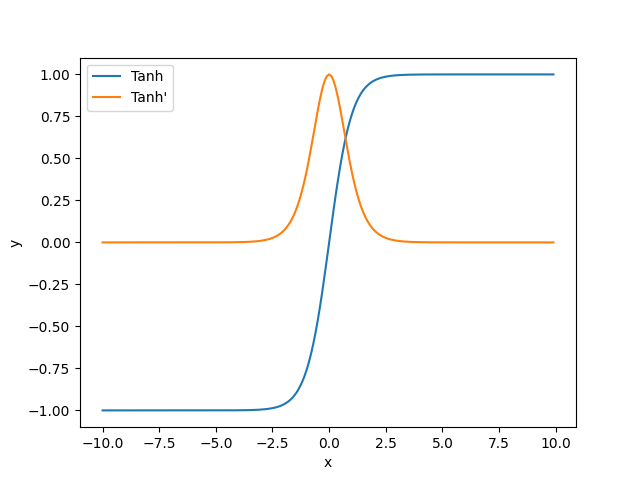

def Tanh(x):

y = (np.exp(x) - np.exp(-x)) / (np.exp(x) + np.exp(-x))

y = np.sum(y)

print(y)

# 画图

xx = np.arange(-10, 10, 0.1)

yy = (np.exp(xx) - np.exp(-xx)) / (np.exp(xx) + np.exp(-xx))

dy = 1 - ((np.exp(xx) - np.exp(-xx)) / (np.exp(xx) + np.exp(-xx))) ** 2

plt.plot(xx, yy, label="Tanh")

plt.plot(xx, dy, label="Tanh'")

plt.xlabel("x")

plt.ylabel("y")

plt.legend()

plt.show()

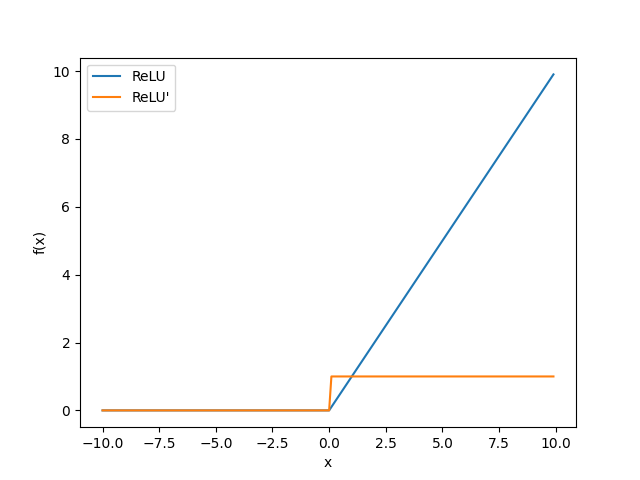

def ReLU(x):

y = np.sum(x[x > 0])

print(y)

# 画图

xx = np.arange(-10, 10, 0.1)

yy = np.where(xx > 0, xx, 0)

dy = np.where(xx > 0, 1, 0)

plt.plot(xx, yy ,label="ReLU")

plt.plot(xx, dy ,label="ReLU'")

plt.xlabel("x")

plt.ylabel("f(x)")

plt.legend()

plt.show()

def Leaky_ReLU(x):

y = np.where(x > 0, x, 0.01 * x)

y = np.sum(y)

print(y)

# 画图

xx = np.arange(-10, 10, 0.1)

yy = np.where(xx > 0, xx, 0.01 * xx)

dy = np.where(xx > 0, 1, 0.01)

plt.plot(xx, yy, label="Leaky_ReLU")

plt.plot(xx, dy, label="Leaky_ReLU'")

plt.xlabel("x")

plt.ylabel("y")

plt.legend()

plt.show()

def SiLU(x):

y = x * (1 / (1 + np.exp(-x)))

y = np.sum(y)

# 画图

xx = np.arange(-10, 10, 0.1)

yy = xx * (1 / (1 + np.exp(-xx)))

dy = 1 / (1 + np.exp(-xx)) * (1 + xx * (1 - 1 / (1 + np.exp(-xx))))

plt.plot(xx, yy, label="SiLU")

plt.plot(xx, dy, label="SiLU'")

plt.xlabel("x")

plt.ylabel("f(x)")

plt.legend()

plt.show()

# ReLU 对比

# ReLU_y = np.where(xx > 0, xx, 0)

# plt.plot(xx, yy, label="SiLU")

# plt.plot(xx, ReLU_y, label="ReLU")

# plt.xlabel("x")

# plt.ylabel("y")

# plt.legend()

# plt.show()

#

# # Sigmoid 对比 SiLU导数和Sigmoid激活函数

# Sigmoid_dy = 1 / (1 + np.exp(-xx))

# plt.plot(xx, dy, label="SiLU'")

# plt.plot(xx, Sigmoid_dy, label="Sigmoid'")

# plt.xlabel("x")

# plt.ylabel("y")

# plt.legend()

# plt.show()

def tanh(x):

return (np.exp(x) - np.exp(-x)) / (np.exp(x) + np.exp(-x))

def softplus(x):

return np.log(1 + np.exp(x))

def Mish(x):

y = x * tanh(softplus(x))

y = np.sum(y)

print(y)

# 画图

xx = np.arange(-10, 10, 0.1)

yy = xx * tanh(softplus(xx))

Omega = 4 * (xx + 1) + 4 * np.exp(2 * xx) + np.exp(3 * xx) + (4 * xx + 6) * np.exp(xx)

Delta = 2 * np.exp(xx) + np.exp(2 * xx) + 2

dy = (np.exp(xx) * Omega) / Delta ** 2

plt.plot(xx, yy, label="Mish")

plt.plot(xx, dy, label="Mish'")

plt.xlabel("x")

plt.ylabel("y")

plt.legend()

plt.show()

if __name__ == "__main__":

x = np.random.randn(10)

print(x)

Sigmoid(x)

Tanh(x)

ReLU(x)

Leaky_ReLU(x)

SiLU(x)

Mish(x)

文章来源:https://blog.csdn.net/m0_68738477/article/details/135247600

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 15个必知的Mysql索引失效场景,别再踩坑了!

- Linux系统使用超详细(十)~vi/vim命令②

- OpenAI 官方的 Prompt 工程指南:你可以这么玩ChatGPT

- 可拖拽表单比传统表单好在哪里?

- SQL注入攻击

- SQL指南:掌握日期函数来查询和管理数据

- 2023年第十六届中国系统架构师大会(SACC2023):核心内容与学习收获(附大会核心PPT下载)

- doris批量创建分区

- 实战——Mac M2 安装mat工具

- Linux———ifconfig命令详解