ceph存储服务结构介绍以及速度优化的方法

ceph存储服务结构介绍:

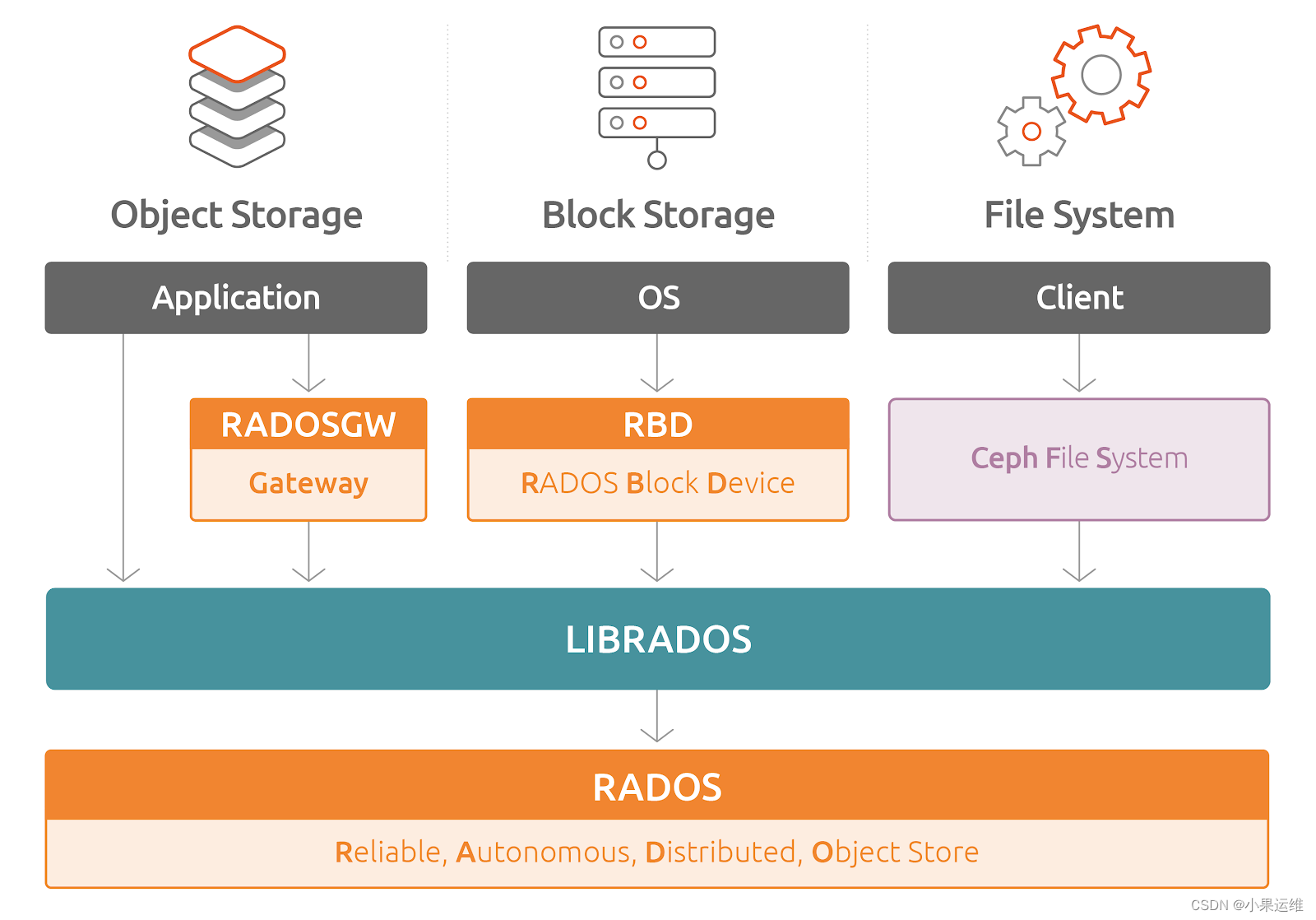

Ceph 提供了多种存储服务,包括 CephFS、RBD、RADOS Gateway (RGW) 以及通过 Librados 和 RADOS 库提供的服务。以下是这些存储服务的简要介绍和结构:

-

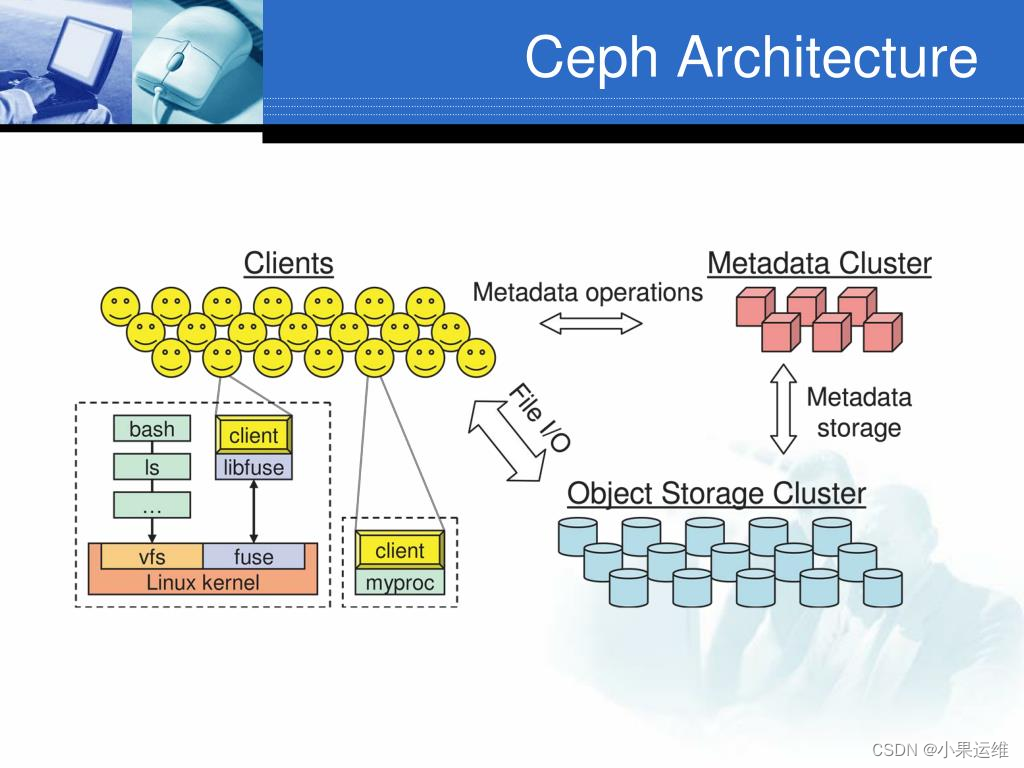

CephFS(Ceph 文件系统):

- 结构:CephFS 是 Ceph 提供的分布式文件系统,它基于 RADOS(可扩展自动分布式对象存储)构建。CephFS 包括 Metadata Server(MDS)和 OSD 组件。

- 工作原理:MDS 负责维护文件系统的元数据信息,如目录结构、权限信息和文件属性等。OSD 负责存储文件数据,通过 RADOS 存储对象来支持文件存储。

-

RBD(RADOS 块设备):

- 结构:RBD 允许在 Ceph 集群上创建、管理和映射块设备。它将块设备映射到客户端,类似于直接连接物理硬盘。

- 工作原理:RBD 利用 RADOS 提供块设备服务,并且支持快照、克隆和镜像等功能。它可以被用于虚拟机镜像、容器存储和其他需要块存储的场景。

-

RADOS Gateway (RGW):

- 结构:RGW 是 Ceph 的对象存储接口,兼容 Amazon S3 和 OpenStack Swift API。它允许通过 RESTful 接口访问对象存储。

- 工作原理:RGW 通过 RADOS 提供对象存储服务,使得开发者可以利用对象存储功能构建基于云存储的应用程序,实现对象级别的数据存储和访问。

-

Librados 和 RADOS:

- 结构:Librados 是 Ceph 提供的客户端库,用于与 RADOS 集群进行交互。RADOS 是 Ceph 的核心组件,提供对象存储服务。

- 工作原理:使用 Librados 库,开发者可以通过 RADOS 集群执行对象级别的操作,包括读取、写入、删除对象等。这为开发者提供了直接与 Ceph 存储集群交互的接口。

这些存储服务构成了 Ceph 强大且多样化的存储功能。每种服务都针对不同的存储需求和场景,提供了灵活的、高性能的分布式存储解决方案。用户可以根据需求选择适合的存储服务来构建应用程序或满足特定的存储需求。

ceph速度优化建议

优化 Ceph 的速度通常需要考虑多个方面,包括硬件优化、软件配置和网络优化等。下面是一些改进 Ceph 性能的常见方法:

-

硬件优化:

- 存储介质:选择高性能的硬盘或固态硬盘 (SSD) 作为存储介质可以提高 Ceph 的性能。

- 网络:使用高速网络设备,如以太网 (Ethernet) 或 InfiniBand,以减少网络延迟和提高带宽。

- 硬件配置:调整服务器的配置,例如增加内存、CPU 核心数等,以满足 Ceph 集群的需求。

-

软件配置:

- 调整 OSD(对象存储守护进程)数量:增加 OSD 可以提高性能,但需要注意避免过多 OSD 导致管理和维护困难。

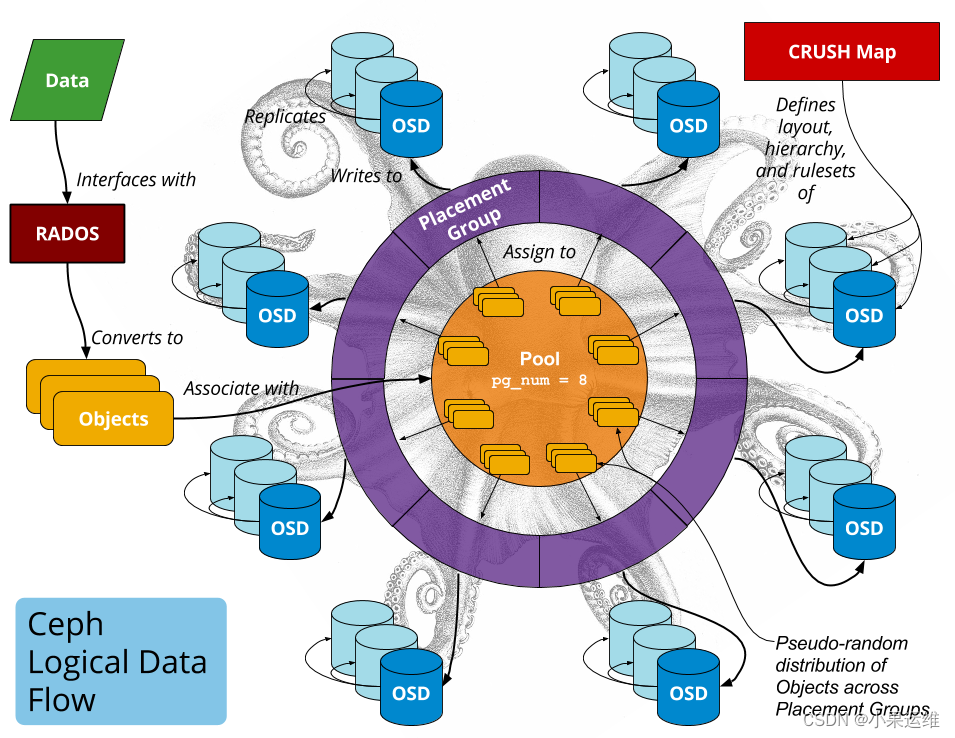

- 调整 PG(placement group)数量:合理配置 PG 数量可以提高负载均衡和性能。

- 优化 CRUSH 映射:CRUSH 是 Ceph 用来确定数据位置的算法,优化 CRUSH 映射可以改善数据分布和读写性能。

- 调整缓存:使用 SSD 作为日志或元数据的缓存可以改善性能。

-

软件更新和版本管理:

- 保持更新:定期更新 Ceph 版本,因为新版本通常会修复漏洞并提高性能。

- 优化配置文件:调整 Ceph 配置文件以优化性能,例如调整日志级别、调整线程池大小等。

-

监控和调优:

- 性能监控:使用工具监控 Ceph 集群的性能,及时发现瓶颈并进行调整。

- 测试和基准测试:进行基准测试以评估性能改进的效果,并根据测试结果调整配置。

-

数据平衡:

- 数据迁移:定期进行数据迁移,避免数据在 OSD 之间不均衡分布。

-

网络优化:

- 网络拓扑优化:优化网络拓扑结构,减少网络延迟和提高带宽。

- QoS(服务质量)设置:设置适当的 QoS,确保 Ceph 数据流的优先级和带宽。

-

调整参数和配置:

- Ceph 参数调整:根据实际情况调整 Ceph 的参数,例如调整线程数、缓存大小等。

-

OSD 参数调整:

osd_max_scrubs:限制每个 OSD 同时进行的数据恢复和检查次数,默认为 1。可适当增加以加速数据恢复。osd_scrub_during_recovery:允许在数据恢复期间进行数据校验和修复。启用此选项可能会影响恢复速度。osd_recovery_max_active和osd_recovery_op_priority:调整 OSD 恢复操作的并发度和优先级。

-

CRUSH 参数调整:

osd_crush_update_on_start:启用后,OSD 启动时将立即更新 CRUSH 映射,以便更快地适应新的设备或拓扑变化。osd_crush_initial_weight:设置新 OSD 的初始权重,以影响数据分布。osd_pool_default_pg_num和osd_pool_default_pgp_num:调整默认 PG 数量和预分配 PG 的数量,根据存储需求和数据分布进行调整。

-

调整缓存和日志:

osd_op_threads和osd_disk_threads:调整 OSD 的操作线程数和磁盘线程数。osd_memory_target:指定每个 OSD 进程可用内存的目标值。osd_max_backfills:限制并行的后台填充作业数量。- 调整

osd_journal_size(日志大小)和osd_max_backfill(最大后台填充数量)等参数来优化性能。

-

网络和带宽调整:

osd_client_message_size_cap:调整客户端消息大小的上限。osd_max_pg_per_osd:控制每个 OSD 上的 PG 数量,以避免过载和网络拥塞。osd_pool_default_min_size:调整最小副本数以确保数据冗余性。

优化 Ceph 的速度是一个持续的过程,需要综合考虑硬件、软件和网络等多个因素。在进行任何改变之前,请务必备份重要数据,并谨慎地测试和评估每一项改进的效果,以避免对生产环境造成负面影响。

ceph参数优化样例:

OSD 参数优化样例:

# 调整每个 OSD 同时进行的数据恢复和检查次数

osd_max_scrubs = 4

# 允许在数据恢复期间进行数据校验和修复

osd_scrub_during_recovery = true

# 调整 OSD 恢复操作的并发度和优先级

osd_recovery_max_active = 10

osd_recovery_op_priority = 3

# 启用 OSD 启动时立即更新 CRUSH 映射

osd_crush_update_on_start = true

# 调整新 OSD 的初始权重

osd_crush_initial_weight = 1.0

# 调整默认 PG 数量和预分配 PG 的数量

osd_pool_default_pg_num = 128

osd_pool_default_pgp_num = 128

网络和带宽调整样例:

# 调整客户端消息大小的上限

osd_client_message_size_cap = 131072

# 控制每个 OSD 上的 PG 数量

osd_max_pg_per_osd = 200

# 调整最小副本数以确保数据冗余性

osd_pool_default_min_size = 2

缓存和日志调整样例:

# 调整 OSD 操作线程数和磁盘线程数

osd_op_threads = 16

osd_disk_threads = 4

# 指定每个 OSD 进程可用内存的目标值

osd_memory_target = 8589934592 # 8GB

# 限制并行的后台填充作业数量

osd_max_backfills = 2

# 调整日志大小和最大后台填充数量等参数

osd_journal_size = 1024 # MB

rbd参数调优

在 Ceph 中调整 RBD(RADOS 块设备)的性能,可以通过调整一些参数来优化其性能和稳定性。以下是一些常见的 RBD 参数和建议调优配置:

设置文件路径

通常,Ceph 配置位于 /etc/ceph/ 目录下。在该目录下有一个名为 ceph.conf 的配置文件,用于配置 Ceph 的全局参数。同时,每个 OSD 和 Monitor 也会有相应的配置文件。

RBD 参数调优建议

1. 对象大小调整

-

rbd_default_stripe_unit:用于指定 RBD 镜像的条带单位大小。适当的条带大小能够提高性能,可以根据存储负载和硬件配置进行调整。rbd_default_stripe_unit = 4096 # 4KB -

rbd_default_stripe_count:指定条带数量。同样,根据需求进行调整。rbd_default_stripe_count = 1

2. 缓存设置

rbd_cache:设置 RBD I/O 缓存策略。启用缓存可以提高性能,但可能会增加内存使用量。rbd_cache = true

3. QoS 设置

rbd_qos_bps_limit和rbd_qos_iops_limit:可用于限制每个 RBD 镜像的带宽和 IOPS。这有助于避免某个镜像对整个系统的性能影响。rbd_qos_bps_limit = 100M # 限制带宽为 100MB/s rbd_qos_iops_limit = 500 # 限制 IOPS 为 500

4. 其他设置

rbd_blacklist_expire_seconds:如果发生错误,该参数设置了在黑名单中保持的时间长度(以秒为单位)。rbd_blacklist_expire_seconds = 60

示例配置

[rbd]

rbd_default_stripe_unit = 4096

rbd_default_stripe_count = 1

rbd_cache = true

rbd_qos_bps_limit = 100M

rbd_qos_iops_limit = 500

rbd_blacklist_expire_seconds = 60

请注意,这些参数的值应根据实际环境和需求进行调整。在更改这些参数之前,请先在测试环境中进行验证和评估,以确保对性能产生预期的影响。

cephfs服务调优

优化 CephFS(Ceph 文件系统)的性能需要综合考虑多个方面,包括 MDS(Metadata Server)、存储节点、网络、客户端等。以下是一些常见的 CephFS 服务优化配置建议:

MDS 参数调优

MDS 并发度

mds_cache_size:调整 MDS 元数据缓存大小,适当增加可提高性能。mds_cache_size = 100000 # 设置缓存大小为 100,000

MDS 相关设置

mds_log_max_segments和mds_log_max_events:调整 MDS 日志的分段和事件数量。mds_log_max_segments = 1000 mds_log_max_events = 100000

存储节点参数调优

OSD 配置

- 对 OSD 节点的参数优化(如在前述答案中提到的 OSD 参数调优),确保 OSD 节点的性能和稳定性。

客户端参数调优

客户端并发连接

client_mount_timeout和client_tick_interval:调整客户端挂载超时和间隔时间。client_mount_timeout = 30 client_tick_interval = 5

其他建议

- 确保网络稳定性和带宽:CephFS 对网络的稳定性和带宽要求较高,优化网络可以提升性能。

- 考虑合理的数据分布和 PG 数量:适当配置 PG(Placement Group)数量来平衡数据分布。

- 定期执行文件系统检查:定期执行

ceph fs check来检查文件系统并修复潜在的问题,确保文件系统的健康状态。

ceph?pg数量设置建议和依据

PG(Placement Group)数量对于 Ceph 集群的性能和数据分布至关重要。适当设置 PG 数量可以影响存储性能、数据平衡和系统稳定性。以下是一些建议和依据,可作为设置 PG 数量的优化建议:

PG 数量设置的依据:

-

总 OSD 数量:

- 通常,PG 的数量应该与 OSD 数量有关联,以便在数据存储上实现合理的分布和负载均衡。较多的 OSD 数量可能需要更多的 PG 以实现更好的数据分散和负载平衡。

-

数据容量:

- 数据容量与 PG 数量之间存在关系。较大的数据容量可能需要更多的 PG 来确保数据的均匀分布。

-

工作负载类型:

- 不同的工作负载对 PG 数量有不同的需求。例如,写入密集型的工作负载可能需要更多的 PG 以支持更高的并发写入操作。

-

数据分布平衡:

- 适当的 PG 数量有助于实现数据在 OSD 上的均匀分布,避免出现某些 OSD 负载过重或数据不均衡的情况。

PG 数量设置的优化建议:

-

根据 OSD 数量设置 PG:

- 一般推荐每个 OSD 设置 100 到 200 个 PG。例如,如果你有 10 个 OSD,你可以考虑设置 1000 到 2000 个 PG。

-

监控集群状态:

- 监控集群状态,包括 OSD 负载、数据平衡情况和性能指标,根据实际情况进行调整。

-

避免过多的 PG:

- 设置过多的 PG 数量可能会导致过度的元数据操作和管理开销。过多的 PG 也可能增加系统复杂性。

-

小规模集群和大规模集群的区别:

- 在小规模集群中,可以适当减少 PG 数量以降低系统复杂性。而在大规模集群中,可能需要更多的 PG 来保证数据的均匀分布和负载均衡。

-

动态调整:

- Ceph 提供了动态调整 PG 数量的能力。可以根据实际运行情况,利用

ceph osd pool set命令动态调整 PG 数量。

- Ceph 提供了动态调整 PG 数量的能力。可以根据实际运行情况,利用

注意事项:

- 调整 PG 数量时,可能需要重新创建 pool,因为 PG 数量的调整会影响 pool 的配置。

- 在调整 PG 数量之前,请确保已经备份了重要数据,并在生产环境之前进行充分测试和评估。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- mysql-3-可视化工具使用

- 肯尼斯·里科《C和指针》第6章 指针(1)

- 加法器原理详解

- 面试算法71:按权重生成随机数

- 鸿蒙APP的代码规范

- eDP?OpenLDI桥接IC(S2D13V70)

- Vue3中ref和reactive的区别

- 视频和音频怎么合并在一起?分享3个轻松合并的实用技巧

- IDEA 中搭建 Spring Boot Maven 多模块项目 (父SpringBoot+子Maven)

- 腾讯云轻量服务器4核8G12M有三年优惠价表