51、全连接 - 特征的全局融合

发布时间:2024年01月05日

Resnet50 中的核心算法,除了卷积、池化、bn、relu之外,在最后一层还有一个全连接。

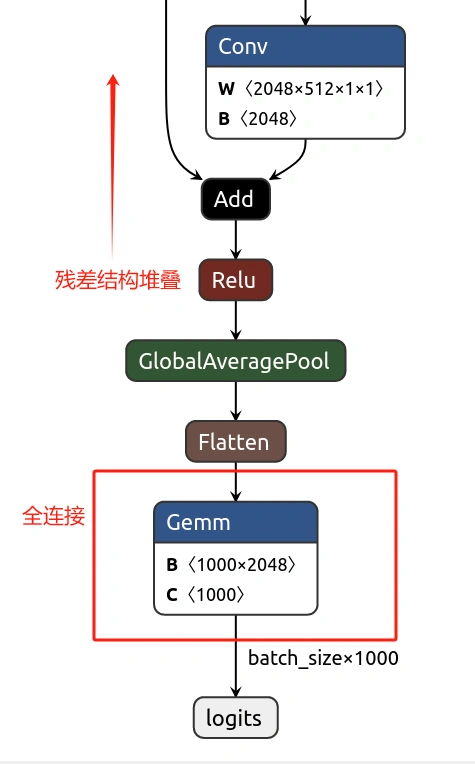

下图是 Resnet50 网络结构结尾的部分,最后一层 Gemm(通用矩阵乘法)实现的就是全连接操作。而矩阵乘法我们之前介绍过,传送门在:矩阵乘。

卷积也好,矩阵乘法也好,其目的都是为了完成神经网络中的特征融合,这是其本质。

神经网络的运算,也是为了更好的完成输入数据的特征提取和融合,从而识别一张图片、一个句子。

那么,全连接层和卷积层甚至矩阵乘法又有什么区别和联系呢?

1、全连接层

全连接层(Fully Connected Layer),也称为密集连接层(Dense Layer),在全连接层中,每个神经元与前一层的每个神经元都有连接,每个连接都有一个权重,形成一个完全连接的网络结构。

这种全连接的方式与卷积和池化不同,卷积和池化是通过固定大小的卷积核或池化窗口在输入上移动,

文章来源:https://blog.csdn.net/dongtuoc/article/details/135397417

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 使用C语言创建高性能网络爬虫IP池

- 文心一言 VS 讯飞星火 VS chatgpt (165)-- 算法导论13.1 5题

- YOLOv8目标检测中数据集各部分的作用

- SSM—Mybatis

- Confluence6+mysql5.7安装避坑详细记录

- CNAS中兴新支点——什么是黑盒测试,白盒测试,有什么区别

- OpenHarmony—Docker编译环境

- COMSOL中绘制局部结果云图

- 2024年最新C语言入门实战系列教程-嵌入式必备-IT营大地老师

- 晚期食管癌肿瘤治疗线程分类