LLM4Drive: A Survey of Large Language Models for Autonomous Driving

LLM4Drive: A Survey of Large Language Models for Autonomous Driving

摘要

自动驾驶技术是交通和城市交通革命的催化剂,它有从基于规则的系统过渡到数据驱动战略的趋势。传统的基于模块的系统受到级联模块间累积误差和预设规则不灵活的限制。相比之下,端到端自动驾驶系统由于其完全数据驱动的训练过程,有可能避免错误积累,尽管由于其“黑匣子”性质,它们往往缺乏透明度,使决策的验证和可追溯性变得复杂。最近,大型语言模型(LLM)已经展示了理解上下文、逻辑推理和生成答案的能力。一个自然的想法是利用这些能力来实现自动驾驶。通过将LLM与基础视觉模型相结合,它可以为开放世界的理解、推理和少量学习打开大门,而这正是当前自动驾驶系统所缺乏的。本文系统地回顾了自动驾驶大语言模型(LLM 4AD)的研究进展。本研究评估了技术进步的现状,明确概述了该领域的主要挑战和未来方向。为了方便学术界和工业界的研究人员,我们通过指定链接提供该领域的最新进展以及相关开源资源的实时更新:Github添加链接描述.

1.介绍

自动驾驶正在迅速重塑我们对交通的理解,预示着一个新的技术革命时代的到来。这种转变不仅意味着交通运输的未来,也意味着各个行业的根本转变。在传统的自动驾驶系统中,算法通常采用模块化设计[Liang等人,2020年; Luo等人,2018; Sadat等人,2020],具有负责诸如感知等关键任务的单独组件[Li等人,2022 c; Liu等人,2023 d],预测[Shi等人,2022; Jia等人,2022 a; Jia等人,2023 c],和规划[Treiber等人,2000; Dauner等人,2023年]。具体地,感知组件处理对象检测[Li等人,2022 c; Liu等人,2023 d],跟踪[Zeng等人,2022]和复杂的语义分割任务[Cheng et al.,2022年]。预测组件分析外部环境[Jia等人,2021]并估计周围代理的未来状态[Jia等人,2022 b]。规划部分通常依赖于基于规则的决策算法[Treiber等人,2000],确定到达预定目的地的最佳和最安全的路线。虽然基于模块的方法在各种场景中提供了可靠性和增强的安全性,但它也带来了挑战。系统组件之间的解耦设计可能导致在转换期间的关键信息丢失以及潜在的冗余计算。此外,由于模块之间的优化目标不一致,误差可能在系统内累积,从而影响车辆的整体决策性能[Chen等人,2023 a]。

基于规则的决策系统,由于其固有的局限性和可扩展性问题,正逐渐让位于数据驱动的方法。**端到端的自动驾驶解决方案越来越成为该领域的共识[**Wu et al.,2022 b; Chitta等人,2023; Chen和Krüahenbüuhl,2022; Jia等人,2023 d; Jia等人,2023 b; Hu等人,2023 b]。通过消除多个模块之间的集成误差并减少冗余计算,端到端系统增强了视觉的表达[Wu et al.,2022 a]和感官信息,同时确保更高的效率。然而,这种方法也引入了“黑箱”问题,即决策过程缺乏透明度,使解释和验证复杂化。

与此同时,自动驾驶的可解释性已成为一个重要的研究焦点[Jin et al.,2023 a]。虽然较小的语言模型(如BERT的早期版本[Devlin等人,2018]和GPT [Brown等人,2020年])用于从驾驶场景中收集大量数据有助于解决这个问题,但它们往往缺乏足够的泛化能力来实现最佳性能。最近,大型语言模型[OpenAI,2023; Touvron等人,2023]在理解上下文、生成答案和处理复杂任务方面表现出卓越的能力。它们现在也与多模态模型集成[Brohan等人,2023 a; Liu等人,2023 a; Driess等人,2023年; Xu等人,2023年; Chen等人,2023 b]。这种集成实现了图像、文本、视频、点云等的统一特征空间映射。这种整合显著增强了系统的泛化能力,并使其能够以零拍摄或少拍摄的方式快速适应新场景。

在此背景下,开发可解释且高效的端到端自动驾驶系统成为研究热点[Chen et al.,2023 a]。大型语言模型具有广泛的知识基础和卓越的泛化能力,可以更容易地学习复杂的驾驶行为。通过利用视觉语言模型(VLM)强大而全面的开放世界理解和上下文学习能力[Bommasani等人,2021; Brohan等人,2023 b(Rt-2: Vision-language-action models transfer web knowledge to robotic control;) Liu等人(Visual instruction tuning),2023 a; Driess等人,[2023],可以解决感知网络的长尾问题,帮助决策,并为这些决策提供直观的解释。

本文旨在对这一迅速兴起的研究领域进行全面概述,分析其基本原理、方法和实现过程,并详细介绍LLM在自动驾驶中的应用。最后,我们讨论了相关的挑战和未来的研究方向。

2.Motivation of LLM4AD

在当今的技术环境中,大型语言模型,如GPT-4和GPT-4V [OpenAI,2023; Yang等人,2023 c]以其上级上下文理解和上下文学习能力引起了人们的注意。他们丰富的常识知识促进了许多下游任务的重大进展。我们提出这样一个问题:这些大型模型如何帮助自动驾驶领域,特别是在决策过程中发挥关键作用?

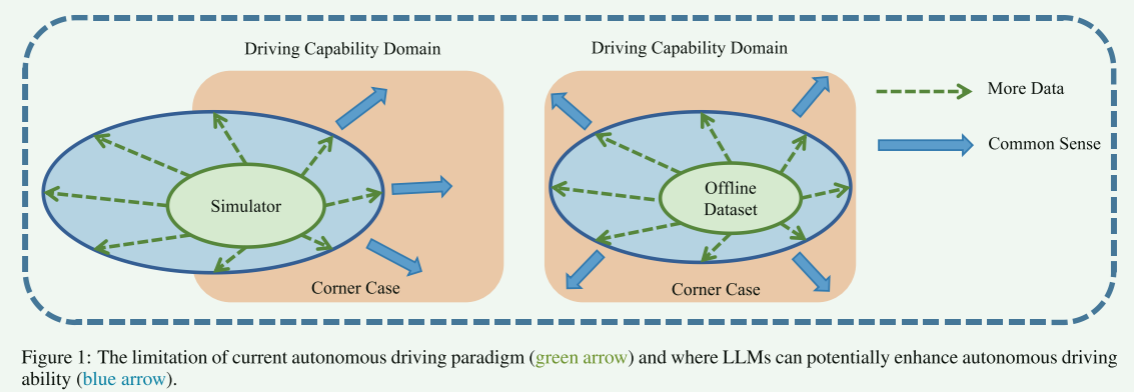

图一:当前自动驾驶模式的局限性(绿色箭头)以及LLM可以潜在地增强自动驾驶能力的地方(蓝色箭头)。

在图1中,我们给予一个直观的示范,目前的自动驾驶模式的局限性和LLM可以潜在地提高自动驾驶能力。我们总结了驾驶技能的两个主要方面。橙子圆圈代表驾驶能力的理想水平,类似于经验丰富的人类驾驶员所拥有的水平。

有两种主要方法可以获得这种熟练程度:一是通过模拟环境中基于学习的技术;二是通过类似的方法从离线数据中学习。重要的是要注意,由于模拟和真实的世界之间的差异,这两个领域并不完全相同,即sim 2真实的差距[Hücket al.,2021年]。同时,离线数据作为真实世界数据的子集,因为它是直接从实际环境中收集的。然而,由于臭名昭著的长尾性质,也很难完全覆盖该分布[Jain等人,2021年]的自动驾驶任务。

自动驾驶的最终目标是通过广泛的数据收集和深度学习,将驾驶能力从基本的绿色阶段提升到更高级的蓝色水平。然而,与数据收集和注释相关的高成本,沿着模拟和现实环境之间的固有差异,意味着在达到驾驶技能的专家水平之前仍然存在差距。在这种情况下,如果我们能够有效地利用嵌入在大型语言模型中的先天常识,我们可能会逐渐缩小这一差距。直觉上,通过采用这种方法,我们可以逐步增强自动驾驶系统的能力,使其更接近或可能达到理想的专家驾驶水平。通过这种技术整合和创新,我们预计自动驾驶的整体性能和安全性将得到显著改善。

大语言模型在自动驾驶领域的应用确实涵盖了广泛的任务类型,将深度和广度结合起来,具有革命性的潜力。自动驾驶管道中的LLM如图2所示。

3.Application of LLM4AD

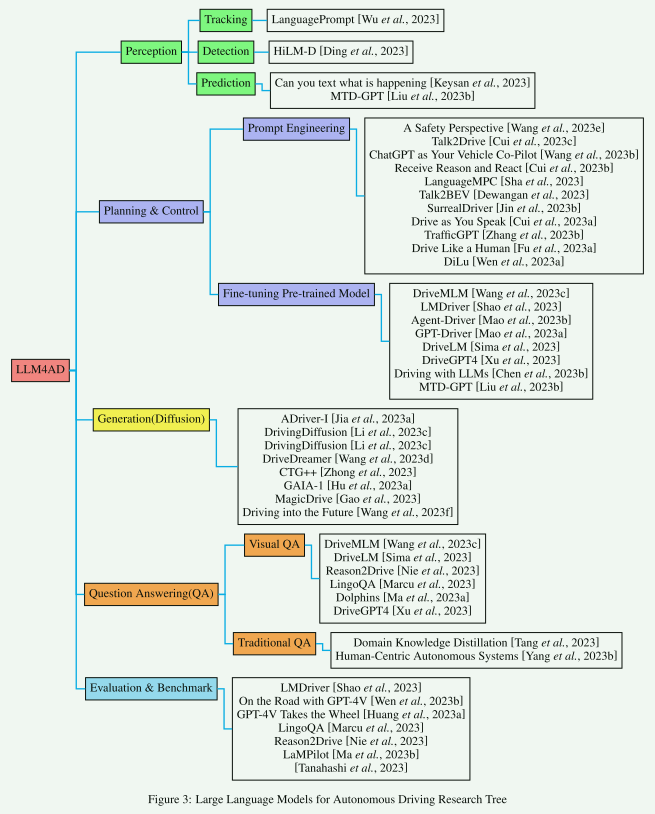

在下面的部分中,我们根据应用LLM的角度划分现有的工作:规划,感知,问题回答和生成。相应的分类树如图3所示。

3.1Planning & Control

大型语言模型(LLM)凭借其开放世界认知和推理能力取得了巨大成功[拉德福等人,2018;拉德福等人,2019; Brown等人,2020; Ouyang等人,2022; OpenAI,2023]。这些功能可以为自动驾驶决策过程提供透明的解释,显著增强系统可靠性和用户对该技术的信任[Deruyttere等人,2019年; Kim等人,2019 a; Atakishiyev等人,2023; Jin等人,2023 a; Malla等人,2023年]。在这个领域中,根据是否调整LLM,相关研究可以分为两种主要类型:微调预训练模型和即时工程。

微调预训练模型

在微调预训练模型的应用中,MTDGPT [Liu等人,将多任务决策问题转化为序列建模问题。通过在混合多任务数据集上进行训练,它解决了无信号交叉口的各种决策任务。虽然这种方法优于单任务决策RL模型的性能,但所使用的场景仅限于无信号交叉口,这可能足以证明真实的世界应用程序的复杂性。Driving with LLMs [Chen等人,2023 b]设计了一种架构,该架构使用两阶段预训练和微调方法将向量化输入融合到LLM中。由于矢量化表示的局限性,他们的方法只在仿真中进行了测试。DriveGPT 4 [Xu等人,2023]提出了一种基于Valley的多模态LLM [Luo等人,2023 a]并开发了用于可解释的自动驾驶的视觉指令调整数据集。除了预测车辆的基本控制信号外,它还能实时响应,解释采取行动的原因。它在各种QA任务中的性能优于基线模型,而有关规划的实验是简单的。GPT-Driver [Mao等人,2023 a]将运动规划任务转换为语言建模问题。它超过了UniAD[Hu等人,2023 b]中。然而,由于它使用过去的速度和加速度信息,因此担心与UniAD进行不公平的比较。此外,L2仅反映驾驶路线的拟合程度,而可能不反映驾驶性能[Dauner等人,2023年]。Agent-Driver [Mao等人,2023 b]利用LLM常识和强大的推理能力,通过设计工具库,认知记忆和推理引擎来提高规划能力。该范例在nuScenes数据集上实现了更好的结果。同时,缩短推理时间也是一个亟待解决的问题。DriveLM [Sima等人,2023]使用轨迹标记器将自我轨迹信号处理为文本,使它们属于同一域空间。这样的标记器可以应用于任何一般的视觉语言模型。此外,他们利用图结构推理与逻辑顺序的多个QA对,从而提高最终的规划性能。[Wang例如,2023 b]将LLM适配为驾驶的车辆“副驾驶员”,其可以基于所提供的信息在满足人类意图的情况下完成特定的驾驶任务。在复杂的交互场景中缺乏验证。LMDrive [Shao等人,2023]设计了一个多模态框架来预测控制信号和给定指令是否完成。它采用Resnet [He et al.,2016]作为尚未经过图像-文本对齐预训练的视觉编码器。此外,它还引入了一个基准LangAuto,其中包括大约64 K的CARLA后续数据剪辑。LangAuto基准测试系统处理复杂指令和具有挑战性的驾驶场景的能力。DriveMLM [Wang等人,2023 c]采用多模态LLM(Multi-view image,Point cloud,and prompt)生成高层决策命令,并使用Apollo作为规划器获取控制信号。此外,训练数据由专家生成,并使用GPT-3.5来增加数据多样性。它在CARLA Town 05 Long上取得了76.1的驾驶成绩,达到了经典端到端自动驾驶的水平。

prompt engineering

在提示工程的视角下,一些方法试图通过巧妙的提示设计来挖掘LLMS的深层推理潜力。Dilu[wen et al.,2023a]设计了一种LLMS框架作为智能体来解决闭环驾驶任务。这种方法引入了一个记忆模块来记录经验,利用LLM来促进推理和反思过程。与基于Sota RL的方法相比,DILU具有更强的泛化能力。然而,推理和反思过程需要多轮问答,其推理时间不容忽视。同样,接受理性并做出反应[崔等人,2023b]和边说边开车[崔等人,2023a]将LLMS的语言和推理能力整合到自动驾驶车辆中。除了记忆和反射过程外,这些方法还引入了额外的原始传感器信息,如相机、GNSS、激光雷达和雷达。然而,推理速度也没有得到解决。此外,SurrealDriver[jin等人,2023b]将记忆模块分为短期记忆、长期指导方针和安全标准。与此同时,该公司采访了24名司机,并将他们对驾驶行为的详细描述作为思维链提示,开发了一个“教练代理”模块。然而,缺乏与传统算法的比较来证明大型语言模型确实能带来性能提升。LanguageMPC[Shaet al.,2023]还为驾驶场景中的LLMS设计了一个链式框架,并通过引导参数矩阵自适应与低级控制器集成。虽然它在简化的模拟器环境中的性能优于基于MPC和RL的方法,但在复杂环境下缺乏验证。TrafficGPT[Zhang et al.,2023b]是ChatGPT和交通基础模型的融合,可以处理复杂的交通相关问题并提供有洞察力的建议。它利用多模式数据作为数据源,为各种与交通相关的任务提供全面支持。Talk2BEV[Dewangan等人,2023]为自动驾驶环境中的鸟瞰(BEV)地图引入了一个大型视觉语言模型(LVLM)界面。它不需要任何训练或微调,只依赖于预先训练的图像语言模型。此外,它还为评估用于AD应用的LVLMS的后续工作提供了一个基准。Talk2Drive[Cui等人,2023a]利用人类的语言命令,根据上下文信息做出自动驾驶决定,以满足人们对安全、效率和舒适性的个性化偏好。

Metric:

MTD-GPT [Liu等人,2023 b]使用单个子任务成功率作为模拟中的度量,并且它超过了RL专家。DriveGPT 4 [Xu等人,2023]使用均方根误差(RMSE)和阈值精度进行评估。在车辆动作描述、理由和完整句子中,它使用BLEU-4 [Papineni等人,2002]、METEOR [Banerjee和Lavie,2005]、CIDER[Vedantam等人,2015]并讨论交通灯检测的准确性以及用于交通灯距离预测的以米为单位的平均绝对距离误差。除了与感知相关的指标外,它还使用GPT-3.5对模型的答案进行评分,这是一种最近出现的技术-对自然语言响应进行评分[Fu et al.,2023 b; Wang等人,2023 a; Liu等人,2023 c]。DiLu [Wen等人,2023 a]使用模拟中的成功步骤作为评估泛化和转换能力的度量。SurrealDriver [Jin等人,2023 b]基于两个主要维度评估代理:安全驾驶能力和人性化。通过碰撞率评估安全驾驶能力,而通过24名法律的驾驶成年参与者(年龄29.3 ± 4.9岁,男性= 17岁)的用户实验评估人类相似性。[Sha et al.,自定义一些度量:故障/碰撞情况、交通流的效率、自我车辆的时间成本以及自我车辆的驾驶行为的安全性。类似地,Talk 2BEV [Dewangan等人,[2023]从空间推理、实例属性、实例计数和视觉推理的角度来衡量他们的方法。GPT-Driver [Mao等人,2023 a]、DriveLM [Sima等人,2023]和Agent-Driver [Mao等人,2023 b]包含两个度量:L2错误(以米为单位)和冲突率(以百分比为单位)。通过测量计划轨迹和离线记录的人类驾驶员轨迹中每个路点的距离来计算平均L2误差。它反映了计划轨迹与人类驾驶轨迹的拟合。碰撞率是通过在规划轨迹的每个航路点放置自我车辆框,然后检查与其他对象的地面实况边界框的碰撞来计算的。它反映了计划轨迹的安全性。LMDrive [Shao等人,2023]和DriveMLM[Wang等人,2023 c]采用CARLA的官方指标,包括驾驶分数(DS),路线完成(RC),违规分数(IS)。目前,LLM 4AD关于规划任务缺乏一个统一的度量标准,无法统一评估每种方法与传统方法之间的利弊。

3.2 Perception

大型语言模型已经在“感知”任务中证明了其独特的价值和强大的能力[拉德福等人,2021年; Li等人,2022 b; Li等人,2023 a; Li等人(Blip-2: Bootstrapping language-image pre-

training with frozen image encoders and large language models,2)023 b(Graph-based topology reasoning for driving scenes.;) Li等人,2022 a]。特别是在数据相对稀缺的环境中,这些模型可以依靠其少拍学习特性来实现快速准确的学习和推理[P et al.,2023; Lin等人,2023年]。这种学习能力在自动驾驶系统的感知阶段具有重要意义,大大提高了系统在变化和复杂驾驶环境中的适应性和泛化能力。Wu等人,2023]在提示推理分支中融合交叉模态特征以预测3D对象。它使用语言提示作为语义线索,并将LLM与3D检测任务和跟踪任务相结合。虽然与其他方法相比,它实现了更好的性能,但LLM的优点并不直接影响跟踪任务。相反,跟踪任务用作查询以帮助LLM执行3D检测任务。HiLM-D [Ding等人,2023]将高分辨率信息纳入多模态大型语言模型,用于风险对象定位和意图和建议预测(ROLISP)任务。它将LLM与2D检测任务相结合,与其他多模态大型模型(如Video-LLaMa)相比,在检测任务和QA任务中获得更好的性能[Zhang et al.,2023 a]、ePALM [Shukor等人,2023年]。值得注意的是,该数据集的一个潜在限制是:每个视频只包含一个风险对象,这可能无法捕捉到现实世界场景的复杂性。[Keysan等人,2023]集成了预先训练的语言模型作为基于文本的输入编码器,用于自动驾驶轨迹预测任务。联合编码器(图像和文本)在这两种模式下的性能优于单独使用单个编码器。虽然关节模型显著改善了基线,但其性能尚未达到最先进水平[Deo等人,2021; Gilles等人,2021年]。

Metric:

MtTrack [Wu等人,2023]使用平均多对象跟踪精度(AMOTA)度量[Bernardin和Stiefeldinger,2008],平均多对象跟踪精度(AMOTP)[Bashar等人,2022]和身份交换机(IDS)[Huang等人,2023 b]度量。HiLM-D [Ding等人,2023]使用BLEU-4 [Papineni等人,2002]、METEOR [Banerjee和Lavie,2005]、CIDER[Vedantam等人,2015]和SPICE [安德森等人,2016年],IoU [Rezatoi等人,2019]作为与最先进技术进行比较的指标。[Keysan et al.,2023]使用nuScenes-devkit中提供的标准评估度量[Caesar等人,2019; Fong等人,2021]:最小平均位移误差(minADEk)、最终位移误差(minFDEk)和超过2米的未命中率。

3.3 Question Answering

自动驾驶是一项重要的任务,在智能交通、辅助驾驶和自动驾驶汽车中有着广泛的应用[Xu et al.,2021 a; Xu等人,2021 b]。它主要通过不同的问答范式体现,包括传统的QA机制[Tang et al.,2023]和更详细的视觉QA方法[Xu等人,2023年]。[Tang例如,2023]通过与ChatGPT“聊天”构建领域知识本体。它开发了一个基于Web的助手,以便在运行时进行手动监督和早期干预,并保证全自动蒸馏结果的质量。这种问答系统增强了车辆的交互性,将传统的单向人机界面转变为交互式的交流体验,并可能培养用户的参与感和控制感。这些复杂的模型[Tang等人,2023年; Xu等人,2023],配备了解析,理解和生成类人响应的能力,是实时信息处理和提供的关键。他们设计与场景相关的综合问题,包括但不限于车辆状态、导航辅助和对交通情况的了解。[Yang例如,2023 b]提供了以人为本的视角,并通过不同的提示设计提供了几个关键的见解,使LLM能够在机舱内实现AD系统的要求。海豚[Ma等人,2023 a]通过创新的接地思维链(GCoT)过程增强推理能力,并通过构建驾驶特定的命令数据和命令调整来专门适应驾驶领域。LingoQA [Marcu等人,2023]开发了QA基准和数据集,详细信息见3.5和4。

Metric:

在QA任务方面,经常使用NLP的度量。在DriveFPT 4 [Xu等人,2023],其使用BLEU-4 [Papineni等人,2002]、METEOR [Banerjee和Lavie,2005]、CIDER[Vedantam等人,2015]和chatgpt评分[Fu等人,2023 b]。在[Yang等人,2023 b],它在单个问题级别和包括一些子问题的命令级别调整准确度。

3.4 Generation

在“生成”任务领域,大型语言模型利用其先进的知识库和生成能力,在特定环境因素下创建逼真的驾驶视频或复杂的驾驶场景[Khachatryan等人,2023;Luo等人,2023b]。这种方法为自动驾驶的数据收集和标记挑战提供了革命性的解决方案,也为测试和验证自动驾驶系统的决策边界构建了一个安全且易于控制的环境。此外,通过模拟各种驾驶情况和紧急情况,生成的内容成为完善和丰富自动驾驶系统应急响应策略的重要资源。

常见的生成模型包括变分自动编码器(VAE)[Kingma和Well,2022]、生成性对抗网络(GAN)[GoodFloor等人,2014]、归一化流(Flow)[Rezende和Mohamed,2016]和去噪扩散概率模型(Diffulation)[Ho等人,2020]。随着扩散模型最近在文本到图像转换方面取得了巨大成功[Ronneberger等人,2015;Rombach等人,2021;Ramesh等人,2022],一些研究已经开始研究使用扩散模型来生成自动驾驶图像或视频。DriveDreamer[Wang等人,2023d]是一个源自真实世界驾驶场景的世界模型。它使用文本、初始图像、HDmap和3Dbox作为输入,然后生成高质量的驾驶视频和合理的驾驶策略。类似地,驱动扩散[Li等人,2023c]采用3D布局作为控制信号来生成逼真的多视点视频。Gaia-1[Hu等人,2023a]利用视频、文本和动作输入来生成交通场景、环境要素和潜在风险。在这些方法中,文本编码器都采用了在图像和文本之间具有更好对准的CLIP[Radford et al.,2021]。除了生成自动驾驶视频外,还可以生成交通场景。CTG++[钟等人,2023]是一个场景级扩散模型,可以生成真实且可控的流量。它利用LLMS将用户查询转换为可微损失函数,并使用扩散模型将损失函数转换为现实的、符合查询的轨迹。MagicDrive[Gao等人,2023]生成高度逼真的图像,通过独立编码道路地图、对象框和相机参数来利用3D注释中的几何信息,以实现精确的几何制导合成。该方法有效地解决了多摄像机视点一致性的难题。虽然与BEVGen[Swerdlow等人,2023]和BEVControl[Yang等人,2023a]相比,它在生成保真度方面取得了更好的性能,但在一些复杂场景中,如夜景和看不见的天气条件,它也面临着巨大的挑战。ADDRIVER-I[Jia et al.,2023a]结合了多模式大语言模型(MLLM)和视频扩散模型(VDM)来预测当前帧和未来帧的控制信号。它在nuScenes及其私有数据集上显示了令人印象深刻的性能。然而,MLLM和VDM是分开训练的,不能联合优化。驾驶迈向未来[Wang等人,2023f]开发了一种名为Drive-WM的多视角世界模型,它能够在自动驾驶场景中生成高质量、可控和一致的多视角视频。它探索了世界模型在自动驾驶的端到端规划中的潜在应用。

这些方法探索了定制的真实的自动驾驶数据。尽管这些基于扩散的模型在视频和图像生成指标上取得了良好的效果,但目前还不清楚它们是否真的可以用于闭环,以真正提高自动驾驶系统的性能。

Metric:

DriveDreamer [Wang等人,2023 d]和DrivingDiffusion [Li等人,2023 c]使用逐帧的Frechet Inception Distance(FID)[Parmar等人,2022]以评估生成的图像的质量和Frechet视频距离(FVD)[Unterthiner等人,2019年,视频质量评估。DrivingDiffusion还使用平均交叉路口(mIoU)[Rezatoiani等人,2019]可行驶区域和NDS的得分[Yin等人,2021]通过将预测布局与地面实况BEV布局进行比较来确定所有对象类别。CTG++ [Zhong等人,2023]之后[Xu等人,2022; Zhong等人,2022],使用故障率、驾驶简档的归一化直方图之间的Wasserstein距离、真实性偏差(real)和场景级真实性度量(rel real)作为度量。MagicDrive [Gao等人,2023]利用诸如道路mIoU和车辆mIoU的分割度量[Taran等人,2018],以及mAP[亨德森和法拉利,2017]和NDS [Yin等人,2021年]。ADriver-I [Jia等人,2023 a]采用当前帧的速度和转向角的L1误差、Frechet起始距离(FID)和Frechet视频距离(FVD)作为评估指标。

3.5 Evaluation & Benchmark

在评价方面,在路上与GPT-4V [温等人,2023 b]在各种自动驾驶场景中对GPT-4V进行了全面和多方面的评估,包括场景理解,推理和充当驾驶员。GPT-4V在场景理解、意图识别和驾驶决策方面表现良好。它擅长处理分布外的情况,可以准确评估交通参与者的意图,利用多视角图像全面感知环境,准确识别交通参与者之间的动态交互。但GPT-4V在方向识别、交通信号灯解读、非英文交通标志等方面仍有一定的局限性。GPT-4V Takes the Wheel [Huang等人,2023 a]使用公开可用的数据集评估GPT-4V用于自主行人行为预测的潜力。尽管GPT-4V在行人行为预测的AI能力方面取得了重大进展,但与领先的传统特定领域模型相比,它仍然存在不足。

在基准方面,LMDrive [Shao等人,2023年]推出LangAuto(车辆引导自动驾驶)CARLA基准。它涵盖了8个城镇的各种驾驶场景,并考虑了16种不同的环境条件。它包含三条轨道:LangAuto跟踪(根据位置更新导航指令,并分为不同路线长度的子跟踪)、LangAuto-Notice跟踪(根据导航指令添加通知指令)和LangAuto-Sequential跟踪(将连续指令合并为单个长指令)。此外,LangAuto还采用三个主要评价指标:路线完成情况、违章分数、驾驶分数,综合评价自动驾驶系统的遵循指令能力和驾驶安全性。LingoQA [Marcu等人,2023]开发了LingoQA,用于评估自动驾驶的视频问答模型。该评估系统由三个主要部分组成:基于GPT 4的评估,它确定模型的答案是否与人类答案一致; LingoJudge度量,它使用经过训练的文本分类器Lingo-Judge答案准确性来评估模型;以及与人类评级的相关性分析。该分析涉及多个人类注释者对17个不同模型的响应进行评分,评分范围为0到1,这被解释为响应准确解决问题的可能性。Reason 2Drive [Nie等人,2023]引入了用于测量推理链的正确性以解决语义歧义的协议。评估过程包括四个关键指标:推理一致性,衡量逻辑推理中的重叠程度;冗余度,旨在识别任何重复的步骤;缺失步骤,侧重于确定任何缺少但解决问题所必需的关键步骤;严格原因,评估涉及视觉元素的场景。LaMPilot [Ma等人,2023 b]是一种用于评估自动驾驶汽车指令执行能力的创新基准测试,包括三个部分:模拟器,数据集和评估器。它使用Python语言模型程序(LMP)来解释人类注释的驾驶指令,并在其框架内执行和评估它们。[Tanahashi等人,2023]评估了大语言模型(LLM)在自动驾驶领域的两大核心能力:一是空间感知决策能力,即LLM能够基于坐标信息准确识别空间布局;二是遵循交通规则的能力,确保LLM在驾驶时严格遵守交通法规的能力。

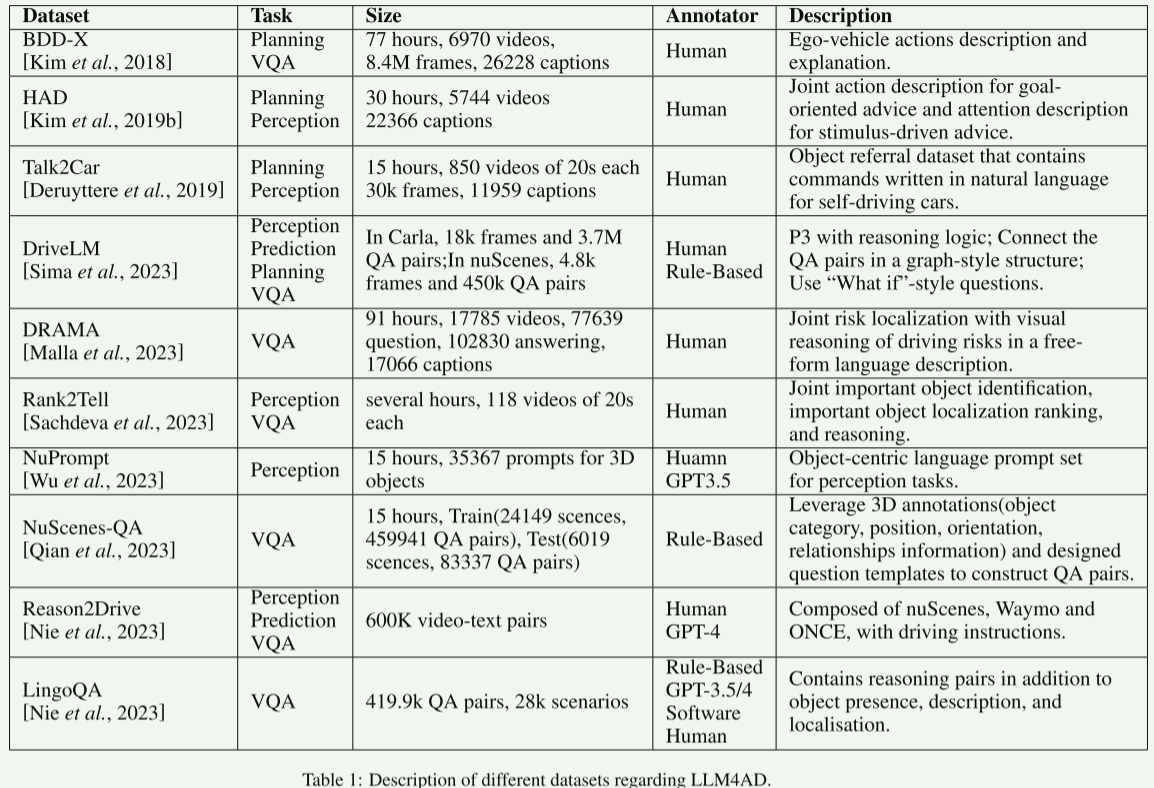

4.Datasets in LLM4AD

传统数据集,如nuScenes数据集[Caesar et al.,2019; Fong等人,2021]缺乏用于与LLM交互的动作描述、详细说明和问答对。BDD-x [Kim等人,2018],Rank 2 Tell [Sachdeva等人,2023]、DriveLM [Sima等人,2023],DRAMA [Malla等人,2023],NuPrompt [Wu等人,2023]和NuScenes-QA [Qian等人,数据集代表了LLM 4AD研究的关键发展,每个数据集都通过广泛,多样和丰富的注释为理解代理行为和城市交通动态做出了独特的贡献。我们给予表1中的每个数据集的总结。我们在下面给予详细描述。

BDD-X数据集[Kim等人,2018年]:该数据集收集了6,970个视频中超过77小时的各种驾驶条件,是真实驾驶行为的集合,每个都有描述和解释。它包括840万帧中的26 K活动,因此为理解和预测不同条件下的驾驶员行为提供了资源。

本田研究所建议数据集(HAD)[Kim等人,2019年b]:HAD提供30小时的驾驶视频数据,并配有自然语言建议和集成CAN总线信号数据的视频。建议包括被设计为在导航任务中引导车辆的目标导向建议(自上而下信号)和突出用户期望车辆控制器主动关注的特定视觉线索的刺激驱动建议(自下而上信号)。2019]:

Talk 2Car数据集包含nuScene的850个视频的11959个命令[Caesar等人,2019; Fong等人,2021]训练集作为3D边界框注释。其中,55.94%来自波士顿录制的视频,44.06%来自新加坡。平均而言,每个命令包含11.01个单词,其中包括2.32个名词,2.29个动词和0.62个形容词。通常,每个视频中大约有14.07个命令。它是一个对象引用数据集,包含用自然语言编写的自动驾驶汽车命令。

DriveLM数据集[Sima等人,2023]:该数据集将类人推理集成到自动驾驶系统中,增强感知、预测和规划(P3)。它采用了“思维图”结构,通过“假设”场景鼓励未来主义的方法,从而促进驾驶系统中先进的基于逻辑的推理和决策机制。

DRAMA数据集[Malla等人,2023年]:收集自东京街头,它包括17,785个用摄像机捕捉到的场景片段,每个片段的持续时间为2秒。它包含不同的注释:视频级问答、对象级问答、风险对象边界框、自由格式字幕、自驾车意图的单独标签、场景分类器和对驾驶员的建议。

Rank2Tell数据集[Sachdeva等人,2023]:它是从旧金山湾区高度互动的交通场景中的一辆移动车辆上拍摄的。它包括116个10fps的剪辑(每个剪辑20个),使用配备有1920×1200像素的三点灰蝗虫摄像机、Velodyne HDL-64E S2 LiDAR传感器和高精度GPS的仪表化车辆拍摄。数据集包括视频级别的Q/A、对象级别的Q/A、LiDAR和3D边界框(带跟踪)、3个摄像头的视场(缝合)、重要对象边界框(每帧多个重要对象,具有多个级别的重要性)、自由形式的字幕(多个对象的多个字幕)、自我-汽车意图。

NuPrompt数据集[Wu等人,2023]:它代表了nuScenes数据集的扩展,丰富了专门为驾驶场景设计的带注释的语言提示。该数据集包括用于3D对象的35,367个语言提示,平均每个对象5.3个实例。这种注释增强了数据集在自动驾驶测试和训练中的实用性,特别是在需要语言处理和理解的复杂场景中。

NuScenes-QA数据集[钱学森等人,2023]:它是自动驾驶的数据集,包含来自34,149个不同视觉场景的459,941个问答对。他们被分成来自28,130个场景的376,604个问题用于培训,以及来自6,019个场景的83,337个问题用于测试。NuScenes-QA展示了一系列广泛的问题长度,反映了不同的复杂程度,使其对人工智能模型具有挑战性。除了绝对的数字之外,该数据集还确保了问题类型和类别的平衡范围,从识别对象到评估它们的行为,例如它们是在移动还是停在那里。这种设计抑制了模型偏颇或依赖语言捷径的倾向。

Reason2Drive[Nie等人,2023]:它由nuScenes、Waymo和Once数据集组成,其中包含60万个由人类和GPT-4标记的视频-文本对。它通过独特的自动注释模式提供了驾驶场景的详细表示,捕获了各种元素,如对象类型、视觉和运动学属性,以及它们与EGO车辆的关系。GPT-4对它进行了增强,包括复杂的问题-答案对和详细的推理叙述。

LingoQA[Marcu等人,2023]:这个数据集是一个大规模的、多样化的自动驾驶集合,包含大约419,000个问答对,涵盖动作和场景子集。它通过高质量的视频和详细的注释提供关于驾驶行为、环境感知和路况的丰富信息。它的特点是复杂的问题和自由形式的答案,利用GPT-3.5/4来增强内容的多样性和深度。涵盖的驾驶能力包括动作、原因、注意力、识别、定位等,特别适合提升自动驾驶系统的理解和决策能力。

5.总结

在本文中,我们提供了一个全面的调查LLM4AD。我们分类并介绍了使用LLM进行自动驾驶的不同应用,并总结了每个类别中的代表方法。同时,我们总结了LLM4AD的最新数据集。我们将继续关注该领域的发展,并强调未来的研究方向。

6.

总结和展望

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 详解 MySql InnoDB 的 MVCC 实现机制

- android 9 reboot流程

- vue开发跨平台应用

- 抽奖sql存储过程

- <软考高项备考>《论文专题 - 8 论文的项目背景之背景段的写法》

- 蜕变,我的2023

- 【动态规划】19子数组系列_最大子数组和_C++(medium)

- OpenTiny 2023年度共建者榜单大曝光!!!

- prometheus grafana redis安装配置监控

- linux dd命令,快速占用服务器磁盘