详解Keras3.0 Layer API: Dropout layer

发布时间:2023年12月29日

Dropout layer

?

?

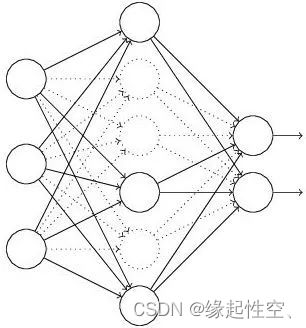

? ? ? ? Dropout层的作用是在神经网络中引入正则化,以防止过拟合。它通过随机丢弃一部分神经元(如图2)的输出来减少模型对训练数据的依赖性。这样可以提高模型的泛化能力,使其在测试数据上表现更好。

? ? ? ? Dropout层的核心思想是减小神经网络中权重共享的情况,让不同的神经元可以承担不同的特征提取任务。由于每个神经元被丢弃的概率相同,因此每一轮训练都可能得到不同的网络结构,这有助于提高模型的泛化能力。同时,Dropout也有助于减少神经元之间的依赖性,增强模型的鲁棒性。

工作原理

- 在训练阶段,对于每一层神经元,以一定的概率p随机选择一部分神经元,将它们的输出置为0。这样,每一层的神经元有p的概率被保留,也有p的概率被丢弃。

- 在前向传播过程中,每一层神经元的输入会经过Dropout处理,保留概率p的神经元进行计算。

- 在反向传播过程中,梯度会根据未被丢弃的神经元的权重进行传播。这意味着在更新权重时,被丢弃的神经元的权重不会被更新。

- 在测试阶段,为了使用训练阶段得到的网络集合,每个神经元的输出需要乘以概率p。这样做的目的是为了在测试时模拟出与训练阶段相同的网络结构。

keras.layers.Dropout(rate, noise_shape=None, seed=None, **kwargs)参数说明

- ?rate:在0和1之间浮动。要丢弃的输入单位的分数。

- noise_shape:表示将与输入相乘的二进制丢弃掩码的形状的1D整数张量。例如,如果输入具有形状(batch_size,时间步长,features),并且希望所有时间步长的丢弃掩码相同,则可以使用noise_shape=(batch_size,1,features.)。

- seed:用作随机种子的Python整数。

示例?

# 导入所需的库

from keras.models import Sequential

from keras.layers import Dense, Dropout

# 创建一个Sequential模型

model = Sequential()

#添加全连接层(Dense)

model.add(Dense(units=64, activation='relu', input_dim=100))

#在全连接层之后添加一个Dropout层,丢弃率为0.5

model.add(Dropout(rate=0.5))

#添加全连接层

model.add(Dense(units=10, activation='softmax'))

#编译模型,设置损失函数、优化器和评估指标

model.compile(loss='categorical_crossentropy',

optimizer='adam',

metrics=['accuracy'])

文章来源:https://blog.csdn.net/lymake/article/details/135297553

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 常用Python自动化测试框架有哪些?

- java实现.net中byte和int转化的方法:BitConverter.GetBytes【验证可用】

- AI加持,openEuler打造数字基础设施全场景操作系统

- 【Python 零基础入门】常用内置函数 初探

- User电脑中睡眠和休眠的区别,及对不同环境下模式设置建议

- electron autoUpdater自动更新使用示例 客户端+服务端

- Java 常用加密解密

- 球形体积雾

- 【论文笔记】动态蛇卷积(Dynamic Snake Convolution)

- 网络安全(黑客)—2024自学