机器学习算法--朴素贝叶斯(Naive Bayes)

实验环境

1. python3.7

2. numpy >= '1.16.4'

3. sklearn >= '0.23.1'?

朴素贝叶斯的介绍

朴素贝叶斯算法(Naive Bayes, NB) 是应用最为广泛的分类算法之一。它是基于贝叶斯定义和特征条件独立假设的分类器方法。NB模型所需估计的参数很少,对缺失数据不太敏感,算法也比较简单。当年的垃圾邮件分类都是基于朴素贝叶斯分类器识别的。

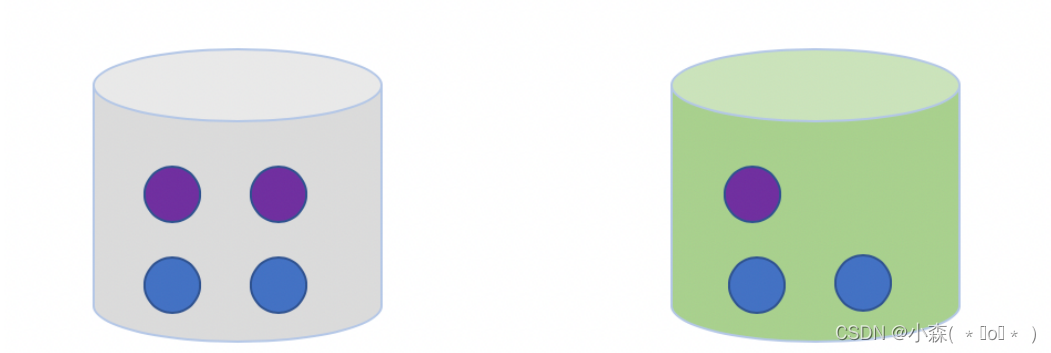

什么是条件概率,我们从一个摸球的例子来理解。我们有两个桶:灰色桶和绿色桶,一共有7个小球,4个蓝色3个紫色,分布如下图:

从这7个球中,随机选择1个球是紫色的概率p是多少?

- 先选择桶

- 再从选择的桶中选择一个球

我们选择小球的过程就是条件概率的过程,在选择桶的颜色的情况下是紫色的概率,另一种计算条件概率的方法是贝叶斯准则;

p(A,B):表示事件A和事件B同时发生的概率。

p(B):表示事件B发生的概率;p(A):表示事件A发生的概率。

p(A|B):事件B发生的条件下,事件A发生的概率。

p(B|A):事件A发生的条件下,事件B发生的概率。

人们常常使用已经发生的某个事件去推断我们想要知道的之间的概率。

?朴素贝叶斯的应用

朴素贝叶斯算法假设所有特征的出现相互独立互不影响,每一特征同等重要。朴素贝叶斯分类算法是学习效率和分类效果较好的分类器之一。朴素贝叶斯算法一般应用在文本分类,垃圾邮件的分类,钓鱼网站检测等。

莺尾花数据集--贝叶斯分类

?库函数导入

import warnings

warnings.filterwarnings('ignore')

import numpy as np

# 加载莺尾花数据集

from sklearn import datasets

# 导入高斯朴素贝叶斯分类器

from sklearn.naive_bayes import GaussianNB

from sklearn.model_selection import train_test_split?数据导入&分析

X, y = datasets.load_iris(return_X_y=True)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=0)?模型训练

# 使用高斯朴素贝叶斯进行计算

clf = GaussianNB(var_smoothing=1e-8)

clf.fit(X_train, y_train)模型预测

# 评估

y_pred = clf.predict(X_test)

acc = np.sum(y_test == y_pred) / X_test.shape[0]

print("Test Acc : %.3f" % acc)

# 预测

y_proba = clf.predict_proba(X_test[:1])

print(clf.predict(X_test[:1]))

print("预计的概率值:", y_proba)从上述例子中的预测结果中,可以看到类别2对应的后验概率值最大,所以认为类目2是最优的结果

朴素贝叶斯的优缺点

优点: 朴素贝叶斯算法主要基于经典的贝叶斯公式进行推倒,具有很好的数学原理。而且在数据量很小的时候表现良好,数据量很大的时候也可以进行增量计算。由于朴素贝叶斯使用先验概率估计后验概率具有很好的模型的可解释性。

缺点: 朴素贝叶斯模型与其他分类方法相比具有最小的理论误差率。但是实际上并非总是如此,这是因为朴素贝叶斯模型给定输出类别的情况下,假设属性之间相互独立,这个假设在实际应用中往往是不成立的,在属性个数比较多或者属性之间相关性较大时,分类效果不好。而在属性相关性较小时,朴素贝叶斯性能最为良好。对于这一点,有半朴素贝叶斯之类的算法通过考虑部分关联性适度改进,例如为了计算量不至于太大,我们假定每个属性只依赖另外的一个。解决特征之间的相关性,我们还可以使用数据降维(PCA)的方法,去除特征相关性,再进行朴素贝叶斯计算。

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 【挑战全网最易懂】深度强化学习 --- 零基础指南

- 02-Eureka微服务注册中心集群搭建

- 【深度deepin】深度安装,jdk,tomcat,Nginx安装

- vue3 使用setup语法糖之后设置页面name方法

- Qt隐式共享浅析

- 算法伴学笔记 Day 01 | DFS入门

- kivy PageLayout 的说明及例子

- CentOS 7路由管理解析:探秘路由表的奥秘

- 【医疗器械政策】第一期 我国大型医用设备管理

- vue3引入echarts正确姿势