Python爬虫之使用代理IP池维护虚拟用户

文章目录

前言

在进行Web爬取时,使用代理IP是一种常见的策略,它可以帮助我们隐藏真实IP地址,绕过网站的访问限制,提高爬取效率。本文将介绍如何使用代理IP池维护虚拟用户,以在爬取过程中保持匿名性和稳定性。

一、什么是代理IP池?

代理IP池是一个包含多个代理IP的集合。这些代理IP通常是从公开或付费的代理IP供应商那里获取的,也可以通过自己搭建代理服务器来获取。代理IP池可以提供多个不同的IP地址,用于隐藏真实IP,避免被网站封禁或限制访问。

二、爬取代理IP

首先,我们需要从代理IP供应商或其他可靠的来源中获取代理IP。这些代理IP通常以文本格式提供,每行一个代理IP,格式如下:

IP地址:端口

我们可以使用Python中的requests库来发送HTTP请求获取代理IP列表,并将其保存到本地文件中。以下是一个获取代理IP列表的示例代码:

import requests

def get_proxy_ips():

url = 'http://example.com/proxy_ips.txt' # 代理IP列表文件的URL

response = requests.get(url)

proxy_ips = response.text.split('\n')

return proxy_ips

三、验证代理IP的可用性

获取到代理IP列表后,我们需要验证这些代理IP的可用性。我们可以使用requests库来发送带有代理IP的请求,并检查响应状态码来确定是否可用。以下是一个验证代理IP可用性的示例代码:

import requests

def check_proxy_ip(proxy_ip):

url = 'http://example.com' # 需要访问的URL

proxies = {

'http': 'http://' + proxy_ip,

'https': 'https://' + proxy_ip

}

try:

response = requests.get(url, proxies=proxies, timeout=10)

if response.status_code == 200:

return True

else:

return False

except:

return False

四、维护代理IP池

在获取和验证代理IP之后,我们需要维护一个代理IP池,以便在爬取过程中动态地切换代理IP。我们可以使用Python中的列表或队列来实现代理IP池。以下是一个简单的代理IP池实现示例代码:

import random

class ProxyIPPool():

def __init__(self, proxy_ips):

self.proxy_ips = proxy_ips

self.proxy_ip_pool = []

def get_proxy_ip(self):

if not self.proxy_ip_pool:

self.proxy_ip_pool = self.proxy_ips.copy()

random.shuffle(self.proxy_ip_pool)

return self.proxy_ip_pool.pop()

def put_proxy_ip(self, proxy_ip):

self.proxy_ip_pool.append(proxy_ip)

在爬取过程中,我们可以通过调用get_proxy_ip方法来获取一个代理IP,并将其作为参数传递给requests库的proxies参数。如果获取的代理IP不可用,我们可以调用put_proxy_ip方法将其放回代理IP池,然后再获取另一个代理IP。这样,我们就可以动态地切换代理IP,保持爬取的匿名性和稳定性。

五、使用代理IP池进行爬取

使用代理IP池进行爬取的过程很简单。首先,我们需要获取代理IP列表并初始化代理IP池。然后,我们可以在爬取循环中使用代理IP池,调用get_proxy_ip方法获取一个代理IP,并将其作为参数传递给requests库的proxies参数。如果请求失败或遇到其他问题,我们可以调用put_proxy_ip方法将代理IP放回代理IP池,并继续爬取。以下是一个使用代理IP池进行爬取的示例代码:

import requests

proxy_ips = get_proxy_ips()

proxy_ip_pool = ProxyIPPool(proxy_ips)

url = 'http://example.com'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

while True:

proxy_ip = proxy_ip_pool.get_proxy_ip()

proxies = {

'http': 'http://' + proxy_ip,

'https': 'https://' + proxy_ip

}

try:

response = requests.get(url, headers=headers, proxies=proxies, timeout=10)

if response.status_code == 200:

# 处理响应数据

pass

else:

# 处理请求失败情况

pass

except:

# 处理请求异常情况

pass

finally:

proxy_ip_pool.put_proxy_ip(proxy_ip)

六、总结

使用代理IP池可以帮助我们在爬取过程中保持匿名性和稳定性。通过获取和验证代理IP,并维护一个代理IP池,我们可以动态地切换代理IP,提高爬取效率,并避免被网站封禁或限制访问。在爬取过程中,我们可以根据具体的需求,选择合适的代理IP供应商或搭建自己的代理服务器,以获取可靠的代理IP。同时,我们还可以添加一些附加的策略,如定时更新代理IP列表,检测代理IP的可用性等,以提高爬取的可靠性和效率。

以上就是使用代理IP池维护虚拟用户的方法和示例代码。希望本文对你理解和使用代理IP池有所帮助。

关于Python技术储备

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后给大家分享一份全套的 Python 学习资料,希望提供给想学习 Python 的小伙伴们一点帮助!

保存图片微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、Python所有方向的学习路线

Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、Python基础学习视频

② 路线对应学习视频

还有很多适合0基础入门的学习视频,有了这些视频,轻轻松松上手Python~在这里插入图片描述

③练习题

每节视频课后,都有对应的练习题哦,可以检验学习成果哈哈!

因篇幅有限,仅展示部分资料

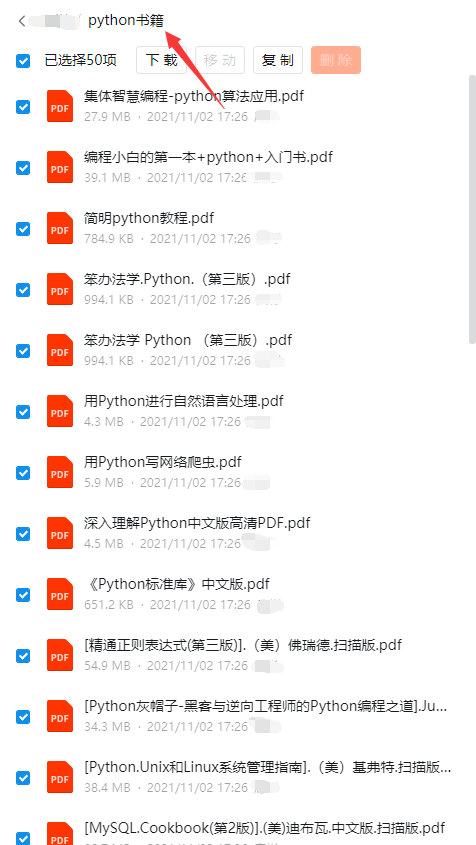

三、精品Python学习书籍

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、Python工具包+项目源码合集

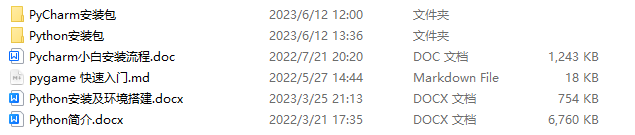

①Python工具包

学习Python常用的开发软件都在这里了!每个都有详细的安装教程,保证你可以安装成功哦!

②Python实战案例

光学理论是没用的,要学会跟着一起敲代码,动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。100+实战案例源码等你来拿!

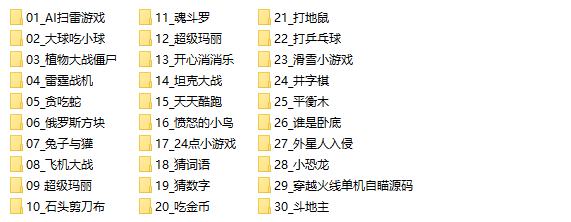

③Python小游戏源码

如果觉得上面的实战案例有点枯燥,可以试试自己用Python编写小游戏,让你的学习过程中增添一点趣味!

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

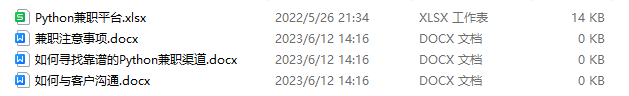

六、Python兼职渠道

而且学会Python以后,还可以在各大兼职平台接单赚钱,各种兼职渠道+兼职注意事项+如何和客户沟通,我都整理成文档了。

这份完整版的Python全套学习资料已经上传CSDN,朋友们如果需要可以保存图片微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 豆豆人智能AI游戏设计与Java实现

- docker安装redis

- 使用Python生成UID

- AttributeError: module ‘_winapi‘ has no attribute ‘SYNCHRONIZE‘解决方案

- QML —— 四种定位器介绍,及中继器、定位器示例(Row、Column、Gird、Flow)(附完整源码)

- Kubernetes-Affinity(node亲和、pod亲和)

- 数据结构期末复习(六)查找算法

- 字体包引入以及使用

- 浅谈企业数据资产分类管理

- 调研 7 个开源项目后,这家数据合规平台如何构建高性能网关