Keepalived双机热备

- 学会构建双机热备系统

- 学会构建LVS+HA高可用群集

1.1 Keepalived概述及安装

? ? ? ? Keepalived的官方网站位于http://www.keepalived.org/,本章将以yum方式讲解Keepalived的安装、配置和使用过程。在非LVS群集环境中使用时,Keepalived也可以作为热备软件使用

1. Keepalived的热备方式

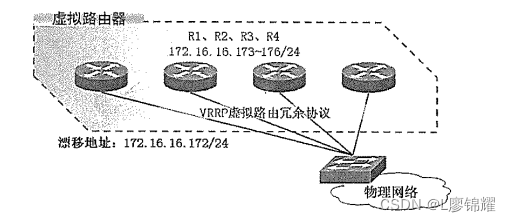

? ? ? ? Keepalived采用VRRP(虚拟路由冗余协议)热备份协议,以软件的方式实现Linux服务器的多级热备功能。VRRP是针对路由器的一种备份解决方案——由多台路由器组成一个热备组,通过共用的虚拟IP地址对外提供服务;每个热备组内同一时刻只有一台主路由器提供服务,其他路由器处于冗余状态,若当前在线的路由器失效,则其他路由器会自动接替(优先级决定接替顺序)虚拟IP地址,以继续提供服务如图

Keepalived的VRRP热备机制

? ? ? ? 热备组内的每台路由器都可能成为主路由器,虚拟路由器的IP地址(VIP)可以在热备组内的路由器之间进行转移,所以也称为漂移IP地址。使用Keepalived时,漂移地址的实现不需要手动建立虚接口配置文件(如ens33:0),而是有Keepalived根据配置文件自动管理

2. Keepalived的安装与服务控制

(1)安装Keepalived(主从服务器都要安装)

? ? ? ? 在CentOS7系统中,使用yum方式安装keepalived.x86_64 0:1.2.13-8.el7,会自动安装keepalived所需的软件包,除此之外,在LVS群集环境中应用时也需要用到keepalived管理工具

[root@node1 ~]# yum -y install keepalived ipvsadm //主服务器

[root@node2 ~]# yum -y install keepalived ipvsadm //从服务器(2)控制keepalived服务

? ? ? ? yum安装keepalived后,执行以下命令将keepalived服务设置为开机启动

[root@node1 ~]# systemctl enable keepalived.service //主服务器

[root@node2 ~]# systemctl enable keepalived.service //从服务器1.2. 使用Keepalived实现双机热备

? ? ? ? 基于VRRP的热备方式,Keepalived可以用作服务器的故障切换,每个热备组可以有多台服务器——当然,最常用的就是双机热备热备了。在这种双机热备的方案中,故障切换主要针对虚拟IP地址的漂移来实现,因此能够适用于各种服务器(不管是Web、FTP、Mail、还是SSH、DNS....)。

? ? ? ?本小节通过一个简单的安装来说明Keepalived双机热备的配置方法。其中,主、备服务器的IP地址分别为192.168.161.10和192.168.161.11,基于漂移地址192.168.161.250提供Web服务,如图

Keepalived双机热备示意图

? ? ? ? 主、备设备都需要安装Keepalived;使用yum方式安装httpd提供Web服务,下面讲解与Keepalived相关的配置及测试过程

1. 主服务器的配置

? ? ? ? Keepalived服务的配置目录位于/etc/keepalived/。其中,keepalived.conf是主配置文件;另外包括一个子目录samples/。提供了许多配置样例作为参考。在keepalived的配置文件中,使用“global_defs{...}”区段指定全局参数,使用“vrrp_instance实例名称{...}”区段指定VRRP热备参数,注释文字以“!”符号开头

[root@node1 ~]# cd /etc/keepalived/

[root@node1 keepalived]# cp keepalived.conf keepalived.conf.bak

[root@node1 keepalived]# vim keepalived.conf

global_defs {

router_id HA_TEST_R1 //本路由器(服务器)名称

}

vrrp_instance VI_1 { //定义VRRP热备实例

state MASTER //热备状态,MASTER表示主服务器

interface ens33 //承载VIP地址的物理接口

virtual_router_id 51 //虚拟路由器的ID号,每个热备组保持一致

priority 100 //优先级,数值越大优先级越高

advert_int 1 //通告间隔秒数(心跳频率)

authentication { //认证信息,每个热备组保持一致

auth_type PASS //认证类型

auth_pass 123.123 //密码字串

}

virtual_ipaddress {

192.168.161.250 //指定漂移地址(VIP),可以有多个

}

}????????确认上述配置无误后,然后启动Keepalived服务。实际状态为MASTER的主服务器将为ens33接口自动添加IP地址,通过ip命令可以查看(注意:ifconfig命令看不到)

[root@node1 keepalived]# systemctl start keepalived.service

[root@node1 keepalived]# ip addr show dev ens33

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 00:0c:29:a3:c9:c3 brd ff:ff:ff:ff:ff:ff

inet 192.168.161.10/24 brd 192.168.161.255 scope global noprefixroute ens33

valid_lft forever preferred_lft forever

inet 192.168.161.250/32 scope global ens33

valid_lft forever preferred_lft forever

inet6 fe80::5e23:bd31:9cd8:b008/64 scope link noprefixroute

valid_lft forever preferred_lft forever

[root@node1 keepalived]# 2. 备用服务器的配置

? ? ? ? 在同一个Keepalived热备组内,所有服务器的Keepalived配置文件基本相同,包括虚拟路由器的ID号、认证信息、漂移地址、心跳频率等。不同之处主要在于路由器名称、热备状态、优先级。

- 路由器名称(router-id):建议为每个参与热备的服务器指定不同的名称

- 热备状态(state):至少应有一台主服务器,将状态设为MASTER;可以有多台备用服务器,将状态设置为BACKUP

- 优先级(priorty):数值越大则取得VIP控制权的优先级越高,因此主服务器的优先级设置应设为最高;其他备用服务器的优先级可依次递减,但不要相同,以免在争夺VIP控制权时发生冲突

配置备用服务器(可以用多台)时,可以参考主服务器的配置文件内容,只要修改路由器、热备状态、优先级就可以了

[root@node2 ~]# cd /etc/keepalived/

[root@node2 keepalived]# cp keepalived.conf keepalived.conf.bak

[root@node2 keepalived]# vim keepalived.conf

global_defs {

router_id HA_TEST_R2

}

vrrp_instance VI_1 {

state BACKUP

interface ens33

virtual_router_id 51

priority 99

advert_int 1

authentication {

auth_type PASS

auth_pass 123.123

}

virtual_ipaddress {

192.168.161.250

}

}? ? ? ? 确认配置无误后,一样需要启动Keepalived服务,此时主服务器仍然在线,VIP地址实际上仍然由主服务器控制,其他服务器处于备用状态,因此在备用服务器中将不会为ens33接口添加VIP地址

[root@node2 keepalived]# systemctl start keepalived.service

[root@node2 keepalived]# ip addr show dev ens33

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 00:0c:29:f2:ca:28 brd ff:ff:ff:ff:ff:ff

inet 192.168.161.11/24 brd 192.168.161.255 scope global noprefixroute ens33

valid_lft forever preferred_lft forever

inet6 fe80::3965:8c44:d947:febb/64 scope link noprefixroute

valid_lft forever preferred_lft forever

[root@node2 keepalived]# 3. 测试双机热备功能

? ? ? ? Keepalived的日志信息保存在/var/log/messages文件中,在测试主、备故障自动切换功能时,可以跟踪此日志文件观察热备状态的变化,以针对连通性和Web服务的测试为例,主要操作如下所述

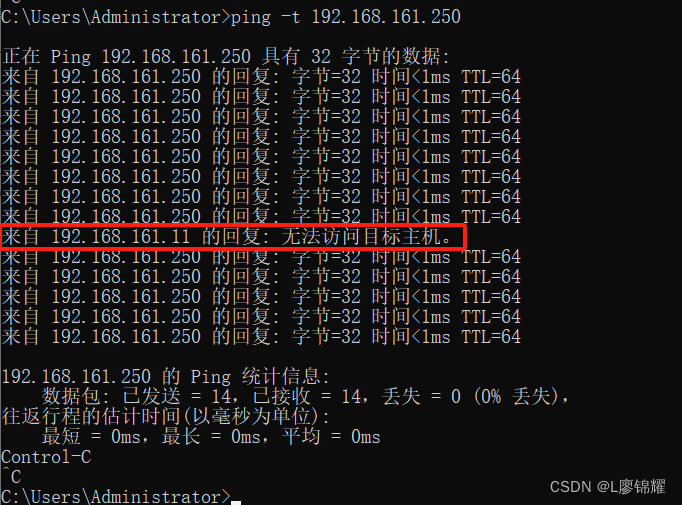

1)连通性测试

? ? ? ? 在客户机中执行“ping -t 192.168.161.250”命令,能够正常,持续ping通,根据以下操作继续观察测试结果

? ? ? ? (1)停止启用主服务器的 Keepalived 服务,发现 ping 测试只中断了 1 或 2 个包即恢复正常,说明已有其他服务器接替 VIP 地址,并及时响应客户机请求

? ? ? ? (2)重新启用主服务器的 Keepalived 服务,发现 ping 测试再次中断 1 或 2 个包即恢复正常,说明主服务器已恢复正常,并夺回 VIP 地址的控制权

2)Web访问测试

?????????在客户机中访问 http://192.168.161.250/,将看到由主服务器 192.168.161.10?提供的网页文档

? ? ? ? (1)停止启用主服务器的 Keepalived 服务,再次访问上述 Web 服务,将看到由备用服务器 192.168.161.11?提供的网页文档,说明 VIP 地址已切换至备用服务器

? ? ? ? (2)重新启用主服务器的 Keepalived 服务,再次访问上述 Web 服务,将看到重新由主服务器 192.168.161.10?提供的网页文档,说明主服务器已重新夺取 VIP 地址

3)查看日志记录

? ? ? ??在执行主、备服务器故障切换的过程中,分别观察各自的/var/log/messages 日志文件,可以看到 MASTER、SLAVE 状态的迁移记录

? ? ? ? (1)主服务器中,Keepalived 服务状态先变为“stop”,移除 VIP 地址,恢复后重新变为 MASTER

? ? ? ? (2)备用服务器中,状态先切换为 MASTER,待主服务器恢复后再交回控制权

通过上述测试过程,可以发现双机热备已经正常。客户机只要通过 VIP 地址就可以访问服务器所提供的 Web 等应用。其中,任何一台服务器失效,另一台服务器将会立即接替服务,从而实现高可用性。实际应用时,注意主、备服务器所提供的 Web 服务内容要保持一致

1.3 LVS+Keepalived高可用群集

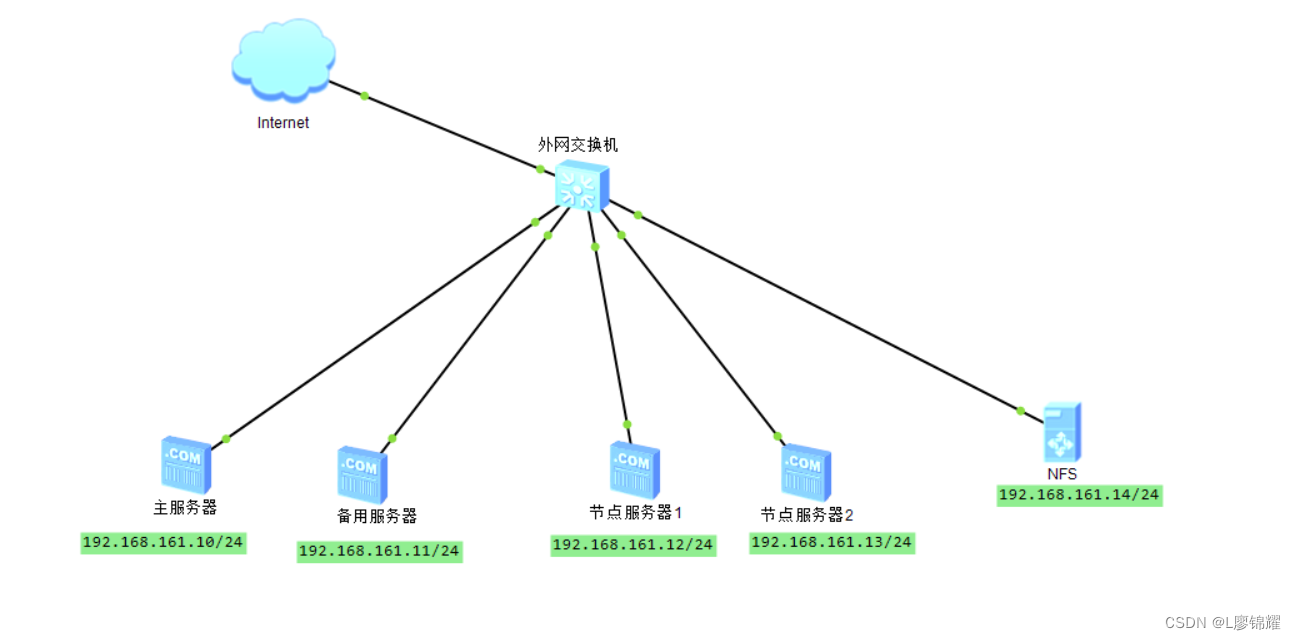

????????Keepalived 的设计目标是构建高可用的 LVS 负载均衡群集,可以调用 ipvsadm 工具来创建虚拟服务器、管理服务器池,而不仅仅用作双机热备。使用 Keepalived 构建 LVS 群集更加简便易用,主要优势体现在:对 LVS 负载调度器实现热备切换,提高可用性;对服务器池中的节点进行健康检查,自动移除失效节点,恢复后再重新加入

????????在基于 LVS+Keepalived 实现的 LVS 群集结构中,至少包括两台热备的负载调度器,三台以上的节点服务器。本节将以 DR 模式的 LVS 群集为基础,增加一台从负载调度器,使用Keepalived 来实现主、从调度器的热备,从而构建兼有负载均衡、高可用两种能力的 LVS网站群集平台,如图

?

使用 Keepalived 构建 LVS 群集时,也需要用到 ipvsadm 管理工具。但大部分工作会由Keepalived 自动完成,不需要手动执行 ipvsadm(除了查看和监控群集以外)?下面主要讲解 Keepalived 的服务器池设置,NFS 共享服务的配置、Keepalived 的热备配置

1. 配置主/从调度器

(1)全局配置、热备配置

????????首先为主、从调度器实现热备功能,漂移地址使用LVS群集的VIP地址

##主服务器的配置

[root@node1 ~]# cd /etc/keepalived/

[root@node1 keepalived]# vim keepalived.conf

global_defs {

router_id HA_TEST_R1

}

vrrp_instance VI_1 {

state MASTER

interface ens33

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 123.123

}

virtual_ipaddress {

192.168.161.250

}

}

##备用服务器的配置

[root@node2 ~]# vim /etc/keepalived/keepalived.conf

global_defs {

router_id HA_TEST_R2

}

vrrp_instance VI_1 {

state BACKUP

interface ens33

virtual_router_id 51

priority 99

advert_int 1

authentication {

auth_type PASS

auth_pass 123.123

}

virtual_ipaddress {

192.168.161.250

}

}

(2)Web服务器池配置(主/备都需要配置)

????????在 Keepalieved 的热备配置基础上添加“virtual_server VIP 端口 { ... }”区段来配置虚拟服务器,主要包括对负载调度算法、群集工作模式、健康检查间隔、真实服务器地址等参数的设置

virtual_server 192.168.161.250 80 { //虚拟服务器地址(VIP)、端口

delay_loop 15 //健康检查的间隔时间(秒)

lb_algo rr //轮询(rr)调度算法

lb_kind DR //直接路由(DR)群集工作模式

persistence_timeout 50 //连接保持时间(秒),启动请去掉!号

protocol TCP //采用TCP协议

real_server 192.168.161.12 443 { //第一个Web节点的地址、端口

weight 1 //节点权重

TCP_CHECK { //健康检查方式

connect_port 80 //检查的目标端口

connect_timeout 3 //连接超时(秒)

nb_get_retry 3 //重试次数

delay_before_retry 4 //重试间隔(秒)

}

}

real_server 192.168.161.13 443 {

weight 1

TCP_CHECK {

connect_port 80

connect_timeout 3

nb_get_retry 3

delay_before_retry 4

}

}

}(3)重新启动Keepalived服务

[root@node1 ~]# systemctl restart keepalived.service

[root@node2 ~]# systemctl restart keepalived.service(4)主/从机器的参数配置

##主服务器

[root@node1 ~]# vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

[root@node1 ~]# sysctl -p

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

[root@node1 ~]#

##备服务器

[root@node2 ~]# vim /etc/sysctl.conf

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

[root@node2 ~]# sysctl -p

net.ipv4.conf.all.send_redirects = 0

net.ipv4.conf.default.send_redirects = 0

net.ipv4.conf.ens33.send_redirects = 0

[root@node2 ~]# (5)Web节点服务器配置

##节点1

[root@node3 ~]# vim /etc/sysctl.conf

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

[root@node3 ~]# sysctl -p

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

[root@node3 ~]# cd /etc/sysconfig/network-scripts/

[root@node3 network-scripts]# cp ifcfg-lo ifcfg-lo:0

[root@node3 network-scripts]# vim ifcfg-lo:0

DEVICE=lo:0

IPADDR=192.168.161.250

NETMASK=255.255.255.255

ONBOOT=yes

[root@node3 network-scripts]# ifup ifcfg-lo:0

[root@node3 network-scripts]# ifconfig lo:0

lo:0: flags=73<UP,LOOPBACK,RUNNING> mtu 65536

inet 192.168.161.250 netmask 255.255.255.255

loop txqueuelen 1000 (Local Loopback)

##节点2

[root@node4 ~]# vim /etc/sysctl.conf

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

[root@node4 ~]# sysctl -p

net.ipv4.conf.all.arp_ignore = 1

net.ipv4.conf.all.arp_announce = 2

net.ipv4.conf.default.arp_ignore = 1

net.ipv4.conf.default.arp_announce = 2

net.ipv4.conf.lo.arp_ignore = 1

net.ipv4.conf.lo.arp_announce = 2

[root@node4 ~]# cd /etc/sysconfig/network-scripts/

[root@node4 network-scripts]# cp ifcfg-lo ifcfg-lo:0

[root@node4 network-scripts]# vim ifcfg-lo:0

DEVICE=lo:0

IPADDR=192.168.161.250

NETMASK=255.255.255.255

ONBOOT=yes

[root@node4 network-scripts]# ifup ifcfg-lo:0

[root@node4 network-scripts]# ifconfig lo:0

lo:0: flags=73<UP,LOOPBACK,RUNNING> mtu 65536

inet 192.168.161.250 netmask 255.255.255.255

loop txqueuelen 1000 (Local Loopback)

(6)配置NFS服务器

[root@node5 ~]# yum -y install nfs-utils rpcbind

[root@node5 ~]# vim /etc/exports

/opt/wwwroot 192.168.161.0/24(rw,sync,no_root_squash)

[root@node5 ~]# systemctl restart rpcbind

[root@node5 ~]# systemctl restart nfs

[root@node5 ~]# systemctl enable rpcbind

[root@node5 ~]# systemctl enable nfs

Created symlink from /etc/systemd/system/multi-user.target.wants/nfs-server.service to /usr/lib/systemd/system/nfs-server.service.

[root@node5 ~]# netstat -anpt | grep rpcbind

tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 8039/rpcbind

tcp6 0 0 :::111 :::* LISTEN 8039/rpcbind

[root@node5 ~]#

(7)Web节点服务器配置httpd挂载测试页面

##节点1

[root@node3 ~]# yum -y install httpd

[root@node3 ~]# showmount -e 192.168.161.14

Export list for 192.168.161.14:

/opt/wwwroot 192.168.161.0/24

[root@node3 ~]# mount 192.168.161.14:/opt/wwwroot /var/www/html/

[root@node3 ~]# vim /etc/fstab

192.168.161.14:/opt/wwwroot /var/www/html nfs defaults,_netdev 0 0

[root@node3 ~]# vim /var/www/html/index.html

<h1>Hello</h1>

##节点2

[root@node4 ~]# yum -y install httpd

[root@node4 ~]# showmount -e 192.168.161.14

Export list for 192.168.161.14:

/opt/wwwroot 192.168.161.0/24

[root@node4 ~]# mount 192.168.161.14:/opt/wwwroot /var/www/html/

[root@node4 ~]# vim /etc/fstab

192.168.161.14:/opt/wwwroot /var/www/html nfs defaults,_netdev 0 0

(8)测试LVS+Keepalived高可用群集

? ? ? ? 在客户机的浏览器中,能够通过LVS+Keepalived群集的VIP地址(192.168.161.250)正常访问Web页面内容。当主、从调度器任何一个失效时,Web站点仍然可以访问(可能需要刷新或重新打开浏览器);只要服务器池由两台以上的真实服务器可用,就可以实现访问量的负载均衡

? ? ? ? 通过主、从调度器的/var/log/messages日志文件,可以跟踪故障切换过程;若要查看负载均衡分配情况,可以执行“ipvsadm -ln”“ipvsadm -lnc”等操作命令,最终可以验证LVS+Keepalived高可用负载均衡群集健壮性

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 基金投资指标解读:货币型基金的万元收益与7日年化率

- 线程通讯的三种方法

- 原生微信授权拒绝授权强制调取授权功能实现

- 数据中台实战(00)-大数据的尽头是数据中台吗?

- Java支持自动装箱和拆箱吗?什么是方法重载和方法重写?static关键字有什么作用?

- 【教程】从gitee或者github,下载单个文件或文件夹命令

- 如何定义一个c++函数

- 案例分享|企业为什么要选择数字化转型?

- 智慧港口解决方案:PPT全文53页,附下载

- C语言运算符