elasticsearch-安装IK分词器

发布时间:2023年12月25日

一、el默认分词器

es在创建倒排索引时需要对文档分词,在搜索时,需要对用户输入内容分词。但默认的分词规则对中文处理并不友好,在kibana的DevTools中测试

二、IK分词器

处理中文分词,一般会使用IK分词器。

GitHub官方网址:https://github.com/medcl/elasticsearch-analysis-ik

三、安装IK分词器?

3.1 安装ik插件(在线安装)

# 进入容器内部

docker exec -it elasticsearch /bin/bash

#在线下载并安装

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.12.1/elasticsearch-analysis-ik-7.12.1.zip

#退出

exit

#重启容器

docker restart elasticsearch

3.2?安装ik插件(离线安装)

1)查看数据卷目录

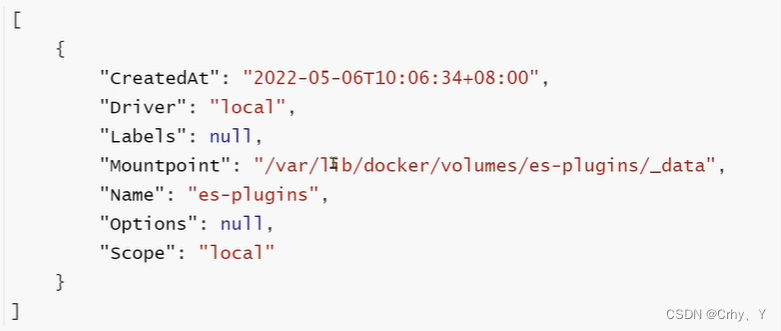

安装插件需要知道elasticsearch的plugins目录位置,通过下面命令查看elasticsearch的数据卷目录:?

docker volume inspect es-pIugins?

结果

说明plugins目录被挂载到了/var/lib/docker/volumes/es-plugins/_data这个目录?

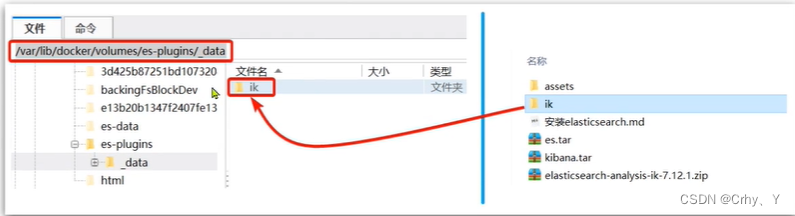

?2)解压缩分词器安装包

下面我们需要把课前资料中ik人词器解压缩,重命名为ik?

?

?

?3)上传到es容器的插件数据卷中

地址路径 /var/1ib/docker/volumes/es-plugins/_data?

?

?

?4)重启容器

# 重启容器

docker restart es

# 查看es日志docker logs -f es

?5)IK的使用

IK分词器包含两种模式:

- ik_smart:最少切分

- ik_max_word:最细切分?

文章来源:https://blog.csdn.net/m0_60769905/article/details/135191709

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Elasticsearch:为现代搜索工作流程和生成式人工智能应用程序铺平道路

- 12.扩展字典(ExtensionDictionary)

- 基于WEB职业培训管理系统

- 算法通关村第十七关—贪心其实很简单(青铜)

- 使用Excel批量给数据添加单引号和逗号

- 详细教程 - 从零开发 Vue 鸿蒙harmonyOS应用 第六节(js版) ——模块化设计实现复杂页面

- LeetCode刷题--- 单词搜索

- Json格式化

- 龙头老大OpenAI在和谷歌等其他同行“掰头”的时候,有一家“业界清流”公司

- 松鼠目标检测数据集VOC格式1400张