图像融合论文阅读:(MFEIF)学习深度多尺度特征集成和边缘注意引导的图像融合

@article{liu2021learning,

title={Learning a deep multi-scale feature ensemble and an edge-attention guidance for image fusion},

author={Liu, Jinyuan and Fan, Xin and Jiang, Ji and Liu, Risheng and Luo, Zhongxuan},

journal={IEEE Transactions on Circuits and Systems for Video Technology},

volume={32},

number={1},

pages={105–119},

year={2021},

publisher={IEEE}

}

论文级别:SCI A2

影响因子:8.4

文章目录

📖论文解读

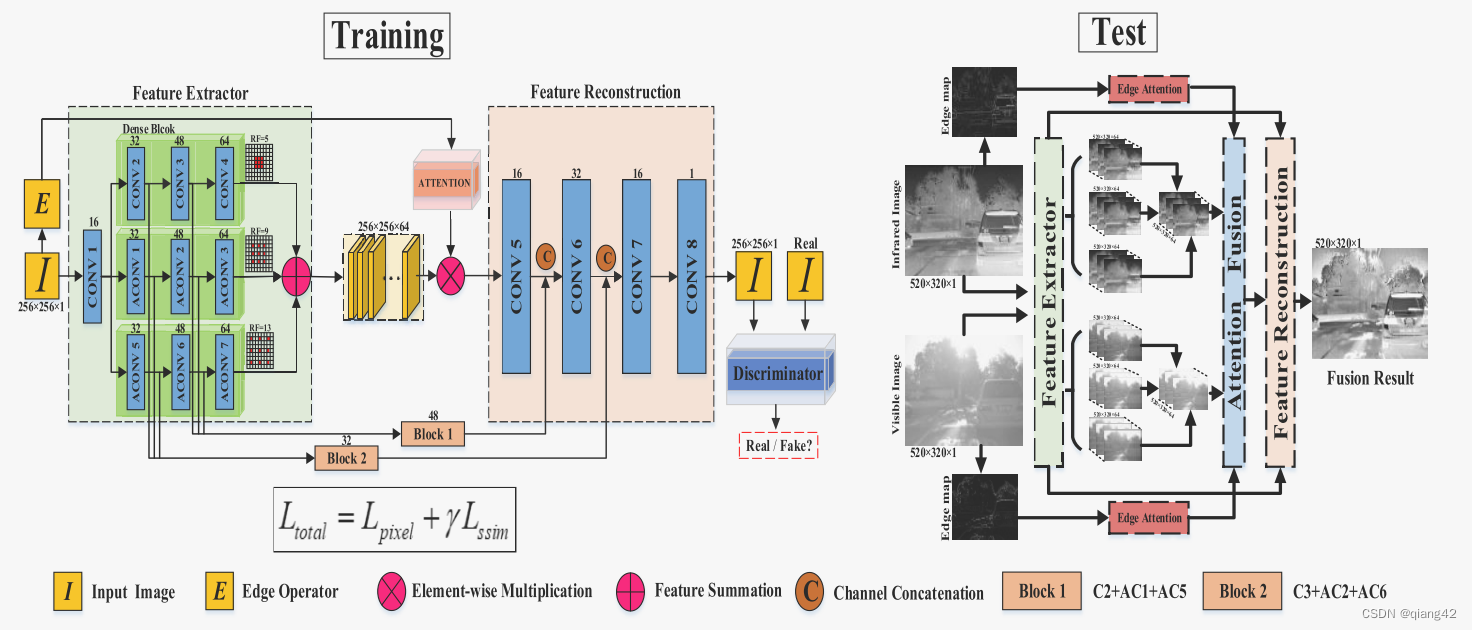

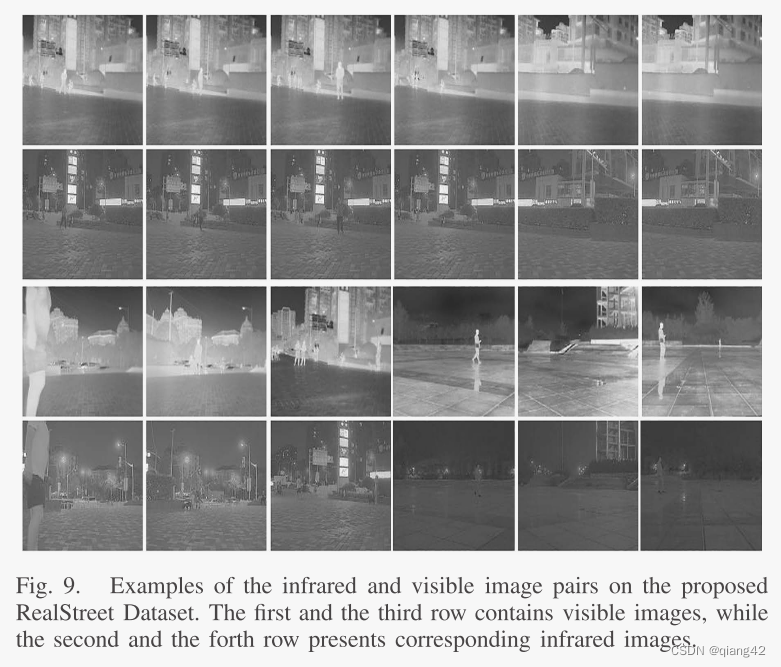

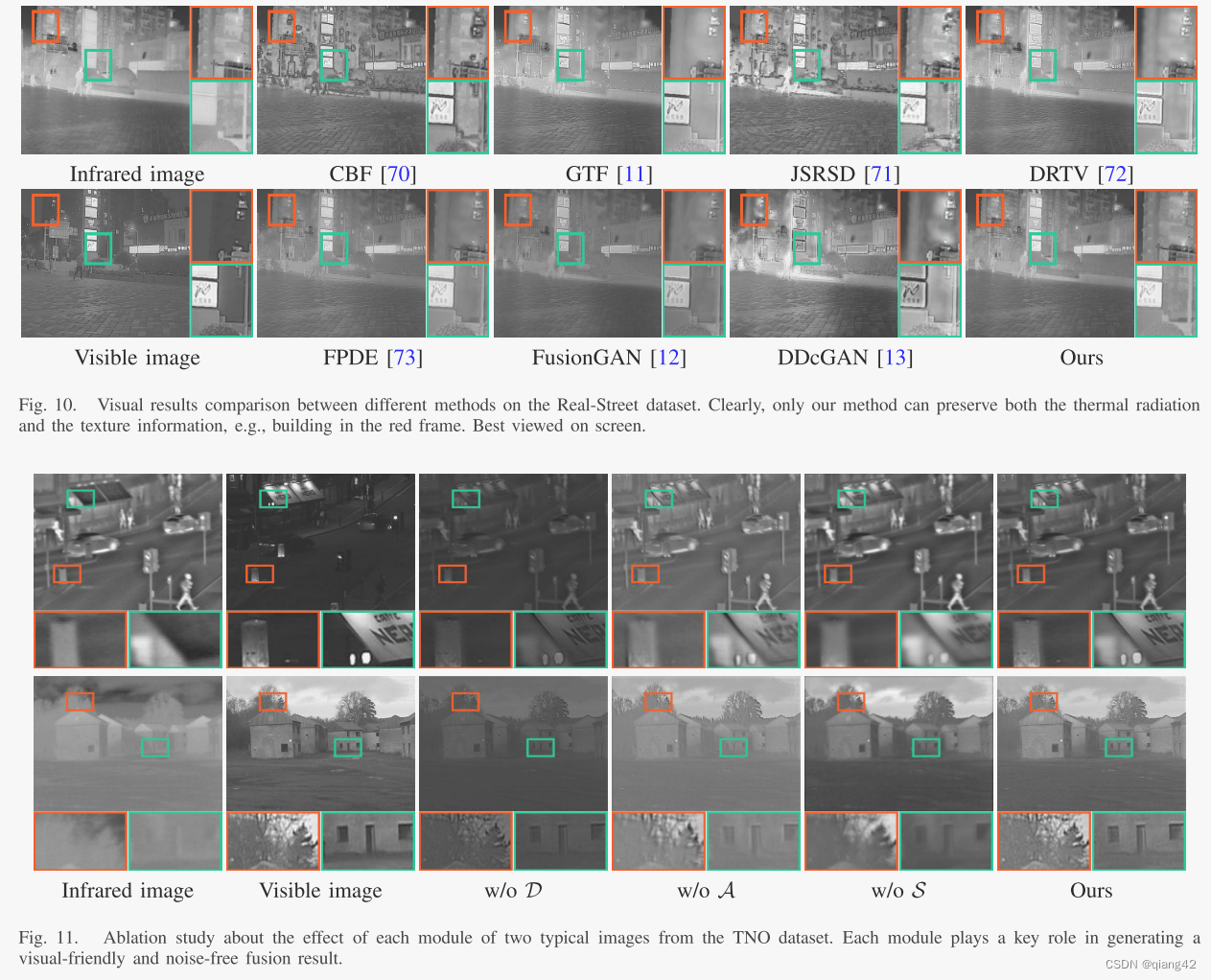

作者提出了一种用于可见光-红外的图像融合网络结构,采用【从粗到细】的结构进行特征提取,该结构可以输入【未对齐】的图像对;并且设计了一个【边缘引导注意力机制】用来使融合关注共同结构,目的使为了在消除噪声的同时恢复细节;作者还发布了一个新的对齐的可见光红外图像【数据集】RealStreet

🔑关键词

Image fusion, deep feature learning, attention mechanism.

图像融合,深度特征学习,注意力机制

💭核心思想

【一句话总结】:AE+GAN

编码器使用不同的空洞卷积提取特征后相加,乘上从源图像中通过注意力机制得到的权重,在通过加入跳跃连接的解码器进行重建。

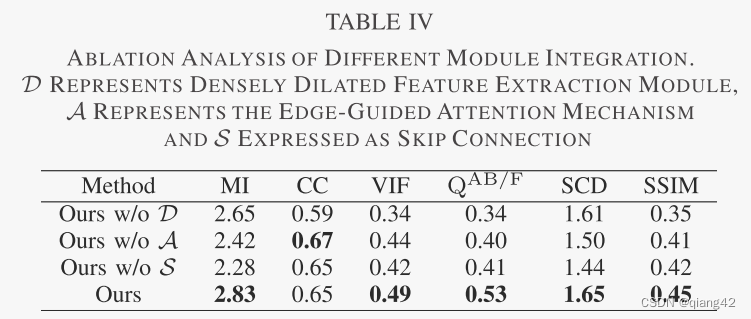

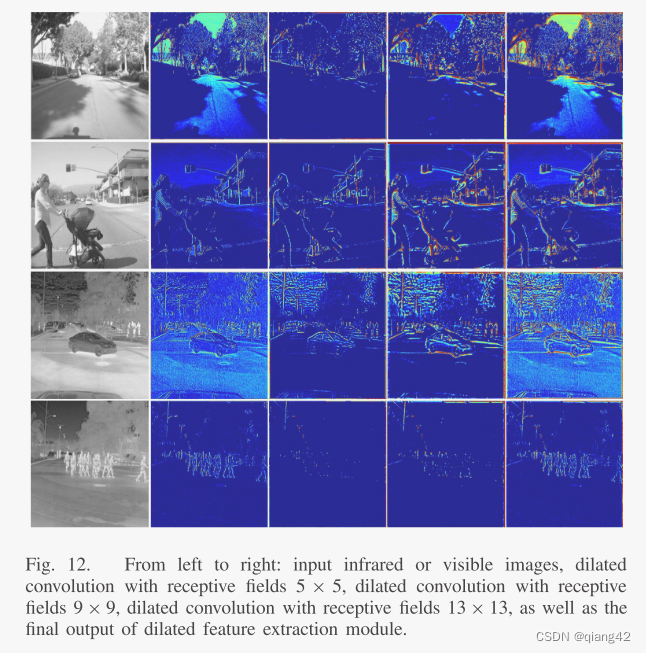

1、设计了一个密集语义扩大模块来增加感受野从而提取深层特征。(使用不同的扩张因子的空洞卷积提取特征然后聚合)

- 通过多尺度上下文聚合结构,将三种不同感受野的卷积路径聚合

- 在每个卷积路径上加入了密集连接

2、设计了一个边缘引导的注意融合规则,以保持图像结构并抑制伪影。

🪢网络结构

作者提出的网络结构如下图所示。

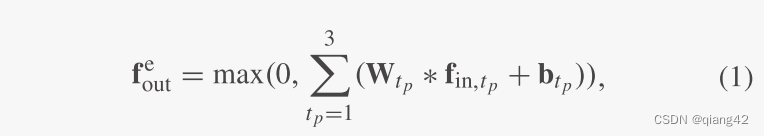

🪢粗到细的特征提取

先通过一次卷积将源图像变成特征图,然后通过3个不同的卷积路径提取特征并聚合。同时在每个路径上加入了密集连接。

f

i

n

f_{in}

fin?和

f

o

u

t

e

f_{out}^e

foute?分别代表特征提取模块的输入特征图和输出特征图。 *是卷积操作,

t

p

tp

tp为路径序号,W和b分别代表卷积层卷积权重和偏置。

作者使用

f

i

r

e

f_{ir}^e

fire?和

f

v

i

s

e

f_{vis}^e

fvise?分别代表红外图像和可见光图像的输出特征。

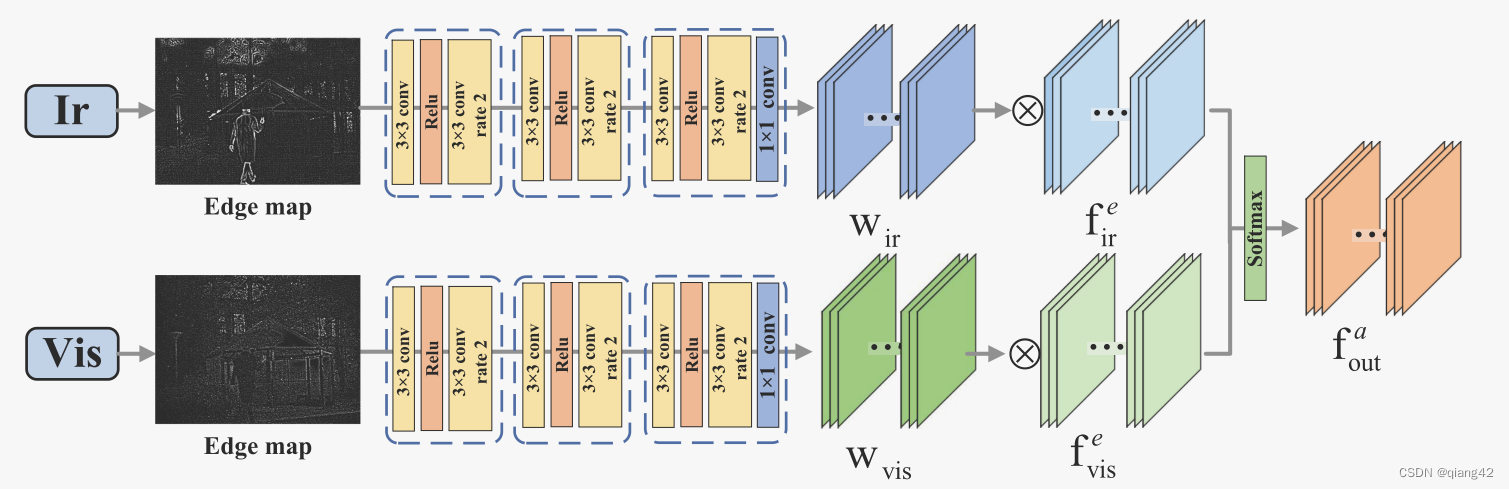

🪢边缘引导注意力特征融合

作者提出的边缘引导注意力特征融合如下图所示。

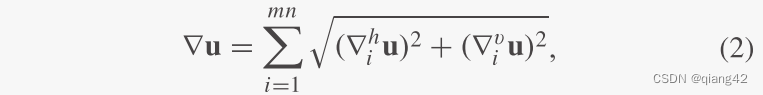

边缘图由2步得到:

输入m×n的灰度图用

u

u

u表示,定义梯度图为:

在上式中,

?

i

h

u

=

u

i

?

u

a

(

i

)

\nabla ^ h_iu=u_i-u_{a(i)}

?ih?u=ui??ua(i)?

?

i

v

u

=

u

i

?

u

b

(

i

)

\nabla ^v_iu=u_i-u_{b(i)}

?iv?u=ui??ub(i)?分别为计算水平和垂直一阶差分的线性算子。

u

a

(

i

)

u_{a(i)}

ua(i)?和

u

b

(

i

)

u_{b(i)}

ub(i)?分别为位于源像素i右侧和下方最近的像素。

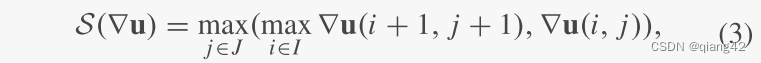

此外作者还设计了边缘增强算子

S

S

S来凸显梯度信息:

其中,

I

=

1

,

…

,

m

?

1

I ={1,…, m?1}

I=1,…,m?1;

J

=

1

,

…

,

n

?

1

J ={1,…, n?1}

J=1,…,n?1。i和j分别代表梯度图像的水平和垂直方向。

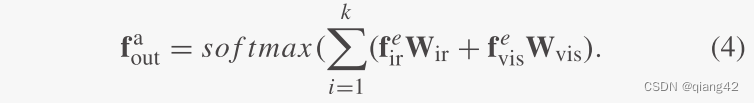

随后,将红外图像和可见光图像增强后的边缘图输入注意力机制,生成特征权重图

W

i

r

W_{ir}

Wir?和

W

v

i

s

W_{vis}

Wvis?,并通过梯度引导注意力计算出融合特征

f

o

u

t

a

f^a_{out}

fouta?:

最终的融合图像由训练好的解码器从融合特征

f

o

u

t

a

f^a_{out}

fouta?来重构。

🪢特征补偿重构

作者认为单纯使用卷积操作来进行图像恢复会导致信息丢失,所以引入了两个跳跃连接。

- 将特征提取中三个不同的特征相加

- 使用choose-max策略选择红外或者可见光特征

- 在特征重构中,将补偿特征在通道上concat到基于注意力的融合特征中

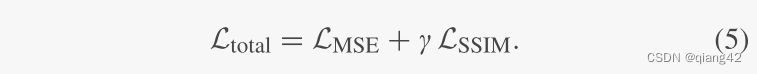

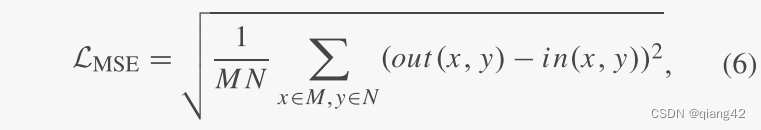

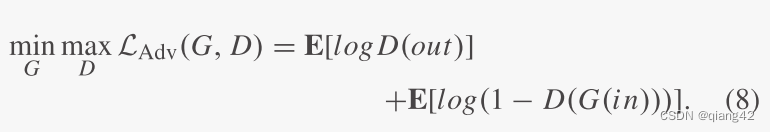

📉损失函数

损失函数=像素损失+结构相似性损失

作者受GAN的启发,假设上述网络结构是一个生成器,在网络末尾加入了一个判别器,用来引导生成器生成更自然的图像。

🔢数据集

训练MSCOCO和FLIR

测试 TNO

图像融合数据集链接

[图像融合常用数据集整理]

🎢训练设置

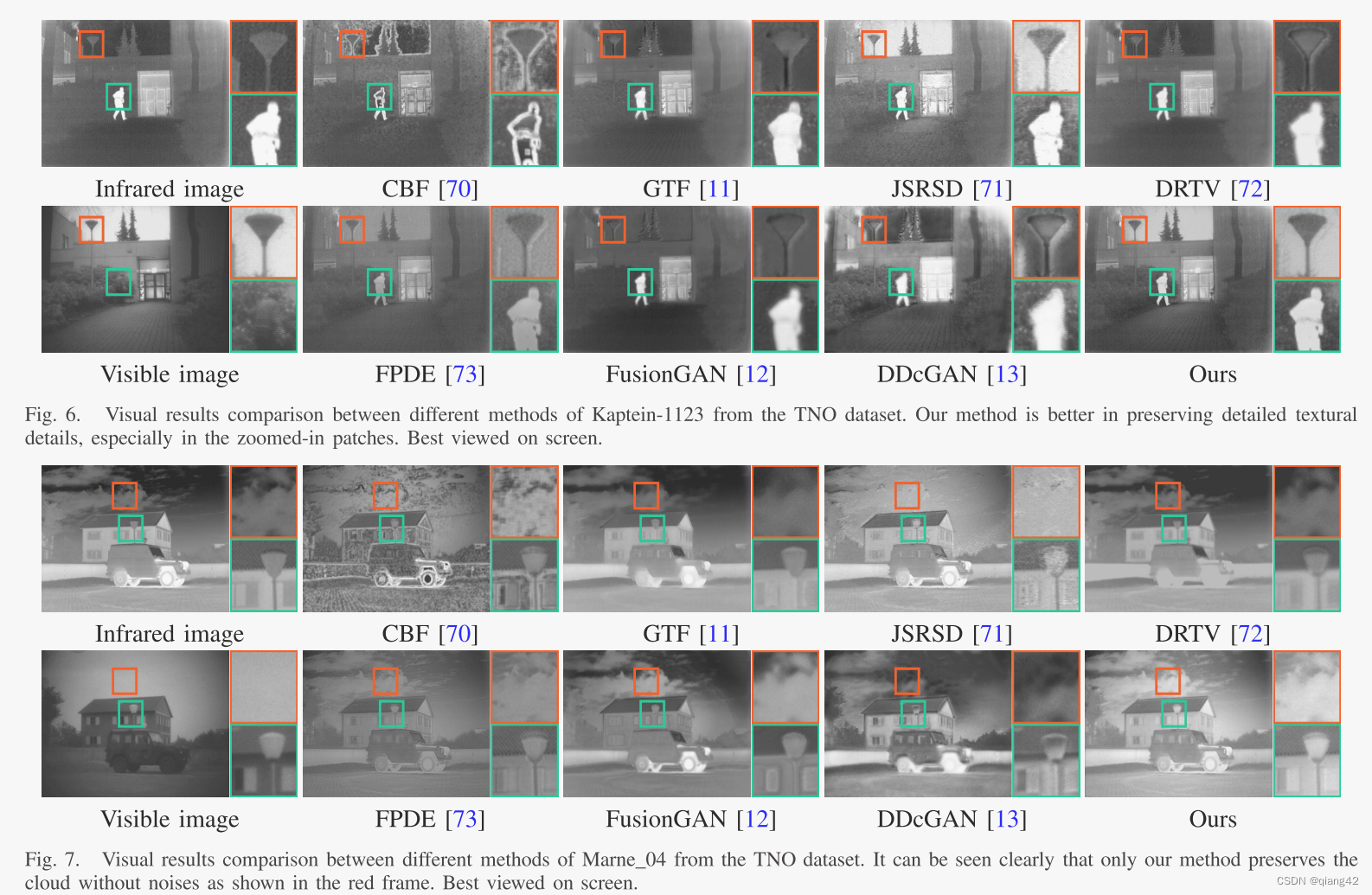

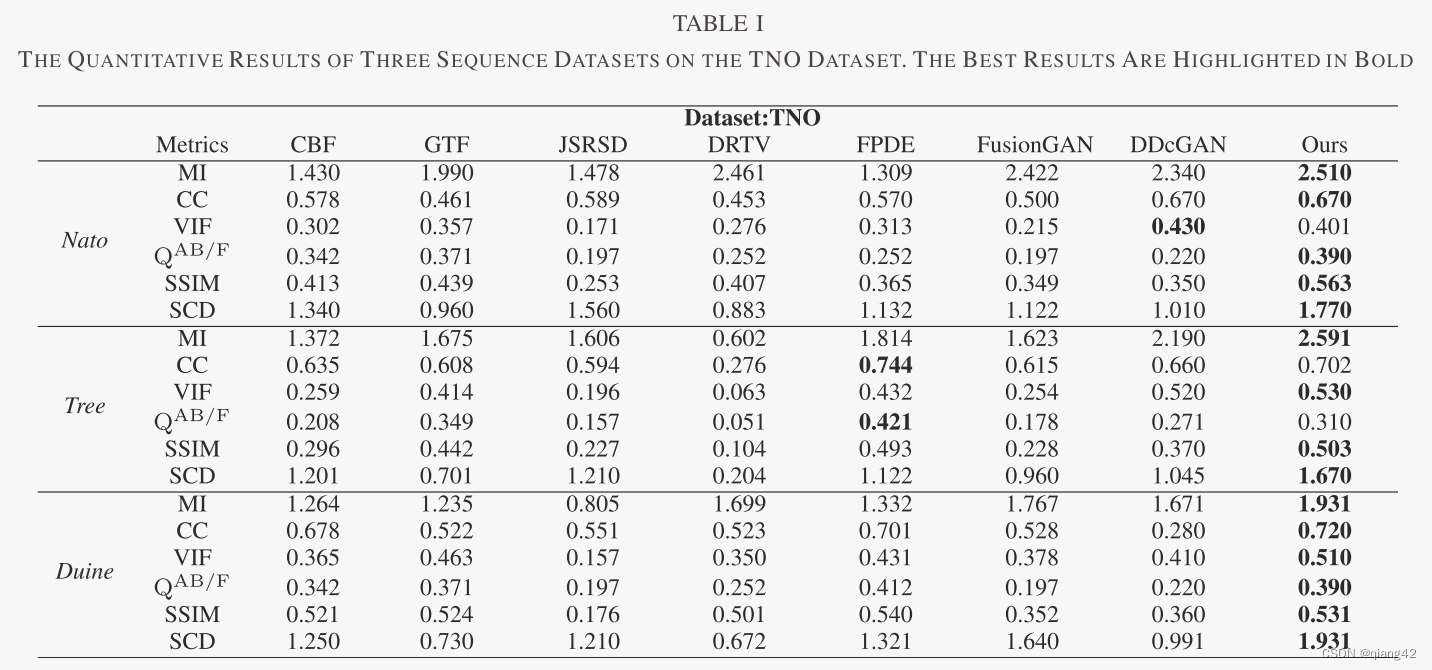

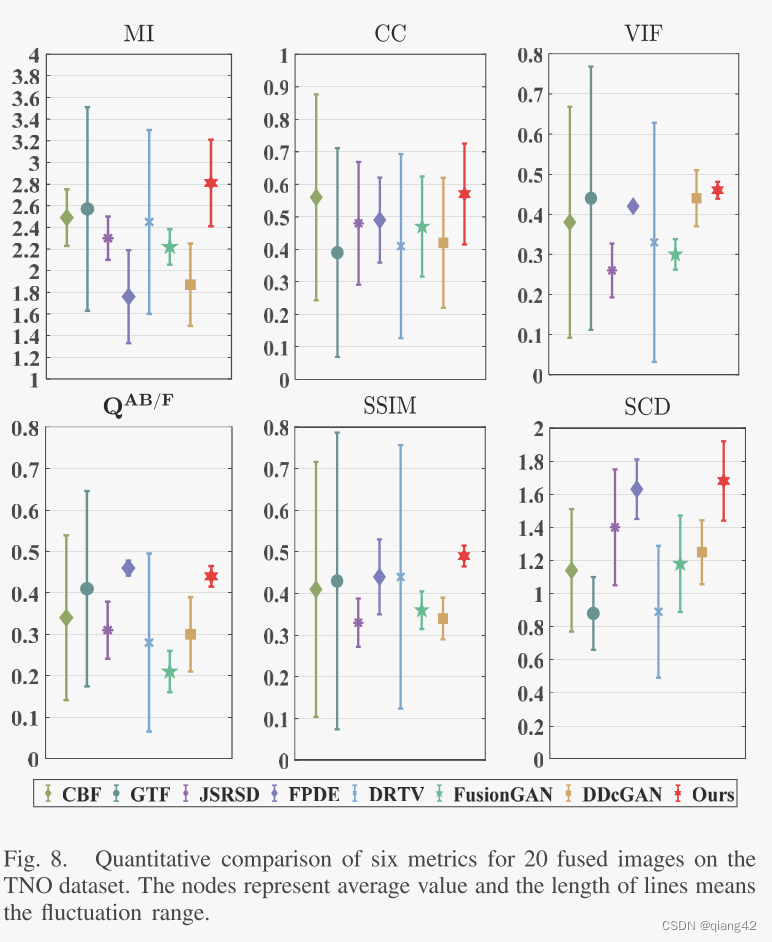

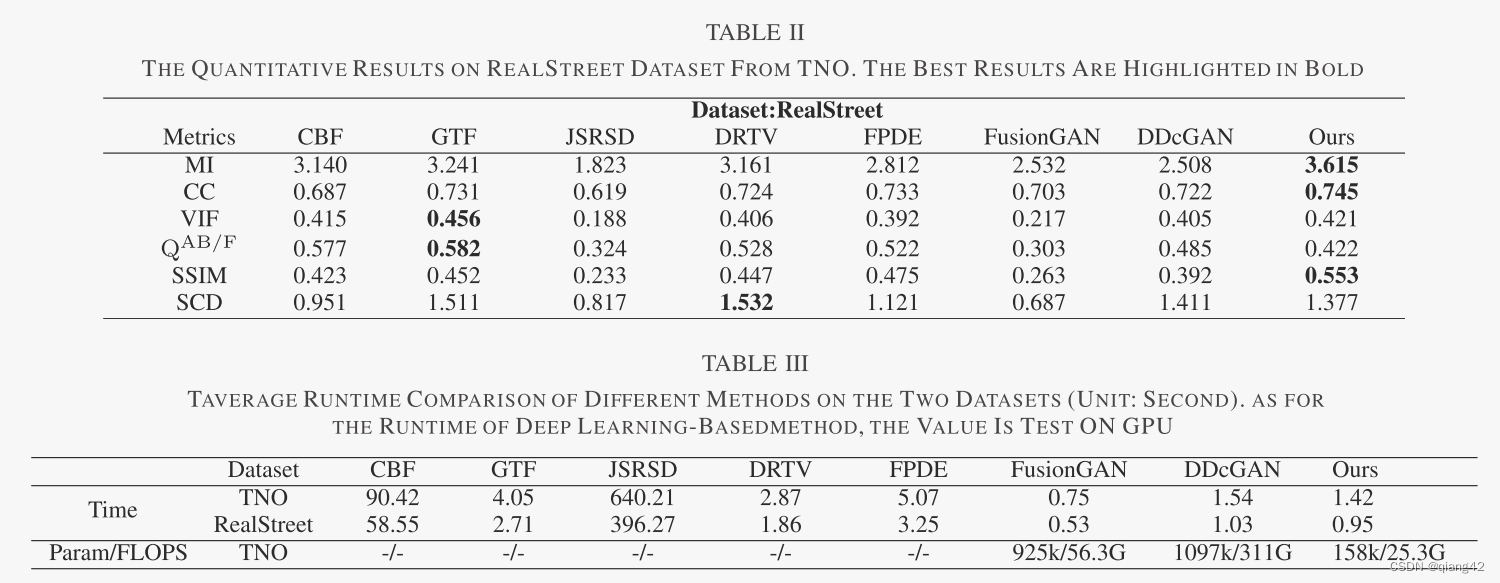

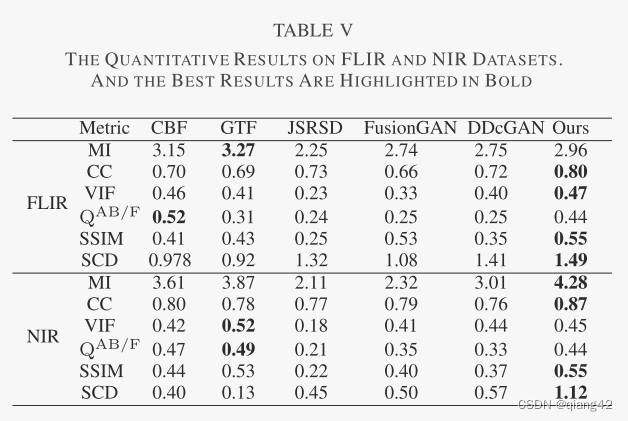

🔬实验

📏评价指标

- MI

- CC

- VIF

- QAB/F

- SSIM

- SCD

参考资料

???强烈推荐必看博客 [图像融合定量指标分析]

🥅Baseline

- CBF, GTF, JSRSD, DRTV, FPDE, FusionGAN, DDcGAN

🔬实验结果

更多实验结果及分析可以查看原文:

📖[论文下载地址]

💽[代码下载地址]

🚀传送门

📑图像融合相关论文阅读笔记

📑[DenseFuse: A fusion approach to infrared and visible images]

📑[DeepFuse: A Deep Unsupervised Approach for Exposure Fusion with Extreme Exposure Image Pair]

📑[GANMcC: A Generative Adversarial Network With Multiclassification Constraints for IVIF]

📑[DIDFuse: Deep Image Decomposition for Infrared and Visible Image Fusion]

📑[IFCNN: A general image fusion framework based on convolutional neural network]

📑[(PMGI) Rethinking the image fusion: A fast unified image fusion network based on proportional maintenance of gradient and intensity]

📑[SDNet: A Versatile Squeeze-and-Decomposition Network for Real-Time Image Fusion]

📑[DDcGAN: A Dual-Discriminator Conditional Generative Adversarial Network for Multi-Resolution Image Fusion]

📑[FusionGAN: A generative adversarial network for infrared and visible image fusion]

📑[PIAFusion: A progressive infrared and visible image fusion network based on illumination aw]

📑[CDDFuse: Correlation-Driven Dual-Branch Feature Decomposition for Multi-Modality Image Fusion]

📑[U2Fusion: A Unified Unsupervised Image Fusion Network]

📑综述[Visible and Infrared Image Fusion Using Deep Learning]

📚图像融合论文baseline总结

📑其他论文

📑[3D目标检测综述:Multi-Modal 3D Object Detection in Autonomous Driving:A Survey]

🎈其他总结

🎈[CVPR2023、ICCV2023论文题目汇总及词频统计]

?精品文章总结

?[图像融合论文及代码整理最全大合集]

?[图像融合常用数据集整理]

如有疑问可联系:420269520@qq.com;

码字不易,【关注,收藏,点赞】一键三连是我持续更新的动力,祝各位早发paper,顺利毕业~

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- Flume基础知识(一):Flume组成原理与架构

- 网上评教系统(JSP+java+springmvc+mysql+MyBatis)

- 31-35.玩转Linux操作系统

- 职场遇到瓶颈如何破解?不妨看看中国人民大学金融加拿大女王大学硕士项目

- 制作Centos7 Docker镜像

- 编程笔记 html5&css&js 027 HTML输入属性(1/2)

- SpringMVC执行流程

- tx2开发板升级JetPack至最新

- 第十二届“中关村青联杯”全国研究生数学建模竞赛-B题:数据的多流形结构分析

- [CTF-Misc攻防世界]碎纸机11