大模型实战营Day5 作业

发布时间:2024年01月14日

?基础作业:

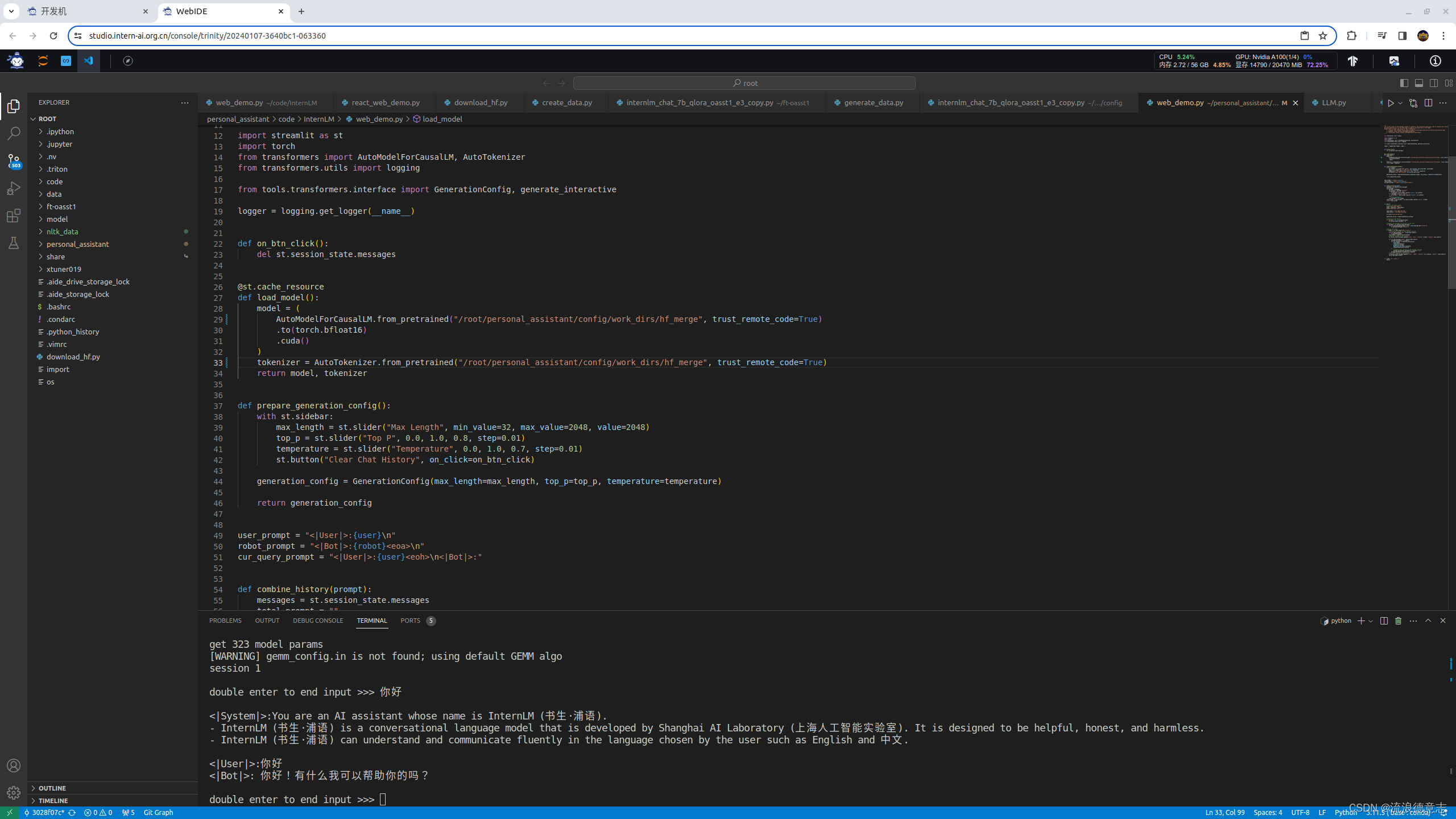

- 使用 LMDeploy 以本地对话、网页Gradio、API服务中的一种方式部署 InternLM-Chat-7B 模型,生成 300 字的小故事(需截图)

TurboMind 推理+命令行本地对话

-

lmdeploy chat turbomind /share/temp/model_repos/internlm-chat-7b/ --model-name internlm-chat-7b

?

TurboMind推理+API服务

网页 Demo 演示

一个终端

lmdeploy serve api_server ./workspace \

> --server_name 0.0.0.0 \

> --server_port 23333 \

> --instance_num 64 \

> --tp 1

另一个终端?

lmdeploy serve gradio http://0.0.0.0:23333 \

> --server_name 0.0.0.0 \

> --server_port 6006 \

> --restful_api True

进阶作业(可选做)

- 将第四节课训练自我认知小助手模型使用 LMDeploy 量化部署到 OpenXLab 平台。

- 对internlm-chat-7b模型进行量化,并同时使用KV Cache量化,使用量化后的模型完成API服务的部署,分别对比模型量化前后和 KV Cache 量化前后的显存大小(将 bs设置为 1 和 max len 设置为512)。

- 在自己的任务数据集上任取若干条进行Benchmark测试,测试方向包括:

(1)TurboMind推理+Python代码集成

(2)在(1)的基础上采用W4A16量化

(3)在(1)的基础上开启KV Cache量化

(4)在(2)的基础上开启KV Cache量化

(5)使用Huggingface推理

文章来源:https://blog.csdn.net/li4692625/article/details/135587651

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:chenni525@qq.com进行投诉反馈,一经查实,立即删除!

最新文章

- Python教程

- 深入理解 MySQL 中的 HAVING 关键字和聚合函数

- Qt之QChar编码(1)

- MyBatis入门基础篇

- 用Python脚本实现FFmpeg批量转换

- 「仙逆」王林夺舍身份曝光,火焚国火兽危机,两位始祖保护王林

- 如何解决安装CAD找不到vcruntime140.dll问题?分享5个有效的方法

- Java 中 IO 流

- shell编程之条件语句

- python24.1.23创建类-定义对象拥有的方法

- 钡铼案例 污水处理远程监控系统的应用介绍

- 支持向量机(Support Vector Machine,SVM)算法 简介

- 可狱可囚的爬虫系列课程 07:BeautifulSoup4库的使用

- 计算机组成原理——指令系统判断+

- Android性能优化系列——内存优化